撰稿 | 云昭

出品 | 51CTO技术栈(微信号:blog51cto)

近日,市场有消息称,在Sora引爆文生视频赛道之前,国内的字节跳动也推出了一款新型视频模型Boximator,与Gen-2、Pink1.0等既有模型相比,Boximator的独特之处在于,它能够通过文本输入精确地控制视频中人物或物体的运动。

有媒体称将之称为中国版的Sora,对此,字节跳动相关人士回复称,Boximator是视频生成领域控制对象运动的技术方法研究项目,目前还无法作为完善的产品落地,距离国外领先的视频生成模型在画面质量、保真率、视频时长等方面还有很大差距。

1、为何会被误解读成中文版Sora解析模型的厉害之处

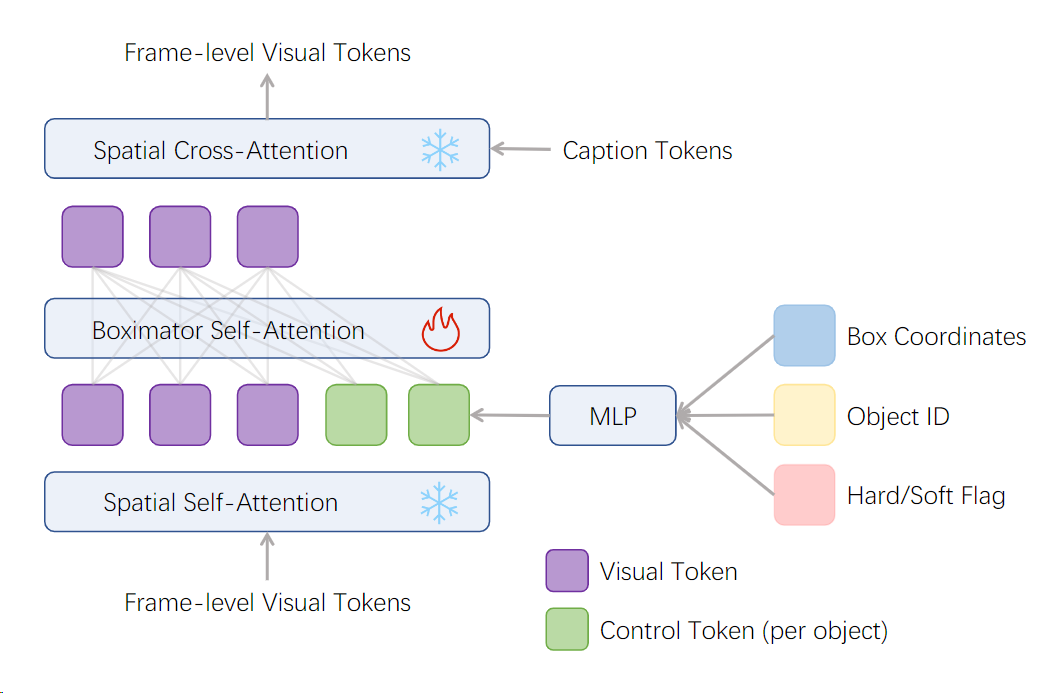

Boximator是建立在视频扩散模型之上的,它采用了3D U-Net架构。简单讲,3D U-Net架构由交替的卷积块和注意力块构成。每个块包括两个组件:一个是空间组件,将单个视频帧作为单独的图像处理;另一个是时间组件,实现跨帧的信息交换。

而在每个注意力块中,空间组件通常包括一个自注意力层,然后是一个交叉注意力层,后者用于根据文本提示进行生成。

图片

图片

Boximator的厉害之处,他们赋予了现有的视频扩散模块运动控制能力。怎么做到的呢?

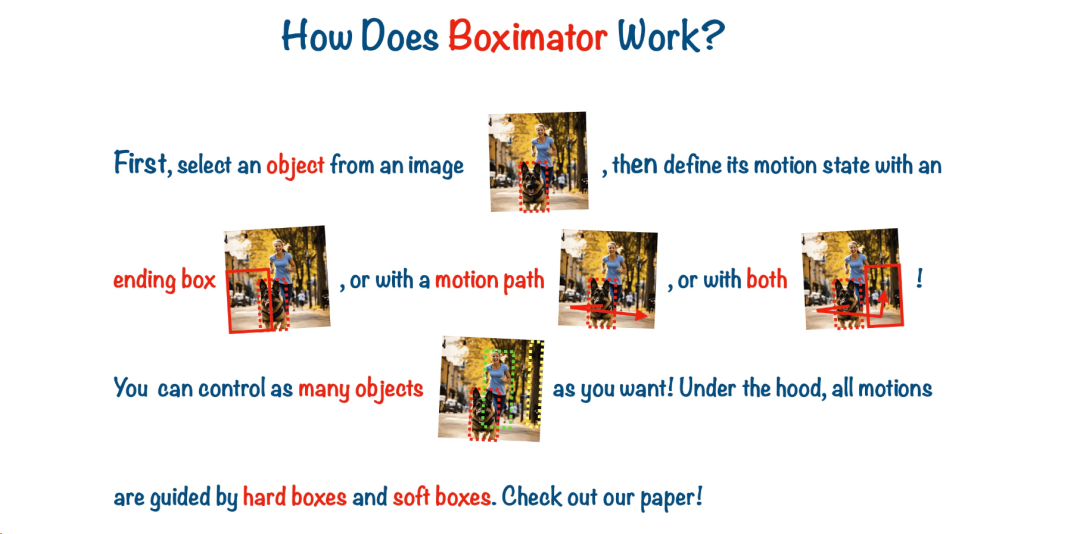

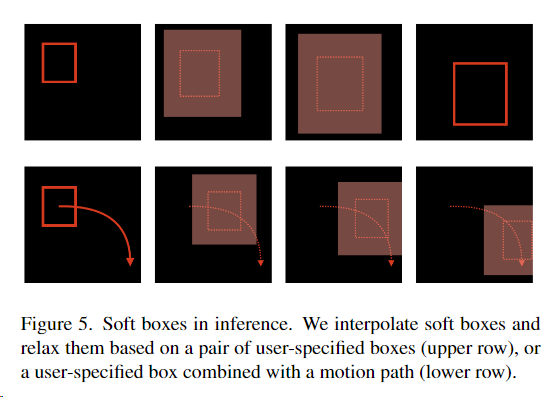

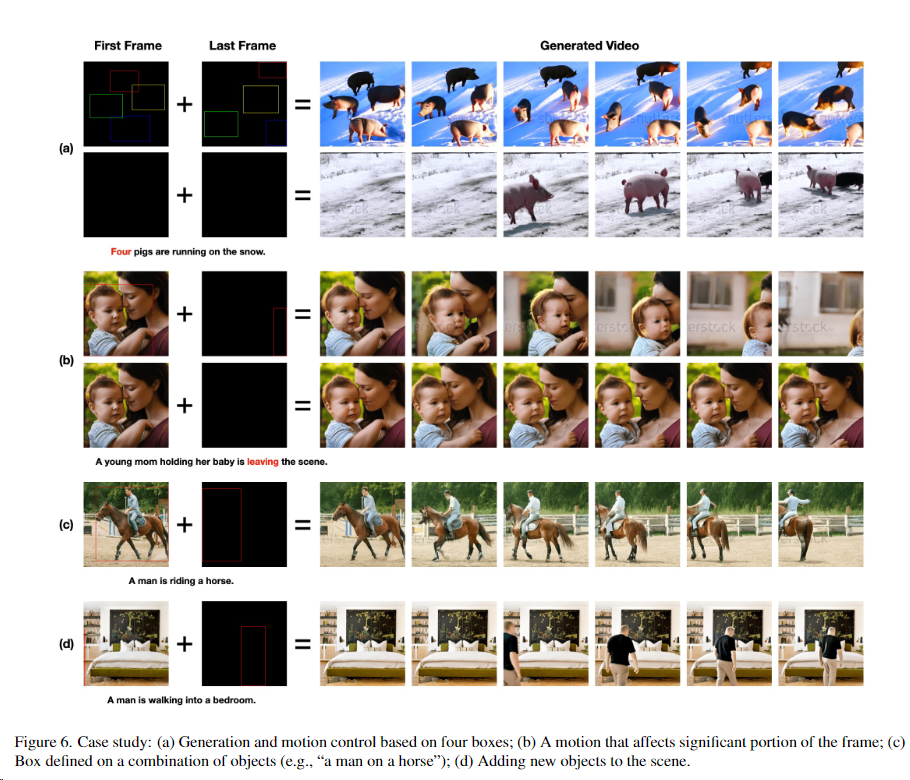

首先,为了实现对视频中物体、人物的动作控制,Boximator 使用了“软框”和“硬框”两种约束方法。

其中,硬框,精确定义了目标对象的边界框,有了它,用户可以在图片中画出感兴趣的对象,Boximator 会将其视为硬框约束, 在之后的帧中精准定位该对象的位置。

而,软框则定义一个对象可能存在的区域, 形成一个宽松的边界框。对象需要停留在这个区域内, 但位置可以有一定变化,实现适度的随机性。

两类框都包含目标对象的 ID, 用于在不同帧中跟踪同一对象。此外, 框还包含坐标、类型等信息的编码。

图片

图片

其次,在原有两个注意力层之上,Boximator通过添加一个新的自我关注层(Spatial Self-attention)来增强这个堆栈。

参数方面,团队考虑到基础模型是在大量网络规模的图像和视频上预先训练的,已经获得了不错的通用知识能力,所以对原始模型的参数进行了冻结,只专注于训练新调整用途的运动控制模块。

当然这只是模型层面的区别,还有数据、训练、算法、推理层面的重要改进,比如自追踪技术、多阶段训练处理,都是相关研究人员值得借鉴的技术,这里不再展开介绍。感兴趣的朋友可以查阅论文。

图片

图片

图片

图片

2、视频实验讲究之处:数据,还是数据

基准模型方面,字节团队选取了两个:PixelDance 和 ModelScope,来训练 Boximator。

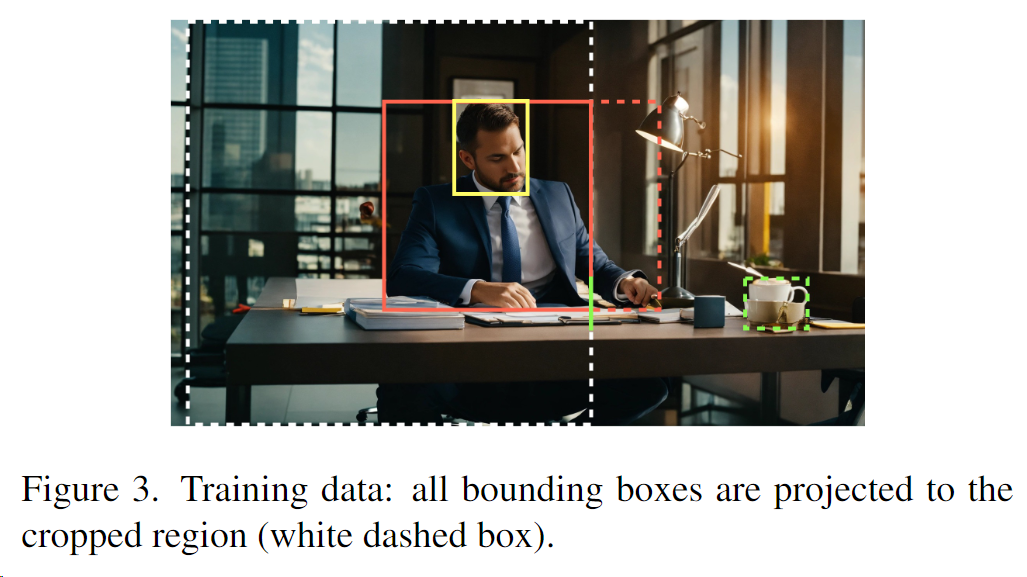

训练数据方面,研究人员从 WebVid-10M 数据集中,过滤出 110 万段动态明显的视频片段, 并自动为其注释了 220 万个对象的边界框,注释的描述包含了视频中对象的名词短语,如“年轻男子”或“白色衬衫”。

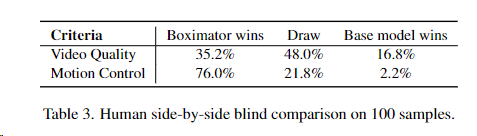

实验结果显示,在 MSR-VTT 数据集上, 无论是视频质量还是框与对象对齐精度面,Boximator 都优于原模型。在人类评估中,Boximator 生成的视频也在质量和运动控制上明显超过原模型。

图片

图片

图片

图片

在Github上呈现的效果视频来看,Boximator 在保持原模型视频质量, 具有非常强大的动作控制能力。同时可以作为一种插件,帮助现有视频扩散模型提升生成质量。

3、新视频产品即将推出

1月30日,梁汝波罕见的批评了字节的大公司病,主要就是两点:效率低下、对机会敏感度降低,对此梁语气非常沉重:“公司层面的半年度技术回顾,直到2023年才开始讨论GPT,而业内做得比较好的大模型创业公司都是在2018年至2021年创立的。”

入场晚,也有着晚的资本。字节集团从飞书、抖音等各个事业部抽调人选,到这个全新的AI部门Flow开发新的C端产品。

现在字节有不少可圈可点的AI产品已经问世。基于抖音、火山等头条系产品,豆包、扣子的应用也赚得市场不错的口碑。

字节其实一直有着AI的基因,张一鸣也是AI的极度推崇者。回望过去的2023,字节对于生成式AI的布局繁多,且力度不小。

只不过,在视频领域,似乎随着Sora的刷屏,字节进一步意识到了王者地位被颠覆的危机。这很难不让人联想到春节前的那场变动,抖音前CEO张楠转岗剪映。

虽然本文的Boximator还只是实验研究,尚未落地,但此前就有消息传出:据说本月剪映将会推出一个AI生图和视频的产品,大家拭目以待吧。

PS:对Boximator感兴趣的朋友,可以发送邮件给论文作者的邮箱,开通体验申请:wangjiawei.424@bytedance.com。

参考链接:

https://arxiv.org/abs/2402.01566

https://boximator.github.io/

https://zhuanlan.zhihu.com/p/682140112