编译 |言征

出品 | 51CTO技术栈(微信号:blog51cto)

过去两周,新的人工智能更新不断涌现,异常疯狂。我们决定整理最近发布的六大框架和模型。

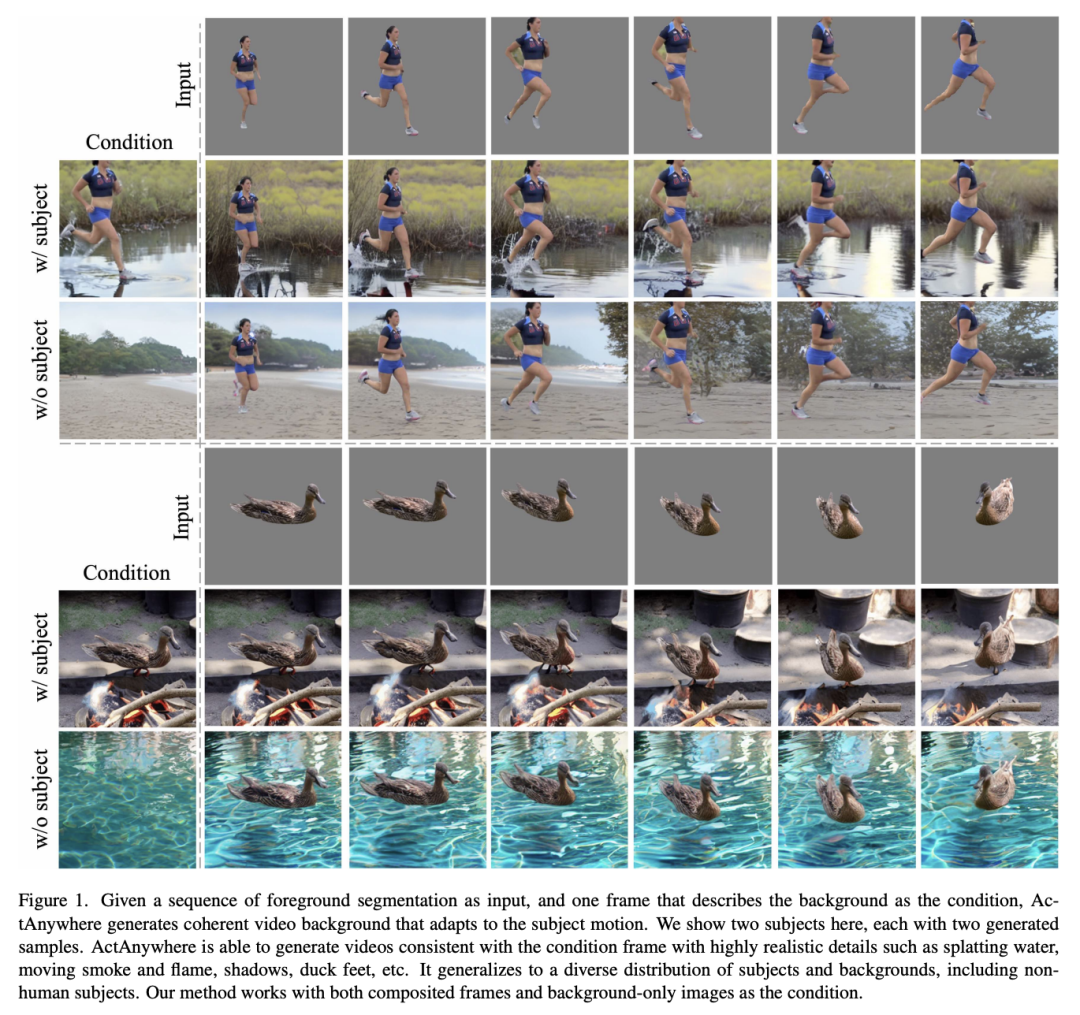

1、ActAnywhere:主题感知视频背景生成

图片

图片

Adobe Research和斯坦福大学推出了Act Anywhere,这是一种生成模型,解决了电影行业和视觉效果领域中将视频背景与前景主体运动对齐的挑战。该模型通过利用大规模视频传播模型来自动化典型的劳动密集型流程。

它采用一系列前景主题分割和描述所需场景的条件帧作为输入,生成具有连贯前景-背景交互的逼真视频。

在大规模人类场景交互视频数据集上进行训练后,数据表明Act Anywhere与基线相比表现良好,并证明了其处理各种非分布样本(包括非人类受试用者)的能力。

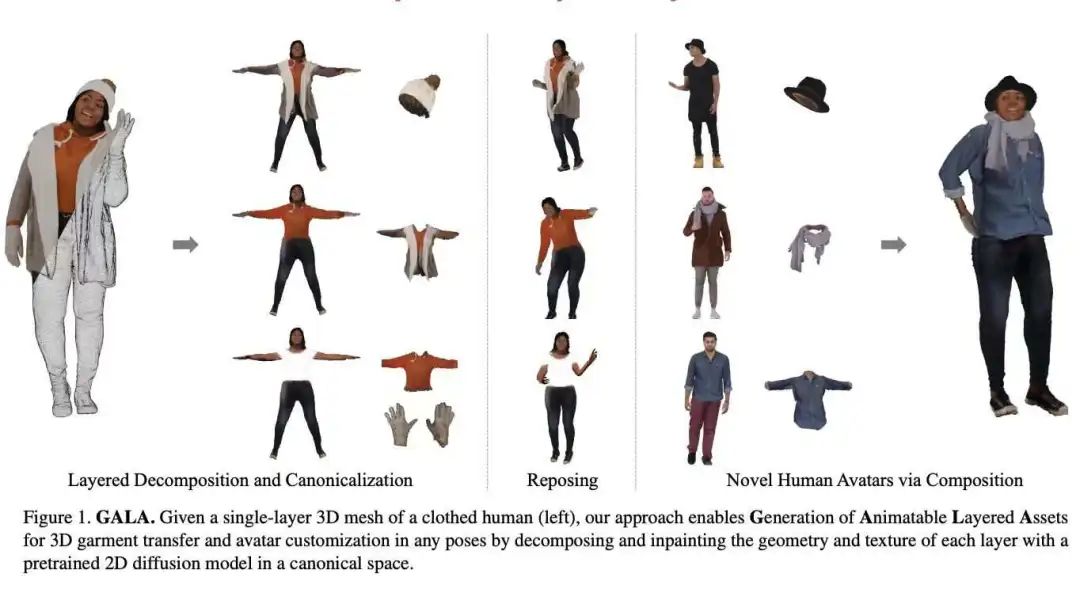

2、GALA

图片

图片

Meta一直试图在 Facebook、Instagram 和 WhatsApp 等不同平台上改进其头像。因此,Meta 的 Codec Avatars Lab 与首尔国立大学合作推出了GALA框架,该框架可将单层穿着的 3D 人体网格转换为全分层的 3D 资源,从而可以创建各种姿势的多样化服装人体头像。

与将穿着衣服的人类视为单层几何体的现有方法不同,GALA 基于人类的发型、服装和配饰的组合性,增强了下游应用。由于遮挡,将网格分解为单独的层具有挑战性,即使分解成功,姿势和身体形状通常也与现实生活不一样。

为了克服这个问题,研究人员使用预先训练的二维扩散模型作为几何和外观的先验模型。该过程包括使用来自多视图 2D 分割的 3D 表面分割对输入网格进行分割,使用新的姿势引导得分蒸馏采样 (SDS) 损失合成姿势空间和规范空间中缺失的几何形状,并将相同的 SDS 损失应用于纹理完整的外观。这会在共享规范空间中产生多层 3D 资产,并针对姿势和人体形状进行标准化,从而有助于轻松组合新颖的身份和姿势。

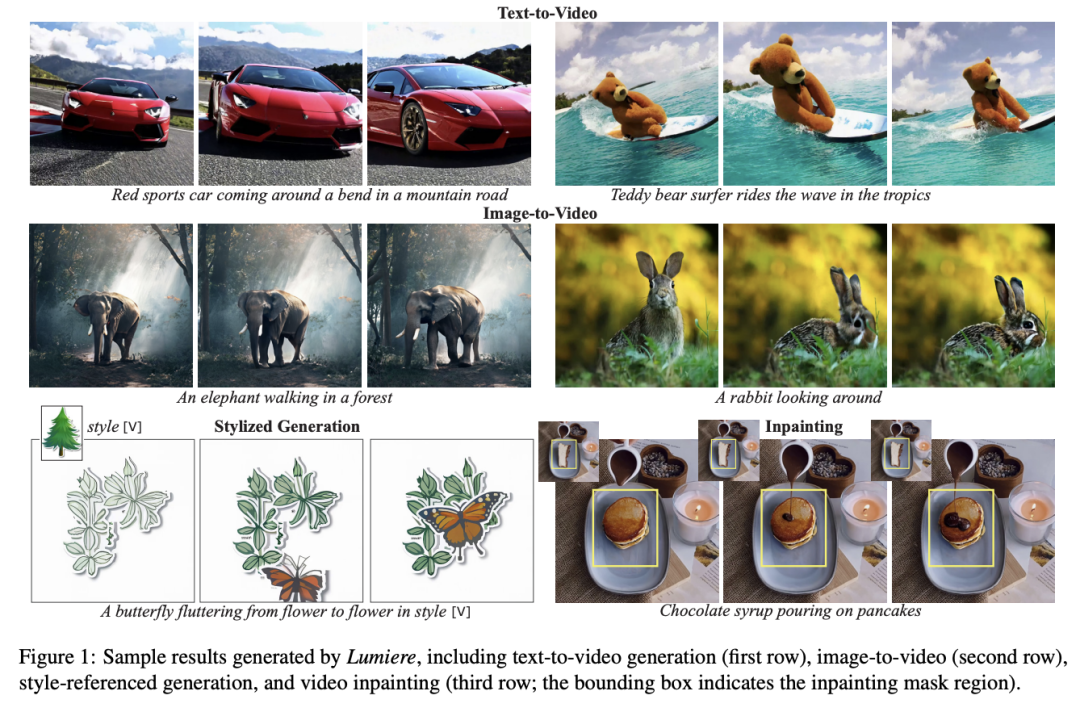

3、Lumiere

图片

图片

为了解决在合成视频中创建逼真、多样化和连贯的运动的挑战,谷歌提出了Lumiere,一种文本转视频模型,由魏茨曼研究所、特拉维夫大学和以色列理工学院合作开发。训练涉及时空 U-Net 架构,它一次性生成整个视频持续时间,这与使用远程关键帧和时间超分辨率的现有模型不同。

通过结合空间和时间处理并利用预先训练的文本到图像模型,该系统直接生成全帧率、低分辨率视频。它擅长文本到视频的任务,例如图像到视频和风格化生成。该模型展示了最先进的文本到视频结果,并且适用于图像到视频、视频修复和风格化生成等任务。

然而,它目前无法处理具有多个镜头或场景转换的视频,这些领域还需要进一步研究。尽管存在一些限制,该项目的重点是使用户能够创造性地、灵活地生成视觉内容。

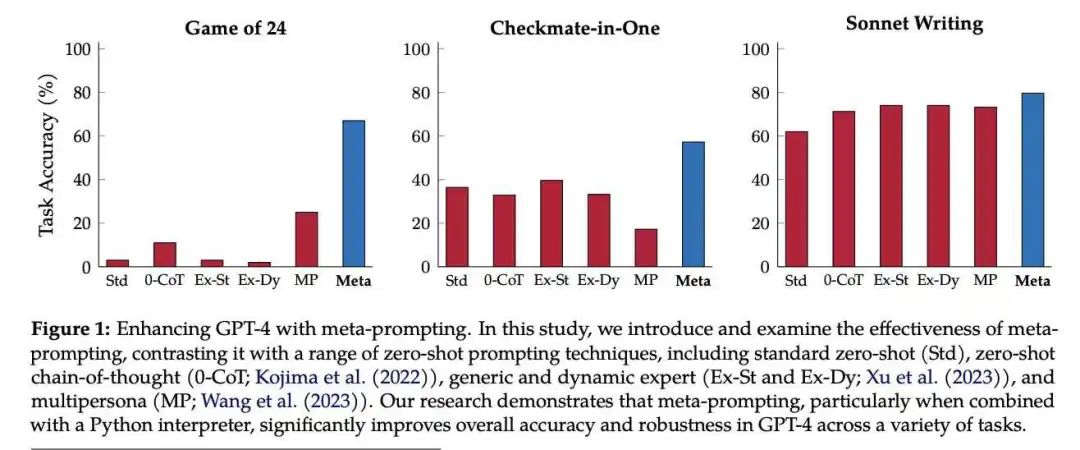

4、元提示(Meta-Prompting)

在另一篇有趣的研究论文中,OpenAI和斯坦福大学联手提出了元提示,这是一种有效的脚手架技术,可以以与任务无关的方式增强语言模型 (LM) 的性能。这是通过将它们转变为可以管理多个独立查询的多功能导体来完成的。元提示与任务无关,无需详细说明即可简化用户交互。

GPT-4 的实验显示了元提示相对于传统方法的优越性,在 Game of 24、Checkmate-in-One、Python编程难题等任务中,元提示比标准提示提高了 17.1%,比动态提示提高了 17.3%,比多人提示(MP)提高了 15.2% 。

使用清晰的指令,元提示引导 LM 将复杂的任务分解为更小的子任务,然后由同一 LM 的专门实例处理,每个子任务都遵循定制的指令。LM 充当导体,确保顺畅的通信和输出的有效集成。它还利用批判性思维和验证流程来完善结果。这种协作提示允许单个 LM 充当协调者和专家小组,从而提高各种任务的性能。

5、自我奖励语言模型

图片

图片

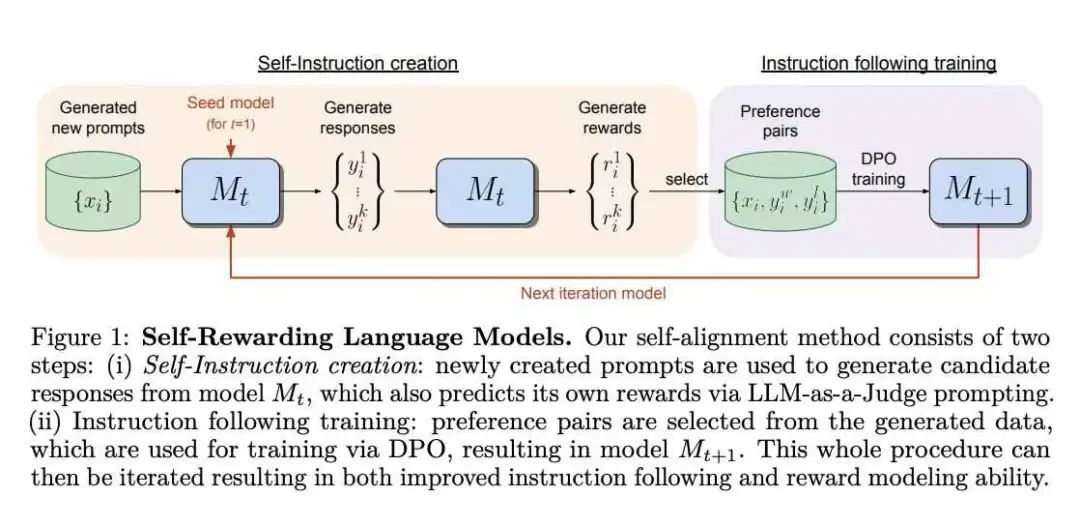

Meta 和 NYU 最近的一篇研究论文中引入了自我奖励语言模型,该模型不依赖于源自人类偏好的奖励模型,这种模型可能会受到人类表现的限制,并且在训练过程中无法改进。这些模型可以通过评估和训练其输出来调整自身,并使用语言模型本身通过法学硕士作为法官的提示来产生奖励。

该方法涉及迭代训练,其中模型使用法学硕士作为法官的提示将奖励分配给自己的输出,从而生成基于偏好的指令数据。结果表明,这种训练提高了模型遵循指令的能力,并改进了其跨迭代的奖励建模。

6、高斯自适应注意力(GAAM)is all your need!

图片

图片

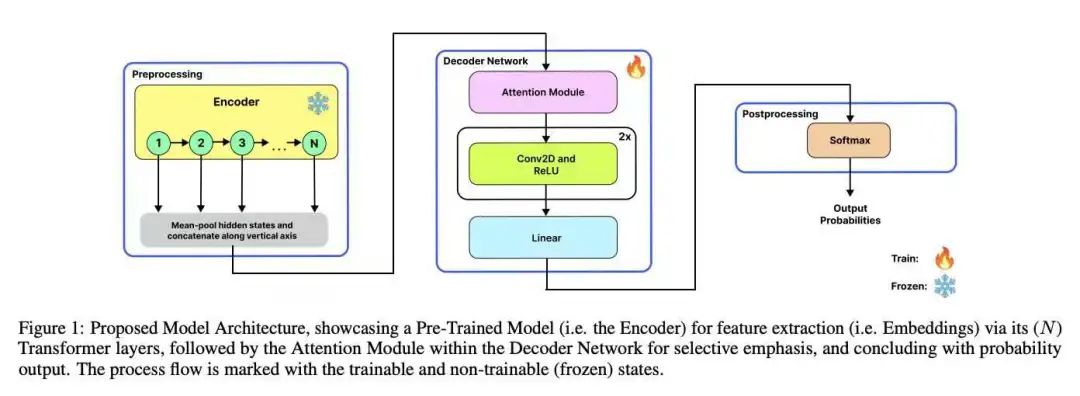

本研究引入了Multi-Head高斯自适应注意力机制(GAAM)和高斯自适应变换器(GAT)来提高模型性能和上下文表示,特别是对于高度可变的数据。GAAM 将可学习的均值和方差纳入其注意力机制中,并在多头框架内构建。此设置允许 GAAM 共同表示任何概率分布,从而能够根据需要不断调整功能的重要性。

该研究还引入了重要性因子(IF)以增强模型的可解释性。GAAM(一种新的概率注意力框架)和 GAT 的提出是为了促进跨语音、文本和视觉模式的信息编译。它通过识别特征空间中的关键元素,在模型性能方面超越了最先进的注意力技术。

该论文由詹姆斯·西尔伯拉德·布朗人工智能中心、卡内基梅隆大学、斯坦福大学和亚马逊发表。