过去一年,生成式人工智能发展的核心关键词,就是「大」。

人们逐渐接受了强化学习先驱 Rich Sutton 充分利用算力「大力出奇迹」的思潮,庞大的数据量是 AI 模型展现出惊人智慧的核心原因。数据规模越大、质量越高、标注越细,模型就能了解到更全面的世界知识,从而拟合出更加智能的结果。

那么,为什么人工智能的进展还没有转化成科幻片中那种全能管家机器人呢?能清理桌子、叠衣服、做早餐的机器人在哪里?

一个重要的原因是机器人领域很难「大力出奇迹」,生成式 AI 的文字或图片训练数据在网络上就能轻松获取,而机器人的训练数据通常是由研究人员在实验室里根据具体的任务一个一个地创建的。这个过程往往漫长而又乏味。

如果没有大量数据的支撑,机器人将无法脱离实验室,无法独立执行做早餐等任务。令人惊艳的机器人研究成果,往往也只是某一个实验室研发出来的某一款机器人在执行某几项任务,对于其他实验室的机器人研究,可参考性有限。

特斯拉机器人 Optimus 在远程操控下叠衣服。

如果有一个汇集了许多机器人经验的「课本」,新机器人可以从中一次性学习,让机器人共享训练数据。这种做法是否能突破手动让机器人执行新任务带来的时间与精力限制?

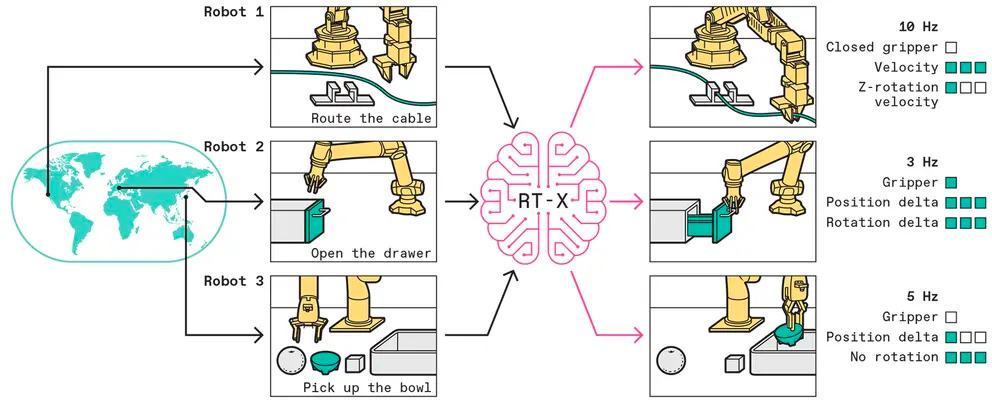

为了得到问题的答案,由谷歌 Deepmind 发起,来自北美、欧洲、亚洲的 34 个机器人实验室共同启动了 RT-X 项目。RT-X 项目的目标是汇集数据、资源和代码,让通用机器人走进现实。该项目的主要参与者加州大学伯克利分校的 Sergey Levine 教授和 Google DeepMind 的资深科学家 Karol Hausman 联合撰写了「THE GLOBAL PROJECT TO MAKE A GENERAL ROBOTIC BRAIN(打造通用机器人大脑的全球合作项目)」一文,总结了 RT-X 项目取得的进展。

RT-X 项目至今都做了哪些努力,让我们一起来看看。

造通用机器人,要从哪方面下手?

人类拥有强大的学习能力。我们的大脑在经过一点练习后,就可以指挥四肢行动,比如拿起工具、骑自行车或上车这种动作。换句话说,也就是我们的躯体发生了一些变化,但大脑能够理解。RT-X 的目标是让机器人也拥有这种「思维方式」:使单个深度神经网络能够控制许多不同类型的机器人。这种能力称为「交叉体现」。

然而「交叉体现」的问题在于,经过机器人数据训练的深度神经网络能否「驾驭」各种各样的机器人。一旦这些外观、物理特性和能力截然不同的机器人能被单个神经网络「大一统」,那么将释放出大型数据集对机器人学习的潜力。

RT-X 项目发布的 Open X-Embodiment 数据集规模庞大,目前它含有 22 种机器人的近 100 万次试验数据,其中包括市场上常用的机器臂。像拾取和放置物体、组装以及电缆布线这种专项任务的数据也都包含在其中,共有约 500 种不同的操作和数千种与其他物体的互动数据。Open X-Embodiment 是目前最大的真实机器人动作开源数据集。

一个惊喜的发现是,大模型从大型数据集学习的思路也适用于机器人领域。使用相对简单的机器学习方法,利用与当前 LLM(如 ChatGPT)相同的模型,研究者能够根据 Open X-Embodiment 数据集训练普遍的机器人控制算法。就像一个人可以通过大脑学习开车或骑自行车一样,在 Open X-Embodiment 数据集上训练的模型可以简单地通过机器人自带的摄像头识别模型所控制的机器人类型。例如摄像头识别出的是 UR10 工业臂,模型将发送适合 UR10 的命令。如果识别出的是低成本的 WidowX hobbyiest 机械臂,模型也会相应地调整指令。

谷歌基于 Open X-Embodiment 数据集训练出来了 RT-X 模型。为了测试「机器人大模型」的能力,参与 RT-X 项目的五个实验室分别对其进行了测试。他们将 RT-X 的训练结果与各自独立开发的最佳控制系统进行了比较。每个实验室的测试项目都涉及其机器人原本的研究任务,如拾取和移动物体、开门和通过夹子布线等。值得注意的是,统一的「大模型」超越了各个实验室的最佳方法,使机器人完成任务的平均成功率提高了约 50%。

更惊人的发现是,如下列动图所示,RT-X 模型可以运用其他机器人的经验来提高不同环境中正在被训练的机器人的鲁棒性。

在同一个实验室中,即使机器人在执行相同的任务,环境稍微不同,它也有可能无法成功完成同一动作。怪不得马斯克要强调在换了衣服、盒子和桌子和之后,特斯拉 Optimus 在未来肯定能学会叠衣服呢。

因此,能够借鉴其他机器人在其他情况下的经验有助 RT-X 模型控制的机器人应对变化和特殊情况。

搭建可以自主推理的机器人

受到以上成果的鼓舞,谷歌 DeepMind 的研究团队继续研究了如何如何将这些数据整合到一个具有更加深入的推理能力的系统中。仅从机器人数据中很难学习到复杂的语义推理。如「在罐子和橘子之间移动苹果」这个复杂任务,需要机器人理解图像中物体之间的语义关系、基本常识还有其他与物理能力不直接相关的符号知识等等。

为了解决复杂语义推理的问题,研究人员决定加入另一个庞大的数据源:全网的图像和文本数据。他们使用了一个现有的大型视觉语言模型,该模型已经精通许多需要理解自然语言和图像之间联系的任务。它是一个类似 ChatGPT 或 Bard 这样公开可用的模型。这个模型可以根据图片输入做出回答,能够解决视觉问答、字幕以及其他开放式视觉理解任务之类的问题。

研究团队发现,经过训练,生成式 AI 模型也能输出机器人动作以响应机器人命令(如「把香蕉放在盘子上」),机器人继而根据命令执行动作。基于这些发现,谷歌 DeepMind 研究团队将这种方法应用到 Open X-Embodiment 数据集中。

为了评估从互联网获取的智能和来自全世界的机器人数据的结合情况,谷歌 DeepMind 用他们的移动机械臂对 RT-X 模型进行了测试。研究人员对它进行了最严格的通用化基准测试。这要求机器人掌握识别物体、成功操纵物体、根据复杂的文本命令、整合文本和图像信息、进行逻辑推理等能力。这种能力正是人类成为通才的原因之一。

研究人员进行了两组评估。他们使用了一个不涉及谷歌的机器人、不包括多机器人数据的模型作为基准。事实上,由于 Open X-Embodiment 数据集中有超过 10 万次演示来自谷歌 DeepMind 的机器人,数据集中其他机器人数据是否起效,这个问题的答案仍然未知。因此,他们又尝试了基于 Open X-Embodiment 整体数据的评估。

对谷歌机器臂而言,「将苹果移到易拉罐和橘子之间」是最难的评估任务之一。这是一项涉及空间关系推理的任务。在「将一个物体放在写着解为 2+3 的纸上」这项任务中,它还需要解数学题。这些挑战旨在测试 RT-X 模型赋予机器臂的推理以及得出结论的能力。

在这种情况下,机器臂推理能力(例如推理出 「之间 」和 「上面 」的含义)来自于视觉语言模型训练中的全网数据,而将推理输出应用于机器人行为的能力(即使机器臂向正确方向移动的命令)来自 RT-X 对机器人数据的训练。下面的视频展示了一个评估实例,研究团队要求机器人执行一项未包含在训练数据中的任务。

即使没有经过专门训练,谷歌的机器臂也能够遵循指令「在罐子和橘子之间移动苹果」。这种能力是由 RT-X 实现的,这是迈向通用机器人大脑的第一步。

虽然这些任务对人类来说可能不值一提,但对通用机器人来说却是一大难题。如果没有具体的机器人演示数据清楚地说明「之间」、「附近」和「上面」是什么意思,即使共享了机器人的训练数据,基于此的系统也无法弄清楚这些命令的含义。

通过整合视觉语言模型中的全网知识,RT-X 的完整系统为机器人研究解决了很多问题。研究团队发现共享机器人数据的加入使谷歌机器人的泛化能力提高了三倍。这表明,Open X-Embodiment 数据集不仅有助于机器人获得各种物理技能,还有助于更好地让与物理动作与视觉语言模型中的语义和符号知识联系起来。这些联系使得机器人具备了一定的常识。有朝一日,机器人能够基于这些方法理解「给我拿早餐」这种复杂和微妙的命令,并为你端上一份热乎乎的早饭。

RT-X 项目的下一步

RT-X 项目展示了机器人社区凝心聚力之后取得的巨大进展。得益于跨地区、跨机构的努力,谷歌 DeepMind 汇集了多样化的机器人数据集,进行了全面的多机器人评估。此前,这对于任何单一机构都是不可能做到的事。RT-X 的发起者希望能有更多的研究人员入这项合作,分享他们的数据。他们还将开发工具、模型和基础设施来支持具身智能研究。

就像大型语言模型已经掌握了广泛的基于语言的任务一样,RT-X 项目目前的进展已经提供了一种大型具身机器人模型改变机器人领域的可能性。在未来,谷歌 DeepMind 将会使用相同的基础模型作为许多现实中的机器人做任务的基础。也许有一天,只通过微调,甚至只向预训练的基础模型输入提示,机器人就能获得新技能。你可以像使用 ChatGPT 一样,无需告诉机器人如何使用裱花袋或要写什么字体,机器人就能在一个蛋糕上做「生日快乐」的裱花。

随着越来越多的实验室参与 RT-X 项目,谷歌 DeepMind 希望进一步推进单个神经网络控制多台机器人的可能。未来他们可能将添加生成的各种模拟数据,加入更多种类的机器人(例如有不同数量的手臂或手指的机器人),引入不同的传感器套件(如深度相机和触觉传感器),结合操纵和运动行为等。

也许在未来,通用化的机器人大脑可以驱动任何机器人,全球所有机器人都可以从共享的数据中受益。