从 Llama、Llama 2 到 Mixtral 8x7B,开源模型的性能记录一直在被刷新。由于 Mistral 8x7B 在大多数基准测试中都优于 Llama 2 70B 和 GPT-3.5,因此它也被认为是一种「非常接近 GPT-4」的开源选项。

在前段时间的一篇论文中,该模型背后的公司 Mistral AI 公布了 Mixtral 8x7B 的一些技术细节,并推出了 Mixtral 8x7B – Instruct 聊天模型。该模型性能在人类评估基准上明显超过了 GPT-3.5 Turbo、Claude-2.1、Gemini Pro 和 Llama 2 70B 聊天模型。在 BBQ 和 BOLD 等基准中,Mixtral - Instruct 也显示出更少的偏见。

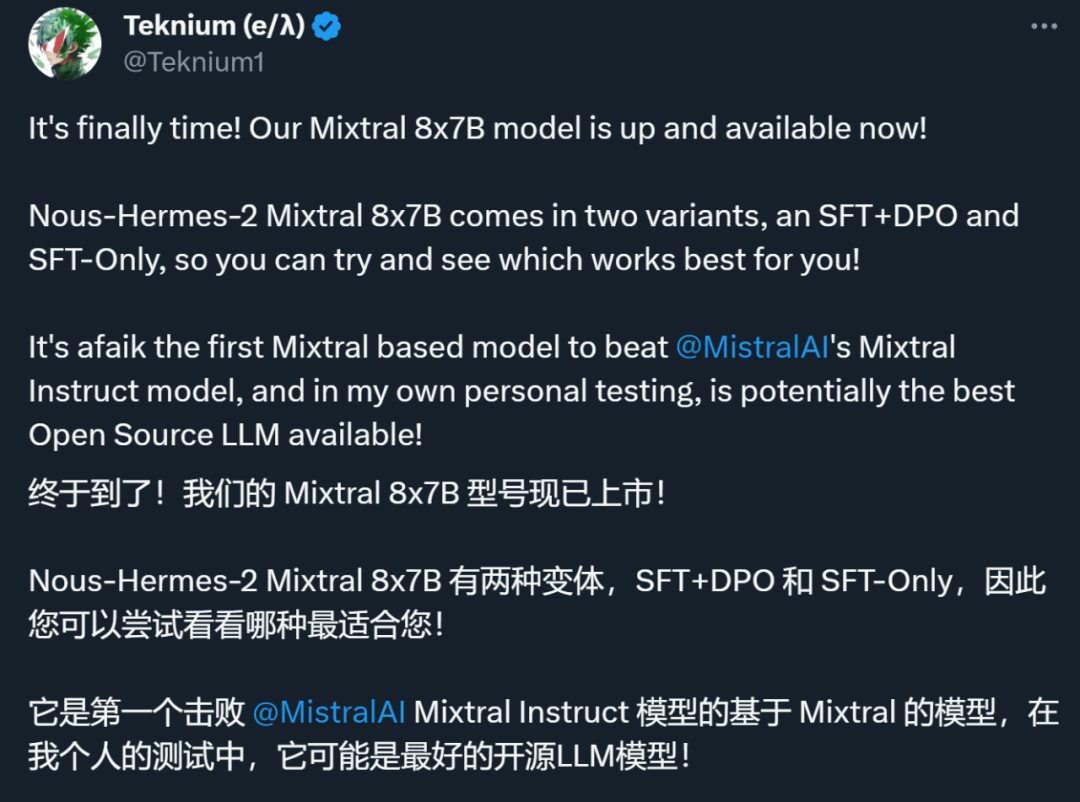

但最近,Mixtral Instruct 也被超越了。一家名叫 Nous Research 的公司宣布,他们基于 Mixtral 8x7B 训练的新模型 ——Nous-Hermes-2 Mixtral 8x7B 在很多基准上都超过了 Mixtral Instruct,达到了 SOTA 性能。

该公司联合创始人、X 平台用户 @Teknium (e/λ) 表示,「据我所知,这是第一个击败 Mixtral Instruct 的基于 Mixtral 的模型,在我个人的测试中,它可能是最好的开源 LLM 模型!」

模型资料卡显示,该模型在超过 100 万个条目(主要是 GPT-4 生成的数据)以及来自整个 AI 领域开放数据集的其他高质量数据上进行了训练。根据后续微调方法的不同,该模型被分为两个版本:

- 仅用 SFT 方法微调的 Nous Hermes 2 Mixtral 8x7B SFT。链接:https://huggingface.co/NousResearch/Nous-Hermes-2-Mixtral-8x7B-SFT

- 用 SFT+DPO 方法微调的 Nous Hermes 2 Mixtral 8x7B DPO。链接:https://huggingface.co/NousResearch/Nous-Hermes-2-Mixtral-8x7B-DPO。Mixtral Nous-Hermes 2 DPO Adapter 链接:https://huggingface.co/NousResearch/Nous-Hermes-2-Mixtral-8x7B-DPO-adapter

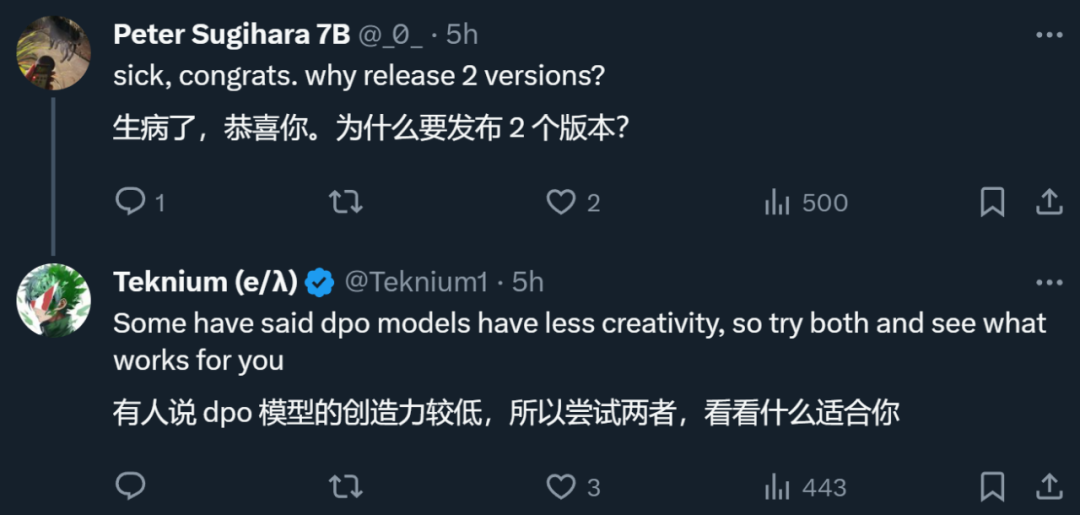

至于为什么发布两个版本,@Teknium (e/λ) 给出了以下解释:

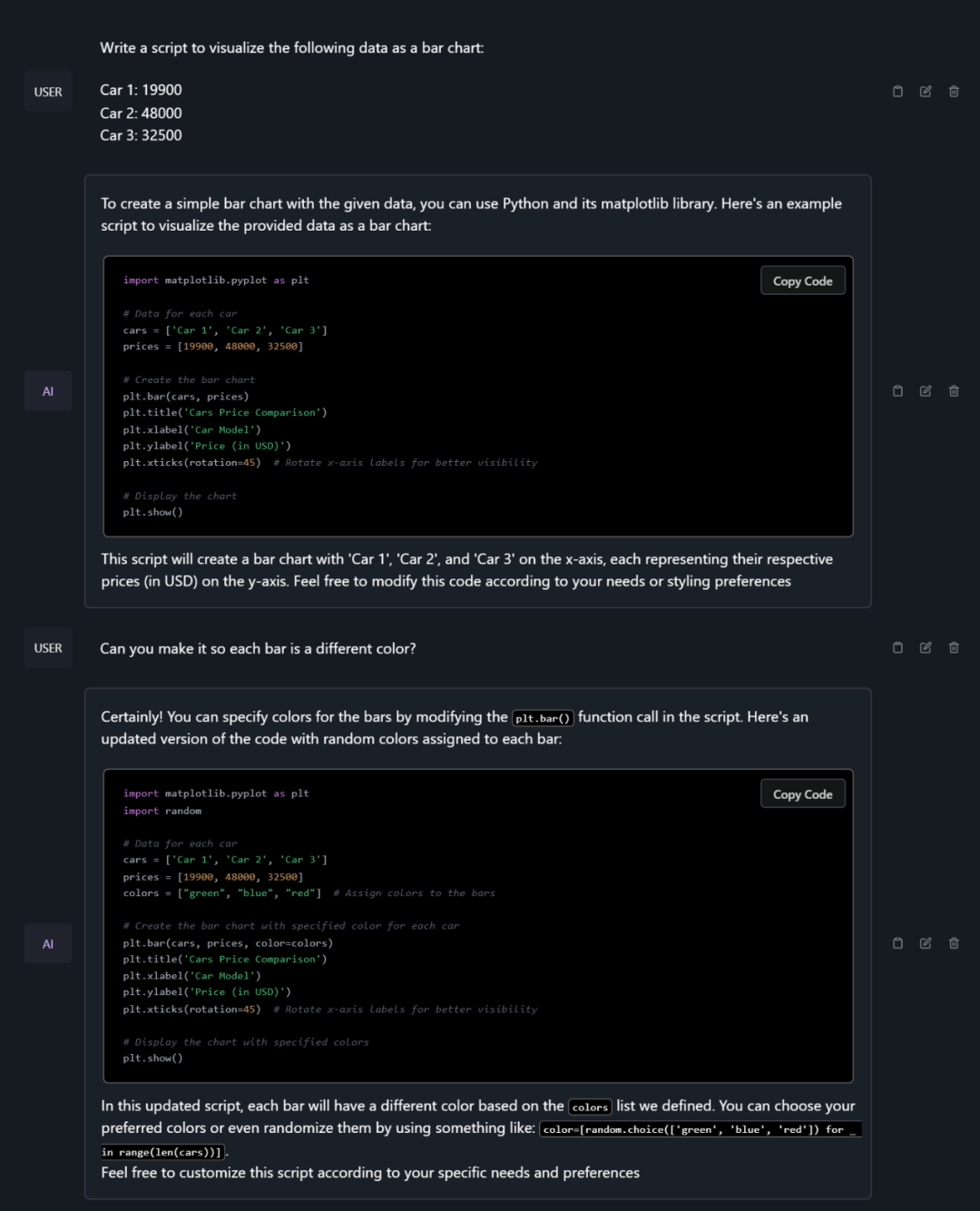

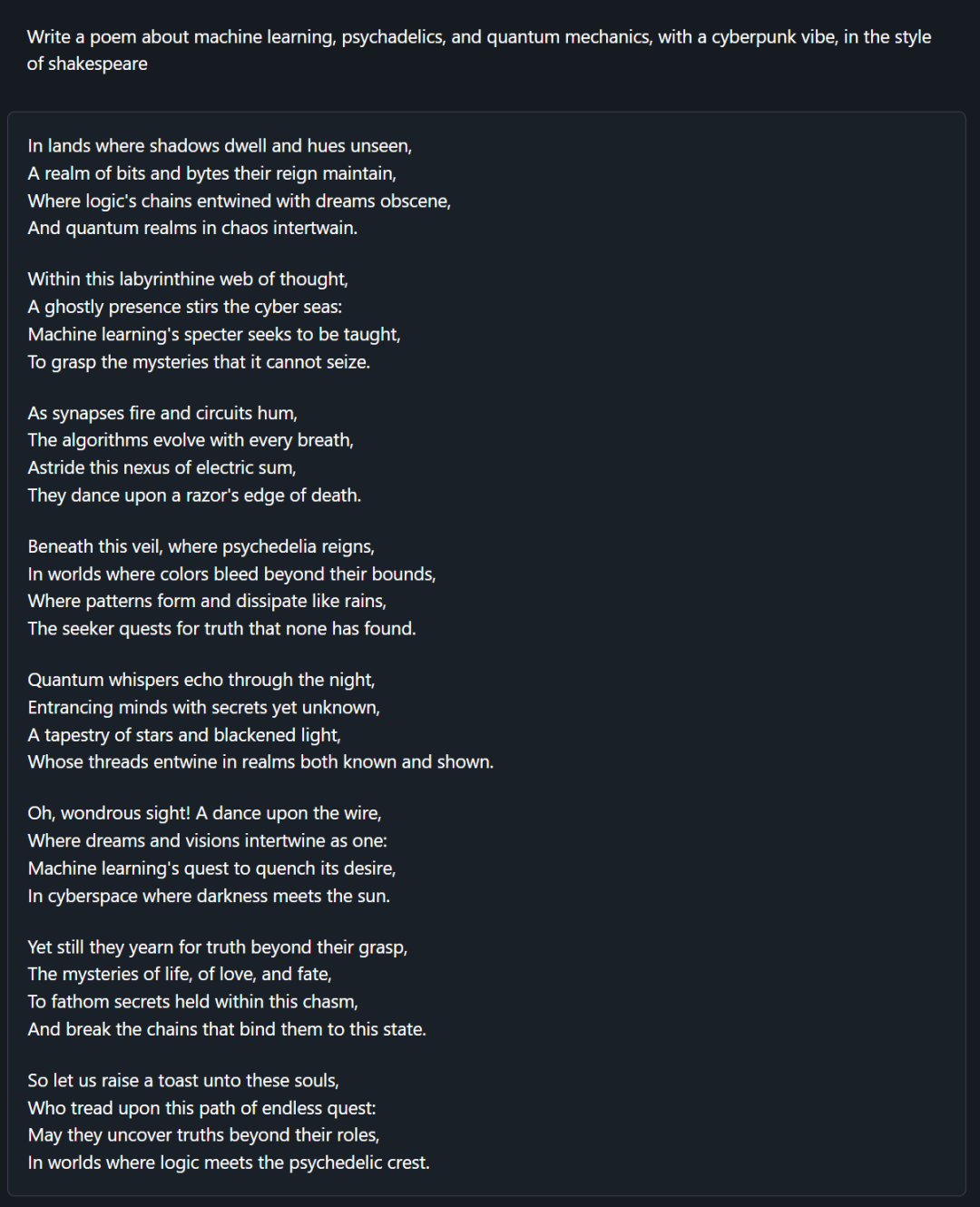

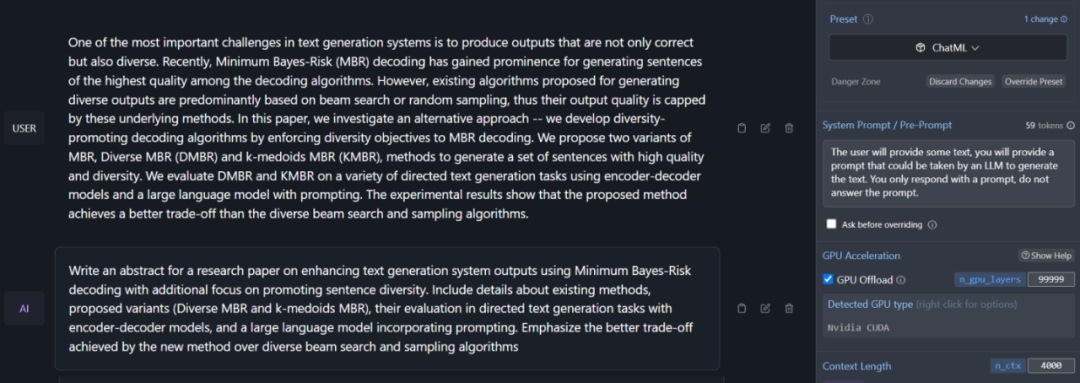

以下是模型的输出示例:

1、为数据可视化编写代码

2、写赛博朋克迷幻诗

3、根据输入文本创建提示

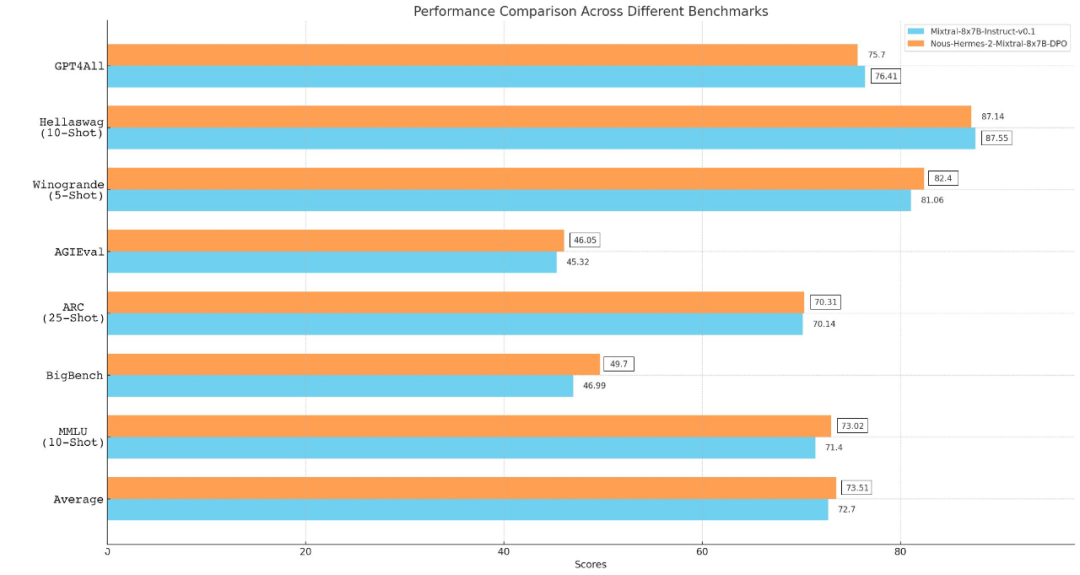

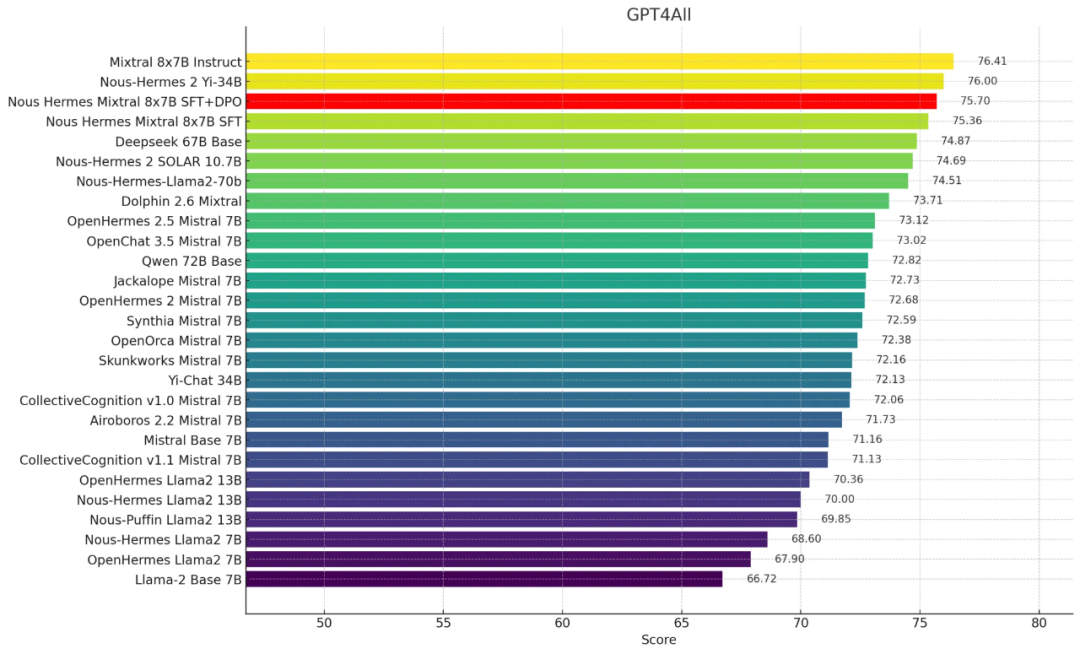

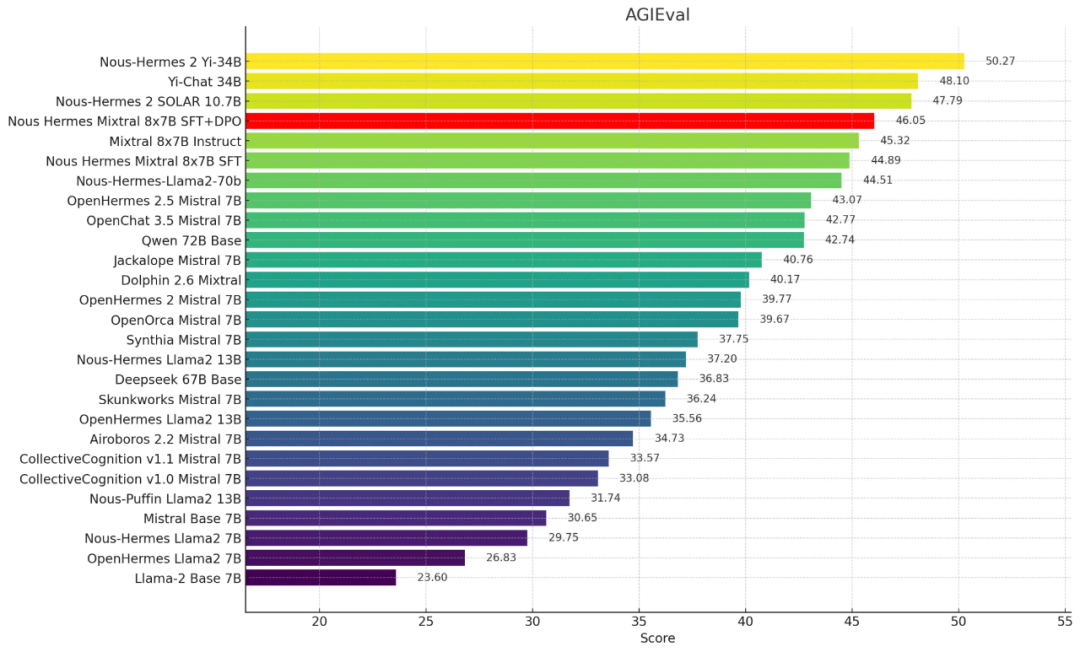

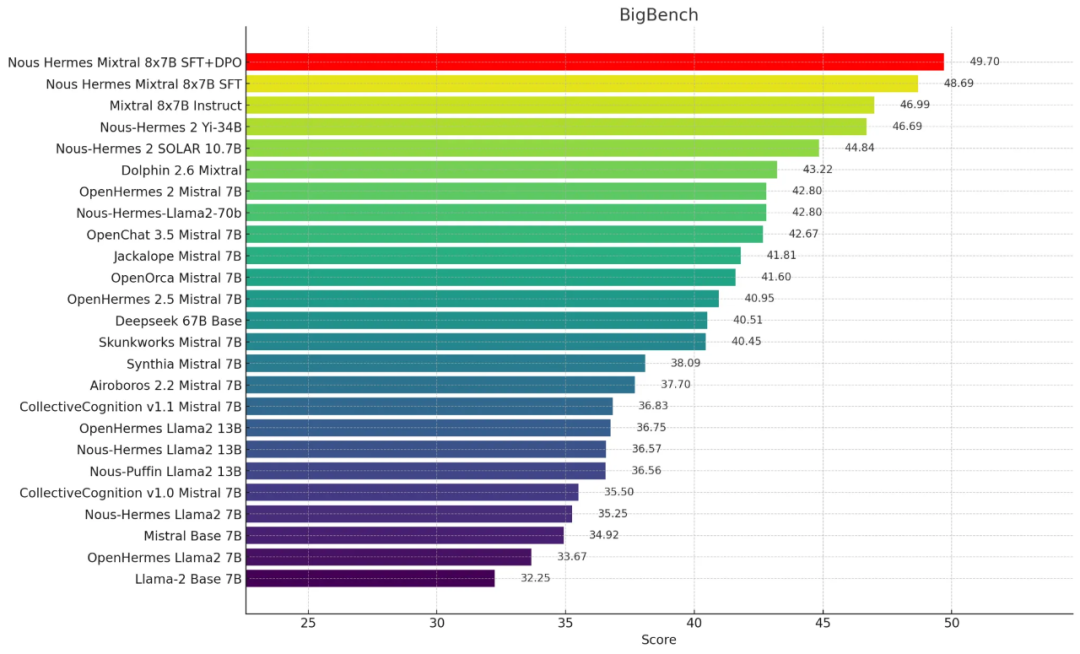

以下是一些性能数据:

1、GPT4All

2、AGI-Eval

3、BigBench 推理测试

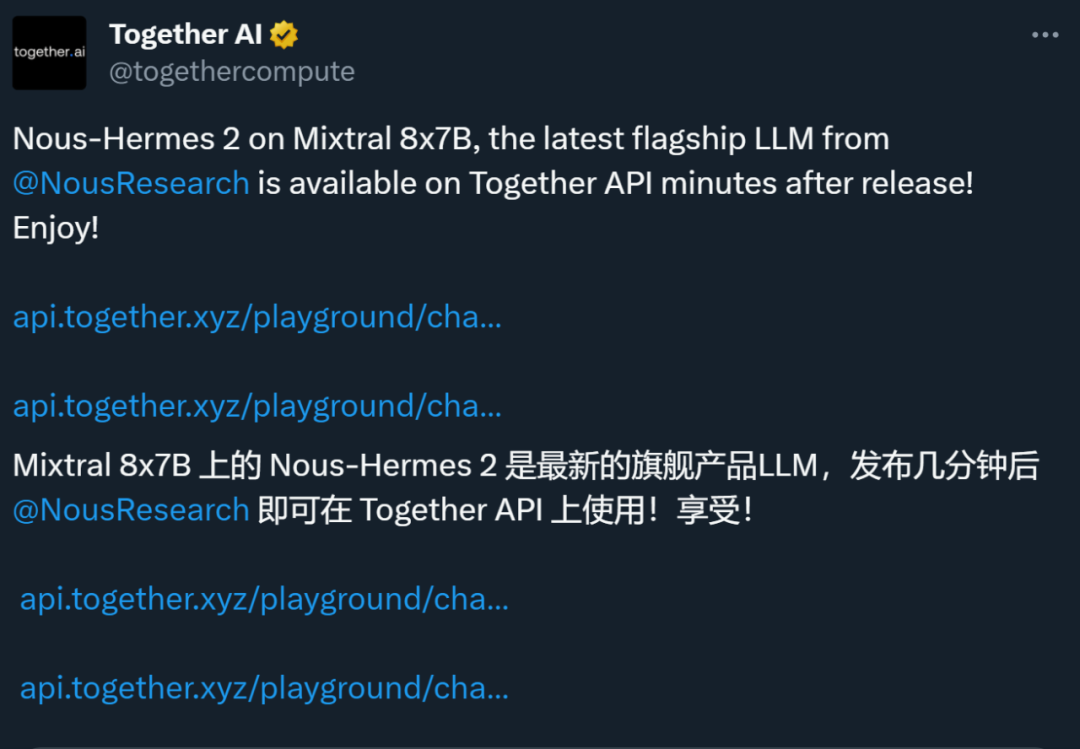

在模型发布之后不久,生成式 AI 初创公司 Together AI 就宣布了其 API 对该模型的支持。Together AI 去年 11 月刚完成超一亿美元的 A 论融资。在 Nous Research 训练和微调 Nous Hermes 2 Mixtral 8x7B 模型期间,Together AI 为他们提供了算力支持。

图源:https://twitter.com/togethercompute/status/1746994443482538141

Nous Research 最初是一个志愿者项目。他们最近成功完成了 520 万美元的种子融资轮,此轮融资由 Distributed Global 和 OSS Capital 联合领投,同时吸引了包括 Together AI 创始人兼 CEO Vipul Ved Reddy 在内的多位知名投资者的参与。Nous 计划在 2024 年推出一款名为 Nous-Forge 的 AI 编排工具。

从官网介绍中可以看到,他们的产品定位是:能够连接和运行程序,获取和分析客户文档,并生成合成数据供生产使用。这些专有系统可根据客户的需求进行微调,无论其业务领域如何。通过这些新颖的算法,他们希望聚合并分析数字注意力生态系统中以往非结构化的专题数据,为客户提供隐藏的市场脉搏信息。