据美国调查新闻网站“拦截者”(The Intercept)1月12日报道,美国知名人工智能企业、ChatGPT母公司OpenAI近日悄悄修改了其产品的使用条款,删除了禁止将OpenAI技术用于军事用途的条文。

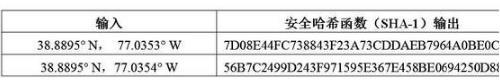

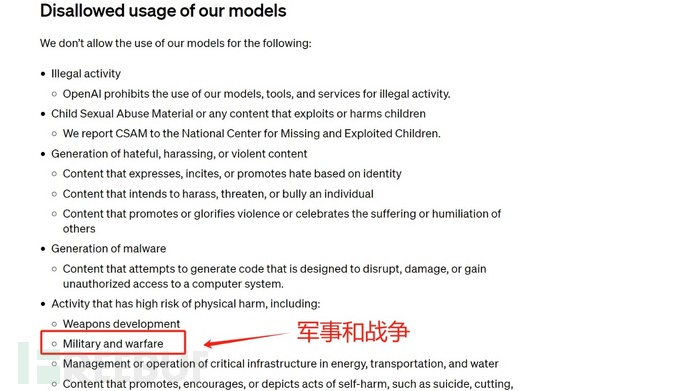

报道称,在今年1月10日之前,OpenAI公司网站发布的使用条款曾明确规定,禁止将该公司的AI模型应用于“很可能造成人员伤亡的用途”,比如“武器研发”和“军事与战争”。“军事”一词,极为明确地将美国国防部、美军、CIA等排除出了OpenAI的用户范畴。

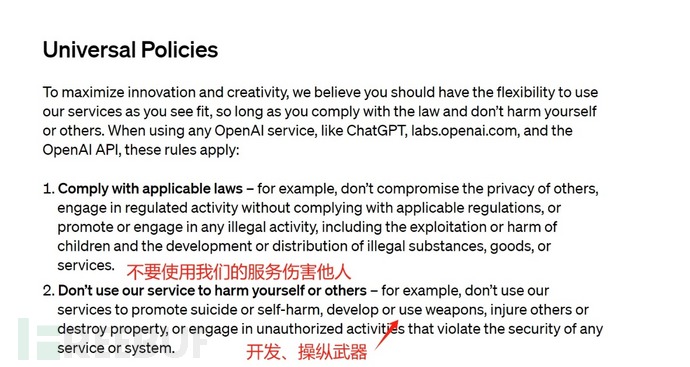

在上周的修改后,OpenAI在“通用政策”条款中虽然也有“不要使用公司服务伤害自己或他人”,并明确表示禁止“AI开发或操纵武器”,但军事这一关键限制性词汇,却从政策中消失了。

对此,OpenAI公司发言人尼克·菲利克斯(Niko Felix)在一份回复“拦截者”网站的邮件中表示,调整使用条款是为了设立一套易于记忆和应用的通用原则,“像‘不伤害他人’这样的规则很宽泛且容易理解,可以适用于很多语境之下。我们还特别列举了武器作为例子。”

但菲利克斯拒绝说明“禁止伤害他人”的表述是否包括所有军事用途。他仅在邮件中表示:“包括军方在内,任何将我们的技术用于研发或使用武器、伤害他人或破坏财产、在未经授权的情况下用于破坏任何服务或系统安全的行为,都是不被允许的。”

美国网络安全公司Trails of Bits的机器学习和自主系统安全专家海蒂·赫拉夫(Heidy Khlaaf)认为,OpenAI的新政策可能是想在确保法律合规之上提供更多的灵活性,“发展武器以及从事与军事有关的活动在不同程度上是合法的,这项调整对AI安全的潜在影响非常大。”

但赫拉夫警告说,鉴于大语言模型中普遍存在“幻觉”和“偏见”的问题,总体上缺乏足够的准确性,将其应用于军事与战争很可能会加剧平民伤亡。

一些专家还表示,OpenAI似乎在悄悄弱化其反对军事应用的立场。他们对“拦截者”网站指出,OpenAI的主要投资者、美国科技巨头微软公司就是美国军方的主要供应商之一。

美国AI研究机构“AI Now”总经理、前联邦贸易委员会AI政策分析师莎拉·迈尔斯·韦斯特(Sarah Myers West)直言,新使用条款的措辞含糊不清,这引发了外界对于OpenAI会如何执行新条款的疑问。

美国军方领导层此前已对AI技术表现出兴趣,美国国防部副部长凯瑟琳·希克斯去年11月曾表示,AI技术是“以作战人员为中心的全面创新方法的关键组成部分”。但希克斯也承认,当前的AI技术还不够成熟,“不符合我们要求的AI道德原则”。

“拦截者”网站称,尽管OpenAI提供的产品还无法被用于操控武器,但美国军方已经开始将其技术应用于协助编写代码、处理武器采购订单和情报分析等工作,“尽管OpenAI工具没有被直接用于杀人,它们已经被用于协助这样的工作。”

参考链接:https://news.china.com/socialgd/10000169/20240115/46082732_1.html