译者 | 李睿

审校 | 重楼

如今,大型语言模型(LLM)正在彻底改变人们的工作和生活,从语言生成到图像字幕软件,再到友好的聊天机器人。这些人工智能模型为解决现实世界的问题提供了强大的工具,例如生成聊天响应或遵循复杂的指令。在这篇关于LLaMA v2的文章中,将对LLaMA 13b-v2-Chat和Alpaca这两种流行的人工智能模型进行比较,并探索它们的功能、用例和局限性。

此外还将介绍如何使用AIModels,找到类似的模型,并将它们与LLaMA13b-v2-Chat和Alpaca进行比较。

关于LLaMA13b-v2-Chat模型

LLaMA 13b-v2-Chat模型是Meta公司最初开发的具有130亿个参数的LLaMA-v2语言模型的微调版本。专门针对人工智能聊天完成进行了微调,使其成为生成对用户消息的聊天响应的优秀工具。用户可以在LLaMA13b-v2-Chat创建器页面和LLaMA13b-v2-Chat模型详细信息页面上找到关于该模型的详细信息。

该语言模型旨在帮助为基于聊天的交互生成基于文本的响应。无论是提供客户支持、生成会话代理还是协助自然语言理解任务,LLaMA13b-v2-Chat是一个具有价值的工具。它的大型参数规模使它能够捕获复杂的语言模式并生成连贯的和场景相关的响应。

总之,LLaMA 13b-v2-Chat可以理解输入并生成适当的聊天响应。

了解LLaMA 13b-v2-Chat模型的输入和输出

为了有效地使用Llama13b-v2-Chat模型,有必要了解它的输入和输出。该模型接受以下输入:

(1)提示:表示聊天提示或查询的字符串。

(2)最大长度:指定要生成的令牌的最大数量的整数。

(3)温度:调节输出随机性的数字。较高的值(大于1)产生更多的随机响应,而较低的值(接近0)产生更多的确定性输出。

(4)Top P:在解码文本时,从最可能的符号的Top P百分比中抽取样本。较低的值将采样限制为更可能的令牌。

(5)重复扣分:对生成文本中单词重复进行扣分。较大的值会阻碍重复,而小于1的值则会鼓励重复。

(6)调试:在日志中提供调试输出的布尔标志。

Llama13b-v2-Chat模型处理这些输入,并生成字符串列表作为输出,表示生成的聊天响应。输出的模式是一个包含字符串的JSON数组。人们可以在其指南中找到更多关于这个模型的信息。

关于Alpaca模型

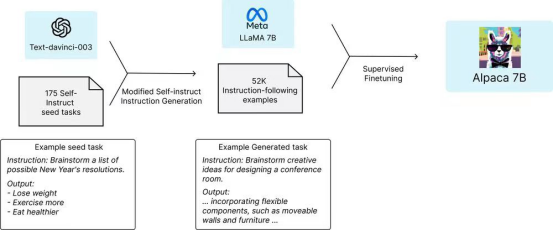

Alpaca模型是一种指令遵循语言模型,由LLaMA 7B模型在52K指令遵循演示中微调而成。它是由斯坦福基础模型研究中心(CRFM)开发的。Alpaca的创造者是Rohan Taori、Ishaan Gulrajani、Tianyi Zhang、Yann Dubois、xuchen Li、Carlos Guestrin、Percy Liang和Tatsunori B. Hashimoto。用户可以在该团队创建的网站页面上找到关于该模型的详细信息。

Alpaca模型侧重于指令遵循能力,旨在通过为学术目的提供易于访问的指令遵循语言模型来弥合研究与应用之间的差距。它使用52K指令跟随演示的数据集对LLaMA 7B模型进行了微调,使用text-davinci-003以自我指导的方式生成。该模型在单圈指令跟踪中表现出良好的性能。

该模型的发布旨在促进学术研究和教学遵循模型的改进。值得注意的是,Alpaca模型不是为商业用途而设计的,其安全措施也没有完全开发用于一般部署。

总之,Alpaca提供了一个轻量级的、可重复的指令遵循语言模型,可用于研究目的和探索指令遵循场景。

Alpaca模型的工作原理

Alpaca模型的工作原理

理解Alpaca模型的输入和输出

为了有效地利用Alpaca模型,以下探索它的输入和输出。

作为一个指令遵循模型,Alpaca遵循指令并根据给定的指令生成响应。Alpaca的输入由指令本身表示,这些指令描述了模型应该执行的任务。Alpaca还有一个可选的输入字段,为其任务提供额外的场景或输入。

Alpaca模型的输出是对给定指令的生成响应。响应是基于经过微调的模型对任务的理解和在训练期间学到的底层语言模式生成的。

模型的比较与对比

现在已经详细探讨了LLaMA 13b-v2-Chat模型和Alpaca模型,以下将它们进行比较和对比,以了解它们的相似点、不同点和最佳用例。

(1)LLaMA 13-v2 vs Alpaca

LLaMA 13b-v2-Chat和Alpaca模型都是针对不同目的而设计的微调语言模型。虽然LLaMA 13b-v2-Chat专注于聊天完成,Alpaca专门从事指令跟随任务。

(2)用例

LLaMA 13b-v2-Chat模型适用于各种聊天完成任务。它可以用于客户服务应用程序、聊天机器人开发、对话生成和交互式会话系统。该模型的多功能性允许它对用户查询或提示生成连贯且与场景相关的响应。

另一方面,Alpaca模型是专门为指令跟随任务量身定制的。它擅长于理解和执行用户提供的指令,使其成为虚拟助手、任务自动化和逐步指导系统等应用程序的理想选择。Alpaca模型理解和遵循指令的能力使它成为用户在执行各种任务时寻求帮助的有价值的工具。

(3)利弊

LLaMA 13b-v2-Chat模型的优势在于它的参数大小(130亿个)和对聊天完成的微调。它可以生成详细和场景适当的响应,使其对参与和互动的会话体验非常有用。由于其通用性,该模型偶尔可能会产生事实上不正确的反应或传播刻板印象。应该实施仔细的监测和过滤机制,以减轻这些风险。

另一方面,Alpaca模型提供了一个更小、更具成本效益的模型(70亿个参数),是专门优化的指令遵循。它展示了与该领域的text-davinci-003模型相当的性能。Alpaca模型的相对容易再现性和较低的成本使其成为对指令遵循模型感兴趣的学术研究人员的一个具有吸引力的选择。然而,它有语言模型的共同局限性,包括偶尔的幻觉和产生虚假或误导性信息的可能性。

(4)相似之处

这两个模型都建立在LLaMA框架之上,该框架为微调提供了强大的基础语言模型。它们利用大规模语言模型的力量来生成高质量的输出。此外,这两个模型都经过了评估,并与text- davincic -003模型进行了比较,展示了它们在指令执行任务方面的相似能力。

(5)差异

模型之间的主要差异在于它们预期的用例和专业。虽然LLaMA 13b-v2-Chat是一个通用的聊天完成模型,适用于各种会话应用程序,但Alpaca是专门为指令遵循任务设计的。Alpaca的训练数据是基于自我指示的提示生成的,使它能够有效地理解和执行特定的指令。

(6)最佳用例

在LLaMA 13b-v2-Chat和Alpaca模型之间进行选择取决于用户对项目或应用程序的具体要求。如果其目标是开发一个会话系统或聊天机器人,以参与动态和场景感知的对话,那么LLaMA 13b-v2-Chat将是更好的选择。另一方面,如果用户需要一个能够理解并执行面向任务的应用程序的用户指令的模型,那么Alpaca是更合适的选择。

更进一步:使用AIModels.fyi查找其他指令跟随或聊天模型

如果用户有兴趣探索除了Alpaca之外的其他指令遵循模型,AIModels.fyi是一个宝贵的资源。它提供了一个全面的人工智能模型数据库,包括那些迎合指令遵循任务的模型。通过以下步骤,可以发现相似的模型并比较它们的输出:

步骤1:访问AIModels.fyi

转到AIModels.fyi开始搜索指令遵循模型。

步骤2:使用搜索栏

利用页面顶部的搜索栏输入与指令遵循模型相关的特定关键字,这将为用户提供与其搜索查询相关的模型列表。

步骤3:筛选结果

在搜索结果页面的左侧,将找到各种过滤器来缩小模型的范围。可以根据模型类型、成本、流行程度和特定创建者进行筛选和排序。应用这些过滤器来找到与用户的需求一致的模型。

通过利用AIModels.fyi的搜索和过滤特性,用户可以找到最适合其需求的模型,并探索指令遵循模型的不同表现。

结论

在这个比较中,探讨了LLaMA 13b-v2-Chat和Alpaca模型的用例、优缺点、相似性、差异性和最佳应用。强调了LLaMA 13b-v2-Chat在聊天完成方面的多功能性,以及Alpaca在指导后续任务方面的专业性。AIModels.fyi是发现和比较各种人工智能模型的宝贵资源,包括指令跟随模型。希望这一指南能激励人们探索人工智能的创造性可能性,并鼓励用户利用AIModels.foyi找到符合其特定需求的模型。

原文标题:LLaMA-v2-Chat vs. Alpaca: When Should You Use Each AI Model?,作者:Mike Young