本文经自动驾驶之心公众号授权转载,转载请联系出处。

1.Nuscenes

数据集链接:nuScenes

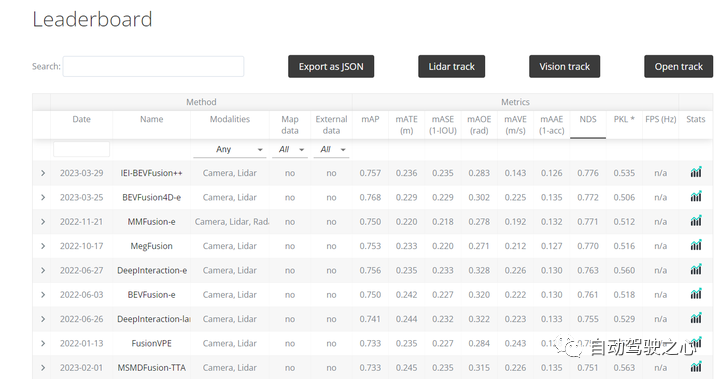

nuscenes数据集下有多个任务,涉及Detection(2D/3D)、Tracking、prediction、激光雷达分割、全景任务、规划控制等多个任务;

nuScenes数据集是一个具有三维目标注释的大型自动驾驶数据集,也是目前主流算法评测的benchmark,它的特点:

● 全套传感器套件(1个激光雷达、5个雷达、6个摄像头、IMU、GPS)

● 1000个20s的场景

● 1400000张相机图像

● 39万次激光雷达扫描

● 两个不同的城市:波士顿和新加坡

● 左侧交通与右侧交通

● 详细地图信息

● 为23个目标类手动注释的1.4M 3D边界框

2.KITTI

数据集官网:The KITTI Vision Benchmark Suite (cvlibs.net)

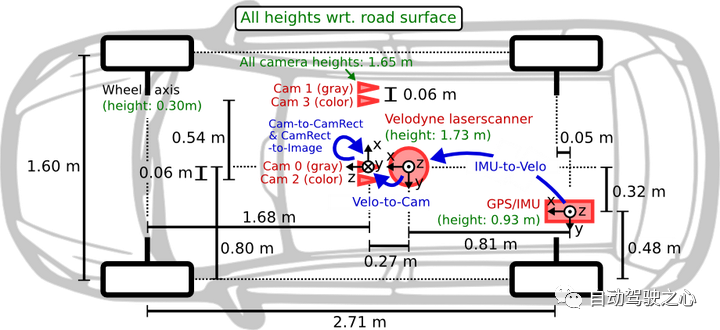

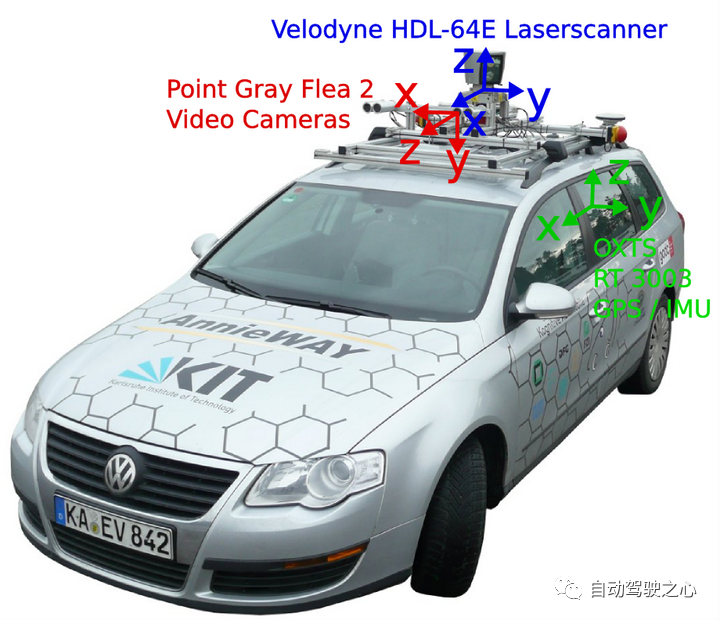

ITTI数据集由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办,该数据集用于评测立体视觉(stereo),光流(optical flow),视觉测距(visual odometry),3D物体检测(object detection)和3D跟踪(tracking)等计算机视觉技术在车载环境下的性能。KITTI包含市区、乡村和高速公路等场景采集的真实图像数据,每张图像中最多达15辆车和30个行人,还有各种程度的遮挡与截断。整个数据集由389对立体图像和光流图,39.2 km视觉测距序列以及超过200k 3D标注物体的图像组成 ,以10Hz的频率采样及同步。总体上看,原始数据集被分类为’Road’, ’City’, ’Residential’, ’Campus’ 和 ’Person’。对于3D物体检测,label细分为car, van, truck, pedestrian, pedestrian(sitting), cyclist, tram以及misc组成。

因为数据量少,目前很多算法验证都在nuscenes上啦~~~

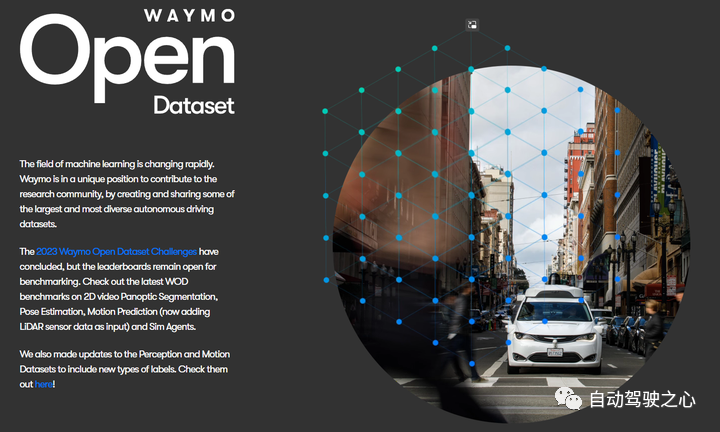

3.Wamyo

年份:2020年;

作者:Waymo LLC和Google LLC

场景数:共1150个场景,主要采集自San Francisco,Mountain View,Phoenix等;

类别数:共4类,分别是Vehicles,Pedestrians,Cyclists及Signs;

是否360°采集:是;

数据总量:共包含 2030个片段,每个片段长度为20秒;

标注总数:约12,600,000个3D标注框;

传感器型号:包含1个mid-range LiDAR,4个short-range LiDARs,5个相机(前置及侧面),同时LiDAR和相机是经过同步和标定处理过的;

数据集链接:https://waymo.com/open/;

简介:Waymo是自动驾驶领域最重要的数据集之一,规模很大,主要用以支持自动驾驶感知技术的研究。Waymo主要由两个数据集组成,Perception Dataset及Motion Dataset。其中,Perception Dataset包含3D标注,2D全景分割标注,关键点标注,3D语义分割标注等。Motion Dataset主要用于交互任务的研究,共包含103,354个20s片段,标注了不同物体及对应的3D地图数据。

4.BDD100K

BDD100K数据集是2018年5月由伯克利大学AI实验室(BAIR)所发布,同时设计了一个图片标注系统。BDD100K数据集包含10万段高清视频,每个视频约40秒/720p/30 fps 。每个视频的第10秒对关键帧进行采样,得到10万张图片,图片分辨率为1280*720,并对其进行标注。数据库集包含了不同天气、场景、时间的图片,具有规模大,多样化的特点。

主要任务:视频、可行使区域、车道线、语义分割、实力分割、全景分割、MOT、检测任务、Pose等;

数据集链接:Berkeley DeepDrive

5.Lyft L5数据集

年份:2019年;

作者:Woven Planet Holdings;

场景数:共1805个场景,室外;

类别数:共9类,包括Car,Pedestrian,traffic lights等;

是否360°采集:是;

数据总量:包括46,000张图像数据,及其对应的点云数据;

标注总数:约1300,000个3D标注框;

传感器型号:包括2个LiDARs,分别是40线和64线,安装在车顶及保险杠上,其分辨率为0.2°,在10Hz下采集约216,000个点。此外,还包括6个360°相机和1个长焦相机,摄像机与LiDAR采集频率一致。

数据集链接:https://level-5.global/data/;

简介:Lyft L5是一整套L5级自动驾驶数据集,据称“业内最大的自动驾驶公共数据集”,涵盖了Prediction Dataset及Perception Dataset。其中Prediction Dataset涵盖了自动驾驶测车队在Palo Alto沿线遇到的各类目标,如Cars,Cyclists和Pedestrians。Perception Dataset则涵盖了自动驾驶车队装置的LiDARs和摄像机采集的真实数据,并通过人工方式标注了大量的3D边界框。

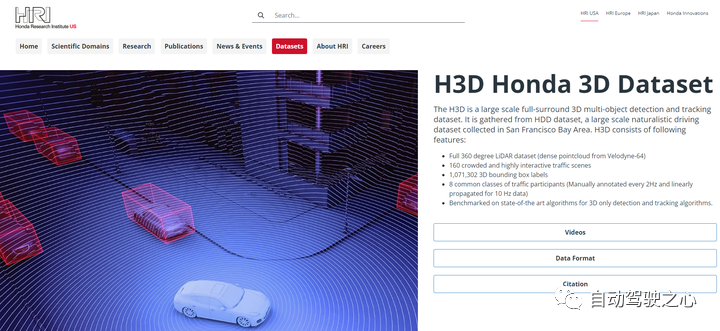

6.H3D数据集

年份:2019年;

作者:Honda Research Institute;

场景数:共160个场景,室外;

类别数:共8类;

是否360°采集:否;

数据总量:包括27,000张图像数据,及其对应的点云数据;

标注总数:约1100,000个3D标注框;

传感器型号:共配备了3个相机型号为Grasshopper 3,分辨率均为1920x1200,除了背面的相机FOV为80°,其他的2个相机的FOV为90°,使用了一个64线的LiDAR,型号为Velodyne HDL64E S2,以及一个GNSS+IMU型号为ADMA-G;

数据集链接:http://usa.honda-ri.com/H3D;

简介:本田研究所于2019年3月发布其无人驾驶方向数据集H3D。该数据集使用3D LiDAR扫描仪收集的包括3D多目标检测和跟踪数据,包含160个拥挤且高度互动的交通场景,在27,721帧中有超过100万个标记实例。

主要任务包括:

7.ApplloScape数据集

年份:2019年;

作者:Baidu Research;

场景数:共103个场景,室外;

类别数:共26类,包括small vehicles,big vehicles,pedestrian,motorcyclist等;

是否360°采集:否;

数据总量:包括143,906张图像数据,及其对应的点云数据;

标注总数:标注总数未知;

传感器型号:共配置了2个VUX-1HA laser scanners,6个VMX-CS6相机(其中两个前置相机分辨率为3384x2710),还有一个IMU/GNSS设备;laser scanners利用两束激光来扫描其周围环境,与常用的Velodyne HDL64E相比,scanner可以获得更高密度的点云,同时具备更高精度(5mm/3mm);

数据集链接:http://apolloscape.auto/index.html;

简介:ApolloScape由RGB视频和对应的稠密点云组成。包含超过140K张图片,并且每张图片都有像素级的语义信息。在国内采集的数据,所以相比于国外的一些数据集,ApolloScape数据集包含的交通场景较复杂,各类目标数量较多,且与KITTI数据集类似,同样包含Easy,Moderate,Hard三个子集。

主要任务包括:车道线、定位、轨迹预测、检测、跟踪、双目、场景识别等;

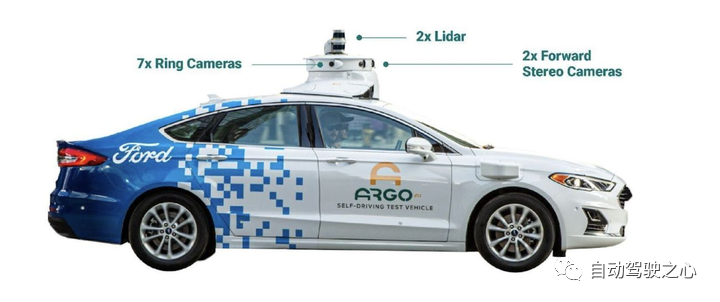

8.Argoverse数据集

年份:2019年;

作者:Argo AI等;

场景数:共113个场景,室外,包括USA,Pennsylvania,Miami,Florida等;

类别数:共15类,包括Vehicle,Pedestrian,Stroller,Animal等;

是否360°采集:是;

数据总量:包括44,000张图像数据,及其对应的点云数据;

标注总数:约993,000个3D标注框;

传感器型号:与KITTI及nuScenes相似,Argoverse数据集配置了两个32线LiDAR传感器,型号为VLP-32。同时,包括7个高分辨率环视相机,分辨率为1920x1200,2个前置相机,分辨率为2056x2464;

数据集链接:https://www.argoverse.org/;

主要任务:3D跟踪、运动预测等任务

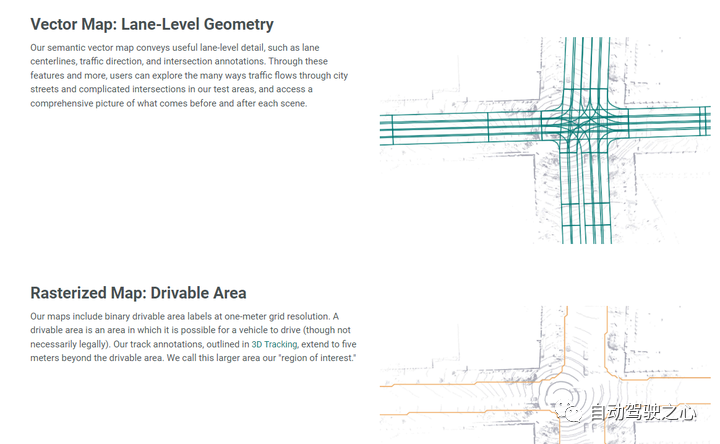

简介:Argoverse中的数据来自Argo AI的自动驾驶测试车辆在迈阿密和匹兹堡(这两个美国城市面临不同的城市驾驶挑战和当地驾驶习惯)运行的地区的子集。包括跨不同季节,天气条件和一天中不同时间的传感器数据或“日志段”的记录,以提供广泛的实际驾驶场景。其包含了共113个场景的3D跟踪注释,每个片段长度为15-30秒,共计包含11052个跟踪目标。其中,70%的标注对象为车辆,其余对象为行人、自行车、摩托车等;此外,Argoverse包含高清地图数据,主要囊括匹兹堡和迈阿密290公里的车道地图,如位置、连接、交通信号、海拔等信息。

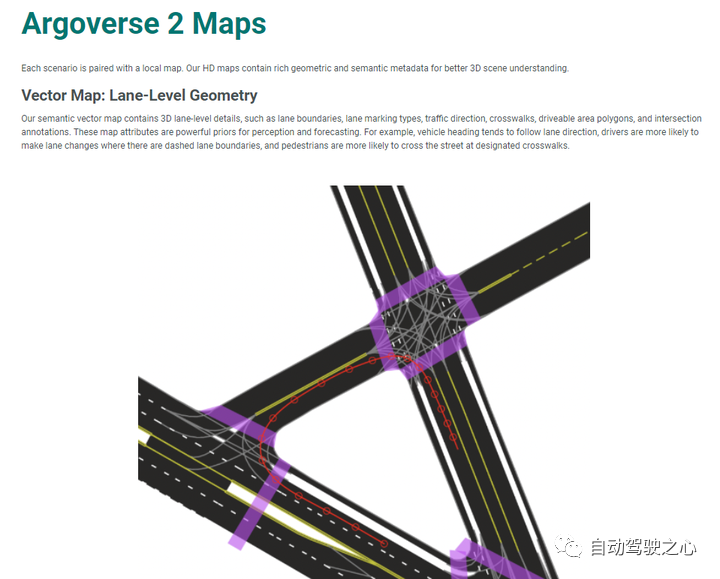

9.Argoversev2数据集

Argoverse 2是一个开源自动驾驶数据和高清(HD)地图的集合,来自美国六个城市:奥斯汀、底特律、迈阿密、匹兹堡、帕洛阿尔托和华盛顿特区。本次发布建立在Argovverse(“Argoverse1”)的首次发布基础上,Argovverse1是首批包含用于机器学习和计算机视觉研究的高清地图的数据发布之一。

Argoverse 2包括四个开源数据集:

Argoverse 2传感器数据集:包含1000个带有激光雷达、立体图像和环形摄像头图像的3D注释场景。该数据集改进了Argoverse 1 3D跟踪数据集;

Argoverse 2运动预测数据集:包含250000个场景,其中包含许多对象类型的轨迹数据。该数据集改进了Argoverse 1运动预测数据集;

Argoverse 2激光雷达数据集:包含20000个未标记的激光雷达序列;

Argoverse 2地图更改数据集:包含1000个场景,其中200个场景描述了真实世界的高清地图更改!

Argoverse 2数据集共享一种通用的高清地图格式,该格式比Argoverse 1中的高清地图更丰富。Argoverse 2数据集还共享一个通用的API,允许用户轻松访问和可视化数据和地图。

10.Occ3D

清华大学和英伟达出品,第一个大规模占用栅格benchmark!

数据集链接:Occ3D: A Large-Scale 3D Occupancy Prediction Benchmark for Autonomous Driving (tsinghua-mars-lab.github.io)

作者生成了两个3D占用预测数据集,Occ3D nuScenes和Occ3D Waymo。Occ3D nuScenes包含600个用于训练的场景、150个用于验证的场景和150个用于测试的场景,总计40000帧。它有16个公共类和一个额外的通用对象(GO)类。每个样本覆盖范围为[-40m、-40m、-1m、40m、40m、5.4m],体素大小为[0.4m、0.4m、0.4m]。Occ3D Waymo包含798个用于训练的序列,202个用于验证的序列,累积了200000帧。它有14个已知的目标类和一个额外的GO类。每个样本覆盖的范围为[-80m、-80m、-1m、80m、80m和5.4m],极细的体素大小为[0.05m、0.05m、0.05m]。

11.nuPlan

nuPlan是世界上第一个自动驾驶的大规模规划基准,虽然越来越多的基于ML的运动规划人员,但由于缺乏既定的数据集、模拟框架和指标,限制了该领域的进展。自动驾驶汽车运动预测的现有基准(Argovest、Lyft、Waymo)专注于其他智能体的短期运动预测,而不是自我汽车的长期规划。这导致以前的工作使用基于L2的指标进行开环评估,这不适合公平评估长期规划。这个基准测试通过提供一个训练框架来开发基于机器学习的规划者、一个轻量级闭环模拟器、特定于运动规划的指标和一个可视化结果的交互式工具,克服了这些限制。

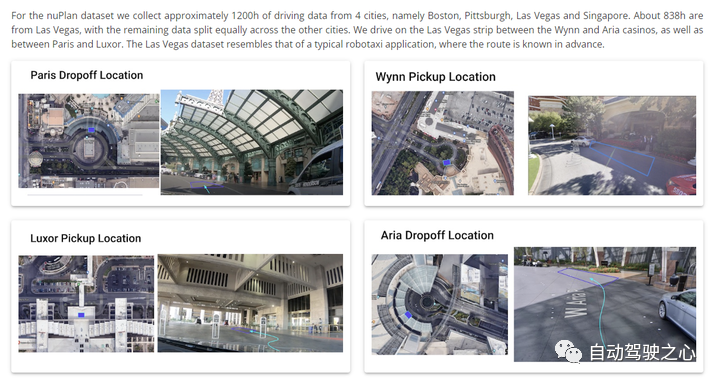

提供了一个大规模数据集,其中包含来自美国和亚洲4个城市(波士顿、匹兹堡、拉斯维加斯和新加坡)的1200小时人类驾驶数据。数据集使用最先进的Offline Perception系统自动标记。与现有的这种大小的数据集相反,不仅发布了数据集中检测到的对象的3d框,还提供了10%的原始传感器数据(120h)。

数据集链接:nuPlan (nuscenes.org)

12.ONCE (One Million Scenes)

● 发布方:华为

● 发布时间:2021

● 简介:ONCE(One millioN sCenEs)是自动驾驶场景下的3D物体检测数据集。ONCE 数据集由 100 万个 LiDAR 场景和 700 万个对应的相机图像组成。这些数据选自 144 个驾驶小时,比 nuScenes 和 Waymo 等其他可用的 3D 自动驾驶数据集长 20 倍,并且是在一系列不同的地区、时期和天气条件下收集的。由组成:100 万个 LiDAR 帧,700 万个相机图像 200 平方公里的驾驶区域,144 个驾驶小时 15k 个完全注释的场景,分为 5 个类别(汽车、公共汽车、卡车、行人、骑自行车的人) 多样化的环境(白天/夜晚、晴天/雨天、城市/郊区)。

● 下载地址:https://opendatalab.org.cn/ONCE

● 论文地址:https://arxiv.org/pdf/2106.1103

13.Cityscape

● 发布方:达姆施塔特工业大学 · 马克斯普朗克信息学研究所 ● 发布时间:2016

● 简介:Cityscapes是一个大型数据库,专注于对城市街道场景的语义理解。它为分为8个类别 (平面,人类,车辆,构造,对象,自然,天空和虚空) 的30个类提供语义,实例和密集的像素注释。数据集由大约5000个精细注释图像和20000个粗糙注释图像组成。在几个月,白天和良好的天气条件下,在50个城市中捕获了数据。它最初被记录为视频,因此手动选择帧以具有以下功能: 大量动态对象,不同的场景布局和不同的背景。

● 下载地址:https://opendatalab.org.cn/CityScapes

● 论文地址:https://arxiv.org/pdf/1604.0168

14.YouTube Driving Dataset

● 发布方:香港中文大学 · 加州大学 ● 发布时间:2022

● 简介:从YouTube上抓取第一视图驾驶视频。收集总长度超过120小时的134视频。这些视频涵盖了具有各种天气条件 (晴天,雨天,下雪等) 和区域 (农村和城市地区) 的不同驾驶场景。每一秒钟采样一个帧,得到130万帧的数据集。将YouTube驾驶数据集分为具有70% 数据的训练集和具有30% 数据的测试集,并在训练集上进行ACO的训练。

● 下载地址:https://opendatalab.org.cn/YouTube_Driving_Dataset

● 论文地址:https://arxiv.org/pdf/2204.02393.pdf

15. A2D2

● 发布方:奥迪

● 发布时间:2020

● 简介:我们已经发布了奥迪自动驾驶数据集 (A2D2),以支持从事自动驾驶的初创公司和学术研究人员。为车辆配备多模式传感器套件,记录大型数据集并对其进行标记是耗时且费力的。A2D2数据集消除了这种高进入壁垒,并使研究人员和开发人员可以专注于开发新技术。数据集具有2D语义分割,3D点云,3D边界框和车辆总线数据。

● 下载地址:https://opendatalab.org.cn/A2D2

● 论文地址:https://arxiv.org/pdf/2004.0632

16.Cam2BEV

● 发布方:亚琛工业大学

● 发布时间:2020

该数据集包含两个合成的、语义分割的道路场景图像子集,它们是为开发和应用论文“A Sim2Real Deep Learning Approach for the Transformation of Images from Multiple Vehicle-Mounted Cameras to a Semantically Segmented”中描述的方法而创建的。该数据集可以通过 Github 上描述的 Cam2BEV 方法的官方代码实现来使用。

数据集链接:Cam2BEV-OpenDataLab

17.SemanticKITTI

● 发布方:波恩大学

● 发布时间:2019

这是一个基于 KITTI Vision Benchmark 的大规模数据集,并使用了里程计任务提供的所有序列。我们为序列 00-10 的每个单独扫描提供密集注释,这使得能够使用多个顺序扫描进行语义场景解释,如语义分割和语义场景补全。剩余的序列,即序列 11-21,被用作测试集,显示大量具有挑战性的交通情况和环境类型。未提供测试集的标签,我们使用评估服务对提交进行评分并提供测试集结果。

● 下载地址:https://opendatalab.org.cn/SemanticKITTI

● 论文地址:https://arxiv.org/pdf/1904.0141

18. OpenLane

● 发布方:上海人工智能实验室 · 上海交通大学 · 商汤科技研究所

● 发布时间:2022

OpenLane 是迄今为止第一个真实世界和规模最大的 3D 车道数据集。我们的数据集从公共感知数据集 Waymo Open Dataset 中收集有价值的内容,并为 1000 个路段提供车道和最近路径对象(CIPO)注释。简而言之,OpenLane 拥有 200K 帧和超过 880K 仔细注释的车道。我们公开发布了 OpenLane 数据集,以帮助研究界在 3D 感知和自动驾驶技术方面取得进步。

● 下载地址:https://opendatalab.org.cn/OpenLane

● 论文地址:https://arxiv.org/pdf/2203.11089.pdf

19. OpenLane-V2

● 发布方:上海人工智能实验室

● 发布时间:2023

全球首个自动驾驶道路结构感知和推理基准。数据集的首要任务是场景结构感知和推理,这需要模型能够识别周围环境中车道的可行驶状态。该数据集的任务不仅包括车道中心线和交通要素检测,还包括检测到的对象的拓扑关系识别。

● 下载地址:https://opendatalab.org.cn/OpenLane-V2

原文链接:https://mp.weixin.qq.com/s/rNc16TLtZFvvkw0BED8hiA