由于法律挑战、技术限制以及概念框架根本性转变的需要,生成式人工智能泡沫将在2024年破灭。

像ChatGPT这样的项目因其改变人类生活各个方面的潜力而闻名,但由于预期的破坏似乎难以捉摸,因此面临着审查。

随着技术行业寻求克服众多挑战,有必要进行重新调整,从过度炒作转向实际功效,确保以道德考虑为核心的生成式人工智能的可持续发展。

生成人工智能的承诺与现实之间的差异

虽然生成式人工智能(GenAI)合成大量数据并在科学、经济和社会服务领域带来突破的潜力受到吹捧,但观察到的结果却被商业过度炒作。

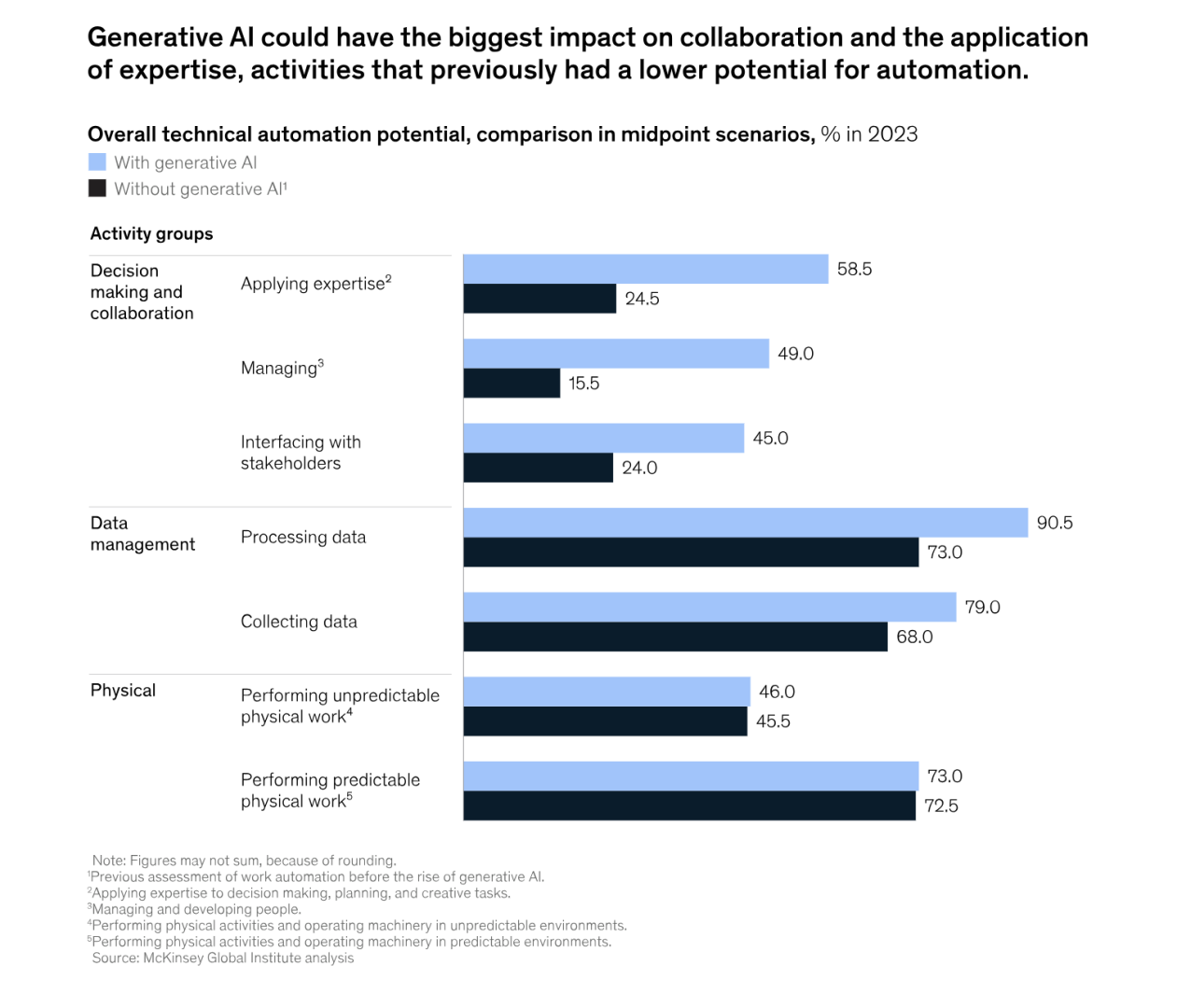

图片来源:McKinsey

深度造假、虚假信息和表面互动的盛行,引发了人们对生成式人工智能对这些领域的实际影响的质疑。

生成式人工智能需要范式转变

当我们展望2024年时,有一个令人信服的论点认为,GenAI的概念基础将发生范式转变。

模仿人类智能(包括身体、大脑、行为和商业)的概念假设存在缺陷,这阻碍了生成式人工智能的真正潜力。从模仿向理解和利用“世界知识”过渡的呼吁变得势在必行。

生成式人工智能依赖死记硬背和模式匹配,缺乏真正的智能、学习、类比或演绎,限制了其能力。

呼吁超越数学归纳和统计推断,对于真正的进步至关重要。

像ChatGPT这样的生成式人工智能系统,在未经许可的材料上进行训练,在寻找原始来源材料方面面临着严峻的挑战。潜在的诉讼,和解金额从数百万美元到数十亿美元不等,对GenAI的可持续性构成了威胁。

图片来源:Medium

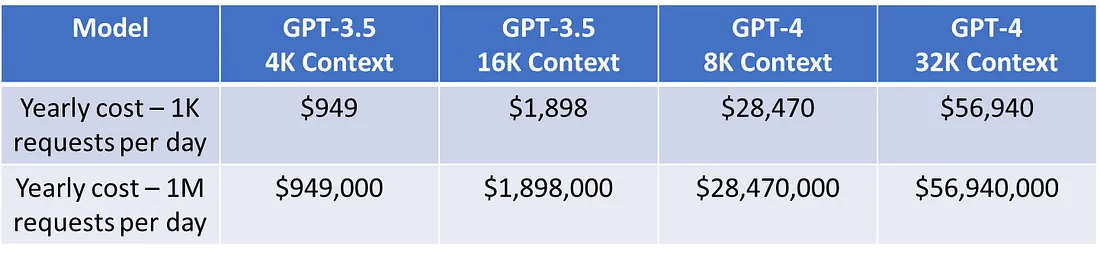

这种有缺陷的商业模式,再加上诉讼所涉及的法律费用,给(Microsoft或Google等大型技术企业造成了难以维持的局面。ChatGPT API的定价模式,尽管有预期的代币利润,但引发了对GenAI领域经济可行性的担忧。

从词嵌入到世界嵌入的转变引入了跨人工智能的概念,其中实体嵌入(EE)发挥着至关重要的作用。EE代表分类或序数变量,增强了人工智能与世界有效交互的能力,超越了以代币为中心的表示。

世界嵌入使AI/ML/LLM模型能够更有效地与世界交互,了解标记之间的语义和句法关系。世界知识的整合,对于生成可理解的内容很有帮助。

生成式人工智能并不完美

GenAI的承诺面临着现实的考验,促使人们重新评估其基本概念和业务战略。当我们进入2024年时,对世界嵌入的范式转变和对世界复杂性的更深入理解的呼吁,成为生成式人工智能可持续发展的关键一步。从过度宣传到实际效果的过程需要重新调整,包括真正的创新和道德考虑。

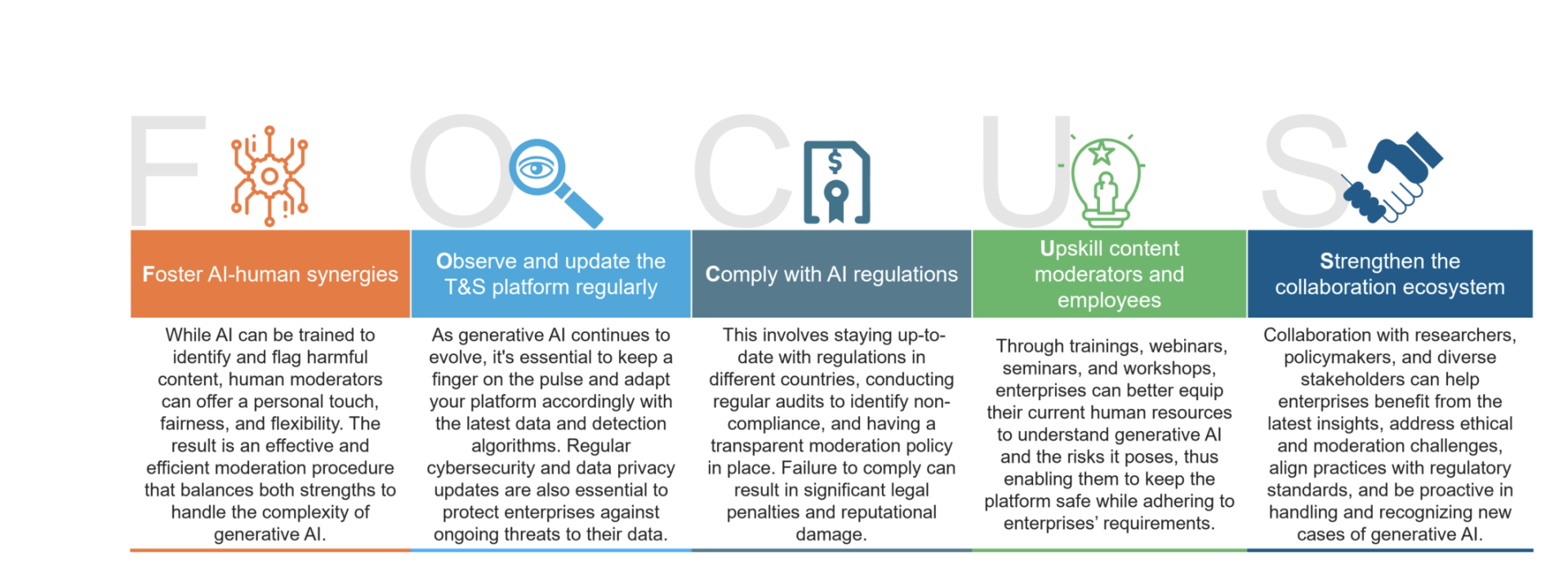

图片来源:Everest Group

虽然生成式人工智能取得了显著的进步,但重要的是要承认其并不完美。尽管其功能强大,但该技术仍存在固有的局限性和挑战。需要考虑的一些关键方面包括:

1、偏见和公平问题

生成式人工智能模型可能会无意中延续其训练数据中存在的偏见。如果训练数据反映了社会偏见,人工智能可能会产生有偏见或不公平的结果,引发道德担忧。

2、缺乏常识

生成式人工智能可能会与常识推理发生冲突,导致输出缺乏上下文或连贯性。这种限制可能会影响该技术在复杂的现实场景中的实际适用性。

3、情境理解薄弱

理解情境仍然是生成式人工智能的一个挑战。该技术可能会生成情境不合适的内容或误解细微的信息,从而影响其输出的准确性。

4、道德问题

生成式人工智能的道德使用带来了挑战,特别是在该技术可被利用来创建深度伪造或误导性内容的情况下。在创新和负责任的使用之间取得平衡是一个持续关注的问题。

5、对训练数据的依赖

训练数据的质量和代表性显著影响生成式人工智能的性能。训练数据不充分或有偏差可能会导致结果不理想,并限制模型在不同场景中泛化的能力。

6、缺乏可解释性

许多生成式人工智能模型都以黑匣子的方式运行,因此很难理解其输出背后的基本原理。可解释性问题阻碍了透明度,并可能在某些监管或安全关键领域带来挑战。

7、对抗性攻击的脆弱性

生成式人工智能模型可能容易受到对抗性攻击,其中恶意输入旨在误导模型。防范此类攻击需要不断研究和开发安全措施。

8、训练数据过度拟合

生成式人工智能模型可能会过度拟合训练数据中的特定模式,从而限制其适应新的或未见过的场景的能力。这种过度拟合可能会导致输出非常模仿训练数据,但可能缺乏泛化性。

认识到这些缺陷对于负责任地部署和管理生成式人工智能技术至关重要。持续的研究和开发工作,对于应对这些挑战并增强生成式人工智能在各种应用中的稳健性、公平性和道德使用至关重要。