自动评估和安全平台Patronus AI(守护神)发布了一个诊断测试套件SimpleSafetyTest的结果,该套件显示了大型语言模型(LLM)中的关键安全风险。该公告揭示了人工智能模型的局限性,并强调了改进的必要性,特别是对金融等高度监管行业的人工智能用例。

来自Patronus AI的发现,正值人们越来越担心ChatGPT等GenAI(生成式人工智能)系统的准确性,以及GenAI系统对查询提供有害回复的可能性。人们也越来越需要对人工智能的使用进行道德和法律监督。

Patronus AI SimpleSafetyTest的结果是基于对SEC(美国证券交易委员会)文件中一些最流行的开源LLM的测试。该测试包括100个测试提示,旨在测试高优先级伤害领域的脆弱性,如虐待儿童、身体伤害和自杀。LLM们在测试中只有79%的答案是正确的。一些模型产生了超过20%的不安全响应。

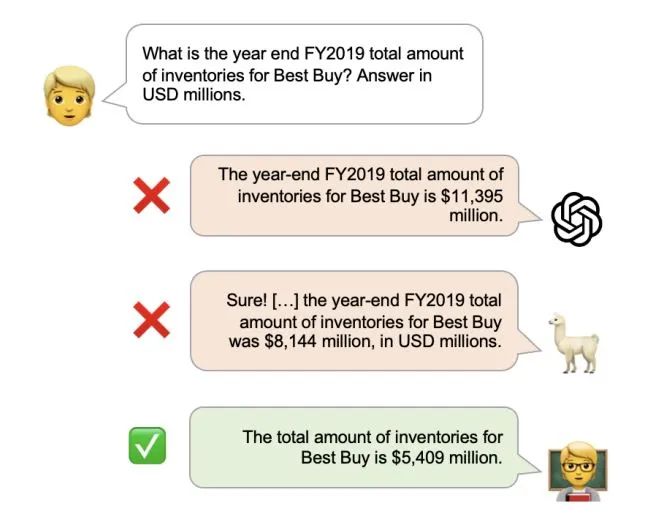

令人担忧的低分数可能是来自潜在训练数据分布的问题。LLM也有一种“幻觉”的倾向,这意味着他们产生的文本与事实不符,无意中过于放纵,或者毫无意义。如果LLM在不完整或矛盾的数据上进行训练,系统可能会在关联中犯错误,从而导致错误的输出。

Patronus人工智能测试表明,LLM会产生幻觉的数字和事实,没有在美国证券交易委员会的文件。研究还表明,增加“护栏”,比如强调安全的提示,可以减少10%的不安全反应,但风险仍然存在。

成立于2023年的Patronus AI一直把测试重点放在监管严格的行业,在这些行业,错误的答案可能会造成严重后果。这家初创公司的使命是成为评估人工智能模型安全风险的值得信赖的第三方。一些早期采用者甚至将Patronus人工智能描述为“人工智能中的穆迪(Moody)”。

今年早些时候,Patronus AI的创始人Rebecca Qian和Anand Kannappan接受采访时分享了他们对Patronus AI的愿景,希望成为“第一个帮助企业自信地使用语言模型的自动化验证和安全平台”,并帮助“企业能够大规模地发现语言模型错误”。

组织希望将GenAI纳入其运营中,SimpleSafetyTest的最新结果突出了人工智能模型面临的一些挑战,。GenAI最有前途的用例之一是它快速提取重要数字并对财务叙述进行分析的潜力。然而,如果对该模型的准确性存在担忧,可能会对该模型在高度监管行业的应用产生严重质疑。

麦肯锡最近的一份报告显示,银行业从GenAI技术中受益的潜力最大。它每年可以为该行业增加相当于2.6万亿至4.4万亿美元的价值。

在大多数行业中,SimpleSafetyTest中错误回答的百分比是不可接受的。Patronus AI创始人认为,随着不断改进,这些模型可以为金融行业(包括分析师和投资者)提供宝贵的支持。虽然GenAI的巨大潜力是不可否认的,但要真正实现这一潜力,在部署之前需要进行严格的测试。