最近,梦工厂创始人Jeffrey Katzenberg预测,生成式AI将使动画电影的成本在未来3年内降低90%,因为该技术将给媒体和娱乐行业带来彻底地颠覆。

「如果从历史的角度来看,钢笔、画笔、印刷机、静态相机、电影摄影机;这些东西以非凡的方式扩展了创造力和讲述故事的方式,人类已经见证过这种发展轨迹。」

他表示,「我不知道还有哪个行业会比媒体、娱乐和创作受到生成式AI影响更大。」

「我认为,一方面,它将具有颠覆性,并将当今艺术家和讲故事的人难以接触到的东西商品化。」

「在我制作动画电影的美好时光里,500 名艺术家花了五年时间才制作出一部世界级的动画电影。我认为未来3年,这个成本将缩减到10%」

「在我看来,未来个人的创造力将决定一切」。

而AI视频领域,也确实入他所说,技术在一日如十年地突飞猛进。

Pika 1.0 ,用户几分钟就能做出迪士尼级别的动画短片

前几天火爆全网的Pika Labs发布正式版1.0。

官方做的第一个视频展现出的动画效果,豪不夸张地说,已经能达到迪士尼等动画电影公司的质感了。

怪不得梦工厂的创始人会有如此预言,也许就是Pika这样面向未来的动画工具,让他看到了行业(bei)革命的曙光。

视频中我们可以看出,虽然每个镜头的时间还不长,但是动画人物的一致性,画面质感,已经和大型动画公司制作出来的动画没有太大的区别了。

而自从Pika 1.0开放了邀请体验以后,网上越来越多的案例被放了出来。看完这些用Pika 1.0做的动画之后,似乎都觉得这个3年90%的预测稍微保守了一些。

这个机器人过圣诞节的动画,除了镜头切换的稍显频繁之外,几乎很难挑出哪里有明显的毛病。

机器人来回的几个镜头一致性很高,完全没有了AI动画之前那种换一个镜头之后主角就会完全变样的硬伤。

机器人没有一句台词,但是依然向观众传达了一个简单的情节。在此基础之上发展出一个好故事,一个AI动画短片就完成了。

而这个动画,按照作者的说法是为了庆祝Pika1.0的上线。

虽然动画中只有一个简单的黑夜场景,但是礼花效果的一致性很好,城市中黑夜的光影也很多样,效果绚丽。

而且不同的镜头错落有致,氛围渲染的非常到位。

而这一个段的动画,看得出脸部效果畸变的问题也几乎被Pika解决了。

虽然人物脸部动作不明显,但是也保持了非常好的一致性,大大改善了之前AI动画最大的短板。

而这一段动画,已经可以说是一段「AI小电影」了。

站在夕阳中的泰坦尼克号上的Jack,身边的Rose换成了一只憨态可掬的大熊猫,效果还居然一点都不违和。

这后边大大的「To Be Continued」,也暗示了未来AI动画行业的故事才刚刚开始。

也许当动画制作的门槛不断降低,每个有优美故事的创作者,就能够完全地释放自己的创造力,制作出足够精良的视频来呈现精彩的故事。

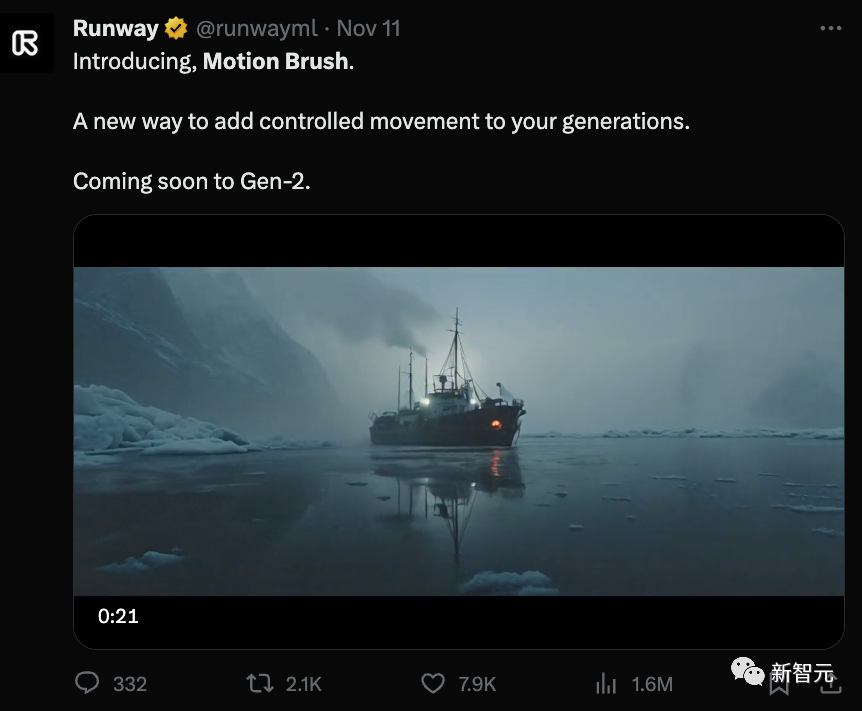

Gen-2推出动态画笔,赋予用户更大的控制能力

Gen-2推出「动态画笔」,让用户能够自由地决定视频中的动态效果。一条推特短短几天时间阅读超过160万。

就像传说中的「神笔马良一样」,用户只要鼠标一拖,就能让静态的图片按照自己的意愿动起来。

不论是背景的运动,还是图片中的具体景物,人物,都能生成自然的运动效果。

无论是画面中的汽车,烟雾,瀑布,火焰,人物,都能自然运动。

湖面,船舶,人像,鱼缸中的金鱼,都能地开始运动。

可以想象,在赋予用户如此之强的动态效果控制能力之后,制作动画和视频的成本将会大大降低。

也许未来,每个普通人就能像写字一样,用几张图片,几个小时,就能动态生成一段自己创作的视频。

5秒就能生成3D素材

动画内容制作另一个领域——3D建模,也在AI技术的推动下不断推陈出新。

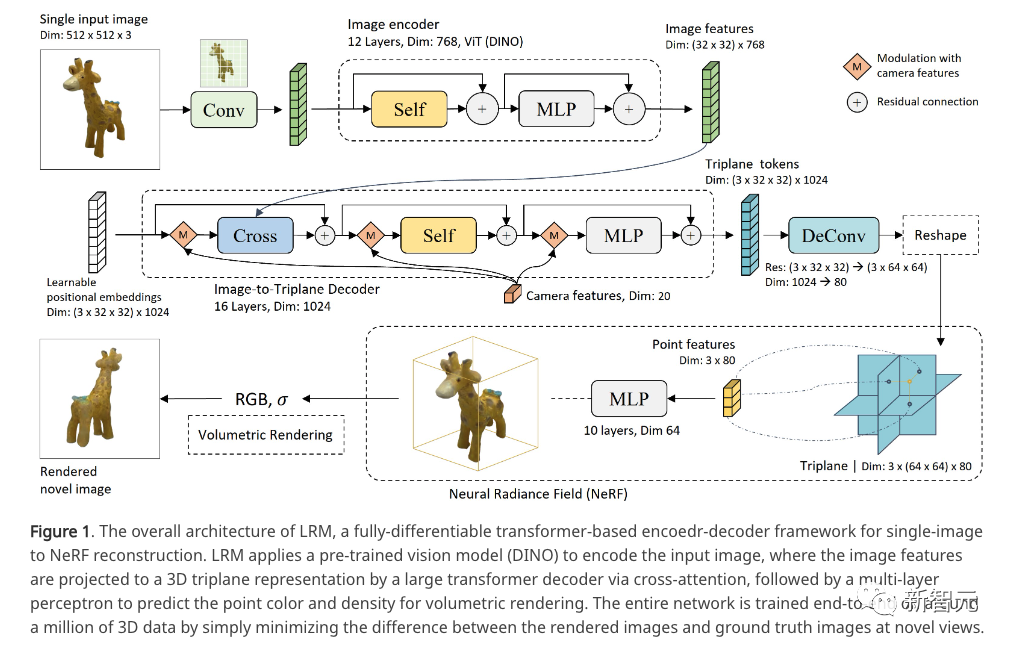

最近由Adobe和澳大利亚国立大学研究员发表的一篇论文,提出了一个用2D图像直接生成3D素材的技术,彻底震撼了业界。

项目地址:https://yiconghong.me/LRM/

作者称,只需要5秒钟,他们的模型就能将给定的一幅2D图像转化为3D素材。

除了普通的3D素材之外,可互动的3D素材也可以用模型生成。

这个基于Transformer构架的3D模型,具有5亿个参数,在短短5秒内就能从一个输入的图像预测出他的3D模型,而且可以直接从数据集预测神经辐射场(NeRF)。

研究人员在包含大约 100 万个对象的海量多视图数据上以端到端的方式训练模型,其中包括来自Objaverse的合成渲染和来自MVImgNet的真实捕获。

高容量模型和大规模训练数据的结合使模型具有高度通用性。

相信,伴随着3D建模技术的不断发展,也许他们的Pika 1.0时刻也不远了。

到时候,就像社交媒体出现之后,自媒体和信息传播的方式会产生很大变化一样,当AI动画将动画制作的门槛大大降低之后,我们将会进入一个视频媒体大爆炸的时代。