Hello folks,我是 Luga,今天我们继续来聊一下人工智能(AI)生态领域相关的技术 - GenerativeAI Library(生成式 AI 库) ,本文将继续聚焦在针对 Gen AI Library 的技术进行解析,使得大家能够了解 Gen AI Library 基本概念以及常用的 Gen AI 库以便大家能够更好地对其进行应用及市场开发。

在不断发展的技术领域中,人工智能(AI)已经成为一股革命性的力量。从最初的基本算法起步,到现代机器学习模型的复杂性,人工智能的进化之路令人瞩目。如今,随着生成式人工智能库的出现,一个引人入胜的篇章正在展开。那么,Gen AI 库究竟是什么呢?

一、什么是 Generative AI Libraries ?

Gen AI (生成式人工智能)库是旨在支持、促进和加速生成模型的研究、开发和应用的软件工具集合。这些库提供了广泛的功能和算法,使开发者能够构建、训练和部署各种创造性任务的生成模型,如图像生成、语音合成、文本生成等。

生成模型是一类机器学习模型,通过学习现有数据的分布特征,具备生成新数据样本的能力。生成模型的目标是模拟和重现真实数据的特征和分布,以产生具有真实性和多样性的生成数据。生成式人工智能库提供了多种生成模型的实现,其中包括生成对抗网络(GANs)、变分自编码器(VAEs)、自回归模型(如语言模型)等。

通过 Gen AI 库,开发者可以利用强大的生成模型来实现创造性任务,创作出新颖、多样且具有真实性的数据。这些库推动了生成模型在各个领域的应用和创新,为开发者提供了强大的工具和资源来探索生成人工智能的潜力。

二、常用的 Generative AI Libraries 解析

No 1: PandasAI

PandasAI 是一个基于流行的 Pandas 库的高级扩展库,旨在为数据操作、分析和驱动人工智能任务提供强大的功能。借助 PandasAI,我们可以高效地处理大型数据集、执行复杂操作,并无缝地利用 AI 技术。

作为一款由 GenAI 驱动的革命性数据分析库,PandasAI 通过重新定义 GenAI 专业人员的日常任务流程,实现了数据分析和操作范式的转变。同时,由于构建在广泛应用的 Pandas 库之上, PandasAI 无缝集成了生成式 AI 模型,从而提升了工作效率。通过引入 GenAI 的功能,PandasAI 在数据框架中引入了对话元素,以提升传统 Pandas 任务,包括数据预处理和数据可视化。

在实际的业务场景中,借助 PandasAI,用户可以更高效地处理和操作数据。通过与生成式 AI 模型的集成,PandasAI 能够自动进行数据预处理、特征工程和模型选择等任务,减轻了用户的工作负担,并提高了数据分析的准确性和效率。

此外,PandasAI 还引入了对话元素,使用户能够以一种更直观和交互的方式与数据进行交互。用户可以通过对话方式进行数据查询、变换和可视化,从而更加灵活地探索和分析数据。

因此,从多维度解析,PandasAI 不仅限于传统的数据操作和分析,同时,还提供了丰富的机器学习和深度学习功能。用户可以在数据处理的同时,直接应用生成式 AI 模型进行分类、回归和聚类等任务,从而实现更全面的数据分析和预测。

那么,作为一款基于 Pandas 的数据分析和机器学习库,旨在为数据科学家和分析师提供更强大的工具和功能。那么,通过扩展 Pandas 的功能的 PandasAI ,提供了核心增强功能呢?具体可参考如下:

1、特征工程

PandasAI 提供了广泛的特征工程技术,例如独热编码、分箱、特征缩放和生成新特征等。这些技术能够帮助数据科学家从数据中提取更多的信息,提高机器学习模型的性能。

2、AI驱动的操作

PandasAI 与流行的 AI库(如 scikit-learn 和 TensorFlow)进行了集成,实现了机器学习和深度学习算法与 Pandas 数据框架的无缝集成。这使得数据科学家可以更轻松地使用Pandas进行机器学习和深度学习。

3、探索性数据分析(EDA)

PandasAI 提供了各种统计和可视化工具,包括描述性统计、相关性分析和交互式可视化等。这些工具能够帮助数据科学家更好地理解数据,发现数据中的模式和趋势。

4、时间序列分析

PandasAI 包含强大的工具,用于处理时间序列数据,如重采样、滞后计算、滚动计算和基于日期的操作等。这些工具可帮助数据科学家分析时间序列数据,预测未来趋势。

通过提供的丰富的功能和集成的 AI 库,PandasAI 使得数据科学家能够在熟悉的 Pandas 环境中进行全面的数据分析和建模。无论是进行特征工程、探索性数据分析还是时间序列分析,PandasAI 都为用户提供了强大而灵活的工具,帮助他们从数据中获得更深入的洞察和更准确的预测。

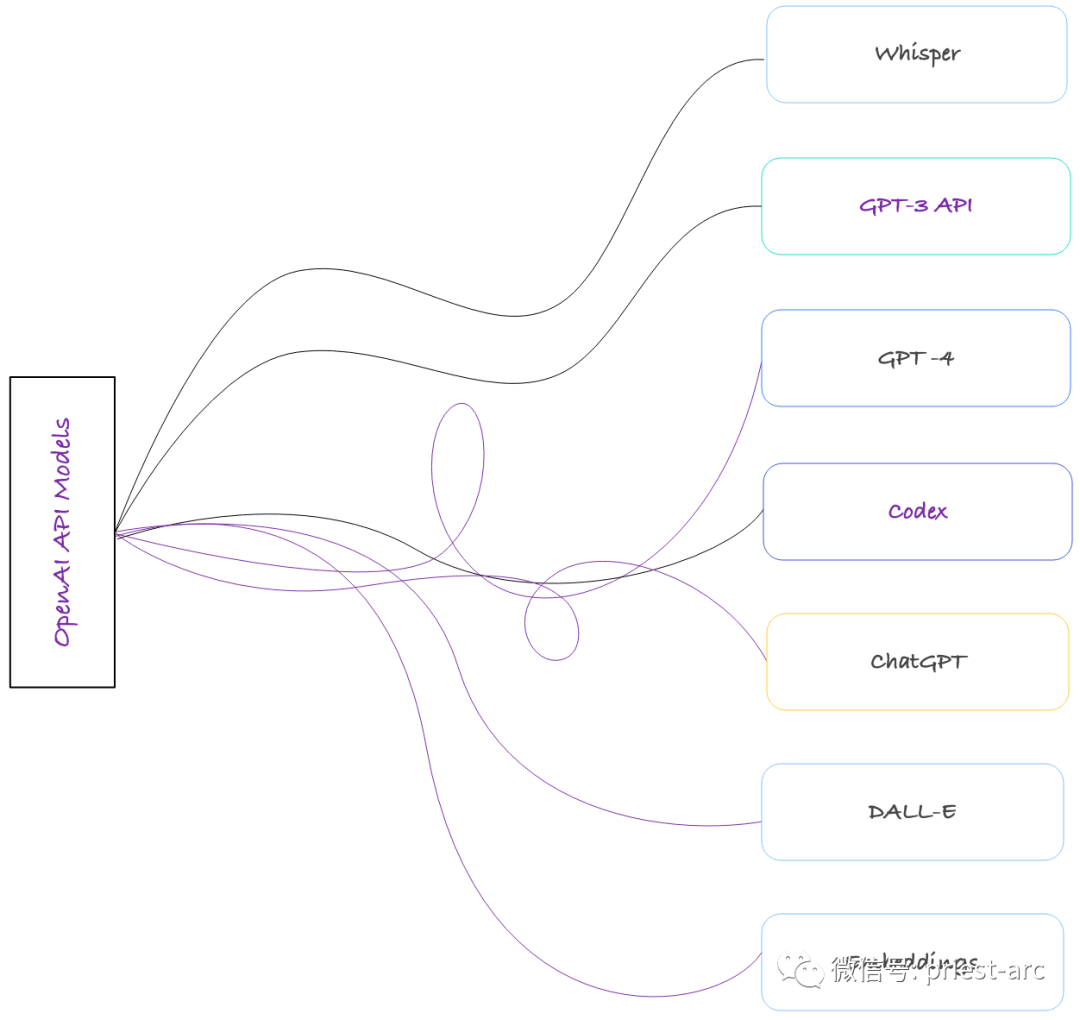

No 2: OpenAI

OpenAI 的 AP I是一项强大而灵活的工具,为用户提供了广泛的功能和应用。它能够处理各种文本输入,并生成高质量的文本输出。这种功能对于研究人员、开发人员和创作者来说具有巨大的潜力。无论是进行自然语言处理任务、生成创意文本、提供智能助理功能还是进行其他英语语言相关工作,OpenAI 的 API 都可以成为必备工具。

通过使用 OpenAI 的 API,专业人士可以更加高效地完成各种任务。他们可以利用API的强大功能,加速实验和开发过程,以及探索新的创新领域。无论是进行迭代实验、构建智能应用还是进行研究探索,OpenAI 的 API 都能提供一个广阔的游乐场,帮助专业人士发挥他们的创造力和想象力。

OpenAI 库是 OpenAI 公司开发的开源人工智能库,它提供了丰富的功能和工具,可以帮助开发人员快速开发机器学习应用程序。OpenAI 库的优势是多方面的,包括但不限于以下几点:

1、功能丰富

OpenAI 库提供了广泛的功能,涵盖了图像识别、自然语言处理、机器学习等多个领域。无论我们是需要进行图像分类、文本生成还是情感分析,OpenAI 库都能满足我们所设想的不同的需求。

2、易于使用

OpenAI 库提供了清晰而详尽的 API 文档和示例代码,使得开发人员能够迅速上手并快速集成库到自己的项目中。无论我们是新手还是经验丰富的开发人员,都能够轻松地利用 OpenAI 库实现自己的想法和解决方案。

3、强大的性能

OpenAI 库经过精心设计和优化,具备出色的性能和效率。无论是处理大规模数据集还是进行复杂的计算,OpenAI 库都能够提供快速而可靠的结果。

4、活跃的社区支持

OpenAI 库拥有一个活跃的社区,开发人员可以在社区中交流、分享经验、寻求帮助和支持。这个社区不仅提供了有价值的技术资源,还能够促进合作和创新,使得开发人员能够更好地利用 OpenAI 库开展工作。

5、持续的更新和改进

OpenAI 团队致力于不断改进和更新库的功能和性能。他们积极倾听用户反馈,并不断推出新的版本和功能,以满足不断变化的需求和技术发展。

No 3: PyTorch

PyTorch 是 Facebook AI 研究院开源的深度学习框架,为 GPU 和 CPU 提供了优化的张量计算能力,广泛应用于神经网络模型的训练和推理。相比 Tensorflow 和 Keras 等框架,PyTorch 在学术圈和工业界获得了更高的认可和采用度。

PyTorch 不仅提供了丰富的层、模型以及优化器来帮助开发者快速搭建和训练深度学习模型,更重要的是其在 GPU 上的高效张量操作,能够有效地加速模型训练的过程。这为研究人员提供了一个高性能的研究平台。

除了模型训练,PyTorch 在模型部署阶段也显示出了很好的兼容性。它可以轻松地将预训练模型下载并移植到不同的硬件环境中,如移动设备或边缘计算设备上,完成模型的实际应用。更重要的是,PyTorch 与 Google Cloud 等大型云平台深度集成,可以部署深度生成模型到 Vertex AI 等服务上。这极大简化了从研究到产品化的整个流程。

对深度学习从业者来说,PyTorch 不仅是一个优秀的研究工具,在他们研发智能应用和服务的整个周期中,都可以发挥重要作用。它为开发者提供了高效而友好的开发环境,让人工智能技术的应用寸步不离。随着 PyTorch 不断丰富的生态,我们预计它将继续积极影响和推动人工智能领域的发展。

与其他 GenAI 库相比较而言,PyTorch 具有如下核心优势,具体可参考:

1、开放和易用性

PyTorch 是完全开源的,任何人都可以自由使用、修改和分发。更重要的是,它是基于 Python 这样一门流行而成熟的语言开发的,这使得 PyTorch 极为易上手。Python 生态丰富,开发人员可以利用 Python 广泛的工具库和社区资源,大幅降低使用 PyTorch 的学习成本。

2、高性能计算

PyTorch 利用 GPU 加速张量和神经网络操作,能够在几秒或几分钟内完成训练模型需要天甚至月计算的工作。这超乎想象的计算性能,为研究人员提供了一个高效的实验平台。同时,PyTorch 也针对 CPU 优化,可在资源有限的设备上运行。

3、模型构建与调试灵活

PyTorch 提供了丰富的层、模型、损失函数以及优化器等 API,可以满足各种深度学习架构和工作流的需求。它的动态计算图模式也极大便利了模型构建与调试的过程。用户可以随时修改代码并实时看到效果,这大大提高了研发效率。

4、部署广泛

PyTorch 训练出的模型支持部署到 CPU/GPU、手机、嵌入式设备等各种硬件平台。开发人员可以基于 PyTorch 将模型应用到实际生产环境中去,真正实现从研发到部署的闭环。

No 4: TensorFlow

TensorFlow 是一个端到端的开源机器学习平台,专注于深度学习领域。深度学习是一种机器学习方法,适用于处理大规模、复杂的非结构化数据。相较于传统机器学习方法,深度学习通过构建多层神经网络来学习数据的高阶表征,其应用范围广泛而多样化。

TensorFlow 提供了丰富且成熟的深度学习库和工具集,帮助开发者轻松创建和部署复杂的深度学习模型。它采用 Python 接口来定义计算流图,而底层则由高性能的 C++ 实现,充分利用 GPU 来加速计算。这使得 TensorFlow 在模型训练速度上具有明显的优势。

除了强大的库支持之外,TensorFlow 社区也非常活跃,提供了大量的预训练模型和应用示例代码,极大地降低了深度学习的学习成本。同时,TensorFlow 与各种生产环境的集成也非常出色,可以轻松地将模型部署到服务器、手机等硬件平台上。

最初,TensorFlow 是 Google Brain 项目内部使用的深度学习框架。随着其开源化,TensorFlow 在研究和实际产品中的应用日益广泛。它不断丰富其功能,为开发者提供了从研究到部署的完整生命周期支持,因此成为了当前主流的开源深度学习框架之一。

以下为 TensorFlow 所具有相关核心特性,具体:

1、全链路深度学习平台

TensorFlow 提供了从数据准备到模型训练和部署的完整深度学习生命周期支持。它包含了各种工具、库和 API,使开发者能够在一个统一的平台上完成整个深度学习项目。

2、强大的计算图

TensorFlow 使用计算图来表示复杂的数学运算和神经网络模型。通过定义计算图,开发者可以明确指定数据流和操作之间的依赖关系,从而实现高效的并行计算和自动微分。

3、跨平台上运行

TensorFlow 提供了对多种硬件平台的支持,包括 CPU、GPU 和 TPU(Tensor Processing Unit)。通过使用适当的硬件加速,可以大幅提升深度学习模型的训练和推理速度。

4、预训练模型和工具集丰富

TensorFlow 社区提供了丰富的预训练模型和工具集,可以帮助开发者快速构建和部署各种深度学习应用。这些模型和工具集涵盖了计算机视觉、自然语言处理、语音识别等领域,为开发者提供了丰富的选择和快速上手的机会。

5、分布式训练和推理

TensorFlow 支持分布式计算,可以在多个设备和计算节点上同时进行模型的训练和推理。这使得在大规模数据和复杂模型上进行高效的并行计算成为可能,加快了深度学习的训练和推理速度。

6、可视化工具和调试支持

TensorFlow 提供了可视化工具和调试支持,帮助开发者理解和调试复杂的深度学习模型。通过可视化工具,可以直观地查看计算图、参数变化和训练过程,从而更好地理解模型的行为和性能。

No 5: Hugging Face

Hugging Face Transformers 库是一个强大的工具,提供了超过 2 万个经过预训练的 Transformer 模型,覆盖 100 多种语言。这些模型包括了各种最先进的自然语言处理(NLP)任务的最佳模型,使得开发人员可以方便地使用这些模型进行文本分类、问答、生成、翻译等各种任务。

基于社区所贡献的预训练模型, Hugging Face 涵盖了广泛的 NLP 任务和语言环境,从而极大地降低了使用深度学习技术研究语言的门槛。研究人员和技术应用者可以专注于研究和应用,而无需从头开始训练模型。

除此之外,为了满足不同框架下的需求,Hugging Face Transformers 也提供了出色的多框架支持能力。它能够兼容于多个深度学习框架,如 PyTorch、TensorFlow、JAX,以及部署框架如 ONNX 和 TensorRT。这种兼容性提供了强大的可移植性,使模型可以更方便地在不同的环境中进行复用。

同时,Hugging Face Transformers 库还开放了超过 2,000 个公开数据集的访问接口,这对于模型开发和自然语言处理实验来说是一个巨大的资源。此外,Hugging Face还建立了一个活跃的社区,鼓励知识共享和创新。

总而言之,Hugging Face Transformers 库为开发者提供了强大的工具和资源,使他们能够轻松地使用预训练的 Transformer 模型进行各种 NLP 任务。通过其多框架支持和丰富的数据集访问接口,开发者能够更加便捷地进行模型开发、实验和部署,并从活跃的社区中获得支持和启发。

Hugging Face Transformers 库具有以下核心特性,具体:

1、预训练的 Transformer 模型

Hugging Face Transformers 库提供了丰富的经过预训练的 Transformer 模型。这些模型在大规模语料库上进行了预训练,学习了丰富的语言表示和语义理解能力。这些预训练模型包括了最新的自然语言处理(NLP)任务的最佳模型,可用于文本分类、问答、生成、翻译等各种 NLP 任务。

2、模型微调

模型微调是 Hugging Face Transformers 库的一项重要功能。它允许开发者根据特定的任务和数据集对预训练模型进行微调,以提高模型在特定领域或任务上的性能。通过微调,可以将预训练模型的丰富语言能力迁移到具体应用场景中,使其更加适应特定领域的数据和任务需求。

基于 Hugging Face Transformers 库所提供的丰富工具和 API,使微调过程更加简便和高效。开发者可以使用库中提供的预定义任务模型,也可以根据自己的需要创建自定义模型。此外,库还提供了用于评估和比较不同微调模型性能的指标和工具。

3、多任务学习

Hugging Face Transformers 库提供了多任务学习的模型架构和工具,使开发者能够轻松地构建和训练多任务学习模型。开发者可以选择使用预定义的多任务模型,也可以根据自己的需求创建自定义的多任务学习模型。库中的多任务学习框架支持任务之间的柔性权重分配、任务特定的学习率和损失函数等,以满足不同任务之间的差异性和优化需求。

通过多任务学习,开发者可以更好地利用数据和模型的共享性,减少训练和推理的计算成本,并提高模型的整体性能和效率。无论是在语言理解、文本生成还是其他 NLP 任务中,多任务学习都是提升模型性能和效果的有力手段。