在开放、高动态和演化环境中的学习能力是生物智能的核心要素之一,也是人类以及大多数动物在「适者生存」的自然选择过程中形成的重要优势。目前传统机器学习范式是在静态和封闭的数据集上学习到一个模型,并假设其应用环境和之前训练数据的属性相同,因而无法适应动态开放环境的挑战。

针对该问题,持续学习模拟生物智能的学习过程和学习能力,发展新型的机器学习理论和方法,通过持续学习的过程,以期提升智能体对开放、高动态环境的适应能力。但是,目前主流的机器学习模型通过调整网络参数进行学习,当学习任务的数据分布发生变化时,先前学到的网络参数可能被覆盖,从而导致对先前知识的灾难性遗忘(catastrophic forgetting)。

作为人工智能尤其是深度学习发展的重要瓶颈,持续学习近年来在人工智能领域受到广泛关注。大多数持续学习方法都专注于提高对所学知识的记忆稳定性以克服灾难性遗忘,例如在学习新任务时固定执行旧任务的网络参数。然而这些方法通常只能在特定场景中发挥作用,难以像生物智能那样对现实世界的复杂环境和任务具有普遍的适应能力。

因此,能否借鉴生物脑的持续学习机理,发展新型的持续学习方法一直是人工智能领域普遍关注的问题。

针对该问题,近期清华大学计算机系朱军教授 TSAIL 课题组联合生命学院钟毅教授课题组在自然机器智能(Nature Machine Intelligence)期刊上发表了题为「融入神经启发适应性的人工智能方法」(Incorporating neuro-inspired adaptability for continual learning in artificial intelligence)的研究论文,并被选作12月的封面文章。

该研究利用贝叶斯方法深入分析并建模了生物学习记忆系统的适应性机制,显著提升了深度神经网络的持续学习能力,为智能系统在动态开放环境的自适应发展提供了跨学科的深刻见解。

论文链接:https://www.nature.com/articles/s42256-023-00747

引言

随着大规模标注数据的出现和硬件设备计算能力的增强,以深度学习为核心的人工智能在计算机视觉、自然语言处理、自动驾驶、智能机器人等领域取得了一系列突破性进展。然而,深度学习高度依赖于静态的数据分布,难以对动态变化的数据分布进行持续学习。

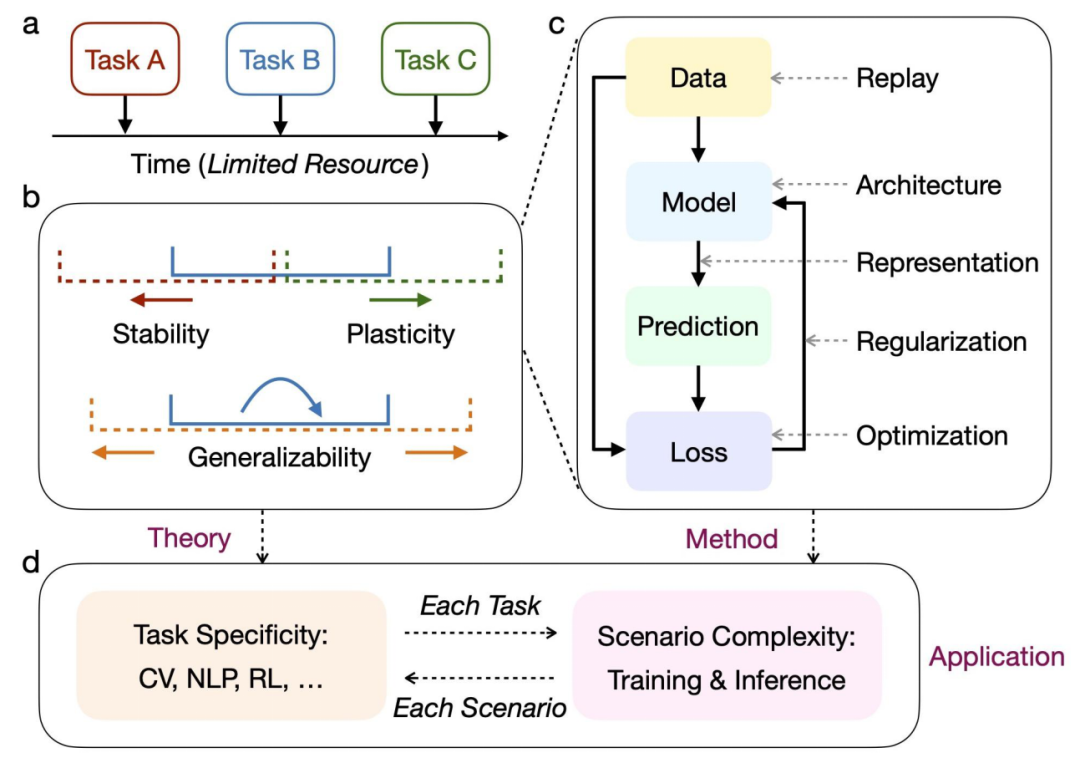

从理论层面来看,持续学习的优化目标可以被进一步细化为记忆稳定性、学习可塑性、泛化兼容性等核心要素。为了适应不断变化的环境和任务,智能系统需要在记忆旧知识和学习新知识之间取得适当的平衡,并具备充分的泛化能力以容纳数据分布之间的差异。

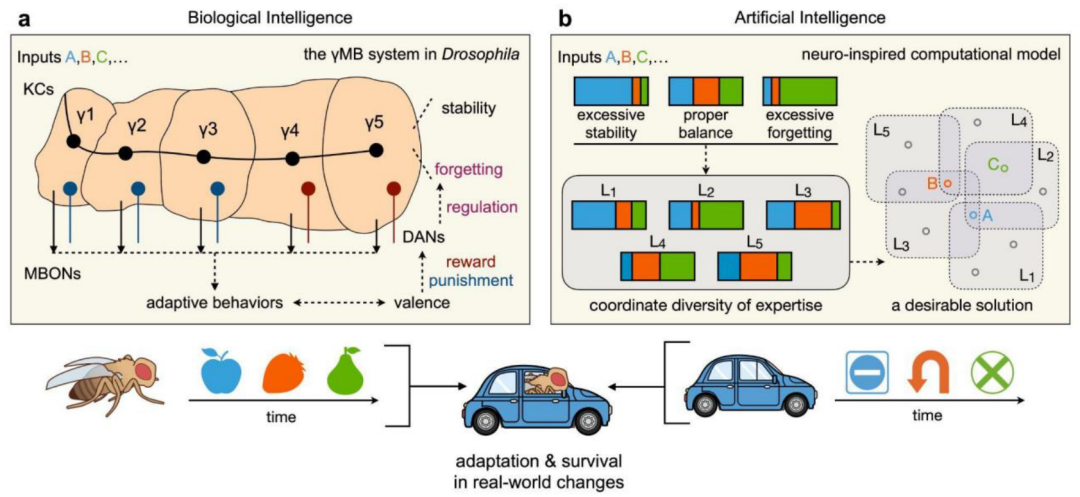

图 1. 生物智能启发的持续学习方法示意图 (来源:NMI 原文)

作为天然的模板,人类以及大多数动物天生就是以一种持续不断的方式进行学习的。即使是果蝇等简单的生命体,也进化出了多种适应性机制,以实现有效的持续学习。在果蝇的学习记忆系统中,动态变化的感觉信息可以在多个并行的持续学习模块中被有选择地保护和遗忘,为人工智能提供了重要的启示。

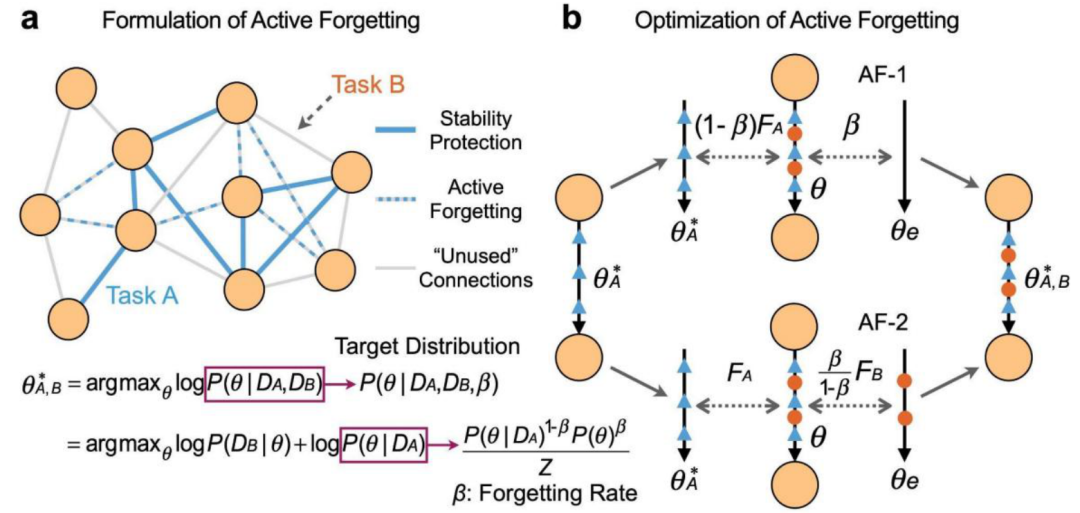

图 2. 记忆的选择性保护与遗忘机制 (来源:NMI 原文)

研究概览

在方法层面,研究人员提出了一种生物启发的记忆调控方法,对所学知识进行有选择地保护和遗忘。在学习新任务时,该方法通过优化参数分布中的旧任务信息来促进记忆稳定性,并引入一定程度的遗忘率以促进学习可塑性。研究人员进一步推导出一种突触扩张-再归一化的优化算法,使神经网络能够在新旧任务的最优解之间做出明确的权衡,并依此分析了遗忘率在降低持续学习的泛化误差方面的作用,从功能目标和实现机制两个层面与生物智能相呼应。

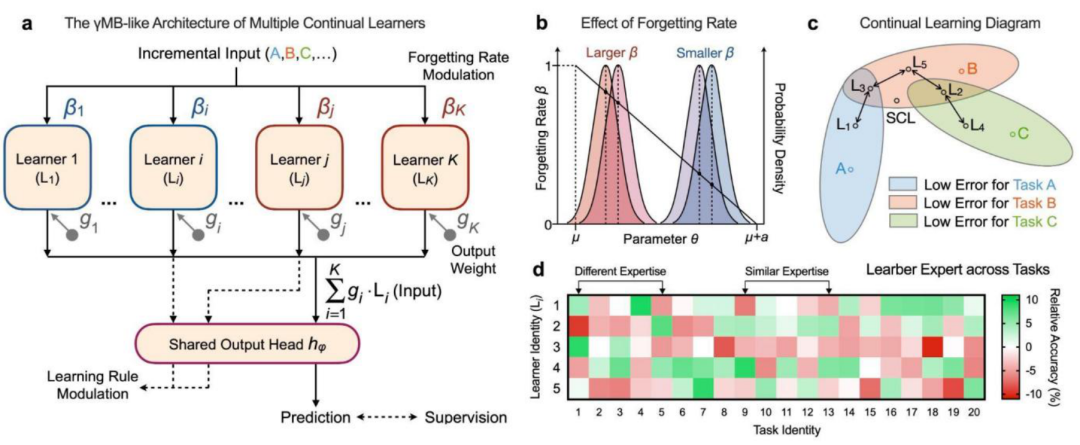

图 3. 动态调节的并行多模块结构 (来源:NMI 原文)

同时,研究人员构建了一种类似果蝇学习记忆系统的并行多模块结构,对应于多个持续学习专家。通过在每个模块中实施所提出的记忆调控机制,对记忆进行有选择地保护和遗忘,从而使各个模块都能分化出适当的任务专长,充分适应不同任务的数据分布差异。研究人员还深入探讨了神经网络的随机性因素与学习规则和遗忘率的相互作用,证明神经系统的适应性机制并非孤立运作,而是高度协同的。

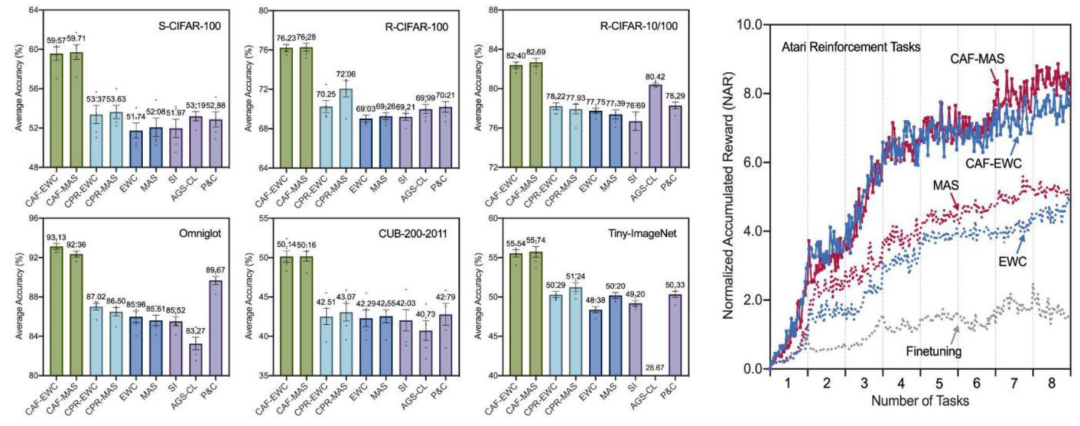

图 4. 多种持续学习基准的实验结果 (来源:NMI 原文)

在多种持续学习基准中,包括视觉任务和强化任务等,所提出的适应性机制能够显著提高深度神经网络的持续学习能力。此外,论文还从遗忘的生物学意义和实现机制等角度,深入探讨了智能系统在持续学习方面的联系,作为一种新的范式推动人工智能和生物智能的协同发展。

图 5. 持续学习的全面综述 (来源:团队的 arxiv 论文 https://arxiv.org/abs/2302.00487)

作者及课题组介绍

清华大学的朱军教授和钟毅教授为本论文的共同通讯作者,水木学者博士后王立元和张幸幸助理研究员为本论文的共同第一作者。清华大学的李乾助理研究员、苏航副研究员、以及伦敦大学学院的张鸣天博士是本论文的共同作者。

清华大学 TSAIL 课题组长期致力于贝叶斯机器学习的理论和算法研究。近年来,课题组结合机器学习与神经科学的前沿进展,在持续学习领域发表了一系列重要成果。在今年年初完成持续学习领域的综述论文「A comprehensive survey of continual learning: theory, method and application」,系统地梳理了持续学习的基本设置、理论基础、代表性方法和实际应用等方面的研究进展,并提出未来的发展方向,受到了国内外人工智能社区的广泛关注。

另外,针对持续学习领域的普遍技术难点,提出了生成模型的半监督持续学习 (CVPR’21)、具备选择性遗忘的权重正则化方法 (NeurIPS’21)、自适应数据压缩的记忆回放方法 (ICLR’22)、动态并行模块的持续学习架构 (ECCV’22) 等。

近期,关于预训练模型的持续学习理论与方法的研究论文「Hierarchical decomposition of prompt-based continual learning: rethinking obscured sub-optimality」被 NeurIPS’23 评为 spotlight,该论文通过对预训练背景下的持续学习优化目标进行层次化分解,提出了适用于各类微调技术(如 prompt、adapter、LoRA 等)的通用框架,显著提升了预训练模型在动态开放环境下的自适应性。