随着 NeurIPS 2023 获奖论文的公布,十年前的词嵌入技术 word2vec 可谓是实至名归的获得了时间检验奖。这篇论文「Distributed Representations of Words and Phrases and their Compositionality」由当时都还在谷歌的 Tomas Mikolov、Ilya Sutskever、Kai Chen、Greg Corrado、Jeffrey Dean 撰写。

不过,Word2vec 首篇论文是 Tomas Mikolov 等同一作者的「Efficient Estimation of Word Representations in Vector Space」。对比作者栏,只是增加了 Ilya。而投稿到当年 NeurIPS 的这篇「Distributed Representations of Words and Phrases and their Compositionality」算是真正让 Word2vec 被广泛应用的改进论文。

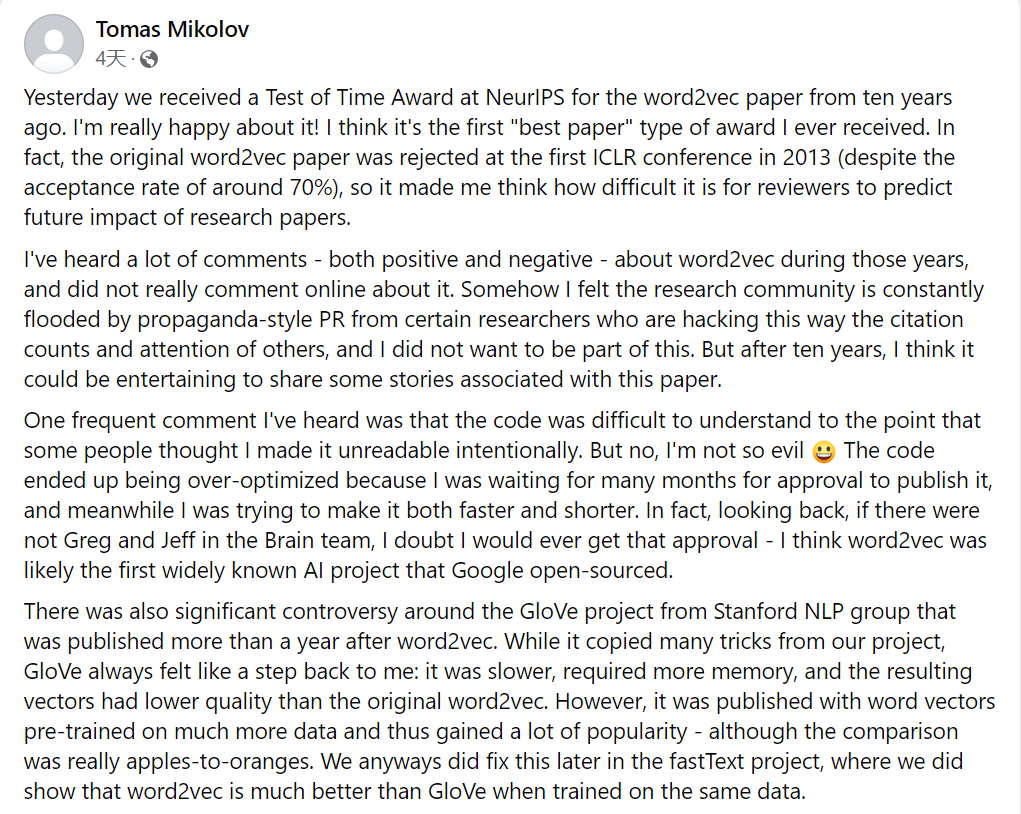

本该是件值得高兴的事,但论文一作 Tomas Mikolov 似乎对有些事情并不满意,最近他分享了论文背后的更多故事。感兴趣的读者可以参考《论文遭首届 ICLR 拒稿、代码被过度优化,word2vec 作者 Tomas Mikolov 分享背后的故事》。

原文地址:https://www.facebook.com/tomas.mikolov/posts/pfbid0avhBpB2WULd3KNtAieyiDCFpP9MQggxW1xSh6RXZDjWF6sGzgpYa638KMAyF75JSl

Tomas 在 Facebook 上发表的这篇获奖感言,爆料了很多内容,文章发出之后,得到了很多人的关注。

word2vec 原始论文曾被 ICLR 拒稿

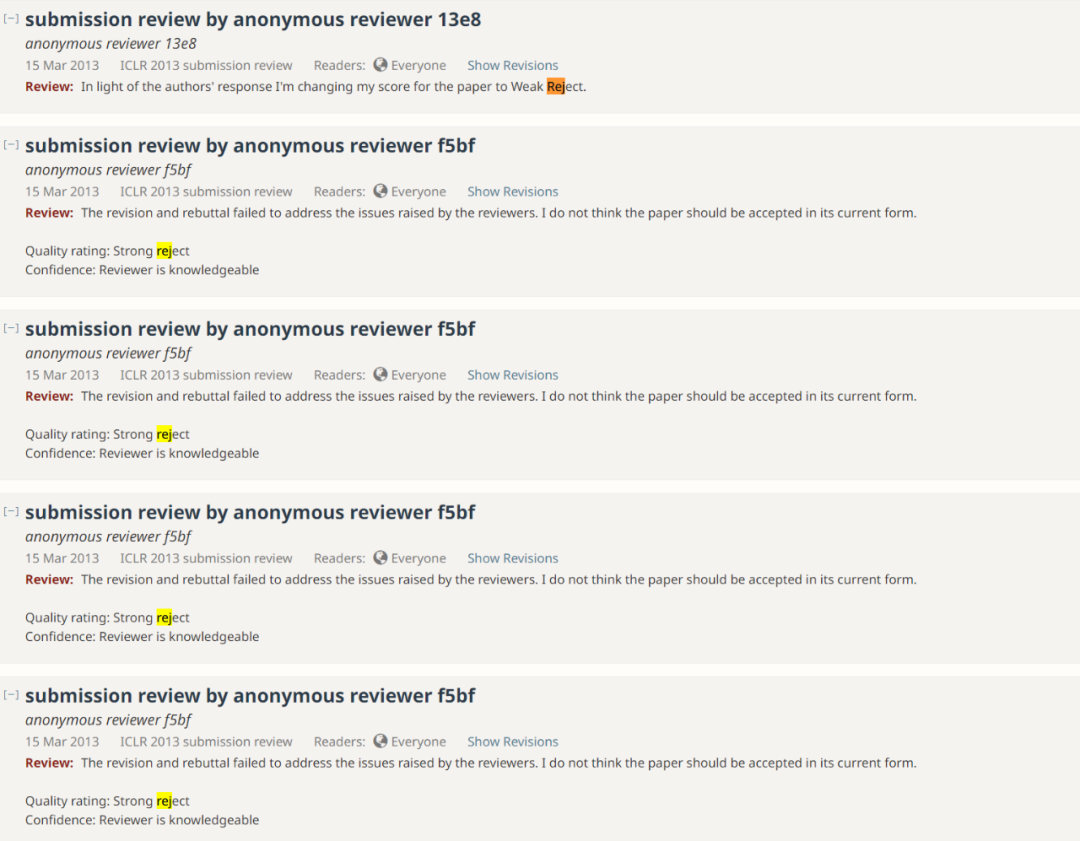

Tomas Mikolov 表示 word2vec 原始论文(即 Efficient Estimation of Word Representations in Vector Space)在 2013 年首届 ICLR 会议被拒绝接收了,尽管当时的接收率很高。在当年的评选中,审稿人给出了一次「弱拒绝」和四次「强烈拒绝」。

感兴趣的读者,可以前去查看:https://openreview.net/forum?id=idpCdOWtqXd60

这个问题很多人表示有同感,LoRA 作者 Weizhu Chen 表示,自己也有相似的经历,LoRA 论文在第一次投稿时也被拒绝了,因为审稿人认为 LoRA 太简单了。

「SIFT 在 1997 年 ICCV 和 1998 年 CVPR 两次被拒稿。」

除了 word2vec 原始论文被拒稿之外,Tomas Mikolov 还透漏了其他事情,我们接着往下看。

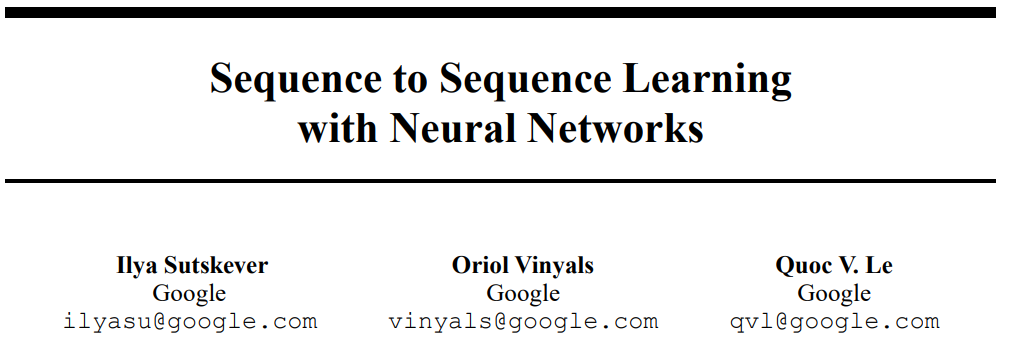

seq2seq 的最初想法到底是谁

Tomas Mikolov 表示他于 2012 年加入谷歌大脑团队,在谷歌大脑工作期间曾与 Quoc Le 和 Ilya Sutskever 讨论过一些想法,关于这个想法 Tomas Mikolov 是这么说的:「其实在加入谷歌之前,我就提出了一个非常简单的想法,通过在句子对(比如法语 - 英语)上训练神经语言模型来实现端到端的翻译,然后在看到第一句话后使用生成模式生成翻译。这对短句子效果很好,但在长句子上就不那么奏效了。」

他曾与谷歌的其他人包括 Quoc Le、Ilya Sutskever 在内多次讨论了这个项目。然而,事情开始出现转折,Tomas Mikolov 选择离开谷歌加入 Facebook AI,而这个项目也被其他人接手了。

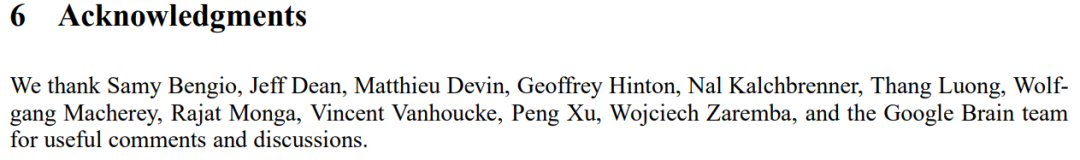

Tomas Mikolov 指出:「谷歌最终以从序列到序列(sequence to sequence)为名发表了我的想法,不仅没有提到我是共同作者,而且在长长的致谢部分提及了谷歌大脑中几乎所有的人,唯独没有我。那时是资金大量涌入人工智能领域的时期,每一个想法都价值连城。看到深度学习社区迅速变成某种权力的游戏,我感到很悲哀。」

论文地址(上)以及致谢名单(下):https://arxiv.org/pdf/1409.3215.pdf

在 Tomas Mikolov 看来,正是这些想法促进了从序列到序列(sequence to sequence,seq2seq)的研究,也就是说 seq2seq 的想法最初来自于 Tomas Mikolov。

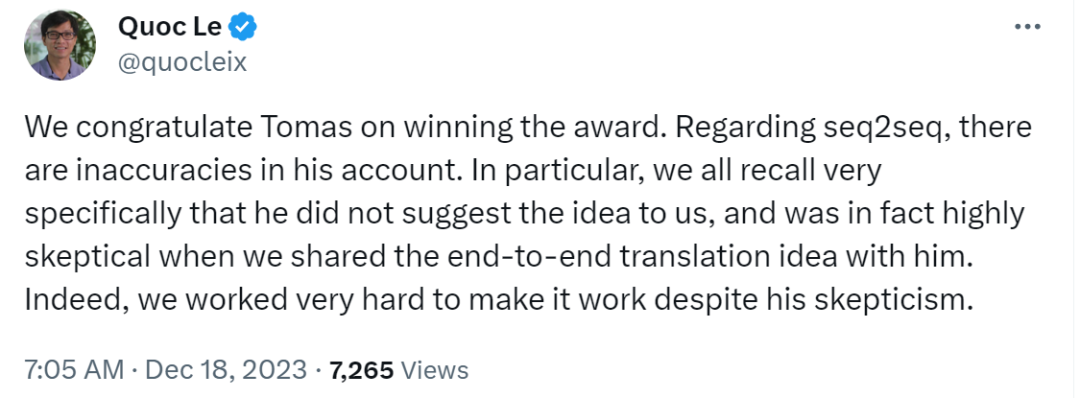

然而,作为 seq2seq 作者的 Quoc Le 并不认同 Tomas 的说法,Quoc Le 先是对 Tomas 参与的 word2vec 论文获奖表示祝贺。然后话锋一转,「关于 seq2seq,Tomas 的说法有不准确的地方。特别是,我们都记得非常清楚,他没有向我们提出这个想法,而且当我们与他分享端到端的翻译想法时,他实际上非常怀疑。事实上,尽管他持怀疑态度,我们还是非常努力地让这个想法发挥作用。」

图源:https://twitter.com/quocleix/status/1736523075943125029

GloVe 论文中引用了 Tomas 的研究 7 次

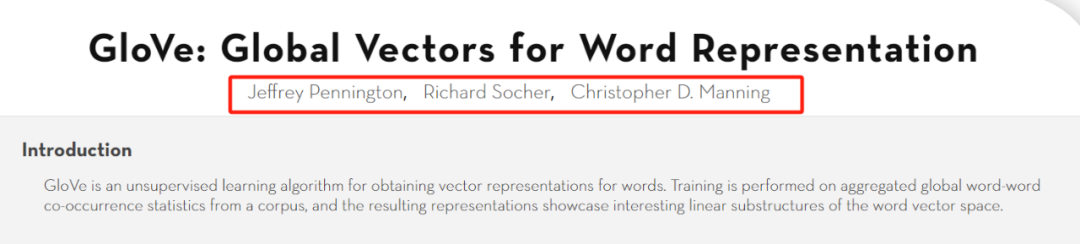

除了 seq2seq,Tomas 还提到了另一个项目,即斯坦福 NLP 小组的 GloVe 项目(全局词表示向量,被很多人认为优于 word2vec)。这项研究由 Jeffrey Pennington、Richard Socher、Christopher D. Manning 共同完成。

论文地址:https://aclanthology.org/D14-1162.pdf

Tomas 表示:「虽然该项目从我们的项目中复刻了很多技巧,但总感觉 GloVe 倒退了一步:速度较慢,还需要更多内存,生成的向量质量比 word2vec 低。然而,GloVe 是基于在更多数据上预训练的词向量发布的,因而很受欢迎。之后,我们在 fastText 项目中修复了相关问题,在使用相同数据进行训练时,word2vec 比 GloVe 好得多。」

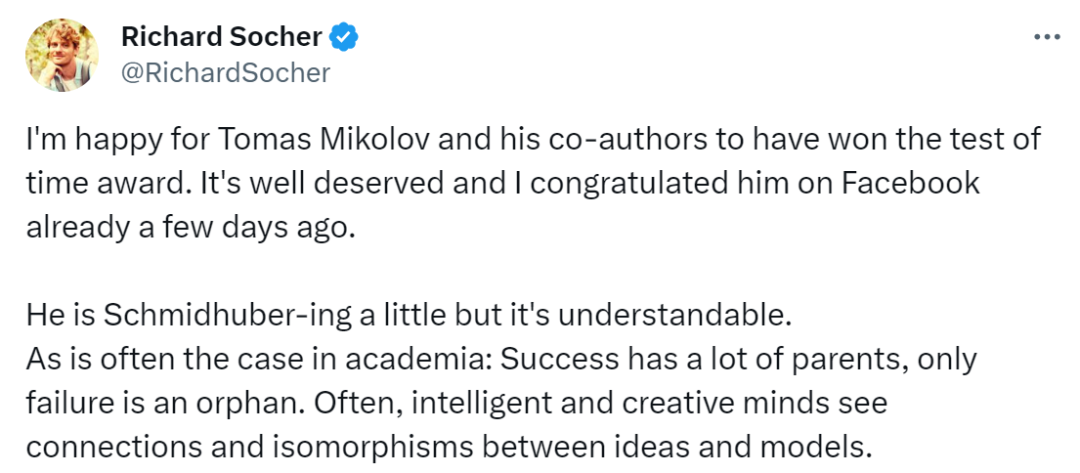

GloVe 的作者之一 Richard Socher 对此进行了反击(以下内容进行了部分概括)。

图源:https://twitter.com/RichardSocher/status/1736161332259614989

「我很高兴 Tomas Mikolov 和他的合著者赢得了时间检验奖。这是当之无愧的,几天前我已经在 Facebook 上向他表示祝贺了。

Tomas 的做法有点像 Schmidhuber(Schmidhuber 多次公开挑战其他研究人员原创性研究),这是可以理解的。学术界经常会出现这种情况:(一项研究)成功了,会有很多人认领,可以将其理解为『父母』,只有失败了才是『孤儿』(言外之意是没有人会在意)。

一个有意义的主题可以激发聪明的大脑和创造性的想象,这些人往往有相似的想法,许多想法都是不确定的。的确,很多想法在某些时候被提及,但没有大规模实施或执行。」

Richard Socher 继续说道,当 Mikolov 以一种有点不满的方式说我们抄袭了其研究的许多技巧时,我们有点不明白,因为我们实际上在 GloVe 论文中引用了他的研究 7 次。

确实,在这篇论文中,我们搜索关键词 Mikolov,除去参考文献出现的 3 次,论文中确实是 7 次。

最后,Richard 表示「早在 2010 年,只有少数人真正关注并致力于语言网络的研究:Ronan Collobert、Jason Weston、Tomas Mikolov、Yoshua Bengio、我自己、Chris Manning 和其他一些人。现在这个领域发展得如此之快,除非你继续做出令人惊叹的工作,否则很快就会被人们忘记。AI 以及深度 NLP 领域在过去的一年里发展很快,许多刚刚加入或注意到它的人都不知它从何而来。可以理解的是,这让一些已经从事了一段时间并奠定了基础的人感到不安。但是,我们应该对我们的想法以如此巨大的速度扩展感到兴奋。」

前面我们提到 Tomas 认为 GloVe 比 word2vec 倒退了一步,但是有人针对这一点也进行了反驳:「尽管 word2vec 是词嵌入的第一个介绍,但我发现 Glove 更直观且易于移植。你从任何语料库构建词嵌入的脚本都非常方便。我们在生产中仍然使用 Glove 与 SIF 一起作为轻量级第一过滤器。」

尽管 Tomas Mikolov 的文章引发的一系列讨论与争议还在继续,但不管事实如何,好在 word2vec 获得了 NeurIPS 2023 时间检验奖。

最后想问一句,2014 年发表到 NeurIPS 的 Seq2Seq 会获得明年的 NeurIPS 时间检验奖吗?