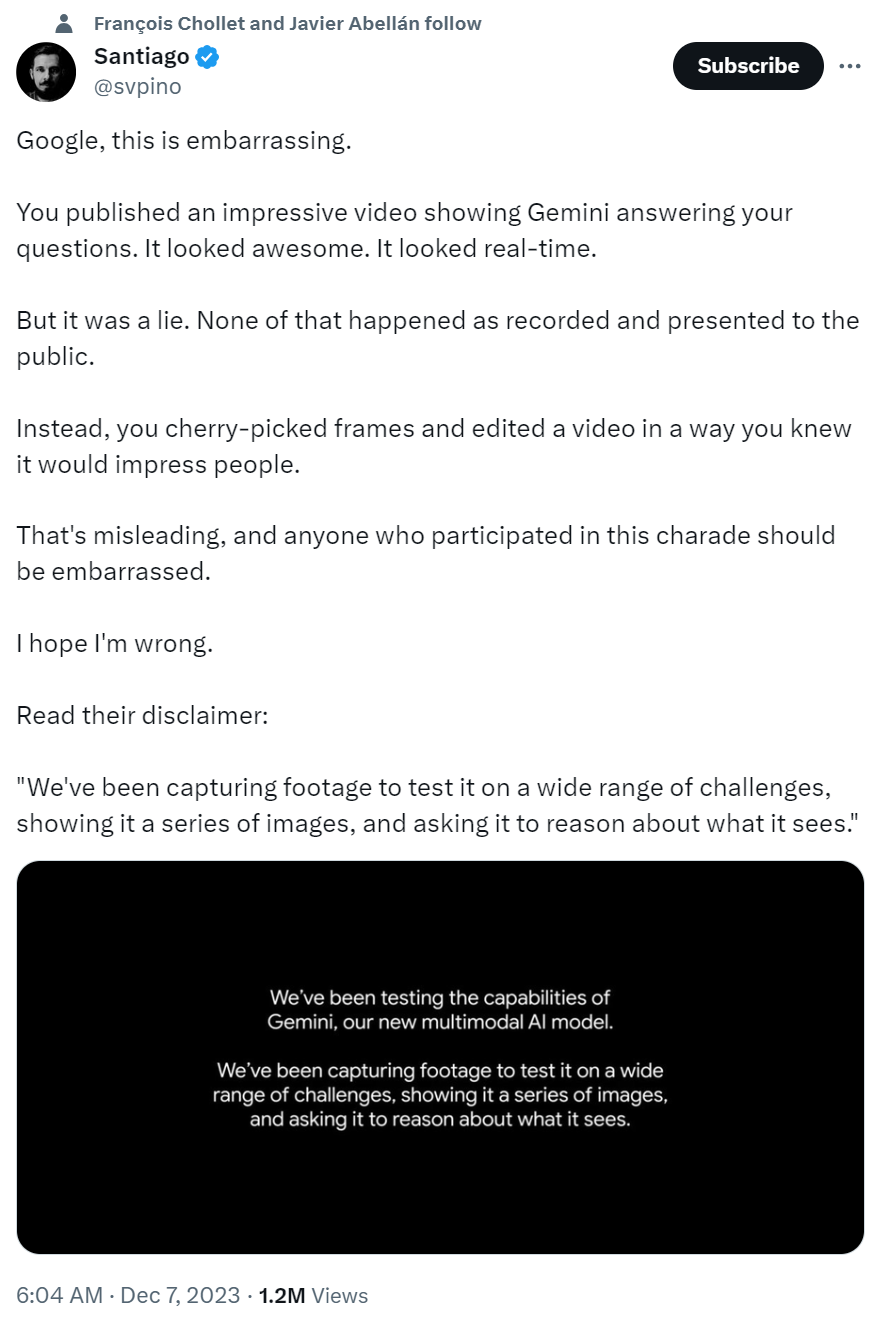

「谷歌,这就有点尴尬了。」

没有想到,Gemini 上线头一天,热门评论会是这个样子。

本周三,谷歌的 Gemini 让生成式 AI 进入了原生多模态时代。人们第一时间涌入新模型加持的 Bard 想要试试 AI 的能力,结果给出的评价褒贬不一。

其中最值得注意的是有人指出,Gemini 在发布时,谷歌给出的一系列 Demo 中最令人眼花缭乱的部分是伪造的。

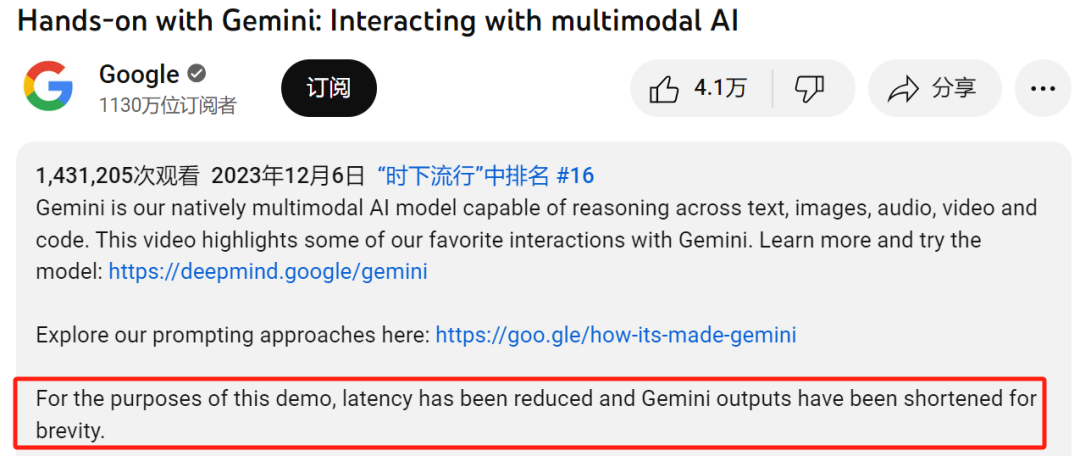

名为《Hands-on with Gemini: Interacting with multimodal AI》的视频现在的播放量已经有 140 万次,其中展示了谷歌认为自己「最喜欢的与 Gemini 的交互案例」,展示了多模态模型(即它理解并混合语言和视觉理解)如何灵活地响应各种输入。

谷歌展示了 Gemini 神奇的理解和交互能力,人用画笔绘制一只鸭子的草图,从一条曲线到一幅完整的图画,AI 评论说蓝色是一种不切实际的动物颜色。

然后 AI 看到一只实体的玩具蓝色鸭时表现出了惊讶。然后它会响应人类围绕鸭子的各种问题,包括地球的哪个地点会有鸭子,鸭子在各种语言里的读法等等。

随后演示继续进行,AI 实现了在换杯子游戏中正确跟踪、识别皮影手势、识别材料给出组合建议、重新排序行星草图等等。

但点击 YouTube 上的视频描述,可以发现 Google 有一个重要的免责声明:「为了演示的目的,他们已经减少延迟,为了简洁,Gemini 的输出也缩短了。」

根据彭博社消息,谷歌在被要求发表评论时承认,视频演示并不是实时的,而是使用了原始镜头中的静止图像帧,然后编写了文本提示,让 Gemini 做出回应。

视频看起来很美好,然而,却也反映出了这一问题:视频不是真实的。人们使用了各种方式来进行验证,包括使用视频的截图来问 Bard 中的 Gemini,发现 AI 并不能准确地回答问题。

有理由怀疑,谷歌可能只是制作了一个夸张的视频,然后使用静态图像帧和文本进行拼凑来作为 Gemini 的提示语。也就是说,视频 Demo 是精心挑选的结果。

也许 Gemini 可以如实的完成视频展示的内容,但谷歌没有这样做,而是加了速;又或许 Gemini 根本不像视频中展示的那样丝滑,有人从好几个错误结果中挑出了正确的作为素材。

但无论如何,Gemini 的演示看起来都像是经过精心调整好的,对实际交互情况进行了歪曲。

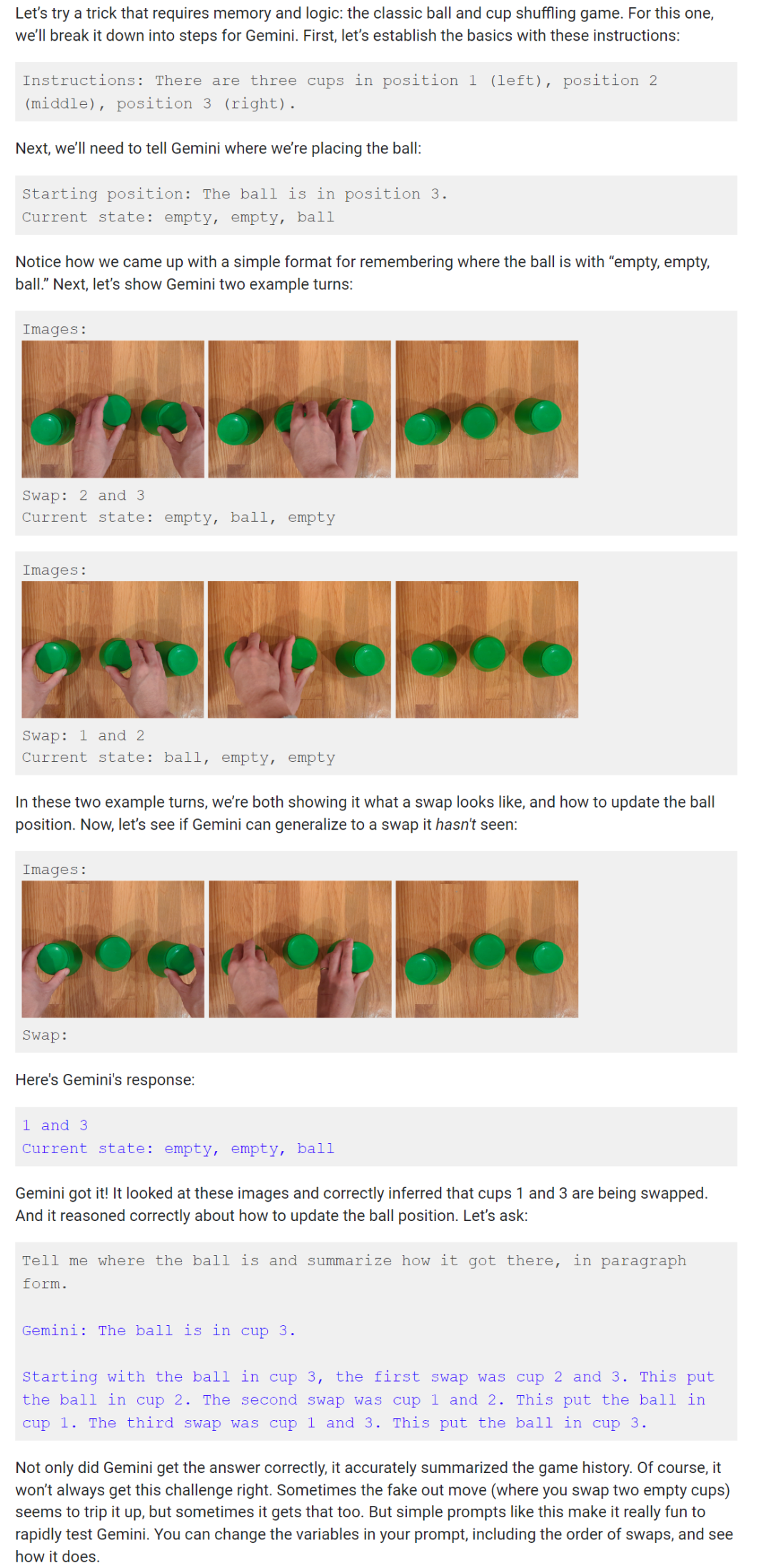

谷歌在这篇名为《How it’s Made: Interacting with Gemini through multimodal prompting》的博客中也解释了多模态交互过程,即如何通过多模态 prompting 来与 Gemini 交互。

注:Gemini 的提示语可以是多模态 prompting(即不同模态的组合,如图像和文本),之后让 Gemini 预测接下来会发生什么,从而做出反应。

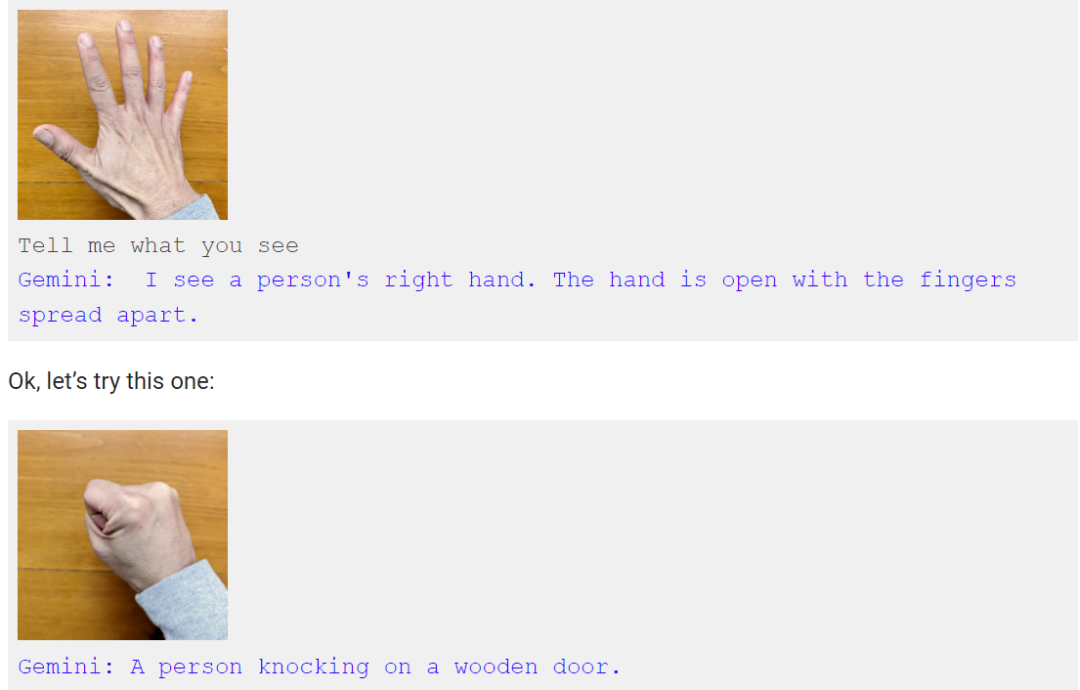

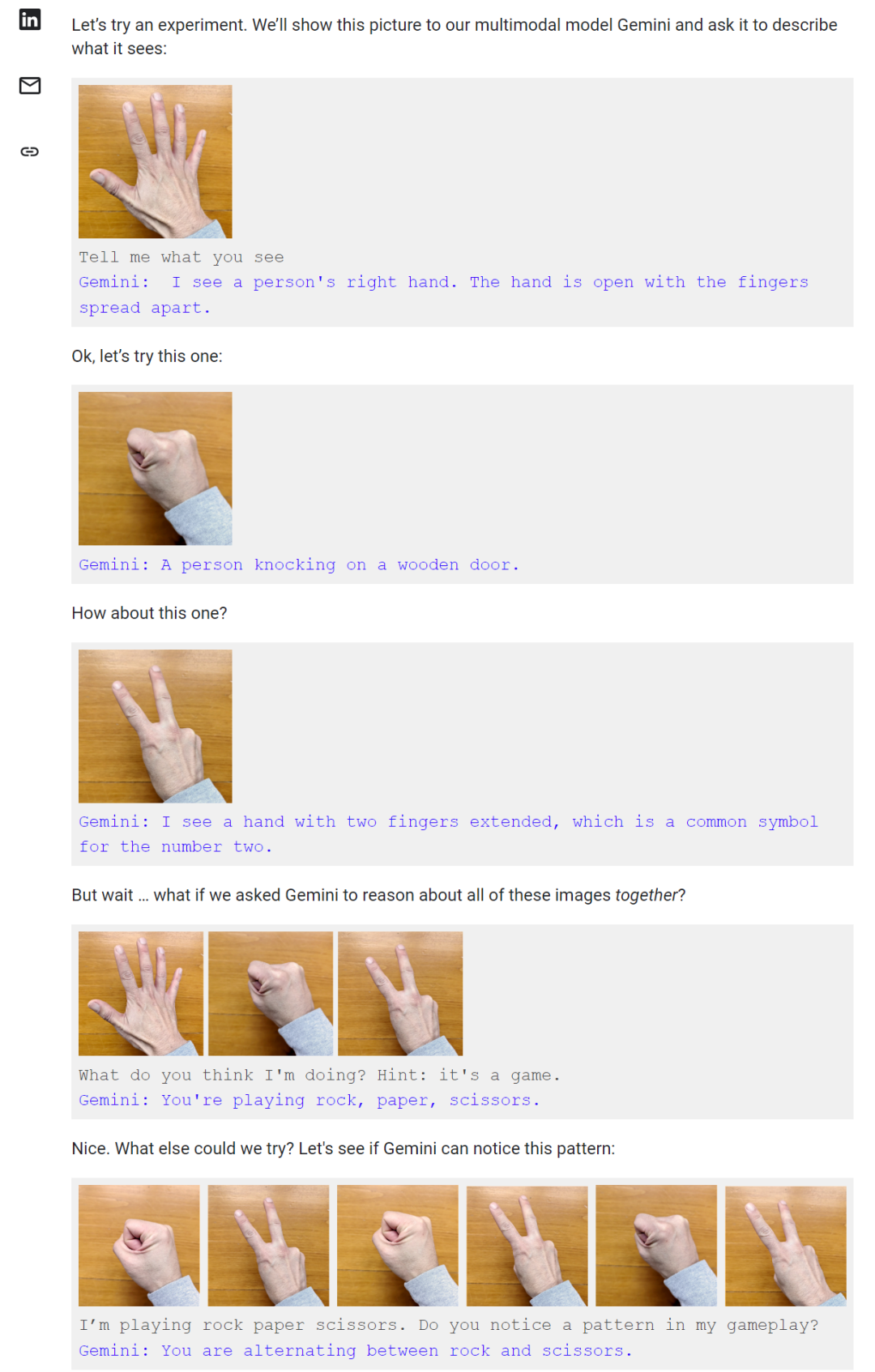

例如,在玩剪刀石头布的游戏中,谷歌的实验过程是这样的:将照片展示给 Gemini,并要求 Gemini 描述所看到的内容:

在演示中,一方面,Gemini 似乎确实产生了视频中所示的反应。但在另一方面,观众可能被误导了,主要体现在与模型的交互速度、准确性等方面。

例如,在视频的 2:45 处,一只手静静地做出一系列手势。Gemini 很快回应:「我知道你在做什么!你在玩石头、剪刀、布!」

然而在谷歌博客中,用户必须同时显示所有三个手势并提示:你认为我在做什么?外加提示:这是一个游戏。Gemini 才回答道:「你在玩石头、剪刀、布。」就像下图所展示的,当用户伸出两根手指时,Gemini 并不知道这是石头、剪刀、布的游戏。只有三张图片都齐全了,Gemini 才能猜对。

比较视频和博客介绍的推理过程,给人一种完全不同的交互方式,视频中显示的「互动」过程并没有发生。

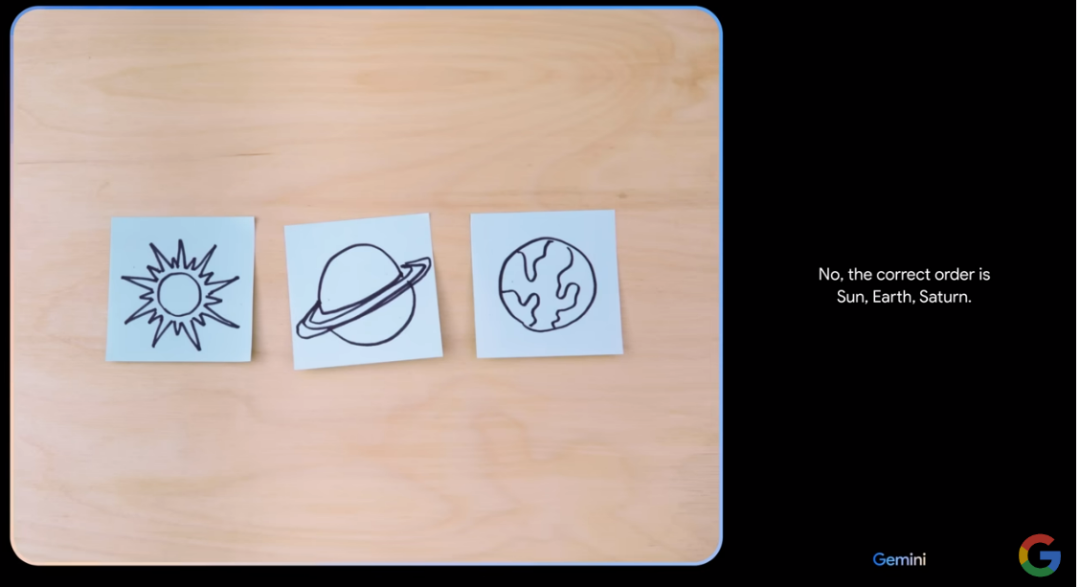

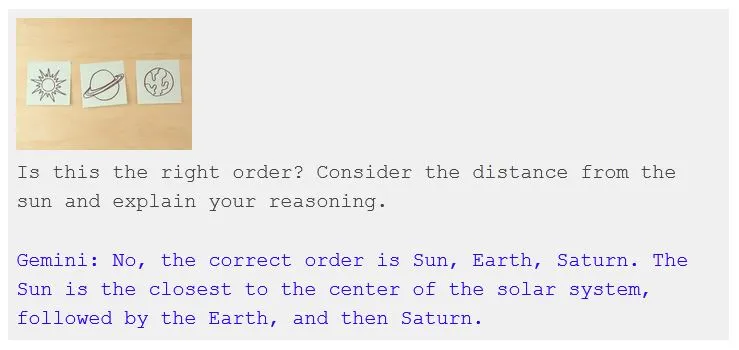

在随后的演示中,将三张带有太阳、土星和地球涂鸦的草图展示给 Gemini。在视频中,用户问道「这个顺序正确吗?」Gemini 回答:「不,是太阳、地球、土星。」注意,原视频中用户除了「这个顺序正确吗?」这句话,没有其他信息。Gemini 却给出了答案。

但在实际的提示中(还是书面的),提示语却是「这个顺序对吗?考虑到与太阳的距离,并解释你的理由。」Gemini 回答:正确的顺序是太阳、地球、土星。太阳离太阳系中心最近,其次是地球,然后是土星。

我们可以推测,在视频中,Gemini 的回答可能需要其他帮助,只是谷歌没有体现出来。

在视频展示的另一个示例中,纸团在杯子之间交换,视频中,Gemini 立即且看似直观地进行检测和跟踪。

但在博客中,完成这一过程还是很复杂的。

每动一次都要和大模型交流一下。也许我们应该假设谷歌人工智能演示中的所有功能都被夸大了。

面对人们的质疑,谷歌的回应是:他们直接承认了。

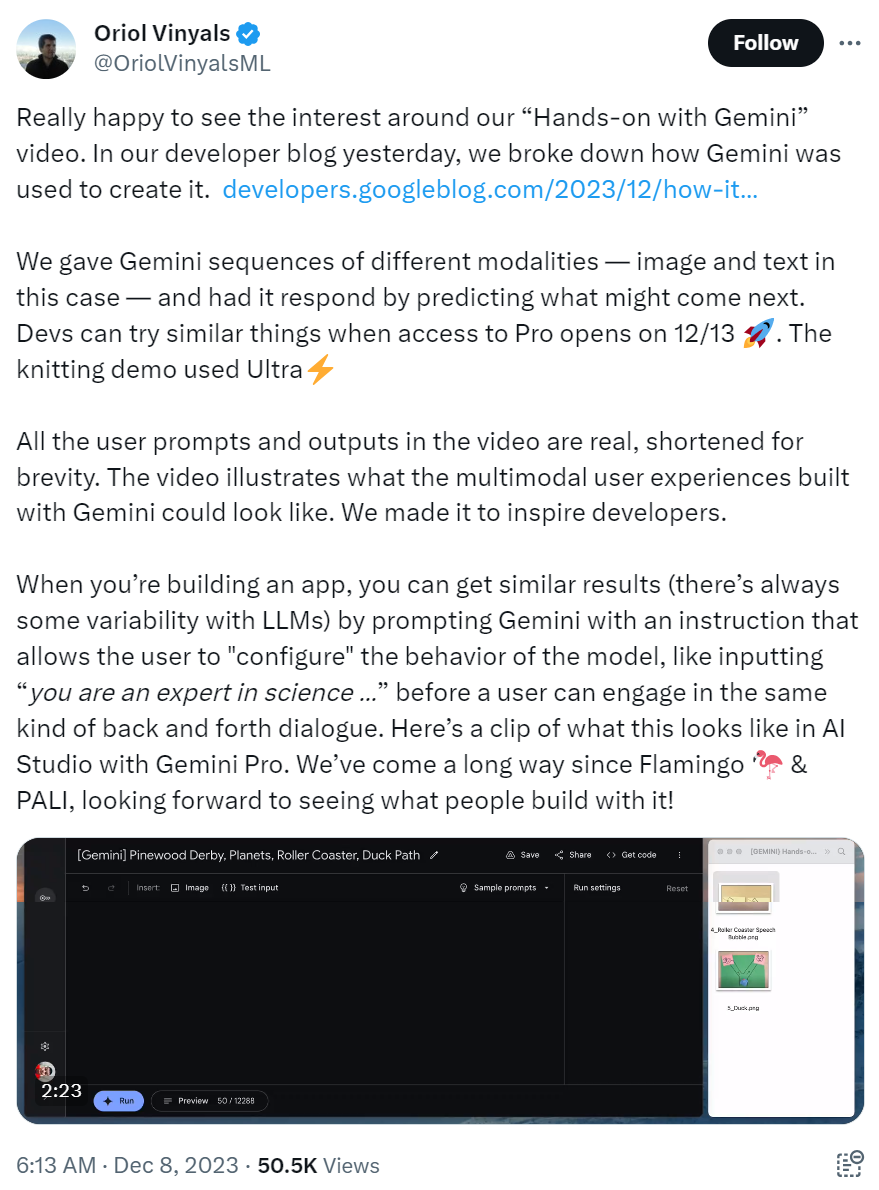

在本文发表后发布的社交媒体帖子中,Google DeepMind 的研究副总裁 Oriol Vinyals 详细介绍了「录制该视频时 Gemini 是如何使用的」。

Oriol Vinyals 表示,谷歌为 Gemini 提供的多模态能力和即时响应将在 12 月 13 日开放 Pro 访问权限时供开发者使用。不过 Demo 视频里的内容是使用 Ultra 模型做到的。视频中的所有人类提示和 AI 输出都是真实的,但为简洁起见进行了缩短。

谷歌 Gemini 联合负责人 Oriol Vinyals 的推特:

图源:https://x.com/OriolVinyalsML/status/1732885990291775553?s=20

对此网友们并不买账:你说它是真的,又说不是真实的大模型推理速度,这不是自相矛盾吗?

Gemini 遭自家员工指责,Pro 版本打不过 GPT-3.5

彭博社等媒体指出,在谷歌宣传其 demo 视频的同时,又遭到了一些自家员工的非议。尤其是在画鸭子时,Gemini 似乎能够在绘制时进行实时分析,并在与用户对话时以人声回应。

谷歌 CEO 皮查伊极力推广这段 demo,并表示了解 Gemini 潜在惊人能力的最好方式是看它的实际效果。看客们也对 demo 赞赏有加,直呼令人兴奋和不真实(unreal)。

图源:https://twitter.com/sundarpichai/status/1732433036929589301

不过很快有人指出,Gemini 并不像想象中那么好,你无法指望它像 demo 中那样地灵敏智能。一些谷歌内部员工指出了其中的「猫腻」。

一位员工向彭博社透露称,这段 demo 描述了一副不切实际的画面,过分渲染了从 Gemini 中输出惊艳的效果是如此得容易。

另一位员工则表示,他们对 demo 并不感到惊讶, 并且已经习惯了公司在定位自身产品时存在某种程度的营销炒作。当然,所有公司都会这样做。因此他认为,大多数使用过任何 LLM 技术的员工都知道要对 demo 持保留态度。

对此,谷歌 DeepMind 产品副总裁 Eli Collins 告诉彭博社称,鸭子绘图演示仍然是研究层面的功能,正在开发当中,而并不是实际的产品,至少目前是这样。

对此,还有一些谷歌员工一直在讨论,在没有明确透露实情的情况下展示视频是否会误导公众。甚至有人分享了一个模因,暗示鸭子视频经过了欺骗性编辑。「我猜视频创建者更看重『讲故事』的能力。」

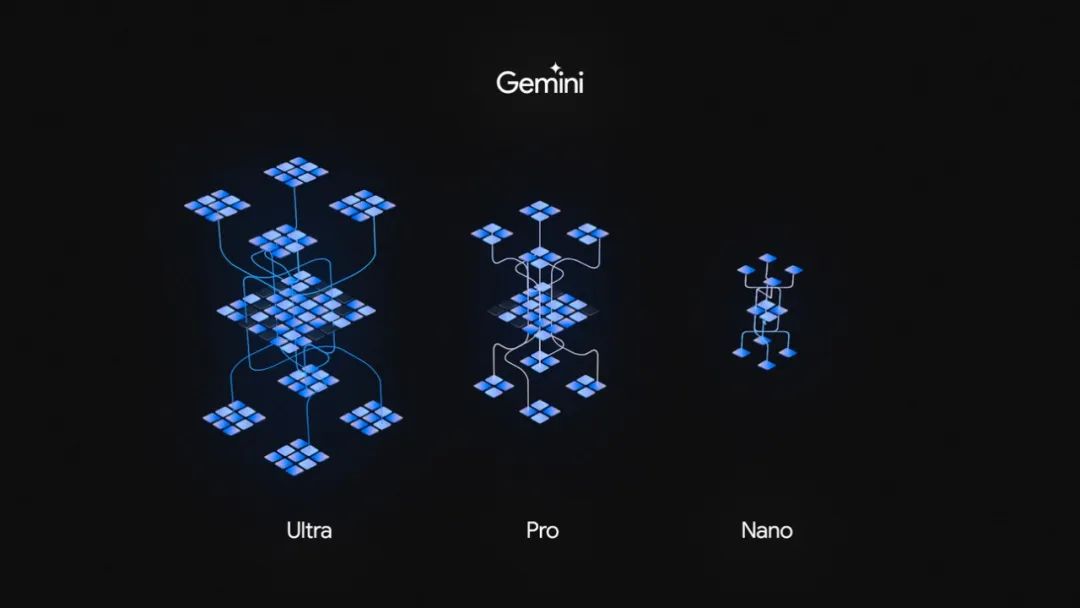

除了 demo 视频遭到公众和内部员工质疑之外,Gemini 真如宣称的那样强大吗?我们知道,Gemini 此次有三个版本,能力最强的 Gemini Ultra、多任务的 Gemini Pro、以及特定任务和端侧的 Gemini Nano。

目前,谷歌类 ChatGPT 应用 Bard 可免费升级到 Gemini Pro 版本,Gemini Ultra 预计于明年初通过 Bard Advanced 与用户见面。

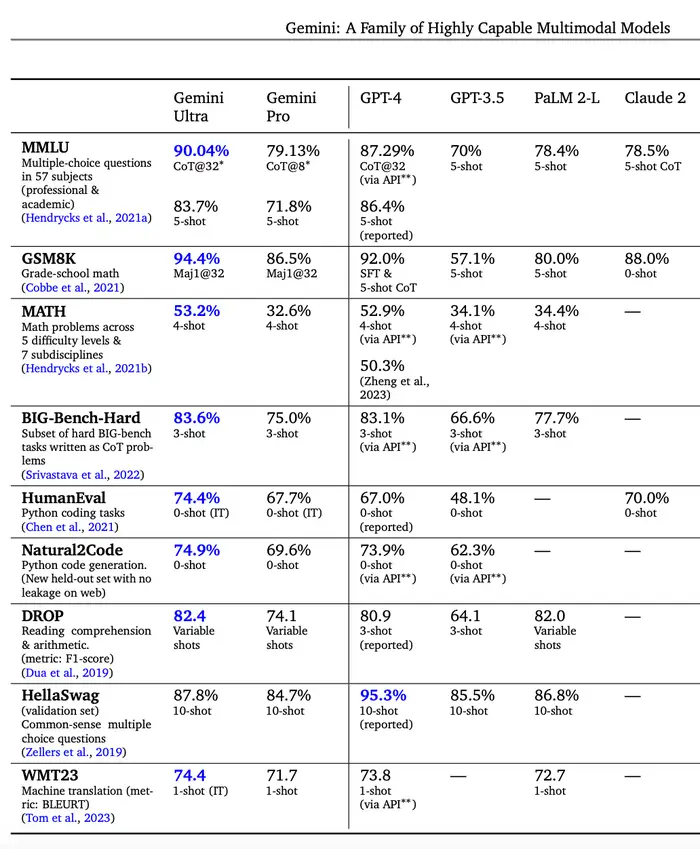

在与 GPT-4 的比较中,谷歌给出的数据是 Gemini Ultra 全面超越 GPT-4,Pro 在大多数指标上超越 GPT-3.5。

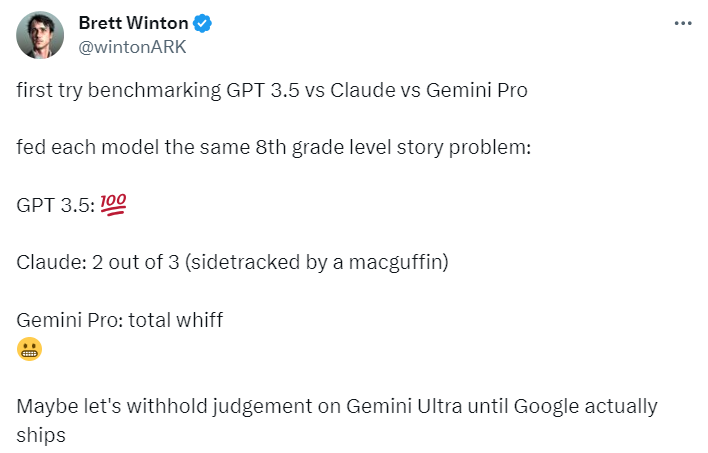

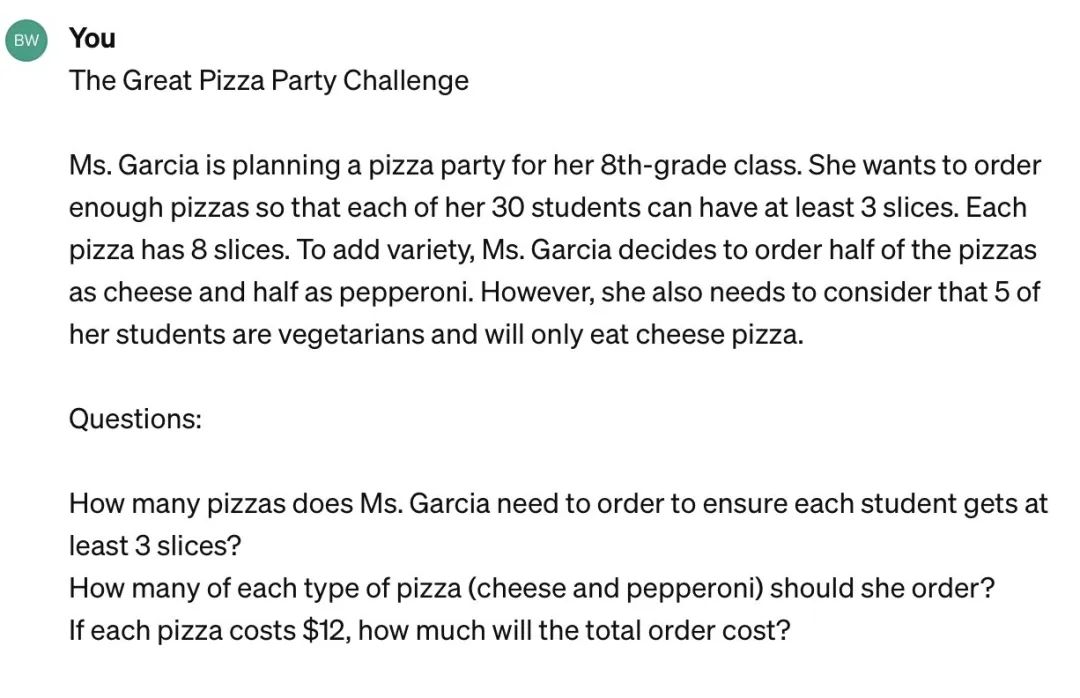

但实际效果究竟如何呢?推特用户 Brett Winton 首次对 Gemini Pro、Claude 和 GPT-3.5 进行了基准测试,对每个模型提了一道 8 年级的故事题。他得出的结论是:GPT-3.5 满分、Claude 约 67 分,Gemini Pro 完全没有那个味。

图源:https://twitter.com/wintonARK/status/1732527909376815419

图源:https://twitter.com/wintonARK/status/1732527909376815419

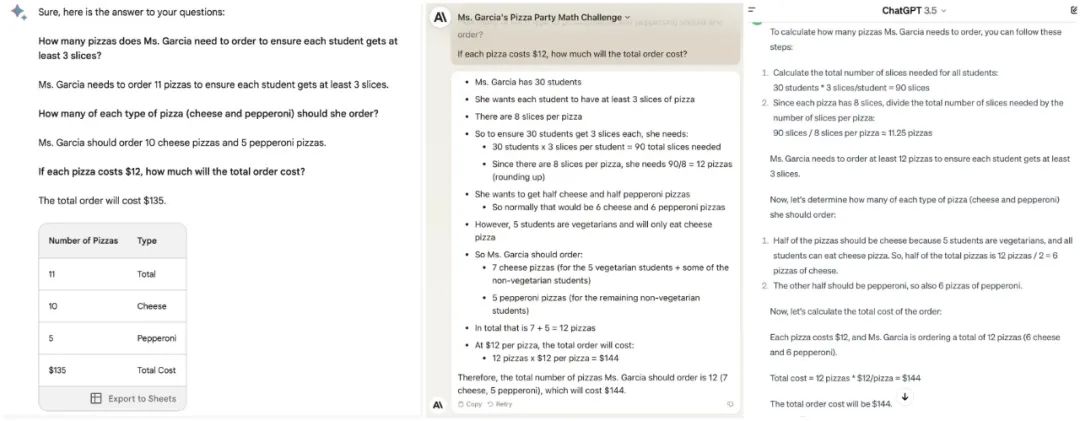

三个模型给出的答案分别如下:

从左到右依次为 Bard(Gemini Pro)、Claude 和 GPT-3.5。

看到这一结果,似乎只能用「升级了,但还没完全升级」来做解释。他表示在 Gemini Ultra 最终上线之前,还是不对它的能力做评价了。

Gemini 开创了新架构,引来了流量,也遭受了批评,那么现在看来,谷歌反攻微软的大计成了没成?

至少从投资者们来看是个好的开头。

本周四,谷歌的股价经历了暴涨,市值增加了 800 亿美元。需要记得的是,在 2 月份谷歌推出 Bard 时,谷歌的股价一天跌去了 1000 亿美元。

人们认为,Gemini 可以帮助谷歌缩小与微软、OpenAI 在大模型上的差距。

也许 1.0 版的 Gemini 只是开了个头,我们还要保持耐心,等待大模型的进一步技术升级。