NUMA的出现

我们都知道,CPU是计算机的核心组件,它被设计用来完成计算机的核心任务:计算,这里的计算既包括数学上的运算,还包括条件的判断、IO设备的读写等多个方面。

在计算机发展初期,为了提升CPU的计算能力,工程师们的方法是不断增加晶体管的数量和提升CPU的主频,因为这可以让CPU在单位时间内完成更多次数的计算。

然而,当技术发展到一定程度之后,CPU的散热和功耗的问题开始变得突出,单纯提升主频开始变得越来越困难,然后工程师们又有了新的想法:既然一个人干活效率有限,那就让更多的人一起干活吧!于是,多核CPU应运而生。

多核CPU可以同时处理多个任务,极大地提高了计算机的运算速度。然而,随着核心数量的增加,新的问题也随之出现。在多核CPU系统中,所有的核心共享同一块内存,当多个核心同时访问内存时,就会产生争用,这种争用会导致内存访问的延迟增加,从而影响系统的整体性能。

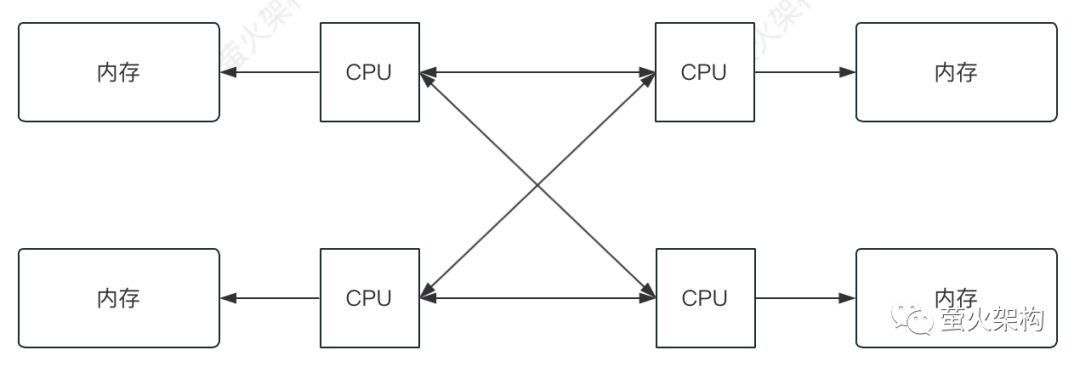

为了解决这个问题,工程师们又提出了非统一内存访问(NUMA)架构。在NUMA架构中,每个节点都有自己的内存,节点之间通过CPU互连网络进行通信。这样,每个节点中的处理器访问自己的内存时,就不会与其他节点产生争用,从而减少了内存访问的延迟,提高了系统的整体性能。

图片

图片

NUMA的问题

虽然非统一内存访问(NUMA)架构可以提高多处理器系统的性能,但它也带来了一些新的问题,主要包括以下几点:

内存访问不均衡

在NUMA系统中,处理器访问远程内存时需要经过核心之间的通道进行,因此本地内存的速度要比访问远程内存快,大约比访问其它节点快2倍以上。这就意味着,如果一个程序的数据大部分位于远程节点,那么它的性能可能会受到影响。例如,假设有一个程序,它在处理器A上运行,但它需要访问的数据大部分在处理器B的本地内存中,那么它需要花费更多的时间来获取这些数据,这就降低了程序的运行效率。

还有,如果程序的数据不是均匀的分布在各个内存节点,CPU访问数据时就可能时快时慢,这会给程序的稳定运行带来一些挑战,对于一些性能敏感的应用影响会比较大。

数据管理复杂

在NUMA系统中,每个处理器都有自己的内存,这就需要操作系统和应用程序更加智能地管理数据的分布和迁移,以确保内存访问的均衡性。例如,操作系统需要能够监控程序的内存访问模式,并根据需要将数据从一个节点迁移到另一个节点,这增加了操作系统的复杂性。

另外,现代CPU的物理核心都会自带一个高速缓存,它会缓存程序频繁使用和即将使用的数据,如果程序频繁的在各个物理核心之间切换执行,就会导致缓存的失效,影响程序的性能。解决这个问题需要复杂的缓存同步机制。

硬件和软件兼容性问题

NUMA架构需要特定的硬件支持,并且需要操作系统和应用程序具有相应的调度和优化策略,以充分利用NUMA的优势。例如,一些操作系统可能无法正确识别和优化NUMA硬件,或者一些应用程序可能没有正确地使用NUMA API,这都可能影响到系统的性能。

解决方案

解决NUMA架构中遇到的问题并不是那么容易,这涉及到硬件设计、操作系统优化和应用程序调度等多方面的技术和策略,下面是一些常见的解决方案:

内存亲和性

内存亲和性(memory affinity)是一种让程序尽可能访问本地内存的技术。这主要有赖于操作系统,它可以通过调度策略,让线程或进程在访问数据时,优先访问它们所在的CPU节点的内存。这样可以减少访问远程内存的次数,提高程序的运行效率。

这还有赖于操作系统的智能内存管理机制。例如,Linux操作系统中的自动NUMA平衡功能,可以自动监控程序的内存访问模式,并在需要时将数据迁移到更接近的节点,以减少访问远程内存的开销。

高速互连技术

有时候跨节点访问内存不可避免,为了尽量提高和稳定访问速度,CPU厂商们在小小的硅片上搞出了很多小花样。

在多核CPU中,一些核心可能会共享一级或二级缓存。操作系统可以将需要频繁通信的线程调度到共享缓存的核心上,可以提高数据访问的效率。

在大型的NUMA系统中,可能会有很多个处理器和内存节点。为了更好地管理这些资源,设计者们将相邻的或者性能相似的节点组织在一起,形成一个子NUMA群组。每个群组内部的节点可以高速互连,而群组之间的连接可能会相对较慢。在应用程序设计和系统调度方面,我们可以将这些群组作为调度和内存分配的单位,以便更好地控制内存访问的性能。

为了提高处理器内部或处理器之间的访问速度,CPU厂商们搞出了一些高速互联技术,比如AMD的Infinity Fabric和Intel的Ultra Path Interconnect(UPI),它们可以提供更高的带宽和更低的延迟,提高了数据在节点之间的传输效率。

软硬件兼容

为了充分利用NUMA的优势,硬件、操作系统和应用程序需要进行相应的优化。硬件制造商需要提供支持NUMA的硬件,并提供相应的驱动程序。

操作系统依赖这些驱动程序,然后能够识别和管理NUMA硬件,并提供相应的API供应用程序使用。比如Linux提供了numactl工具和libnuma库,可以用来设置内存亲和性。

应用程序开发者则需要了解NUMA架构,并使用正确的API和算法,以确保程序在NUMA系统上的性能。

比如在多线程环境中,如果两个或更多的线程在同一个缓存行中的不同位置读写数据,一个线程写数据就可能导致另一个线程需要读取的数据在缓存中失效,从而导致很慢的内存读取。这就需要在编程时注意:尽量让同一缓存行中的数据被同一个线程访问,或者是通过内存对齐和填充,使得同一缓存行中的数据不会被多个线程同时访问。

一些高性能的程序都会考虑这方面的问题,比如Java中的Disruptor异步处理库,Disruptor在每个事件处理器的序列号周围填充了一些无用的数据,使得每个事件处理器的序列号都独占一个缓存行。这样,即使多个事件处理器在并发地更新自己的序列号,也不会影响到其他事件处理器的缓存行。

总的来说,解决NUMA架构中的问题需要硬件、操作系统和应用程序的配合。通过正确的设计和优化,可以充分利用NUMA的优势,提高多处理器系统的性能。

应用案例

再举两个例子。

数据库应用

在数据库应用中,我们可以利用NUMA的特点进行优化。例如,我们可以将数据库的表分区,并将不同的分区分配到不同的NUMA节点。这样,当多个查询同时运行时,它们可以在不同的节点上并行执行,互不干扰,从而提高了查询的性能。

高性能计算

在高性能计算应用中,我们可以将并行的任务分配到不同的NUMA节点上。这样,每个任务可以在本地内存中访问数据,避免了访问远程内存的开销,从而提高了计算的效率。

通过这些例子可以看到一个基本原则:在NUMA架构中,我们应该尽可能让任务在本地内存中访问数据,以避免访问远程内存的开销。通过合理的任务调度和数据分布策略,我们可以充分利用NUMA的优势,提高程序的性能。