本文经自动驾驶之心公众号授权转载,转载请联系出处。

个人理解&&写在前面

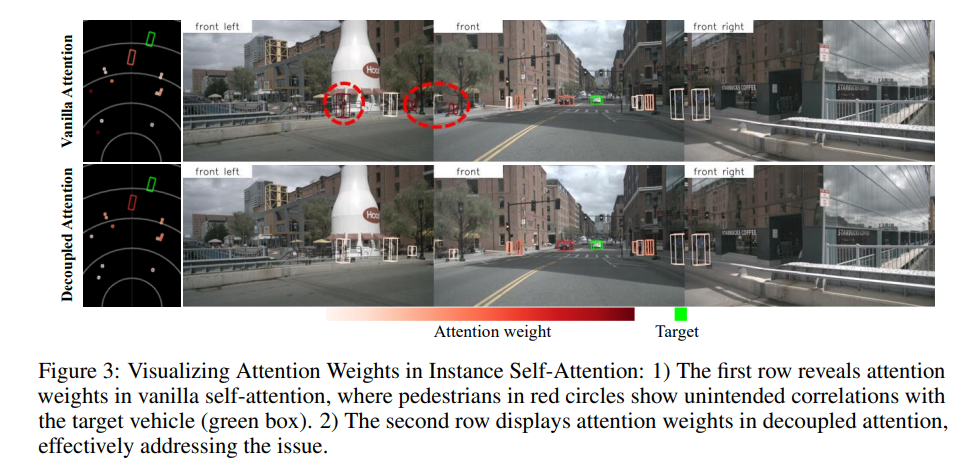

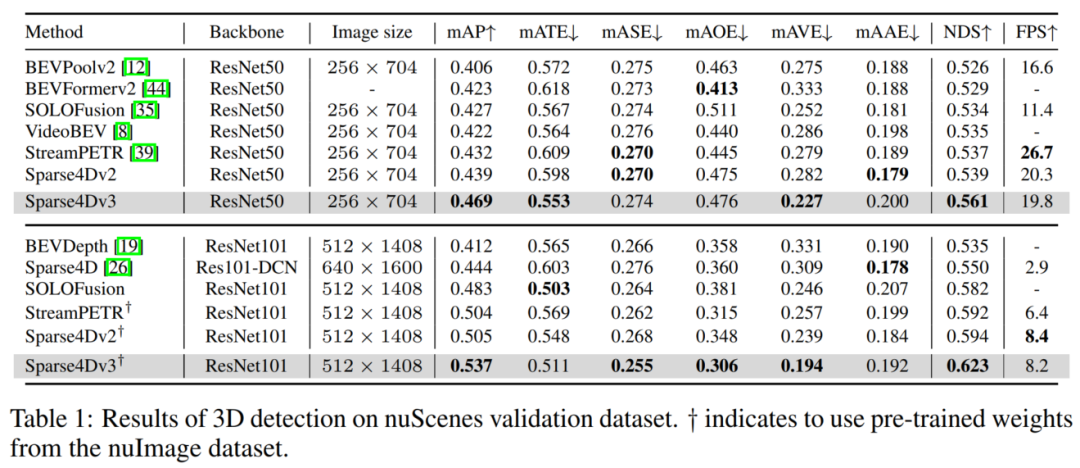

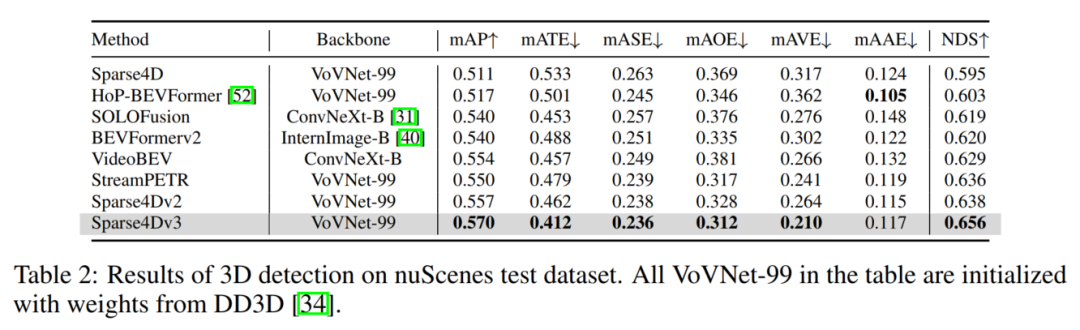

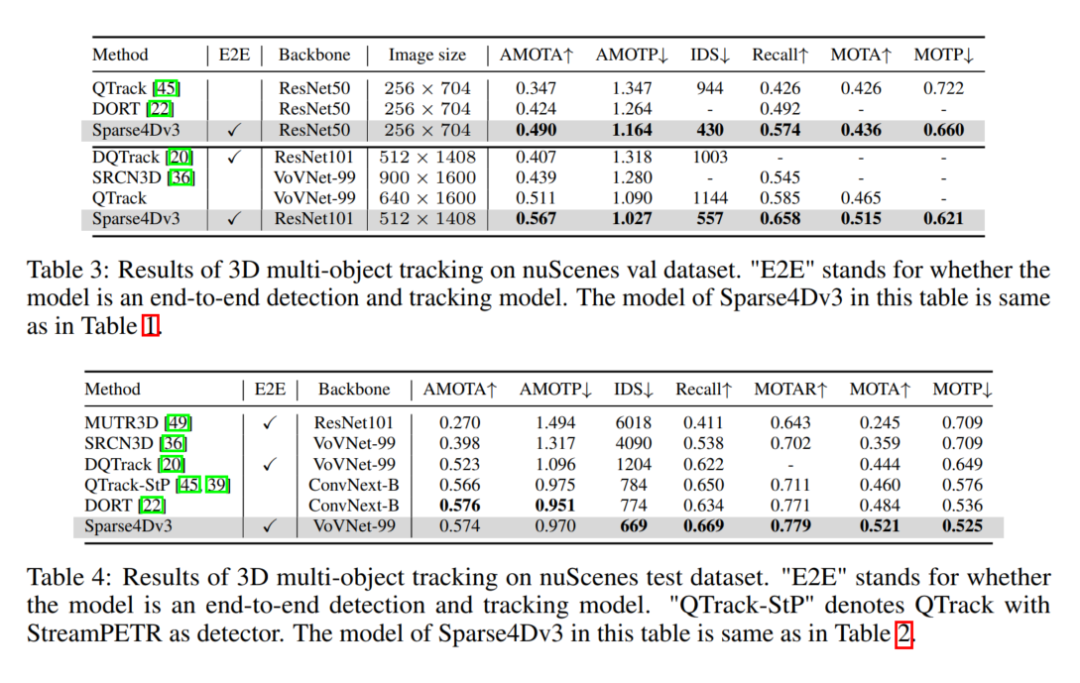

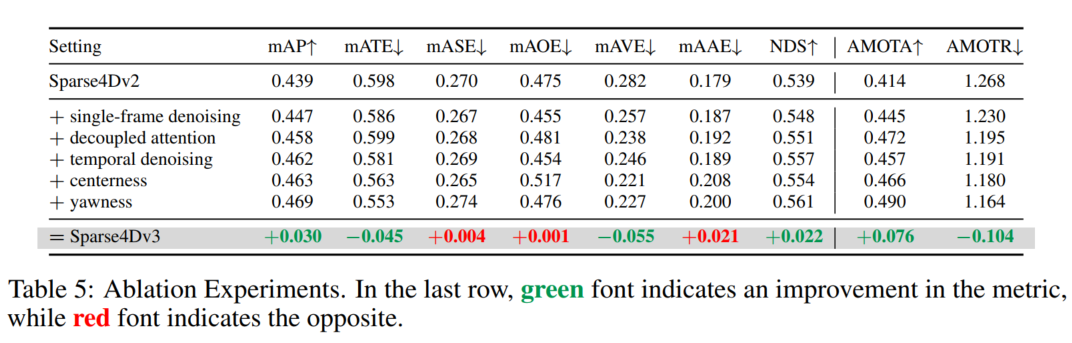

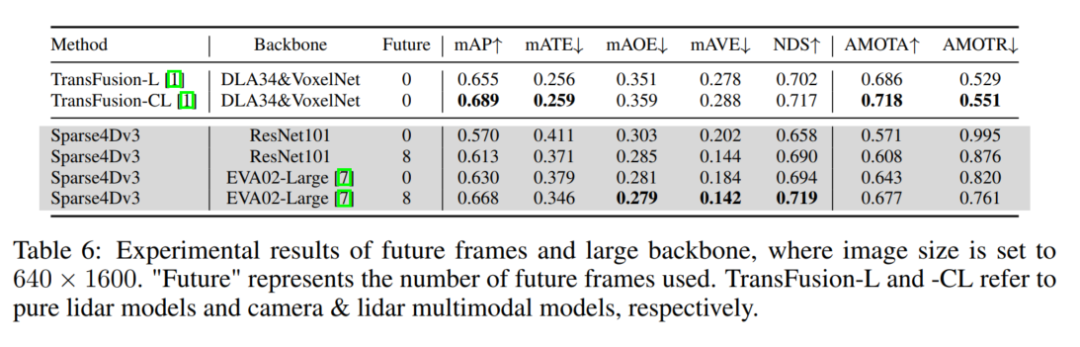

自动驾驶感知系统中,3D检测和跟踪是两项基本任务。v3版本在Sparse4D的基础上对该领域进行了更深入的研究。主要引入了两个辅助训练任务(时态实例去噪和质量估计),并提出了解耦注意力来进行结构改进,从而显著提高检测性能。此外,还使用一种简单的方法将检测器扩展到跟踪器中,该方法在推理过程中分配实例ID,进一步突出了基于Query算法的优势。 这一段话中间开始可以改成 该方法在推理过程中通过直接分配实例id的方式实现跟踪。和现有的端到端跟踪方法(如motr系列)相比,sparse4d v3中无需加入任何针对跟踪的训练策略,进一步突出了基于稀疏实例的时序算法的优势。在nuScenes上以ResNet50为主干,mAP、NDS和AMOTA的提升分别为3.0%、2.2%和7.6%,达到了46.9%、56.1%和49.0%。Best Model在nuScenes测试集上获得了71.9%的NDS和67.7%的AMOTA。

一句话总结下:Sparse4D-v3包含三种有效的策略--时间实例去噪、质量估计和解耦注意力,这也是将Sparse4D扩展到端到端跟踪模型中的尝试!在检测和跟踪任务中都实现了SOTA!

Sparse4D框架回顾

在时序多视角感知研究领域,基于稀疏的算法取得了重大进展,达到了与基于dense-BEV-based算法相当的感知性能,同时提供了几个优势:

- 1) 无需视角变换模块。这些稀疏方法消除了将图像空间转换为3D矢量空间的模块。

- 2) 检测头中的恒定计算负载,与感知距离和图像分辨率无关。

- 3)更容易地实现对下游任务进行端到端方式的集成。

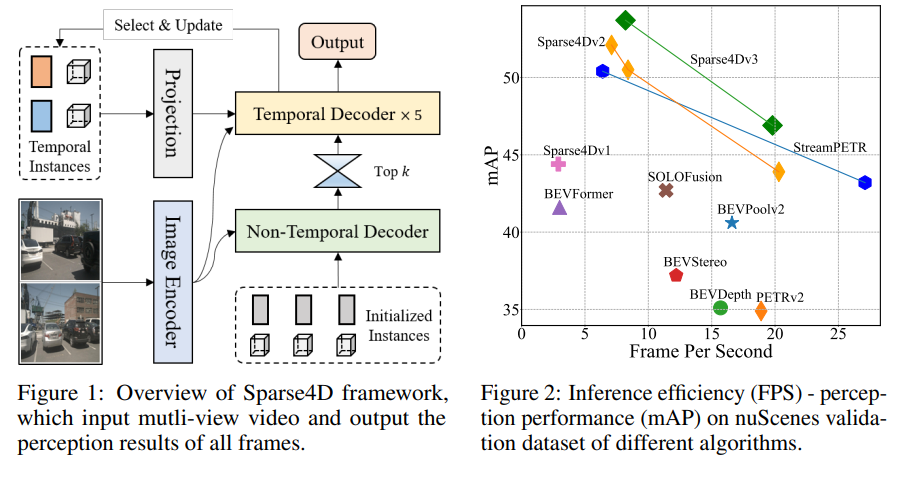

这里选择了稀疏算法Sparse4Dv2作为改进的基线算法。该算法的总体结构如图1所示,图像编码器将多视图图像转换为多尺度特征图,解码器利用这些图像特征来细化实例并生成感知结果。

与基于密集的算法相比,基于稀疏的算法在收敛方面遇到了更大的挑战,最终影响了它们的最终性能。这个问题已经在2D检测领域进行了深入的研究,主要归因于一对一正样本匹配的使用。这种匹配方法在训练的初始阶段是不稳定的,并且与一对多匹配相比正样本数量大幅减少,从而降低解码器训练的效率。

此外,Sparse4D利用稀疏特征采样而不是全局交叉注意力,由于正样本的特征采样点稀少,进一步阻碍了编码器的收敛。在Sparse4Dv2中,引入了密集深度监督,一定程度缓解图像编码器面临的这些收敛问题。v3主要目的是通过关注解码器训练的稳定性来提高模型性能。将去噪任务作为辅助监督,并将去噪技术从2D单帧检测扩展到3D时序检测。它不仅确保了稳定的正样本匹配,而且显著增加了正样本的数量。此外,还引入了质量评估作为辅助监督的任务。这使得输出置信度更加合理,提高了检测结果排名的准确性,从而得到更高的评估指标。并且,我们还改进了Sparse4D中实例自注意和时序交叉注意模块的结构,提出了一种解耦的注意机制,旨在减少注意力权重计算过程中的特征干扰

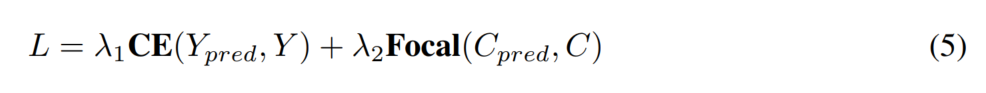

如图3所示,当anchor嵌入和实例特征被添加为注意力计算的输入时,在产生的注意力权重中存在异常值的实例。这不能准确地反映目标特征之间的相互关联,导致无法聚合正确的特征。通过用特征拼接代替特征相加,显著减少了这种错误现象的发生。这种改进与Conditional DETR有相似之处。然而,关键的区别在于这里强调query之间的注意力,而不是Conditional DETR,后者专注于query和图像特征之间的交叉注意力。

当前背景介绍

DETR采用了Transformer架构以及一对一匹配训练方法,以消除对NMS的需求并实现端到端检测。DETR带来了一系列后续改进。Deformable DETR基于参考点将全局注意力变为局部注意力,显著缩小了模型的训练搜索空间,提高了收敛速度。它还降低了注意力的计算复杂性,便于在DETR框架内使用高分辨率输入和多尺度特征。Conditional DETR引入了条件交叉注意力,将query中的内容和空间信息分离,并通过点积独立计算注意力权重,从而加速模型收敛。基于Conditional DETR,Anchor DETR显式初始化参考点,用作anchor。DAB-DETR进一步将边界框维度包括在anchor的初始化和空间查询的编码中。此外,许多方法旨在从训练匹配的角度提高DETR的收敛稳定性和检测性能。DN-DETR使用添加的噪声对真值进行编码,作为解码器的query,采用去噪任务进行辅助监督。在DN-DETR的基础上,DINO引入了噪声负样本,并提出使用混合查询选择进行查询初始化,进一步提高了DETR框架的性能。Group DETR在训练期间将query复制到多个组中,从而提供更多的训练样本。Co-DETR在训练过程中结合了密集的Head,具有两个作用,既能够对主干进行更全面的训练,也能通过使用密集头输出作为query来增强解码器的训练!

DETR3D将可变形注意力应用于multi-view 3D检测,通过空间特征融合实现端到端的3D检测。PETR系列引入了3D位置编码,利用全局注意力进行直接多视图特征融合并进行时间优化。Sparse4D系列在实例特征解耦、多点特征采样、时序融合等方面增强了DETR3D,从而增强了感知性能。

大多数多目标跟踪(MOT)方法使用检测+跟踪框架。它们依赖于检测器输出来执行数据关联和轨迹过滤等后处理任务,从而产生了一个具有大量超参数的复杂pipeline,需要进行调整。这些方法并没有充分利用神经网络的能力,为了将跟踪功能直接集成到检测器中,GCNet、TransTrack和TrackFormer利用了DETR框架。它们基于track query将检测得的目标进行帧间传输,显著降低了后处理的依赖性,MOTR将跟踪推进到一个完全端到端的过。MOTRv3解决了MOTR的detection query训练的局限性,从而带来了实质性的改进(在跟踪性能方面)。MUTR3D将这种基于查询的跟踪框架应用于3D多目标跟踪领域。这些端到端跟踪方法有一些共同的特点:

(1) 在训练过程中,根据跟踪目标约束匹配,确保track query的ID匹配一致,detection query只匹配新目标。

(2) 使用高阈值来传输时间特征,只将高置信度查询传递到下一帧。

v3方法与现有方法不同,不需要修改检测器训练或推理策略,也不需要跟踪ID的ground truth。

方法介绍

网络结构和推理框架如图1所示!展示了Sparse4Dv2的网络结构和推理pipeline,这里将首先介绍两个辅助任务:时序实例去噪和质量估计,紧接着介绍注意力模块的增强,称为解耦注意力,最后概述了如何利用Sparse4D实现3D MOT。

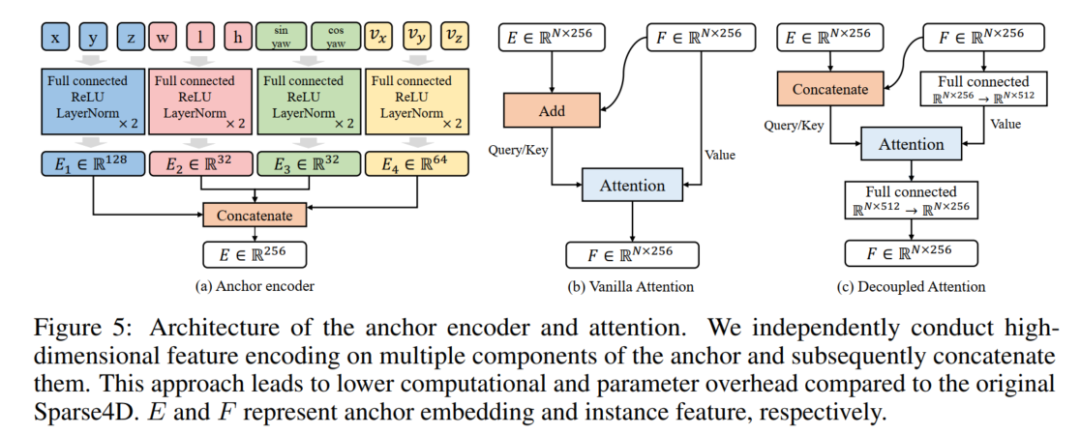

1)Temporal 实例去噪

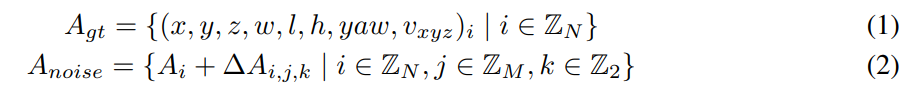

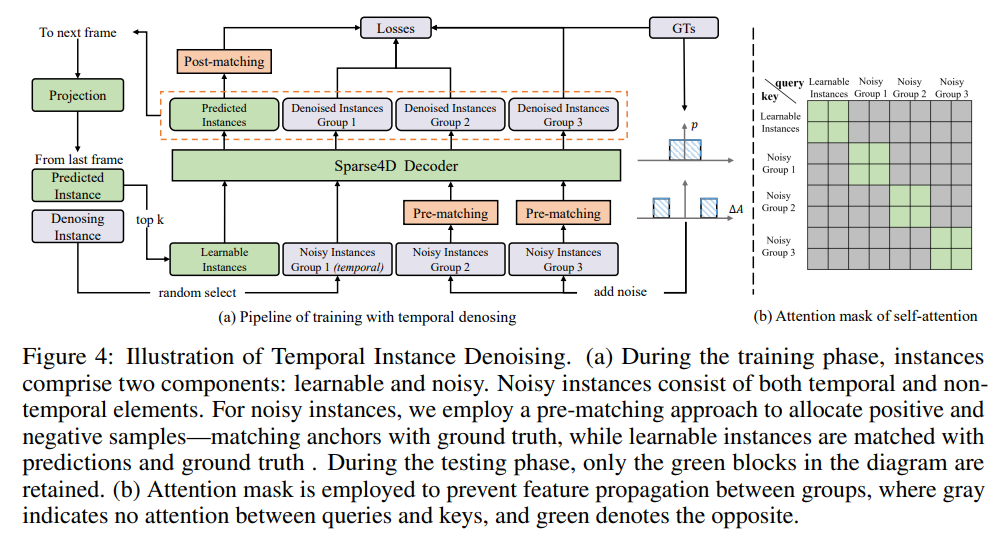

在2D检测中,引入去噪任务被证明是提高模型收敛稳定性和检测性能的有效方法。v3将基本的2D单帧去噪扩展到3D时序去噪。在Sparse4D中,实例(也可称为query)被解耦为隐式实例特征和显式anchor,在训练过程中初始化了两组anchor。一个集合包括均匀分布在检测空间中的anhcor,使用k-means方法初始化,并且这些anchor用作可学习参数。另一组anchor是通过将噪声添加到GT中来生成的。对于3D检测任务,噪声anchor生成如方程(1,2)所示

此外,通过时序传播扩展了上述单帧噪声实例,以更好地与稀疏递归训练过程保持一致。在每帧的训练过程中,从有噪声的实例中随机选择M′组投影到下一帧。时间传播策略与无噪声实例的策略一致:anchors进行自车pose和速度补偿,而实例特征直接作为后续帧特征的初始化。

需要注意的是,这里保持每组实例的相互独立性,并且在噪声实例和正常实例之间不会发生特征交互。这与DN-DETR不同,如图4(b)所示。这种方法确保在每组中,一个GT最多与一个正样本匹配,有效地避免了任何潜在的歧义!

2)质量估计

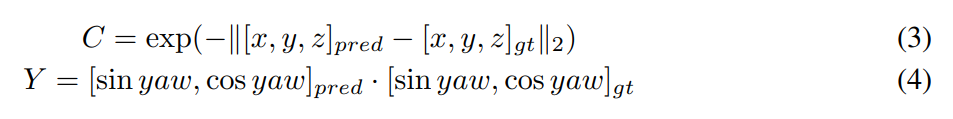

现有的基于稀疏的方法主要估计正样本和负样本的分类置信度,以测量与GT的一致性。优化目标是最大化所有正样本的分类置信度。然而,匹配质量在不同的正样本中存在显著差异,因此分类置信度不是用于评估预测边界框的质量的理想度量。为了便于网络理解正样本的质量,一方面加快收敛,另一方面合理化预测ranking ,这里引入了预测质量估计的任务。对于3D检测任务,定义了两个质量指标:centerness和yawness,公式如下:

在网络输出分类置信度的同时,它还估计了centerness和yawness,它们各自的损失函数为交叉熵损失和focal loss,如以下方程所示:

3)Decoupled Attention

v3对Sparse4Dv2中的anchor编码器、自注意和时间交叉注意进行了简单的改进,该体系结构如图5所示。设计原则是以拼接的方式结合不同模态的特征,而不是使用加法。与Conditional DETR相比,存在一些差异。首先,改进了查询之间的注意力,而不是查询和图像特征之间的交叉注意力;交叉注意力仍然利用来自Sparse4D的可变形聚集。此外,没有在单头注意力级别连接位置嵌入和查询特征,而是在多头注意力级别进行外部修改,为神经网络提供了更大的灵活性!

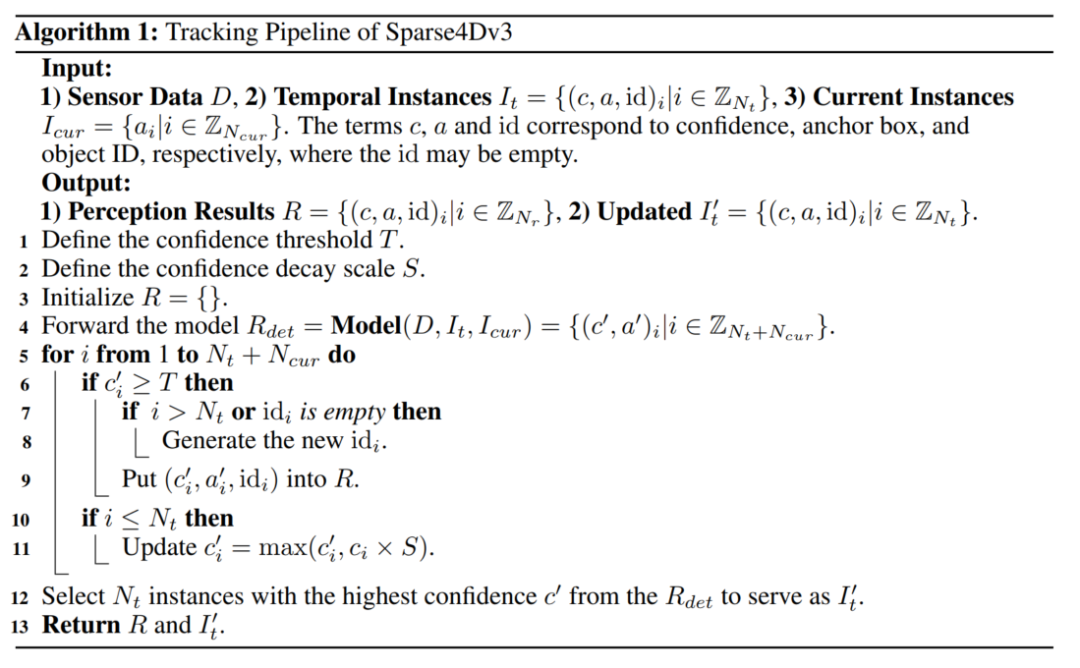

4)扩展到跟踪部分

在Sparse4Dv2的框架中,时序建模采用了递归形式,将前一帧的实例投影到当前帧上作为输入。时序实例类似于基于query的跟踪器中的track query,不同之处在于track query受到更高阈值的约束,表示高度自信的检测结果。相比之下,v3的时序实例很多,其中大多数可能无法准确地表示先前帧中检测到的目标。

为了在Sparse4Dv2框架内从检测扩展到多目标跟踪,我们直接将实例从检测边界框重新定义为轨迹。轨迹包括ID和每个帧的边界框。由于设置了大量冗余实例,许多实例可能不与精确目标相关联,并且不被分配明确的ID。尽管如此,它们仍然可以传播到下一帧。一旦实例的检测置信度超过阈值T,就认为它被锁定在目标上并被分配了ID,该ID在整个时间传播过程中保持不变。因此,实现多目标跟踪就像将ID分配过程应用于输出感知结果一样简单。跟踪过程中的生命周期管理由Sparse4Dv2中的top-k策略无缝处理,无需额外修改,具体可参考算法1。我们观察到,训练好的时序模型不需要使用跟踪约束进行微调,就已经表现出优异的跟踪特性。

实验分析对比

为了验证Sparse4Dv3的有效性,这里使用了nuScenes基准测试,它是一个包含1000个场景的数据集。训练、验证和测试分别包含700、150和150个场景。每个场景以2帧(FPS)的20秒视频剪辑为特征,并包括6个view图像。除了3D框标签外,该数据集还提供了有关车辆运动状态和摄像头参数的数据。对于检测性能评估,综合方法考虑了mAP、mATE、mASE、mAOE、mAVE、mAAE和NDS等指标,其中NDS表示其它指标的加权平均值。对于跟踪模型评估,关键指标包括AMOTA、AMOTP、召回和ID切换(IDS)。

nuScenes验证数据集上的3D检测结果:

nuScenes测试数据集上的3D检测结果:

nuscenes上多目标跟踪性能:

更多消融实验:

后续的一些方向

基于Sparse4D框架,还有相当大的进一步研究潜力:

- (1)我们进对目标跟踪任务进行初步尝试,跟踪性能还有很大的改进空间;

- (2) 将Sparse4D扩展为以激光雷达输入或多模态输入的模型是比较有前景的方向;

- (3) 在跟踪的基础上引入更多的下游任务(如预测和规划),进一步实现端到端感知;

- (4) 集成额外的感知任务,如在线地图和2D标志&红绿灯检测;

原文链接:https://mp.weixin.qq.com/s/ke7_QXm_F5iZwF_A_aw--A