今年大语言模型的快速发展导致像BERT这样的模型都可以称作“小”模型了。Kaggle LLM比赛LLM Science Exam 的第四名就只用了deberta,这可以说是一个非常好的成绩了。所以说在特定的领域或者需求中,大语言模型并不一定就是最优的解决方案,“小”模型也有一定的用武之地,所以今天我们来介绍PubMedBERT,它使用特定领域语料库从头开始预训练BERT,这是微软研究院2022年发布在ACM的论文。

论文的主要要点如下:

对于具有大量未标记文本的特定领域,如生物医学,从头开始预训练语言模型比持续预训练通用领域语言模型效果显著。提出了生物医学语言理解与推理基准(BLURB)用于特定领域的预训练。

PubMedBERT

1、特定领域Pretraining

研究表明,从头开始的特定领域预训练大大优于通用语言模型的持续预训练,从而表明支持混合领域预训练的主流假设并不总是适用。

2、模型

使用BERT。对于掩码语言模型(MLM),全词屏蔽(WWM)强制要求整个词必须被屏蔽。

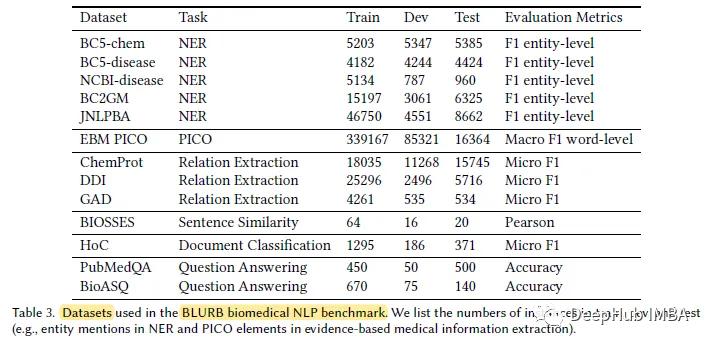

3、BLURB数据集

据作者介绍,BLUE[45]是在生物医学领域创建NLP基准的第一次尝试。但BLUE的覆盖范围有限。针对基于pubmed的生物医学应用,作者提出了生物医学语言理解与推理基准(BLURB)。

PubMedBERT使用更大的特定领域语料库(21GB)。

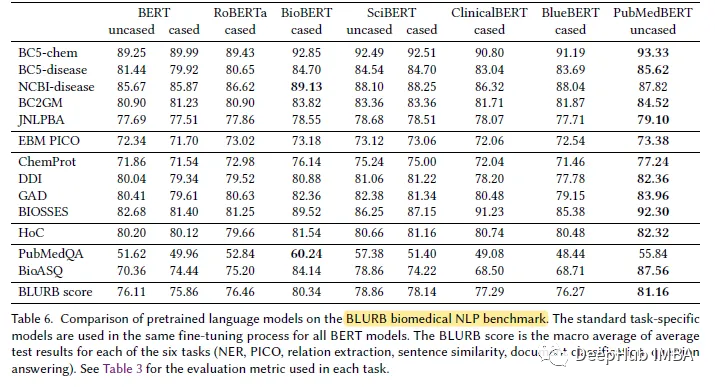

结果展示

在大多数生物医学NLP任务中,PubMedBERT始终优于所有其他BERT模型,并且通常具有显著的优势。