FastGPT

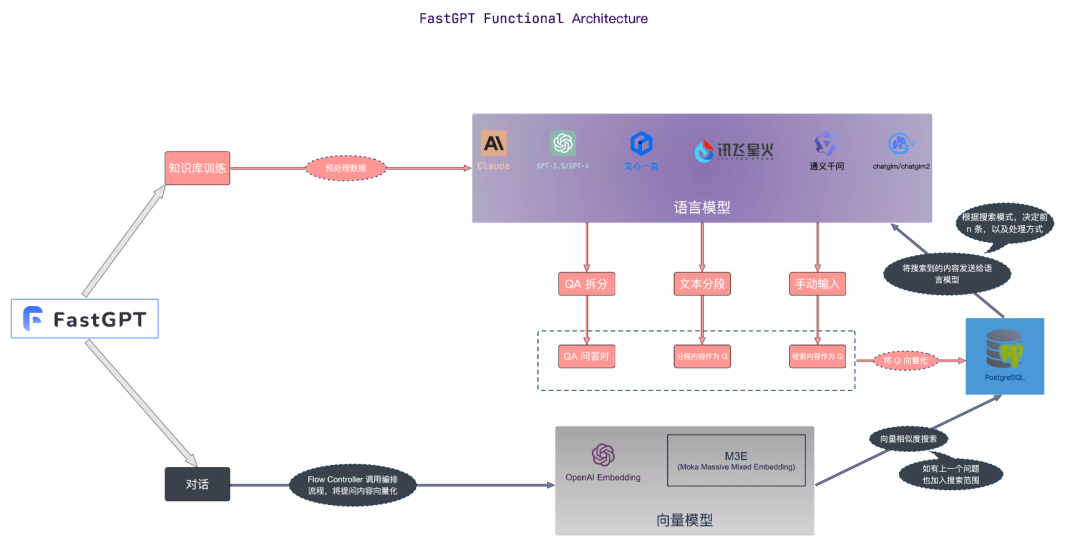

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!

知识库核心流程图

图片

图片

图片来源:https://doc.fastgpt.in

私有化部署

这里使用 Docker Compose 快速进行 FastGPT 私有化部署

1、安装 Docker

# 安装 Docker

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

systemctl enable --now docker

# 安装 docker-compose

curl -L https://github.com/docker/compose/releases/download/2.20.3/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

# 验证安装

docker -v

docker-compose -v- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

如果已经安装,直接跳过就是

2、容器编排

创建一个本地目录并且进入该目录

mkdir tinywan-fastgpt

cd tinywan-fastgpt- 1.

- 2.

以上创建目录路径为/d/Tinywan/GPT/tinywan-fastgpt

docker-compose.yml 配置文件

version: '3.3'

services:

pg:

image: registry.cn-hangzhou.aliyuncs.com/fastgpt/pgvector:v0.5.0 # 阿里云

container_name: pg

restart: always

ports: # 生产环境建议不要暴露

- 5432:5432

networks:

- fastgpt

environment:

# 这里的配置只有首次运行生效。修改后,重启镜像是不会生效的。需要把持久化数据删除再重启,才有效果

- POSTGRES_USER=username

- POSTGRES_PASSWORD=password

- POSTGRES_DB=postgres

volumes:

- ./pg/data:/var/lib/postgresql/data

mongo:

image: mongo:5.0.18

# image: registry.cn-hangzhou.aliyuncs.com/fastgpt/mongo:5.0.18 # 阿里云

container_name: mongo

restart: always

ports: # 生产环境建议不要暴露

- 27017:27017

networks:

- fastgpt

environment:

# 这里的配置只有首次运行生效。修改后,重启镜像是不会生效的。需要把持久化数据删除再重启,才有效果

- MONGO_INITDB_ROOT_USERNAME=username

- MONGO_INITDB_ROOT_PASSWORD=password

volumes:

- ./mongo/data:/data/db

fastgpt:

container_name: fastgpt

image: registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:latest # 阿里云

ports:

- 3000:3000

networks:

- fastgpt

depends_on:

- mongo

- pg

restart: always

environment:

# root 密码,用户名为: root

- DEFAULT_ROOT_PSW=123465

# 中转地址,如果是用官方号,不需要管

- OPENAI_BASE_URL=https://api.openai.com/v1

- CHAT_API_KEY=sb-xxx

- DB_MAX_LINK=5 # database max link

- TOKEN_KEY=any

- ROOT_KEY=root_key

- FILE_TOKEN_KEY=filetoken

# mongo 配置,不需要改. 如果连不上,可能需要去掉 ?authSource=admin

- MONGODB_URI=mongodb://username:password@mongo:27017/fastgpt?authSource=admin

# pg配置. 不需要改

- PG_URL=postgresql://username:password@pg:5432/postgres

volumes:

- ./config.json:/app/data/config.json

networks:

fastgpt:- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.

- 19.

- 20.

- 21.

- 22.

- 23.

- 24.

- 25.

- 26.

- 27.

- 28.

- 29.

- 30.

- 31.

- 32.

- 33.

- 34.

- 35.

- 36.

- 37.

- 38.

- 39.

- 40.

- 41.

- 42.

- 43.

- 44.

- 45.

- 46.

- 47.

- 48.

- 49.

- 50.

- 51.

- 52.

- 53.

- 54.

- 55.

- 56.

- 57.

- 58.

- 59.

- 60.

- 61.

注:请填写CHAT_API_KEY对应的值。

config.json 配置文件

{

"SystemParams": {

"pluginBaseUrl": "",

"vectorMaxProcess": 15,

"qaMaxProcess": 15,

"pgHNSWEfSearch": 100

},

"ChatModels": [

{

"model": "gpt-3.5-turbo-1106",

"name": "GPT35-1106",

"price": 0,

"maxContext": 16000,

"maxResponse": 4000,

"quoteMaxToken": 2000,

"maxTemperature": 1.2,

"censor": false,

"vision": false,

"defaultSystemChatPrompt": ""

},

{

"model": "gpt-3.5-turbo-16k",

"name": "GPT35-16k",

"maxContext": 16000,

"maxResponse": 16000,

"price": 0,

"quoteMaxToken": 8000,

"maxTemperature": 1.2,

"censor": false,

"vision": false,

"defaultSystemChatPrompt": ""

},

{

"model": "gpt-4",

"name": "GPT4-8k",

"maxContext": 8000,

"maxResponse": 8000,

"price": 0,

"quoteMaxToken": 4000,

"maxTemperature": 1.2,

"censor": false,

"vision": false,

"defaultSystemChatPrompt": ""

},

{

"model": "gpt-4-vision-preview",

"name": "GPT4-Vision",

"maxContext": 128000,

"maxResponse": 4000,

"price": 0,

"quoteMaxToken": 100000,

"maxTemperature": 1.2,

"censor": false,

"vision": true,

"defaultSystemChatPrompt": ""

}

],

"QAModels": [

{

"model": "gpt-3.5-turbo-16k",

"name": "GPT35-16k",

"maxContext": 16000,

"maxResponse": 16000,

"price": 0

}

],

"CQModels": [

{

"model": "gpt-3.5-turbo-1106",

"name": "GPT35-1106",

"maxContext": 16000,

"maxResponse": 4000,

"price": 0,

"functionCall": true,

"functionPrompt": ""

},

{

"model": "gpt-4",

"name": "GPT4-8k",

"maxContext": 8000,

"maxResponse": 8000,

"price": 0,

"functionCall": true,

"functionPrompt": ""

}

],

"ExtractModels": [

{

"model": "gpt-3.5-turbo-1106",

"name": "GPT35-1106",

"maxContext": 16000,

"maxResponse": 4000,

"price": 0,

"functionCall": true,

"functionPrompt": ""

}

],

"QGModels": [

{

"model": "gpt-3.5-turbo-1106",

"name": "GPT35-1106",

"maxContext": 1600,

"maxResponse": 4000,

"price": 0

}

],

"VectorModels": [

{

"model": "text-embedding-ada-002",

"name": "Embedding-2",

"price": 0.2,

"defaultToken": 700,

"maxToken": 3000

}

],

"AudioSpeechModels": [

{

"model": "tts-1",

"name": "OpenAI TTS1",

"price": 0,

"voices": [

{

"label": "Alloy",

"value": "alloy",

"bufferId": "openai-Alloy"

},

{

"label": "Echo",

"value": "echo",

"bufferId": "openai-Echo"

},

{

"label": "Fable",

"value": "fable",

"bufferId": "openai-Fable"

},

{

"label": "Onyx",

"value": "onyx",

"bufferId": "openai-Onyx"

},

{

"label": "Nova",

"value": "nova",

"bufferId": "openai-Nova"

},

{

"label": "Shimmer",

"value": "shimmer",

"bufferId": "openai-Shimmer"

}

]

}

],

"WhisperModel": {

"model": "whisper-1",

"name": "Whisper1",

"price": 0

}

}- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.

- 19.

- 20.

- 21.

- 22.

- 23.

- 24.

- 25.

- 26.

- 27.

- 28.

- 29.

- 30.

- 31.

- 32.

- 33.

- 34.

- 35.

- 36.

- 37.

- 38.

- 39.

- 40.

- 41.

- 42.

- 43.

- 44.

- 45.

- 46.

- 47.

- 48.

- 49.

- 50.

- 51.

- 52.

- 53.

- 54.

- 55.

- 56.

- 57.

- 58.

- 59.

- 60.

- 61.

- 62.

- 63.

- 64.

- 65.

- 66.

- 67.

- 68.

- 69.

- 70.

- 71.

- 72.

- 73.

- 74.

- 75.

- 76.

- 77.

- 78.

- 79.

- 80.

- 81.

- 82.

- 83.

- 84.

- 85.

- 86.

- 87.

- 88.

- 89.

- 90.

- 91.

- 92.

- 93.

- 94.

- 95.

- 96.

- 97.

- 98.

- 99.

- 100.

- 101.

- 102.

- 103.

- 104.

- 105.

- 106.

- 107.

- 108.

- 109.

- 110.

- 111.

- 112.

- 113.

- 114.

- 115.

- 116.

- 117.

- 118.

- 119.

- 120.

- 121.

- 122.

- 123.

- 124.

- 125.

- 126.

- 127.

- 128.

- 129.

- 130.

- 131.

- 132.

- 133.

- 134.

- 135.

- 136.

- 137.

- 138.

- 139.

- 140.

- 141.

- 142.

- 143.

- 144.

- 145.

- 146.

- 147.

- 148.

- 149.

- 150.

- 151.

- 152.

- 153.

- 154.

- 155.

- 156.

- 157.

- 158.

- 159.

- 160.

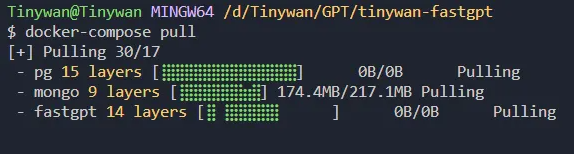

3、启动容器

通过命令docker-compose pull 获取更新版本的镜像

图片

图片

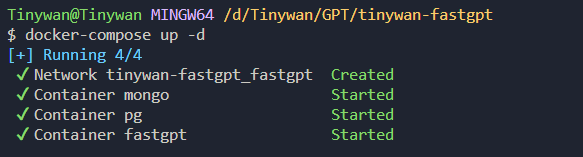

通过命令docker-compose up -d 启动容器

图片

图片

查看容器启动情况

图片

图片

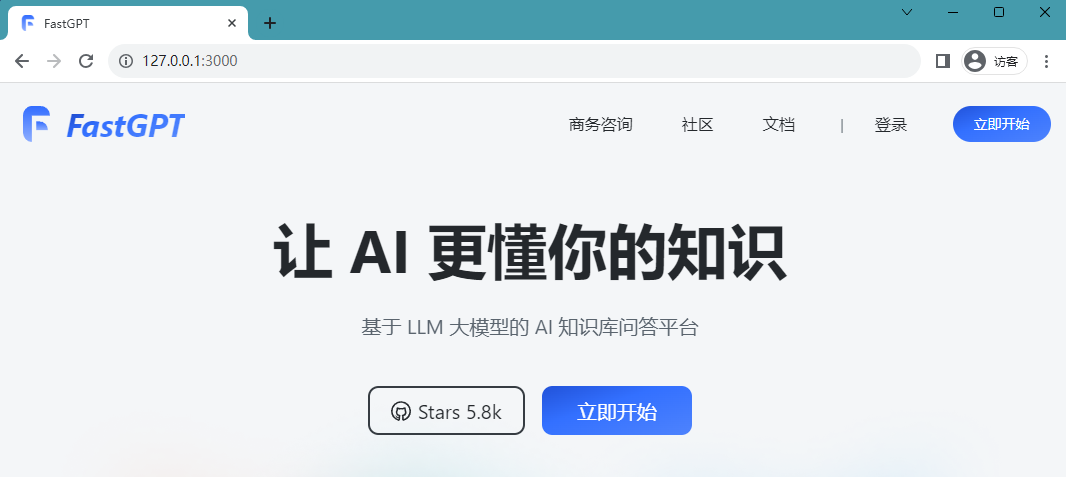

4、访问 FastGPT

目前可以通过 ip:3000 直接访问。这里是本地部署,所以直接通过 http://127.0.0.1:3000 直接访问即可。

部署成功访问页面如下所示

图片

图片

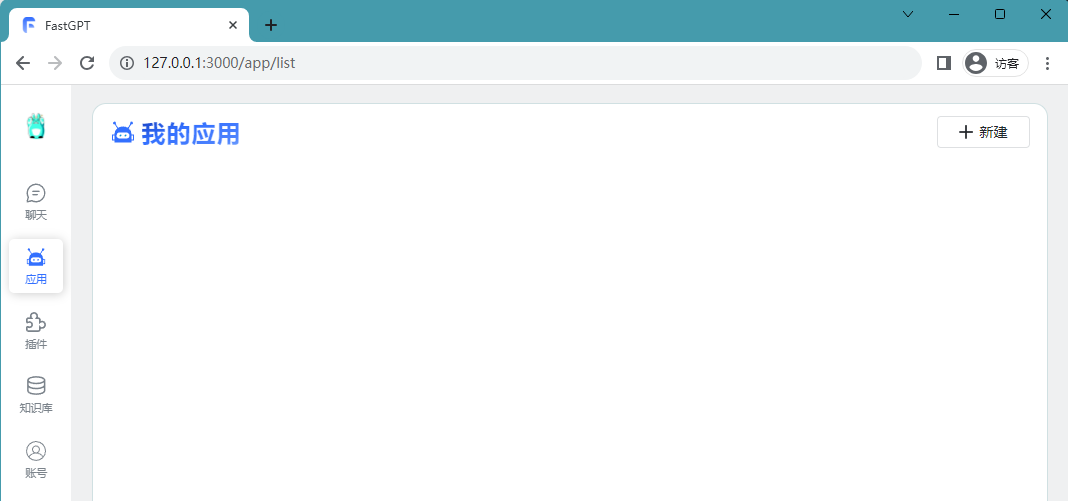

登录用户名为 root,密码为docker-compose.yml环境变量里设置的 DEFAULT_ROOT_PSW。

登录成功访问页面如下所示

图片

图片

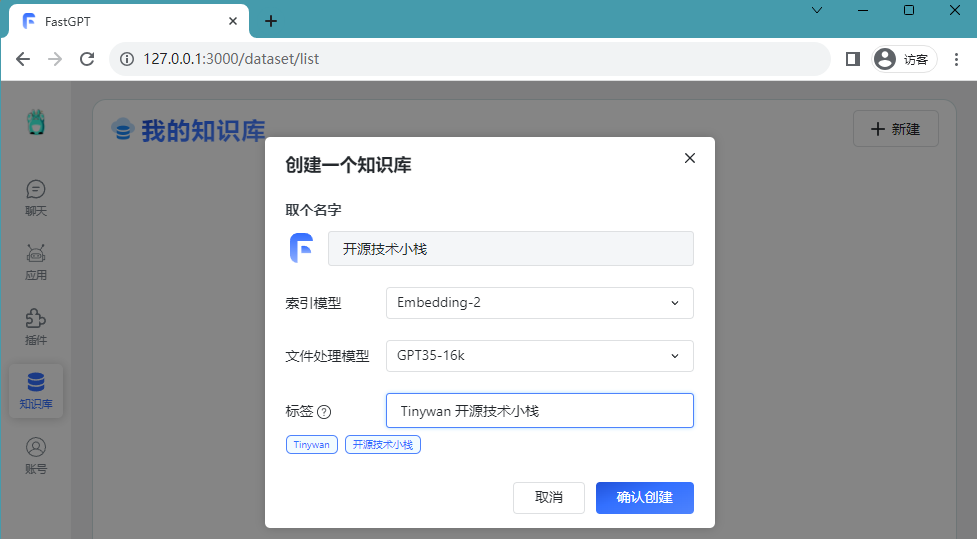

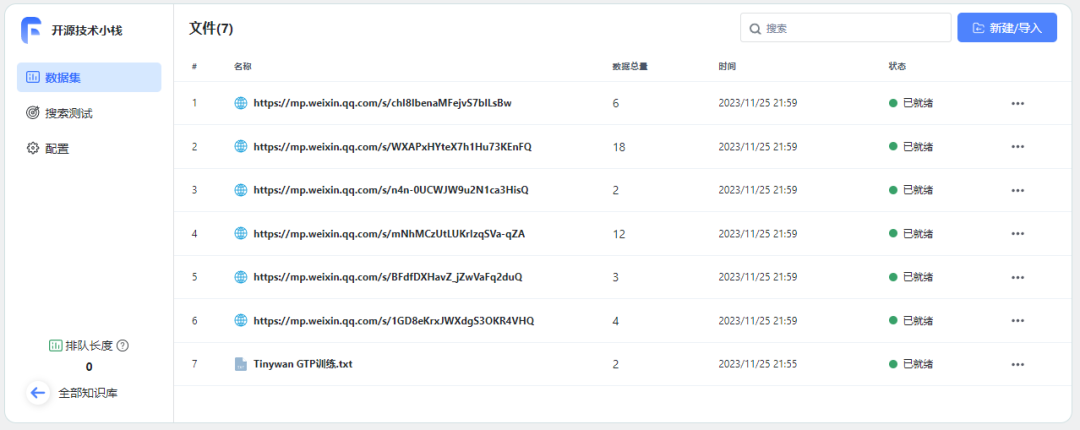

构建知识库

创建知识库

成功登录后,新建一个知识库,取名开源技术小栈。

图片

图片

通过文件将个人经历导入到知识库中

【新建/导入】【文件导入】

图片

图片

确认后就开始将当前数据转化为向量数据

图片

图片

选择文件导入时,可以选择直接分段方案。直接分段会利用句子分词器对文本进行一定长度拆分,最终分割中多组的q。如果使用了直接分段方案,我们建议在应用设置引用提示词时,使用通用模板即可,无需选择问答模板。

导入成功

图片

图片

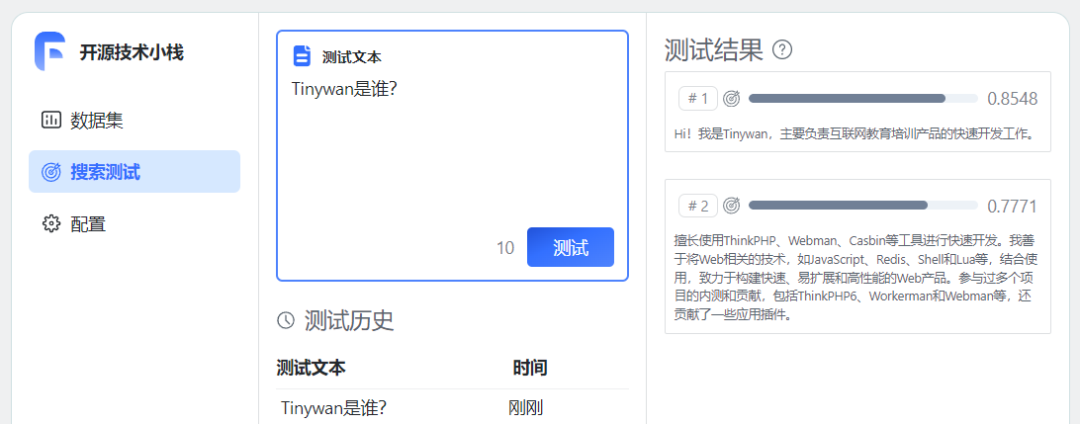

至此,个人知识库已经建好了。尝试进行测试问答

图片

图片

链接训练数据

https://mp.weixin.qq.com/s/1GD8eKrxJWXdgS3OKR4VHQ

https://mp.weixin.qq.com/s/BFdfDXHavZ_jZwVaFq2duQ

https://mp.weixin.qq.com/s/mNhMCzUtLUKrIzqSVa-qZA

https://mp.weixin.qq.com/s/n4n-0UCWJW9u2N1ca3HisQ

https://mp.weixin.qq.com/s/WXAPxHYteX7h1Hu73KEnFQ

https://mp.weixin.qq.com/s/chI8IbenaMFejvS7blLsBw- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

图片

图片

等待所有数据准备就绪

图片

图片

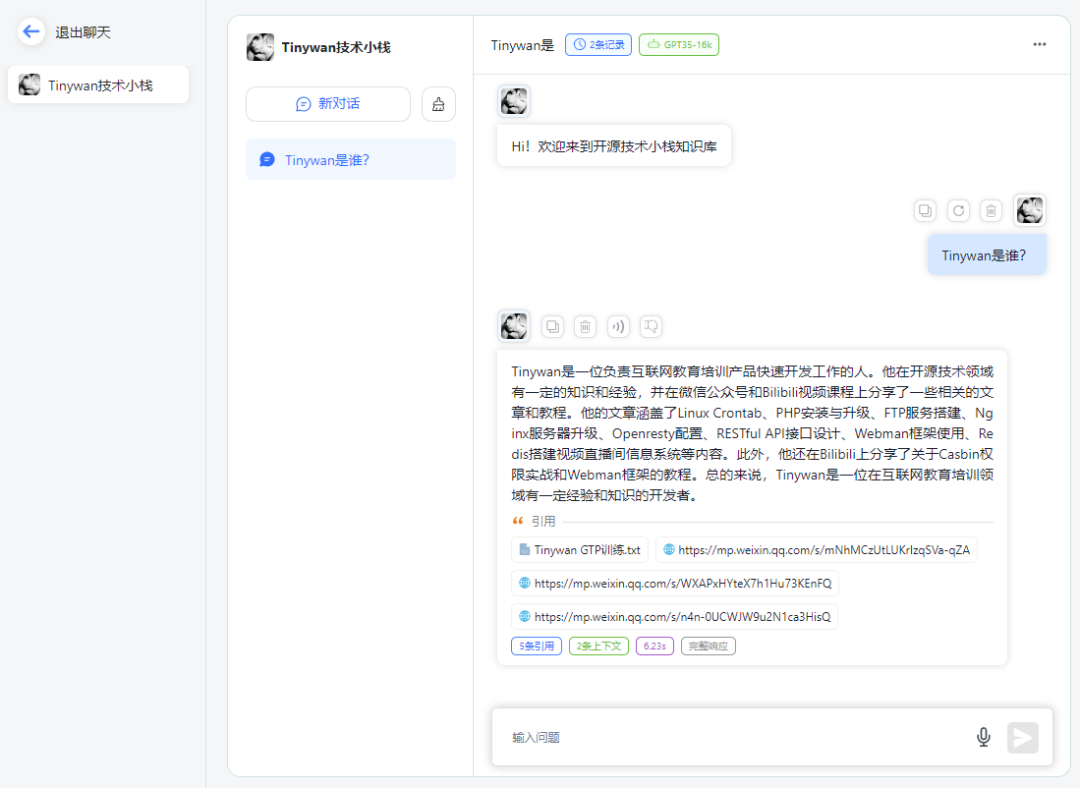

使用知识库

创建应用

使用知识库必须要创建一个应用

图片

图片

关联知识库

设置了开场白并且选择绑定对应知识库开源技术小栈

图片

图片

点击保存预留后,可以直接在右边调试预览框预览对话进行文档内容测试。

开始对话

图片

图片

图片

图片

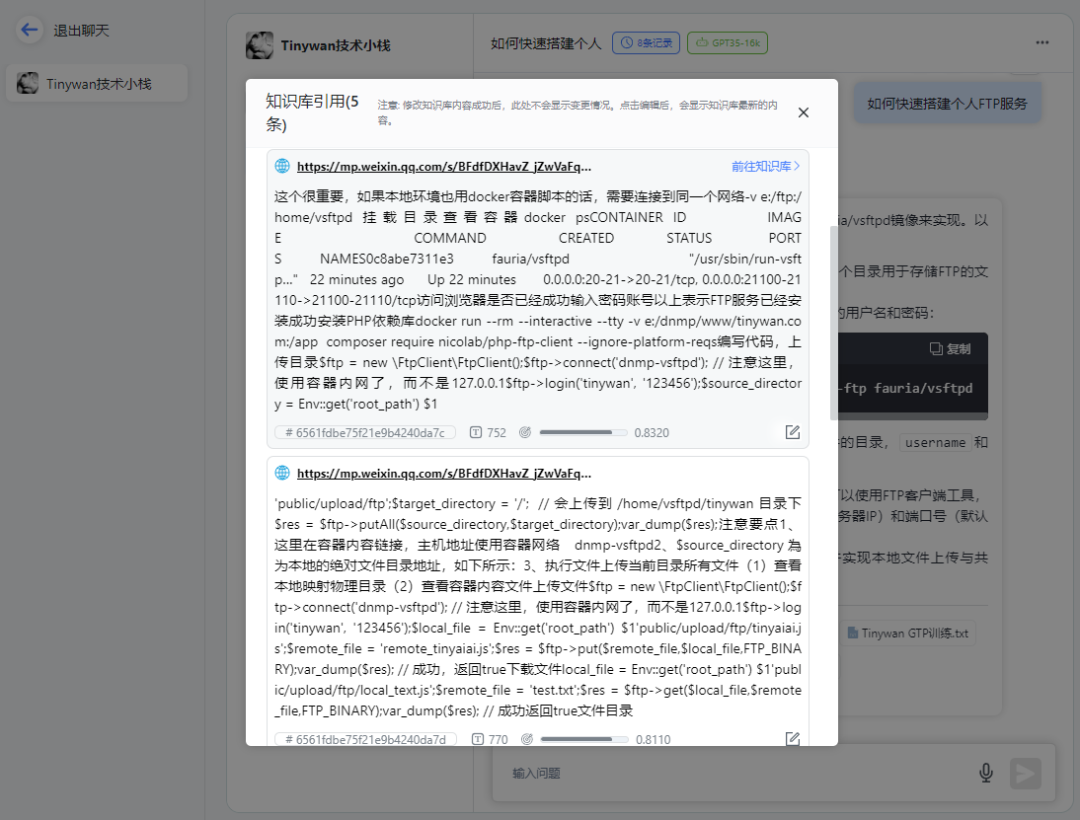

点击链接查看知识库引用

图片

图片

打开对应链接可以直接跳转到微信公众号文章地址

总结

构建私有数据训练服务,针对问题提供精准回答。可以通过AI服务训练自有数据,形成AI知识库,然后创建不同的机器人针对用户问题提供精准回答。并且可以通过API接口很方便整合到自己的产品服务中。