在人工智能领域,计算机视觉的两大巨头是CLIP和DINOv2。CLIP改变了图像理解的方式,而DINOv2为自监督学习带来了新的方法。在本文中,我们将探索定义CLIP和DINOv2的强项和微妙之处的旅程。我们旨在发现这些模型中哪一个在图像相似度任务的世界中真正出色。让我们见证这两位巨头的较量,看看哪个模型胜出。

CLIP中的图像相似度

使用CLIP计算两个图像之间的相似度是一个简单的过程,只需要两个步骤:首先提取两个图像的特征,然后计算它们的余弦相似度。

首先,确保已安装所需的软件包。建议设置和使用虚拟环境:

接下来,继续计算图像相似度:

2张相似的图像

使用两张相似图像的示例,获得的相似度得分为令人印象深刻的96.4%。

DINOv2中的图像相似度

使用DINOv2计算两张图像之间的相似度的过程与CLIP类似。需要同一组软件包,无需进行任何额外的安装:

与CLIP示例中的相同图像对一起使用,使用DINOv2获得的相似度得分为93%。

使用COCO数据集进行测试

在深入评估它们的性能之前,让我们使用COCO数据集的验证集中的图像来比较CLIP和DINOv2的结果。我们采用的流程如下:

- 遍历数据集以提取所有图像的特征。

- 将嵌入存储在FAISS索引中。

- 提取输入图像的特征。

- 检索相似度最高的三张图像。

对于那些对FAISS深入了解的人,请参考这篇充满信息的文章。确保首先使用以下命令安装它:pip install faiss-[gpu|cpu]。

第1部分:特征提取和创建2个索引:

第2部分:图像相似度搜索:

结果

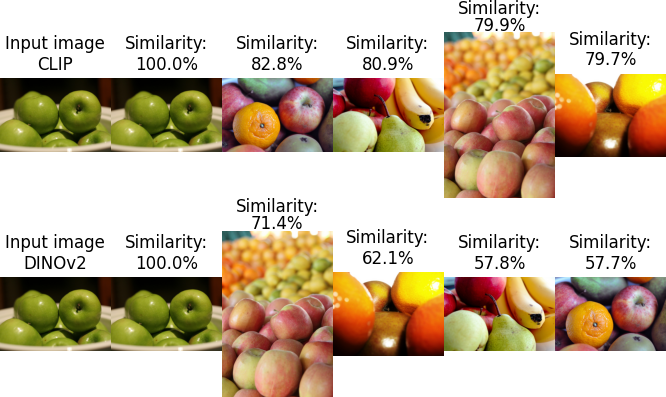

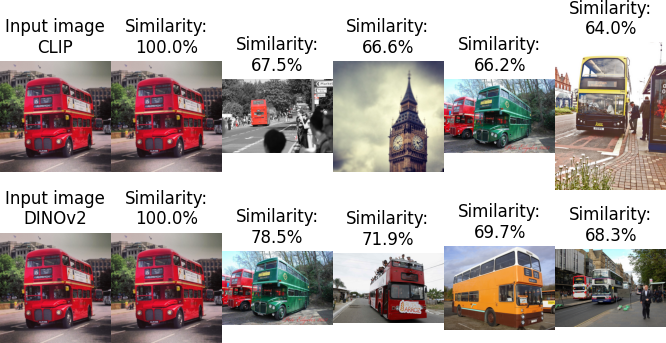

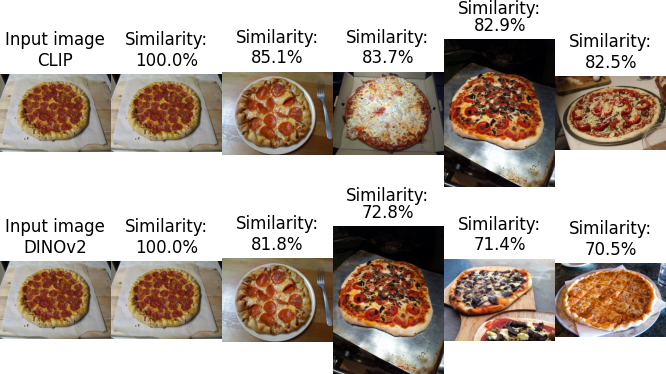

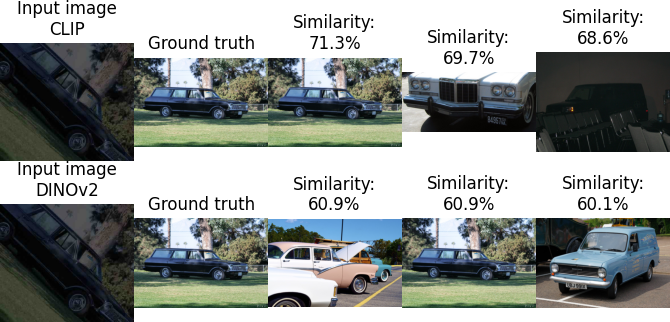

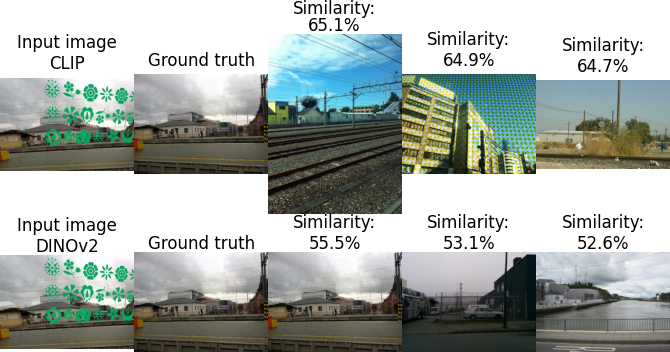

使用四个不同的图像作为输入,搜索产生了以下结果:

CLIP与DINOv2

在这个小子集中,似乎DINOv2展现出了略微卓越的性能。

针对DISC21数据集的基准测试

为了比较它们的性能,我们将遵循与此故事中描述的相同方法:https://medium.com/aimonks/image-similarity-with-dinov2-and-faiss-741744bc5804。我们还将重复上面的脚本,以提取特征,然后计算图像相似度。

数据集

为了对比CLIP和DINOv2,我们选择了DISC21数据集,这个数据集是专门为图像相似性搜索创建的。由于其巨大的大小为350GB,我们将使用150,000张图像的子集。

所使用的度量标准

在度量方面,我们将计算以下内容:

- 准确率:正确预测的图像数量与总图像数量的比率。

- 前三准确率:正确图像在前三个相似图像中找到的次数与总图像数量的比率。

- 计算时间:处理整个数据集所需的时间。

基准测试结果

(1) 特征提取

- CLIP:每秒处理70.7张图像

- DINOv2:每秒处理69.7张图像

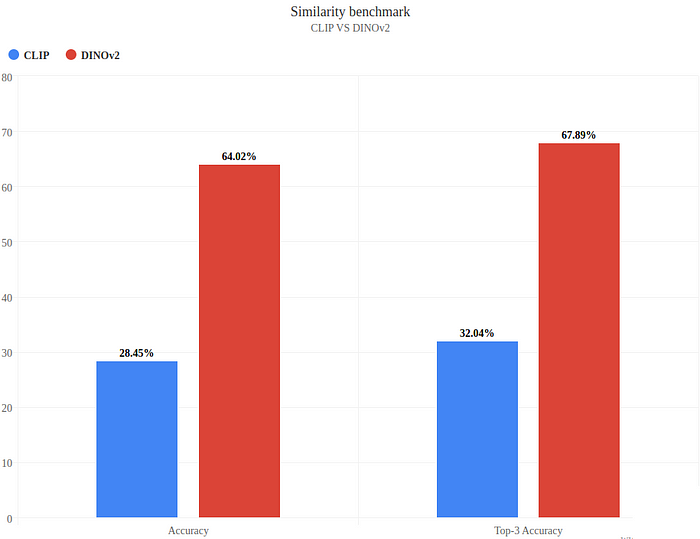

(2) 准确度和前三准确度

准确度和前三准确度

(3) 分析结果

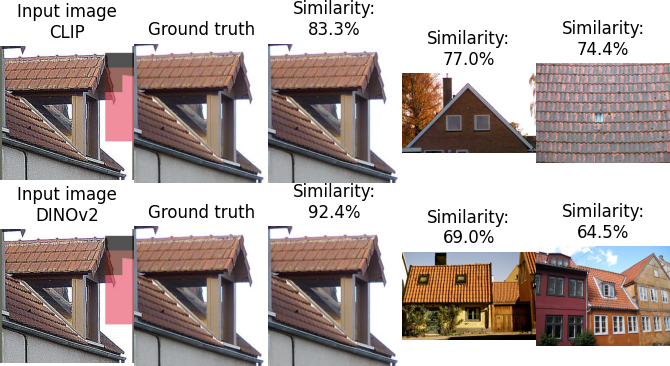

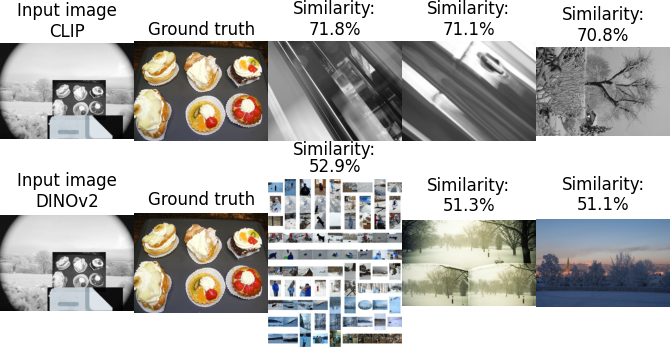

两个模型都正确预测了图像:

所有模型都未能找到正确的图像:

只有CLIP正确预测了图像,DINOv2在前三个中预测了它:

只有DINOv2正确预测了图像:

分析

DINOv2表现出明显的领先地位,实现了在一个明显具有挑战性的数据集上达到64%的令人印象深刻的准确率。相比之下,CLIP展现了更为适度的准确度,达到了28.45%。

就计算效率而言,两个模型表现出非常相似的特征提取时间。这种平衡在这方面没有让任何一个模型处于明显的优势地位。

限制

虽然这个基准测试提供了有价值的见解,但必须认识到它的限制。评估是在1448张图像的子集上进行的,与150,000张图像的池进行了比较。鉴于整个数据集的规模为2.1百万张图像,狭窄的焦点对于保存资源是必要的。

值得注意的是,MetaAI将DISC21数据集用作其模型的基准,这可能给DINOv2带来了有利的优势。然而,我们在COCO数据集上的测试揭示了有趣的细节:DINOv2显示出了在图像中识别主要元素的增强能力,而CLIP则表现出了在输入图像中关注特定细节的能力(如公交车图像所示)。

最后,必须考虑CLIP和DINOv2之间嵌入维度的差异。CLIP使用512的嵌入维度,而DINOv2使用768。虽然另一种选择是使用嵌入维度匹配的更大的CLIP模型,但值得注意的是,这将以速度为代价。在一个小子集上进行的快速测试显示了轻微的性能提升,但没有达到DINOv2所展示的性能水平。