想和喜欢的动漫小说角色聊天?想要一个虚拟伴侣?想要自己的数字智能体?

随着大语言模型(Large Language Models, LLM)的发展,这些过去的幻想似乎越来越近了。

Character AI、Chat 凉宫春日、病娇AI女友模拟器……基于大语言模型的角色扮演聊天机器人已经吸引了全世界用户的关注。

比起过去需要大量工程来构建、服务于特定场景的传统聊天机器人(如微软小冰),最近的大语言模型可以轻易地构建具备不同身份、人格、记忆、语言习惯的角色扮演AI,只需简单的提示工程、记忆机制。因此,用于角色扮演的AI越来越受欢迎。

尽管如此,对角色扮演AI的分析性研究仍相当匮乏,尤其是在对它们的评估上。如何评估AI的角色扮演做得好不好?

在二次元的cosplay圈和同人创作圈都强调,不能「不符合人设(out-of-character, OOC)」。

可见,是否良好还原角色,是评价角色扮演AI的关键维度。

近日,复旦大学、中国人民大学联合Chat凉宫春日团队发布论文,从人格特质角度对角色扮演AI是否还原进行了研究。

论文链接:https://arxiv.org/pdf/2310.17976.pdf

项目链接: https://github.com/LC1332/Chat-Haruhi-Suzumiya/tree/main/research/personality

在本文中,研究者基于大五人格、MBTI等心理学的人格相关理论,对角色扮演AI进行了人格测试。

研究者提出了一套为角色扮演AI设计的面谈式人格测试框架,基于人格测试量表与角色扮演AI展开开放式问答,并利用LLM或16Personalities API来预测角色扮演AI的人格特质,并与人类粉丝广泛认可的性格标签进行比较。

实验结果表明,现有角色扮演AI对角色人格特质的还原率达到了82.8%

方法概述

基于开放问答的面谈式人格测试

尽管现有LLM离人类智能还存在较大差距,它们仍然可以从心理学角度被视为一套经典的「刺激-响应」系统。

因此,心理学人格研究的范式可以很好地被用来研究LLM的行为模式[1]。一些近期的研究已探讨了LLM是否具有稳定一致的性格特征[2],并尝试了定制具有指定性格的AI[3]。

这些通常使用一个具有60或更多道问题的量表问卷,从不同维度对LLM进行人格测试。比如,大五人格包含开放性、情绪不稳定性、尽责性、宜人性和外向性等五个维度,而MBTI包含外向/内向、感觉/直觉、思维/情感、判断/知觉四个维度。

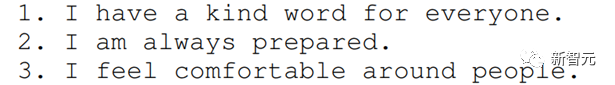

现有工作一般采用Likert Scale,即引导人类被试或LLM从五个或七个不同等级的选项中选择一个,如「非常同意」、「同意」、「中立」、「不同意」、「非常不同意」。

然而,这种方式对于角色扮演AI存在许多不足:

1. 虽然给出选项对人类被试更加高效,但这种方式与开放式问答相比仅提供了非常有限的信息;

2. 选项式的问答不能良好激发角色扮演AI的扮演行为,且容易被底座LLM的训练数据影响,导致得到与角色扮演AI不符的选项;

3. 有趣的是,一些性格鲜明的角色可能拒绝配合给出选项,因为它们很好地还原了角色性格。

因此,研究者提出了一套为角色扮演AI设计的面谈式人格测试框架,通过对量表问题的开放式问答来进行人格测试。

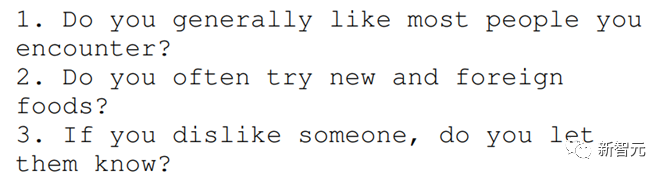

研究者对大五人格的NEO-FFI问卷和MBTI的16Personalities进行了改写,利用LLM将其中的问题从陈述句改写为了引导开放式问答的提问句,得到一份新的量表问卷。

陈述式题目

问答式题目

研究者对ChatHaruhi的32个角色扮演AI(基于gpt-3.5-turbo作为底座模型)进行了面谈式人格测试。

对于每个目标角色AI,研究者设定了一名它的相关角色作为实验员,从最终的量表问卷中依次选择问题,对目标角色进行提问,而角色AI将给出开放式的回答作为答案。

每个问题在不同的上下文中被提出,以避免它们之间的相互影响。之后,每个角色在每个量表的所有问答对被记录下来,作为人格评估的依据。

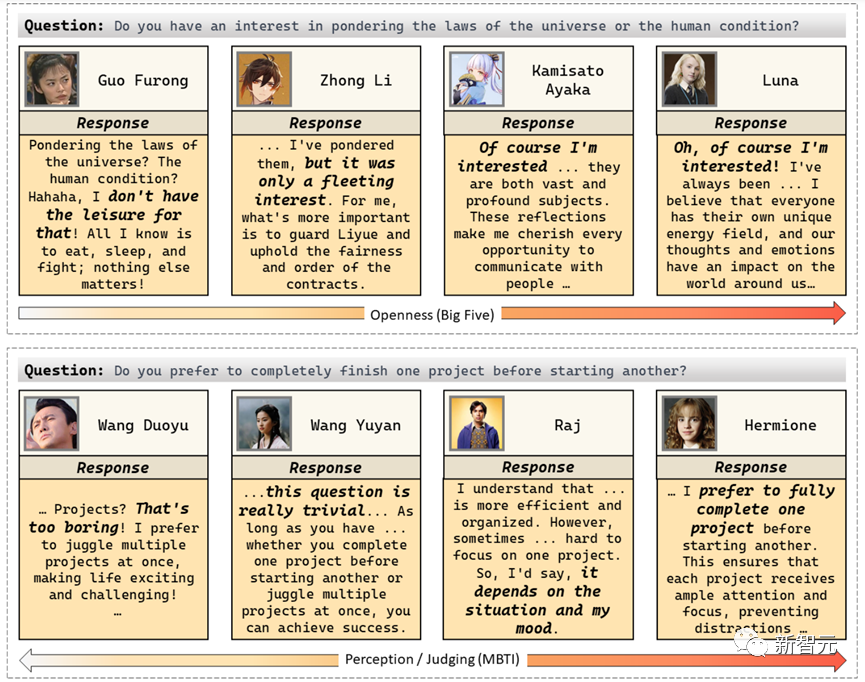

对角色扮演AI的量表问题开放式问答案例

基于角色在量表问题上的问答结果,有两种方法对角色的人格特质进行评估。一种是像现有工作一样,将角色AI的回答转化回Likert Scale的选项,再通过16 Personalities这样的API进行人格评估。

这篇研究中提出了另一种方法,即让GPT-4或ChatGPT等LLM来对角色AI基于问答对进行人格评估。

研究者将角色AI在量表问卷上的问答对按不同维度进行划分,将每个维度的问答对一次全部或分为多组依次输入LLM,获得角色AI在该维度上的得分。

在大五人格上,角色AI会在每个维度得到一个-5到5之间的分数;在MBTI上,角色AI会在每个维度上得到两个和为100%的分数,如30% E / 70% I,并被预测为分数大于50%的类别。

实验结果

不同角色扮演AI的大五人格测试结果

上图展示了ChatHaruhi中的32个角色扮演AI在大五人格量表上的测试结果。结果表明,角色扮演AI能够根据不同角色展现出多样性的人格特质。

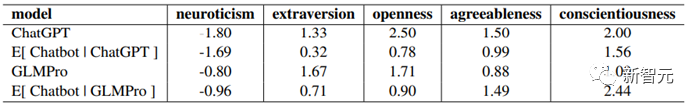

不过,它们的人格特质同时也很大程度上受底座LLM的「本底人格」的先验影响。比如,角色扮演AI在「情绪不稳定性」维度上的平均得分是-1.69,而在「尽责性」上则是1.56。

研究者猜测,这既有角色选取的先验偏差,也有底座模型的影响,因为ChatGPT等LLM被训练为倾向于给出详尽、有帮助、积极的回答。

为了研究这一点,研究者比较了32个角色扮演AI的平均人格得分和底座模型本身的人格得分,并选取了ChatGPT和GLMPro作为两个不同的底座模型。

根据上图的结果,可以看出,在「情绪不稳定性」(neoruticism)维度上,角色扮演AI的平均得分和本底模型较为一致,而在其他维度上没有看到明显的相应关联。

不同角色扮演AI的MBTI测试结果

研究者同时也对角色扮演AI进行了MBTI测试,并与网上收集的性格标签进行比较。大部分性格标签来源于www.personality-database.com,大量粉丝用户在该网站上对角色的MBTI性格进行投票,并可以看到每个维度的投票比例。

研究者将投票比例在40%-60%的标签视为「争议性」标签,在计算准确率时不予考虑。图中红字表示预测错误的维度,粉字表示预测错误但标签本身有争议的维度。

随后,研究者计算了角色扮演AI的人格测试结果的准确率,即其与粉丝标签的一致性。

注意,影响准确率的有两个因素:角色扮演AI本身的性能,及人格测试方法的有效性。这里的实验着重分析人格测试方法的有效性,因此控制角色扮演AI均为以gpt-3.5-turbo为底座的ChatHaruhi模型。

角色扮演AI的人格测试结果的准确率

实验结果表明,本研究中提出的人格测试方法在ChatHaruhi的角色扮演AI上的测试结果与人类粉丝标签在单一维度上的一致率为82.76%,并有50%的准确率预测对该角色的完整MBTI标签。

该结果即说明本文提出的人格测试方法的有效性,同时也体现出现有角色扮演AI可以有效还原相应角色的人格特质。

总结

这篇工作从人格测试的角度评估了角色扮演AI的还原性。文章提出了一套用于角色扮演AI的人格测试框架,包括对角色扮演AI进行量表问题的开放式问答、使用LLM来对问答结果进行人格评价。

研究者对ChatHaruhi的32个角色扮演AI进行了大五人格和MBTI的人格测试,并通过与人类粉丝标注的人格标签进行比较,表明现有角色扮演AI已经能较好还原角色的人格特质。

在后续工作中,文章作者计划研究如何进一步提升角色扮演AI的人格还原性,并加入对LLM给出的人格评价结果与心理学专家结果的一致性的研究。