整理丨诺亚、小欧

出品 | 51CTO技术栈(微信号:blog51cto)

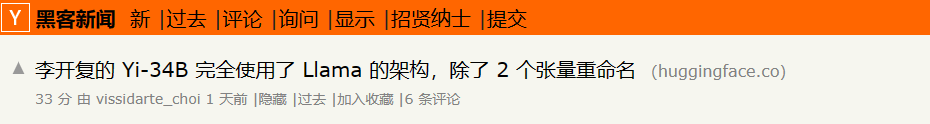

昨天科技圈社区Hacker News突然出现一则消息,矛头直指不久前发布的大模型Yi-34B,认为其除了两个张量被重新命名外,完全使用了Llama的架构。

图片

图片

而根据公开信息,Yi 系列开源大模型没有在开源 License 中提及Llama。虽然原贴评论寥寥,但还是引起了部分关注。毕竟“Yi”才发布不久,而且备受期待。

今年3月,李开复在朋友圈发英雄帖,官宣组建零一万物团队。仅仅7个月后,零一万物就发布了开源中英双语大模型“Yi”。据有关资料显示,在获得创新工场、阿里云和其他未披露投资者的融资后,零一万物的估值已超过10亿美元。

更令人瞩目的是,据零一万物官方介绍,Yi-34B不仅以黑马之姿取得了多项SOTA 国际最佳性能指标认可,而且成为了迄今为止唯一成功登顶 Hugging Face 全球开源模型排行榜的国产模型。

因此,无论是圈内还是圈外,都在关注:“Yi”如何面对这一质疑,后续会有何回应。

1、一篇帖子引发的疑云:社区质疑、贾扬清疑似暗讽

事件的肇因是一篇发布于Hugging Face的帖子。

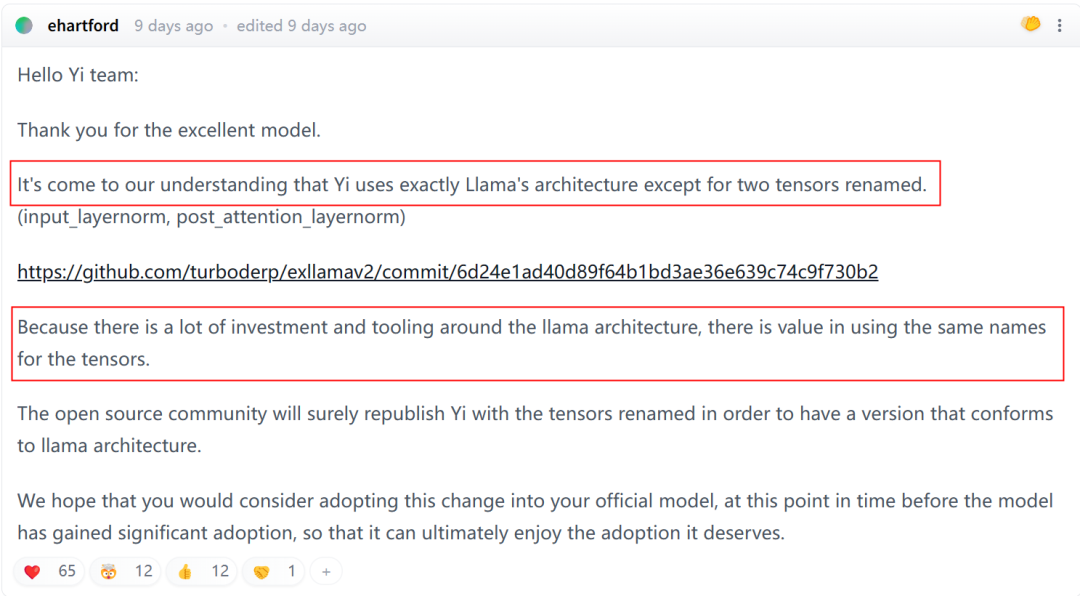

一位署名为ehartford的开发者于9天前在社区留言。他首先指出,据其了解,Yi 使用的正是 Llama 的架构,除了重新命名了两个张量(input_layernorm,post_attention_layernorm)。

更重要的是,由于围绕 Llama 架构有大量的投资和工具,因此对张量使用相同的名称是有价值的。因此他希望,在该模型获得大量采用之前,开源社区重新发布Yi,并“重新命名张量,以便有一个符合Llama架构的版本”。

图片

图片

下面有跟帖的开发者也指出:如果他们确实采用了Meta LlaMA 结构、其代码库和所有相关资源,就需要遵守LLaMA规定的许可协议。要求以 LlaMA 形式正式发布 Yi 模型是有问题的,因为它破坏了 Yi 许可条款的可执行性。

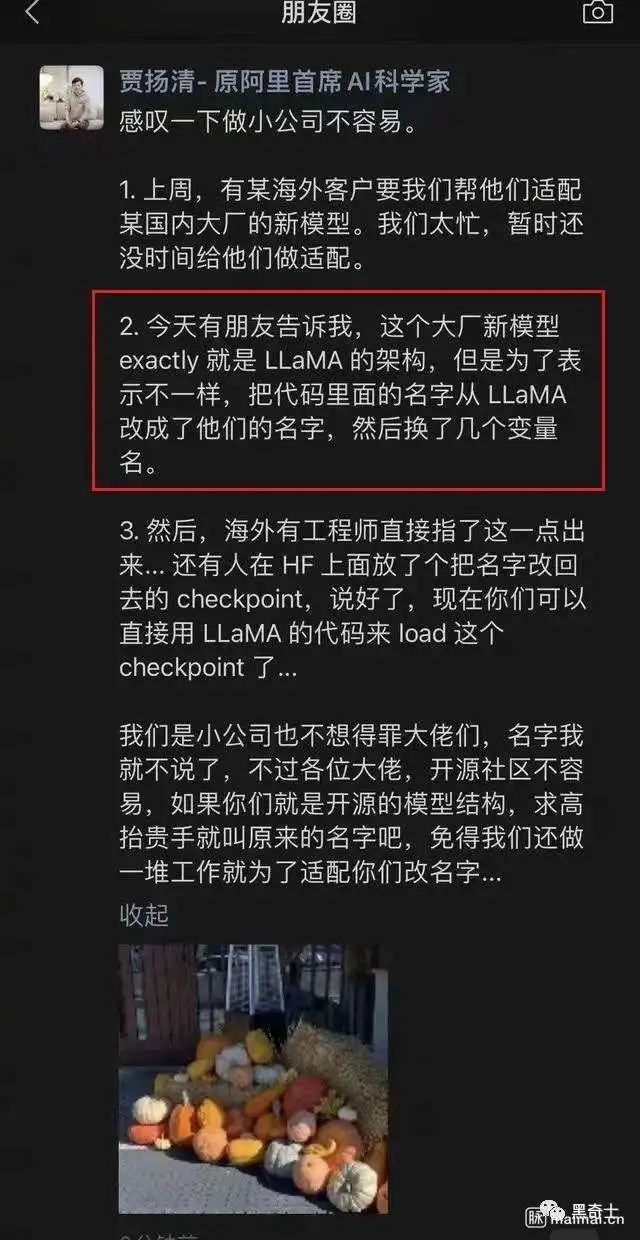

随后又有热心网友挖出了前阿里VP贾扬清在朋友圈发的一张图,直言某国产大模型实际上是抄袭的LlaMA,为表示不一样就更换了几个变量名。甚至还犀利讽刺道:如果是开源的模型架构,就不要改名字了,“免得我们还做一堆工作就为了适配你们改名字”。虽然贾扬清没有指名道姓,但有留意此事的人不免“对号入座”。

图片

图片

2、首次针对性回应:命名问题是团队疏忽

对于此番争议,零一万物随后给出了自身的回应。

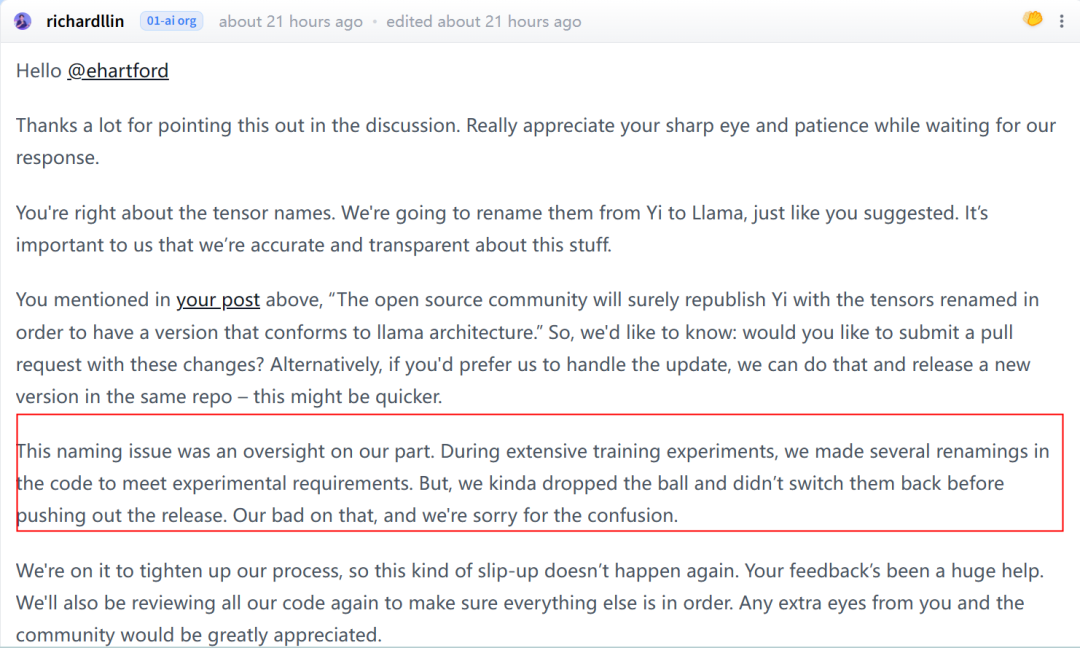

就在昨天,其团队开源总监 Richard Lin 在Hugging Face社区原贴之下指出“命名问题是团队的疏忽,在大量训练实验中,我们对代码进行了多次重命名以满足实验要求。但在发布正式版本之前,我们没能将它们切换回来。对此我们深感抱歉,由此造成的混乱我们也深表歉意”。

图片

图片

Richard Lin向原贴主承认修改张量名称的做法不妥,“您对张量名称的看法是正确的,我们将按照您的建议将其从 Yi 重命名为 Llama。我们也非常重视以准确、透明的方式完成工作。”

与此同时,他也给出了解决方案:要么邀请这名发现问题的开发者提交一条包含这些变更的拉取请求,要么由他们团队处理更新按要求操作并在同一个 repo 中发布新版本,从而完成对 Yi 的张量名称进行重命名以符合 Llama 架构。

最后Richard Lin重申,他们会努力改进工作流程,确保不会再次发生类似的失误,“接下来我们将再次检查所有代码,确保其余部分准确无误”。

3、再次公开回应:大模型核心突破点不仅在于架构,而是在于训练得到的参数

有人说,LLaMa本就是开源的模型,使用LLaMa的架构是正常的大模型训练步骤。而且国内已发布的开源模型也绝大多数采用渐成行业标准的 GPT/LLaMA 的架构。要训练出好的模型,除了架构之外,更需要好的训练数据和对训练方法和具体参数的精准把控。

正如零一万物在今天下午发布的公告所表达的:大模型持续发展与寻求突破口的核心点不仅在于架构,而是在于训练得到的参数。

图片

图片

全文核心观点可总结如下:

- 国内开源模型绝大多数采用 GPT/LLaMA 的架构,大模型持续发展与寻求突破口的核心点不仅在于架构,而是在于训练得到的参数。

- 零一万物团队完成了很多科学训模的系统性工作,比起基本模型结构能起到巨大的作用跟价值。

- 零一万物团队投注大部分精力调整训练方法、数据配比、数据工程、细节参数、baby sitting(训练过程监测)技巧等。这一系列超越模型架构之外,研究与工程并进且具有前沿突破性的研发任务,才是真正属于模型训练内核最为关键、能够形成大模型技术护城河 know-how积累。

- 对于沿用LLaMA部分推理代码经实验更名后的疏忽,原始出发点是为了充分测试模型,并非刻意隐瞒来源,将尽速完成各开源社区的版本更新。

4、本土大模型的迷津难渡:套壳到底如何界定

其实这不是本土大模型首次被质疑“套壳”。

不久前,外界对百川智能开源模型Baichuan-7B同样提出了是否套壳LLaMa的质疑。彼时,王小川表示,搜索公司干了20年,团队对语言数据有深入的理解,知道取得高质量语料的渠道,模型迭代速度很快,“国内开源模型的能力目前已经可以达到LLaMa”。

那么到底什么是套壳,什么又是合理利用既有开源成果?众所周知,固然选择同一种架构,用不同数据集训练出来的模型也会有所差别。不过,Yi此次引发的争议的焦点在于其对于开源模型架构的“魔改”命名。所以回归事件本身,实质还是一个“用了你的成果,却换了你的牌子”的故事。

当Yi-34B刚发布时,李开复在接受外媒TechCrunch采访时曾说,引入开源LLM作为零一万物首个产品的决定是“回馈”社会的一种方式。对于那些觉得LlaMA对他们来说是“天赐之物”的人来说,“我们提供了一个令人信服的选择”。如今看来,到底能不能让人信服,还是要留待时间的检验了。

参考链接:

https://news.ycombinator.com/item?id=38258015

https://huggingface.co/01-ai/Yi-34B/discussions/11#6553145873a5a6f938658491

https://techcrunch.com/2023/11/05/valued-at-1b-kai-fu-lees-llm-startup-unveils-open-source-model/