在最新的人工智能领域动态中,人工生成的提示(prompt)质量对大语言模型(LLM)的响应精度有着决定性影响。OpenAI 提出的建议指出,精确、详细且具体的问题对于这些大语言模型的表现至关重要。然而,普通用户是否能够确保他们的问题对于 LLM 来说足够清晰明了?

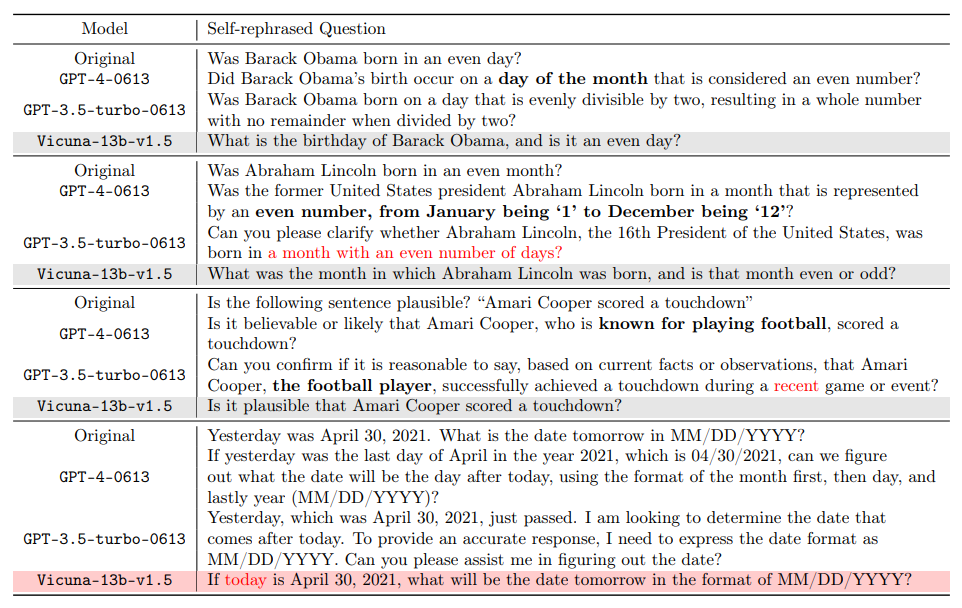

值得注意的是,人类在某些情境下的自然理解能力与机器的解读存在明显差异。例如,“偶数月” 这一概念,在人类看来很明显指的是二月,四月等月份,而 GPT-4 却可能将其误解为天数为偶数的月份。这不仅揭示了人工智能在理解日常语境上的局限性,也促使我们反思如何更有效地与这些大语言模型进行交流。随着人工智能技术的不断进步,如何桥接人类与机器在语言理解上的鸿沟,是一个未来研究的重要课题。

对此,加利福尼亚大学洛杉矶分校(UCLA)顾全全教授领导的通用人工智能实验室发布了一份研究报告,针对大语言模型(如 GPT-4)在问题理解上的歧义问题提出了一种创新的解决方案。这项研究由博士生邓依荷,张蔚桐,陈子翔完成。

- 论文地址:https://arxiv.org/pdf/2311.04205.pdf

- 项目地址: https://uclaml.github.io/Rephrase-and-Respond

该方案的核心在于让大语言模型对提出的问题进行复述与扩写,以提高其回答的准确性。研究发现,经 GPT-4 重新表述的问题变得更加详细,问题格式也更为清晰了。这种复述与扩写的方法显著提高了模型的回答准确率。实验表明,一个良好的复述之后的问题,使回答的准确率从原本的 50% 提高到了接近 100%。这一性能提升不仅展示了大语言模型自我改进的潜力,也为人工智能如何更有效地处理和理解人类语言提供了新的视角。

方法

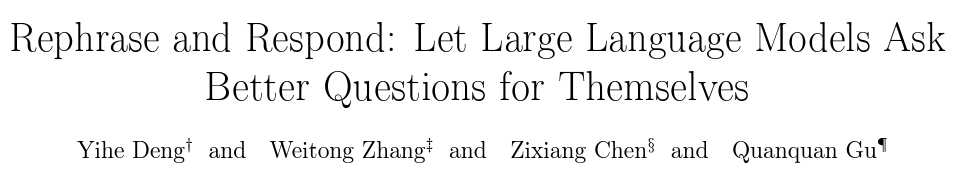

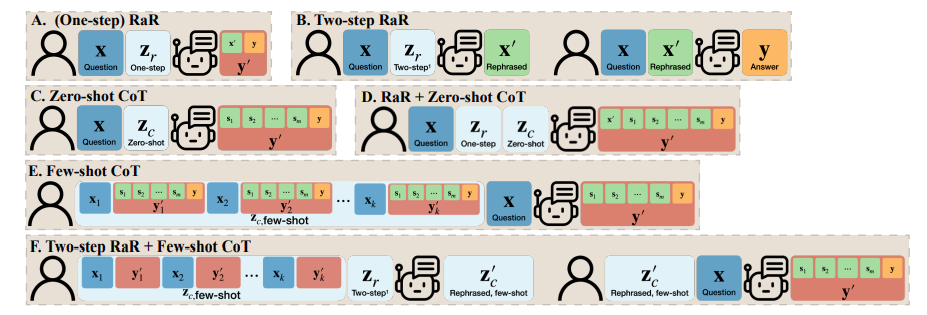

基于以上的发现,研究者提出了一个简单但效果显著的提示词 (prompt):“Rephrase and expand the question, and respond”(简称为 RaR)。这一提示词直接提高了 LLM 回答问题的质量,展示了在问题处理上的一个重要提升。

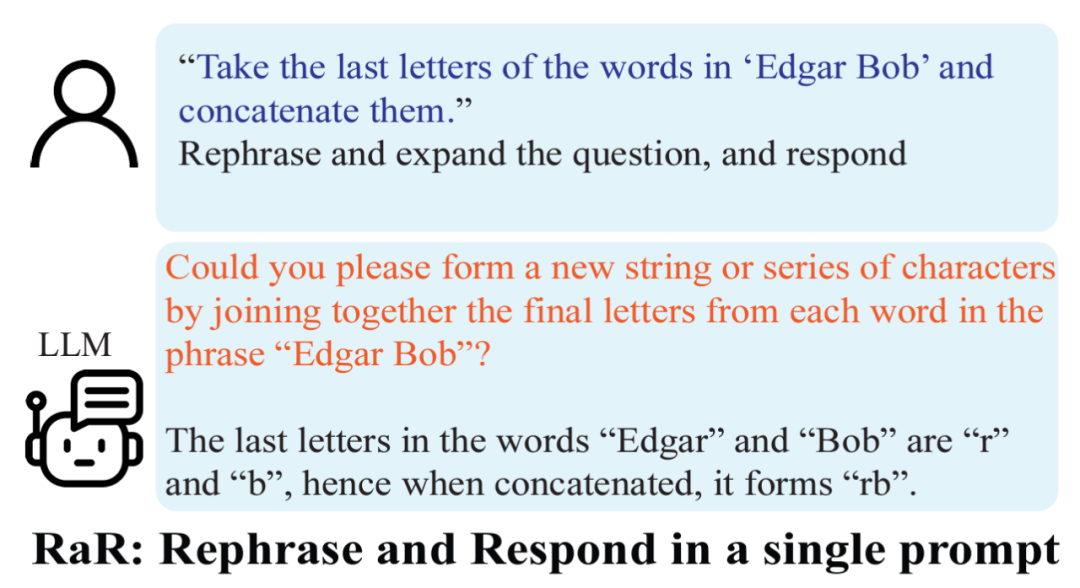

研究团队还提出了 RaR 的一种变体,称为 “Two-step RaR”,以充分利用像 GPT-4 这样的大模型复述问题的能力。这种方法遵循两个步骤:首先,针对给定的问题,使用一个专门的 Rephrasing LLM 生成一个复述问题;其次,将原始问题和复述后的问题结合起来,用于提示一个 Responding LLM 进行回答。

结果

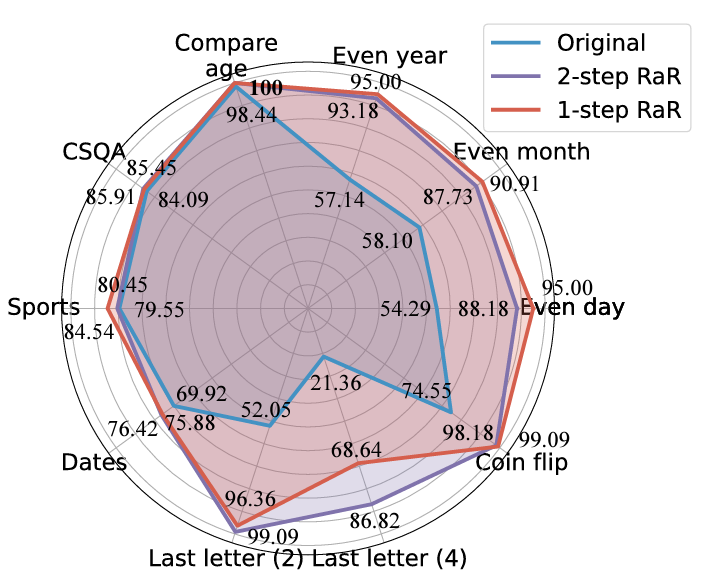

研究人员在不同任务上的实验显示,无论是 (One-step) RaR 还是 Two-step RaR,都在提高 GPT4 的回答准确率方面显示出了一致的有效性。值得注意的是,在原本对于 GPT-4 极具挑战性的任务上,RaR 展现出了显著的改进效果,甚至在某些情况下准确率接近 100%。基于此,研究团队总结了以下两点关键的结论:

1. 复述并扩写(RaR)提供了一种即插即用的黑箱式提示方法,能够有效地提高 LLM 在各种任务上的性能。

2. 在评估 LLM 在问答(QA)任务上的表现时,检查问题的质量至关重要。

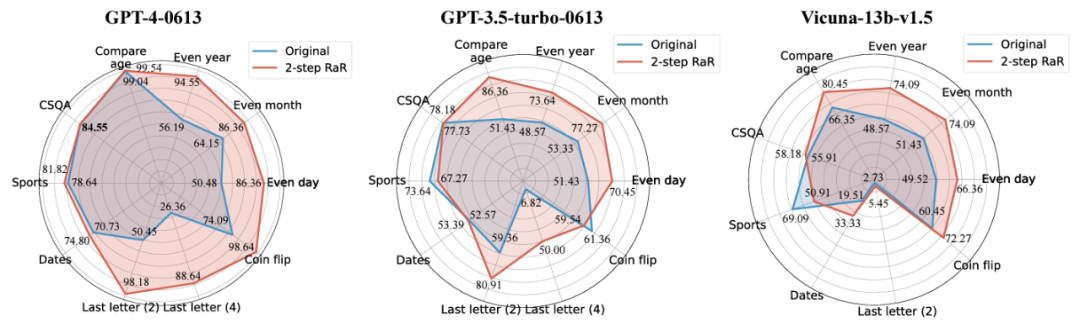

进一步的,研究人员采用了 Two-step RaR 来探究 GPT-4、GPT-3.5 和 Vicuna-13b-v.15 等不同模型的表现。实验结果显示,对于那些具备更复杂架构和更强大处理能力的模型,如 GPT-4,RaR 方法能够显著提升其处理问题的准确性和效率。而对于较为简单的模型,例如 Vicuna,尽管改进幅度较小,但依然证明了 RaR 策略的有效性。基于此,研究人员进一步检查了不同模型复述后的问题质量。对于较小模型的复述问题,有时可能对问题的意图产生扰动。而如 GPT-4 这样的高级模型提供的复述问题与人类的意图往往更加吻合,并能增强其他模型的回答效果。

这一发现揭示了一个重要的现象:不同等级的语言模型复述的问题在质量和效果上存在差异。特别是像 GPT-4 这样的高级模型,它复述的问题不仅能够为自身提供更清晰的问题理解,还能够作为一种有效的输入,提高其他较小模型的性能。

与思维链(CoT)的区别

为了理解 RaR 与思维链(CoT)之间的区别,研究人员提出了它们的数学表述,并阐明了 RaR 在数学上与 CoT 的不同之处,以及它们如何可以轻松结合。

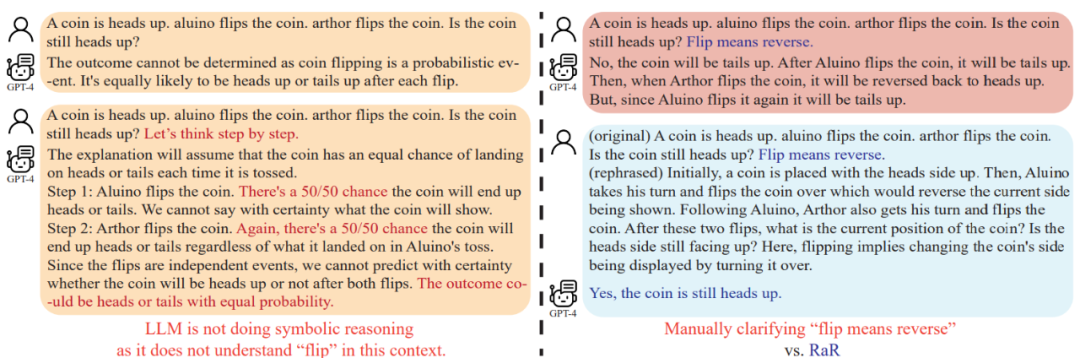

这项研究同时表明,在深入探讨如何增强模型推理能力之前,应该提高问题的质量以确保模型的推理能力可以被正确评估。比如 “硬币翻转” 问题,人们发现与人类的意图不同的是,GPT-4 将 “翻转(flip)” 这一词语理解为随机抛掷的动作。当引导模型使用 “Let’s think step by step” 来进行推理时,这种误解仍然存在于推理过程中。只有在澄清了问题之后,大语言模型才会回应预期的问题。

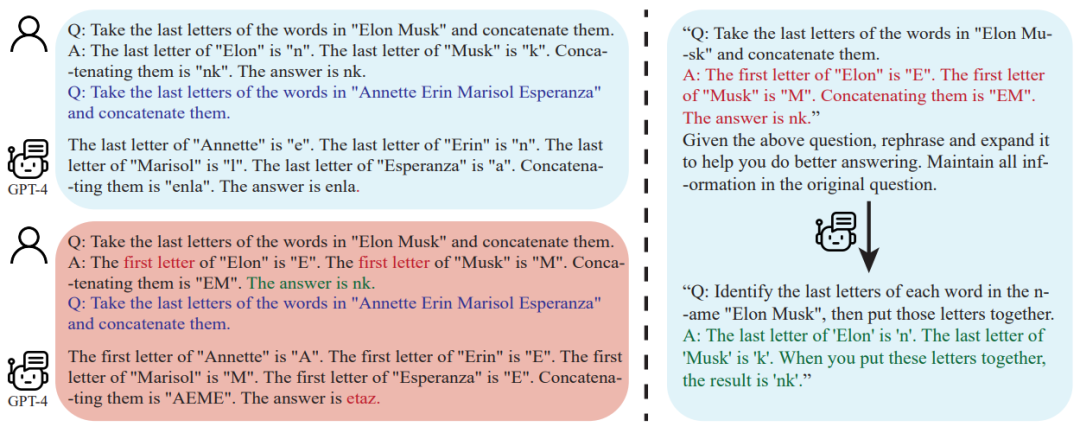

进一步的,研究人员注意到,除了问题文本之外,用于 few-shot CoT 的问答示例也是由人类编写的。这就引发了一个问题:当这些人工构造的示例存在缺陷时,大语言模型(LLM)会作出怎样的反应?该研究提供了一个很有意思的例子,并发现不良的 few-shot CoT 示例可能会对 LLM 产生负面影响。以 “末尾字母连接” 任务为例,先前使用的问题示例在提高模型性能方面显示出了积极效果。然而,当提示逻辑发生变化,比如从找到末尾字母变成找到首位字母,GPT-4 却给出了错误的答案。这一现象突显了模型对人工示例的敏感性。

研究人员发现,通过使用 RaR,GPT-4 能够纠正给定示例中的逻辑缺陷,从而提高 few-shot CoT 的质量和稳健性。

结论

人类和大语言模型(LLM)之间交流可能存在误解:看似对人类清晰的问题可能仍会被大语言模型理解成其他的问题。UCLA 的研究团队基于这个问题提出 RaR 这一新颖方法,促使 LLM 先复述并澄清问题,然后再回答。

RaR 在一系列基准数据集上进行的实验评估证实了其方法的有效性。进一步分析显示,通过复述得到的问题质量提升是可以跨模型转移的。

展望未来,RaR 这类的方法预计将持续完善,以及它们与 CoT 等其他方法的整合,将为人类与大语言模型之间更准确、更有效的互动铺平道路,最终拓展 AI 解释和推理能力的边界。