本文经自动驾驶之心公众号授权转载,转载请联系出处。

笔者个人的一些思考

不得不说,最近大模型在学术界火起来了,基于图文匹配的CLIP预训练模型成为近年来在多模态研究领域的经典之作。除此之外,大语言模型的蓬勃发展也进一步为多模态带来了性能提升。自动驾驶领域也有类似的数据(图像/视频+caption)用于车辆行为分析如BDD-X,最近也有新的工作直接构建自动驾驶场景下的QA,如DQA和DRIVEGPT4中使用chatgpt扩展的BDD-X数据集,这些工作都为端到端自动驾驶技术提供了可能;然而,现有多模态范式中输入尺度较小(224x224),识别精度受限,因此在多模态的基础上提出了高分辨率分支增强目标很重要,尤其是风险目标的识别能力用于——风险目标定位和自车意图以及建议预测(ROLISP),接下来我们一起看下具体是怎么实现的。

HiLM-D是怎么做的?

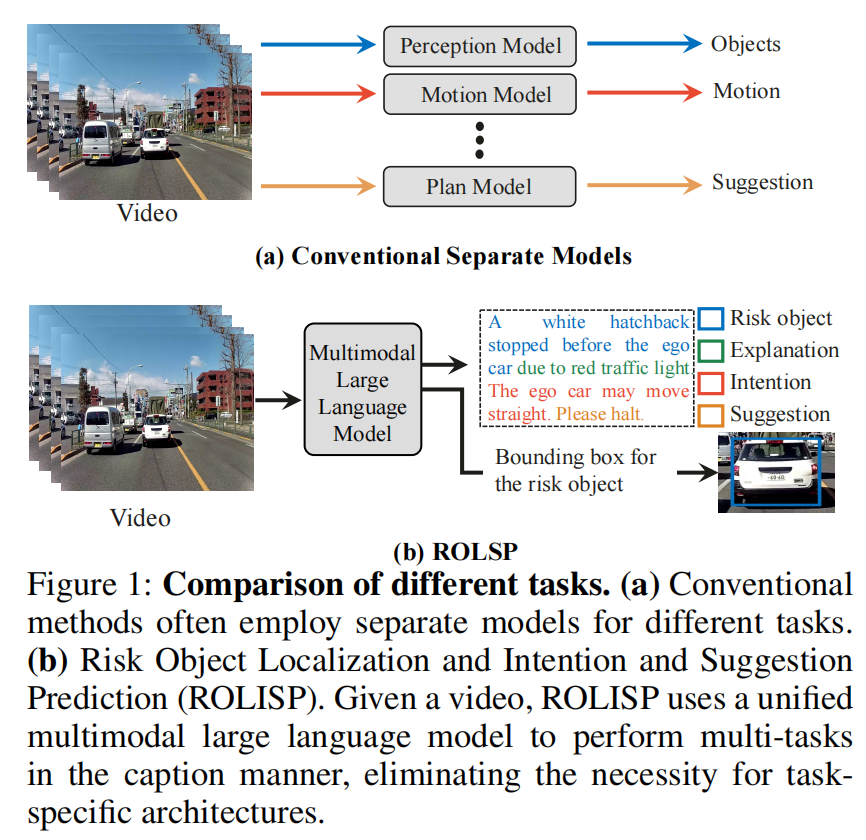

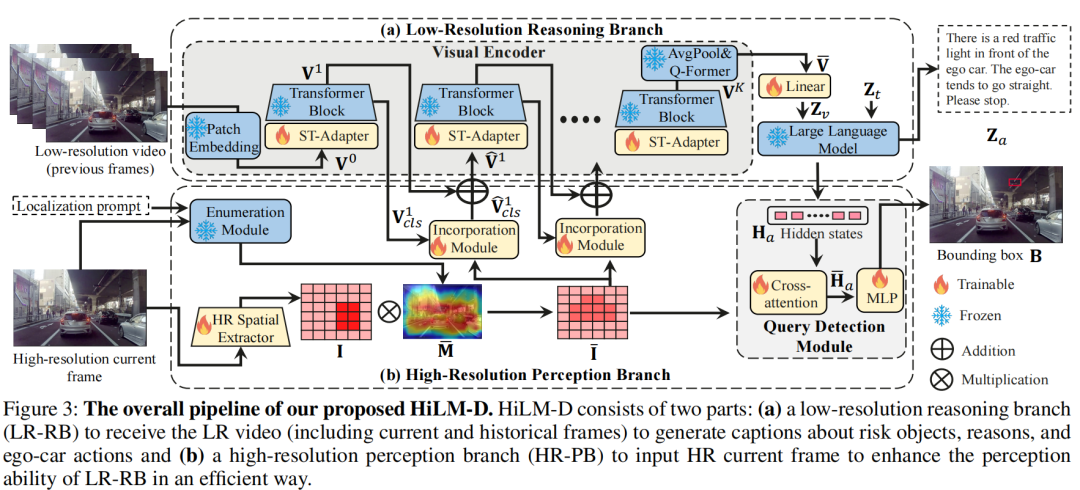

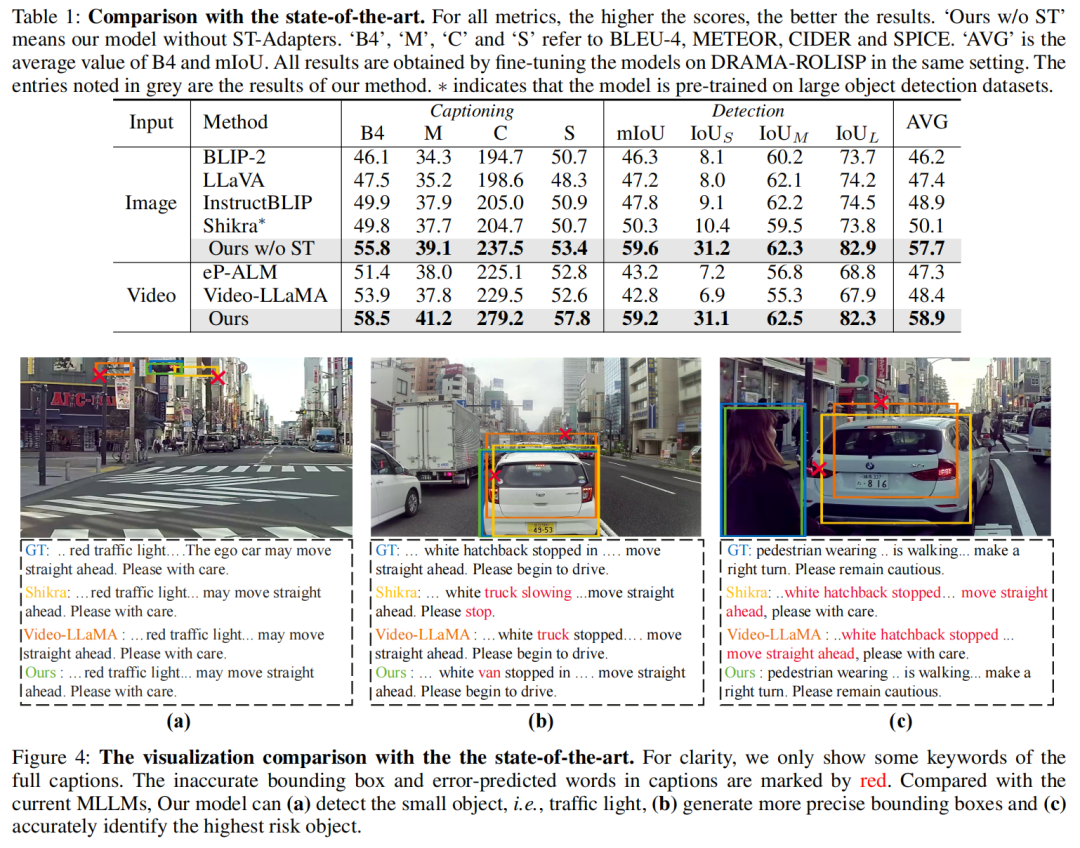

自动驾驶系统通常采用针对不同任务的单独模型,导致设计复杂。HiLM-D首次利用单一的多模态大语言模型(MLLMs)来整合来自视频的多个自动驾驶任务,即"Risk Object Localization and Intention and Suggestion Prediction(ROLISP)"任务。ROLISP使用自然语言同时识别和解释风险目标,理解自动驾驶车辆的意图并提供运动建议,从而消除了需要特定任务架构的必要性。然而,由于缺乏高分辨率(HR)信息,现有的MLLMs在应用于ROLISP时通常会错过小物体(例如交通锥)并过分关注显著的物体(例如大卡车)。本文提出了HiLM-D("Towards High-Resolution Understanding in MLLMs for Autonomous Driving"),这是一种有效的方法,将HR信息合并到MLLMs中,用于ROLISP任务。特别是,HiLM-D整合了两个分支:(i)低分辨率推理分支,可以是任何MLLMs,处理低分辨率视频以为风险目标添加标题并识别自动驾驶车辆的意图/建议;(ii)高分辨率感知分支(HR-PB),是HiLM-D的主要部分,摄入高分辨率图像以通过捕获具有视觉特定HR特征图的高分辨率特征图来增强检测,并优先考虑所有潜在风险,而不仅仅是显著的目标。HiLM-D的HR-PB作为即插即用模块,可以无缝地适应现有的MLLMs。在ROLISP基准测试上的实验证明,HiLM-D在caption生成方面的BLEU-4得分提高了4.8%,在检测方面的mIoU提高了17.2%,显示了HiLM-D相对于主要MLLMs的显著优势。

HiLM-D优势有哪些?

• 利用MLLMs通过自然语言范例来解决多个自动驾驶任务,即ROLISP。

• 普遍的MLLMs通常在训练时输入具有单一小尺寸(即224×224)的图像。HiLM-D引入了HiLM-D(400x400)来生成丰富的包含视觉特定先验知识和突出高风险区域的高分辨率特征图,这些特征图可以与现有的MLLMs无缝集成并增强它们。

•在ROLISP基准测试上进行了实验,以证明HiLM-D的卓越性能,例如在BLEU-4caption生成方面比最先进的MLLMs提高了4.8%。

目前领域相关工作

多模态大语言模型

随着大语言模型(LLMs)的出现,自然语言处理取得了重大进展,例如GPT系列,T5,LLaMA等。受LLMs的潜力激发,许多多模态大语言模型(MLLMs),例如LLaVA,MiniGPT-4,Video-LLaMA和InstructBLIP,已被提出以将LLMs扩展到多模式领域,即感知图像/视频输入,并在多轮对话中与用户交流。这些模型在大规模的图像/视频文本对上进行了预训练,但这些模型仅能处理图像级任务,如图像caption和问题回答。因此,一些作品如ContextDET,KOSMOS-2和Shikra已被提出,以实现MLLMs的基础能力,产生边界框。然而,所有当前的MLLMs都在低分辨率的图像文本对中训练模型,这在高分辨率自动驾驶场景中限制了感知结果,

自动驾驶

在自动驾驶领域,传统的自动驾驶算法通常独立处理不同的任务,例如检测、跟踪、推理和预测。为了提取更丰富的跨任务信息,研究人员开始探索将多个任务集成到端到端的训练框架中。例如,一些作品如D&T展示了检测和跟踪的联合训练,FaF进一步将检测器与轨迹预测器统一,取得了显著的成果。UniAD脱颖而出,将全栈自动驾驶任务融合在一个统一的框架中,尽管仍然依赖于每个任务的不同子网络。该领域中的一个新方向是将自然语言用作跨任务的统一输出。例如,ADAPT使用单个caption来预测意图并提供解释,而DRAMA旨在检测和解释风险目标。在HiLM-D中,比Drama和ADAPT更进一步,即ROLISP,旨在识别、解释和定位风险目标,同时预测其意图并提供建议。

HiLM-D方法设计

Low-Resolution Reasoning Branch

低分辨率推理分支(LR-RB)利用MLLM来接收低分辨率(LR)视频输入,并以自然语言方式生成识别的风险目标(包括原因)以及自车的意图和建议,包括一个视觉编码器和一个大语言模块。

Visual Encoder.(冻结的ViT和Q-former+需训练的ST-Adapter) 视觉编码器负责将视频输入转换为视觉标记,使大语言模型(LLM)能够理解它们。它建立在预训练的图像视觉变换器(ViT)和Q-former的基础上,采用BLIP2(Li等人2023年)初始化,并在训练过程中保持冻结。为了处理图像的时序性,该编码器还包括一个时空适配器(ST-Adapter)(Pan等人2022年)。具体地,对于具有帧的视频,ViT将每个帧映射到其第层特征,产生, 其中 是第帧的特征, 是patch的数量, 是纬度. 这些特征进一步通过ST-Adapter和一个变换块进行处理,产生 . 最终的视频表示为, , 通过将ViT的最后一层特征进行平均池化和 -former. 一个可训练的线性层然后将投影到LLM的维度,生成。

Large Language Model (LLM).(冻结,具体哪个模型似乎没写) 有了视觉标记,就可以利用预训练的LLM来生成包括风险目标的标识以及解释、意图和建议在内的caption,供自动驾驶车辆使用。LLM的输入由多模态标记 的连接组成, 其中 表示从文本提示(例如“哪个目标风险最高?然后预测自车的动作和建议。”)中标记的文本嵌入。预训练的LLM接收这些多模态标记来自动地生成语言。

其中是可训练参数, 是生成的答案。

High-Resolution Perception Branch

高分辨率感知分支(HR-PB)专门设计用于整合来自高分辨率图像的视觉特定信息以及与潜在高风险目标相关的特征,以供LR-RB使用。

该分支由四个部分组成:

• HR空间提取器(HRSE),用于获取HR帧的HR特征;

• 枚举模块,用于突出显示所有潜在高风险目标;

• 整合模块,将所有潜在风险目标整合到LR-RB中;

• 查询检测头,用于基于HR特征检测目标。

HR空间提取器(需训练的ResNet)

为了捕获目标检测的视觉特定信息,HRSE改编自经典的卷积网络(CNN)ResNet。与当前MLLM中的普通ViT相比,CNN具有许多优势:减少内存和计算资源,并为检测任务(例如局部连接性和空间不变性)带来视觉特定的先验知识。HiLM-D将提取的高分辨率空间特征图表示为,其中 和 分别表示维度、宽度和高度。

枚举模块(冻结的GradCAM)

在自动驾驶中,一些风险目标,如行人或交通锥,可能仅占整个图像的一小部分,通常位于边缘区域。然而,HiLM-D的实验发现,现有的MLLM倾向于优先考虑更显眼的目标,如大型车辆,导致风险目标的误识别。为了解决这个问题,引入了一个枚举模块,确保模型关注所有潜在的高风险目标区域,而不仅仅是主导的目标。该模块利用预训练的MLLM来测量图像和位置提示之间的相似性,例如“车辆、红绿灯/锥形标识和人在哪里?”。随后,使用GradCAM(Selvaraju等人,2017)生成一个强调这些高风险目标区域的映射。将生成的强调地图表示为 ,其中 与 分别表示强调地图的宽度和高度,其值范围从0到1。然后,将上采样到与相等的大小,得到。最后,获得了突出显示的高分辨率图像特征,其中表示逐元素相乘,.

整合模块(需训练的交叉注意力)

整合模块旨在让从LR-RB学到的语义与所有潜在风险目标的空间特征相融合,从而使LLM能够比较和决定哪一个需要最多的关注。通过一个交叉注意力模块来实现这一点,该模块将LR-RB第层的特征作为查询,突出显示的HR特征图作为值和键。为了进行高效的计算,只使用 中的cls标记作为查询,即。然后,交叉注意力可以表示为。将 添加到原始的后,获得新的cls标记,即,用于第个ST-Adapter和变压器块。是可学习的门控因子,用于自适应地控制的重要性,其初始值为零,以避免在训练初期对原始ViT造成干扰。最后,整合后的视觉标记由 获得。

查询检测头(需要训练的交叉注意力+MLP)。

为了获得精确的边界框,HiLM-D设计了一个查询检测头,将找到的风险目标的表示视为先验知识,用于在HR特征I中找到边界框。为实现这一点,使用风险目标的隐藏状态作为查询,突出显示的HR空间特征作为值和键来计算交叉关注,可以表示为,其中 是与答案相关的语言标记的隐藏状态,即找到的目标。最后,被馈送到MLP以生成边界框,即 。然后,预测的边界框由进行监督, 是GT。

总损失定义如下:

其中 是超参数。

实验设置与分析

实施细节。提出的方法在PyTorch中实现,使用一台配备8个NVIDIA V100 GPU的单台机器进行训练。输入视频帧被调整大小并裁剪到尺寸为224×224的空间。从整个视频中均匀采样L = 5帧,并确保最后一帧用于生成边界框。设置为2。使用AdamW(Loshchilov和Hutter,2017)作为优化器,余弦退火调度器(Loshchilov和Hutter,2016)作为学习率调度器,低分辨率推理分支的初始学习率为1e-4,高分辨率感知分支的初始学习率为4e-4,全局批量大小为64。

数据集。DRAMA(Malla等人,2023)是一个评估驾驶场景中视觉推理的基准,包括17,785个两秒交互式场景。然而,它只提供有关风险目标的标题,没有提供有关自车意图或建议的信息,这对于ROLISP至关重要。为了解决这个问题,增强了注释,扩展了DRAMA的标题,包括自车意图和建议,从而产生了DRAMA-ROLISP数据集。

评估指标。ROLISP包括两个任务:(1)标题以识别和解释风险目标,同时预测自车意图和动作,以及(2)风险目标检测。标题性能遵循标准指标(Malla等人,2023),即BLEU-4(B4),METEOR(M),CIDER(C)和SPICE(S)。使用平均交并比(mIoU)来进行检测评估。此外,还提供了按物体大小分类的IoU分数:小型(IoUS),中型(IoUM)和大型(IoUL)。

与最先进方法的比较 在DRAMA-ROLISP上进行实验,与基于图像和视频的MLLM进行比较,包括BLIP-2,LLaVA,InstrutBLIP,Shikra,eP-ALM和Video-LLaMA;请注意,除了Shikra,其他模型都无法检测物体。因此,将检测头(基于MLP的)整合到它们中以生成边界框;

Main Results

最后总结一下

HiLM-D引入了一种新的方法,使用多模态大语言模型(MLLMs)来统一多个驾驶任务,称为风险目标定位和自车意图以及建议预测(ROLISP)。进一步提出了HiLM-D,以生成丰富的高分辨率特征图,其中包含了视觉特定的先验信息,突出显示高风险区域,这可以无缝地与现有的MLLM集成并增强其性能。

局限性。值得注意的是,HiLM-D的数据集固有的局限性,每个视频只包含一个风险目标,这可能无法捕捉真实世界场景的复杂性。此外,该数据集缺乏如雨雪或雾等恶劣天气条件,这对于全面的自动驾驶评估至关重要。此外,提供的建议通常是简明的,例如“停车”或“让行”,这可能过于简化了可能的行动范围。未来工作是创建一个更多样化和具有挑战性的数据集,进一步推动该领域的发展。

参考:

论文:https://arxiv.org/pdf/2309.05186.pdf

作者单位:The Hong Kong University of Science and Technology, Huawei Noah’s Ark Lab。

原文链接:https://mp.weixin.qq.com/s/OFGH64lO88sRuRou5K9HFA