当前,最先进的文本到图像(T2I)模型需要大量的训练成本(例如,数百万个 GPU 小时),这严重阻碍了 AIGC 社区的基础创新,同时增加了二氧化碳排放。

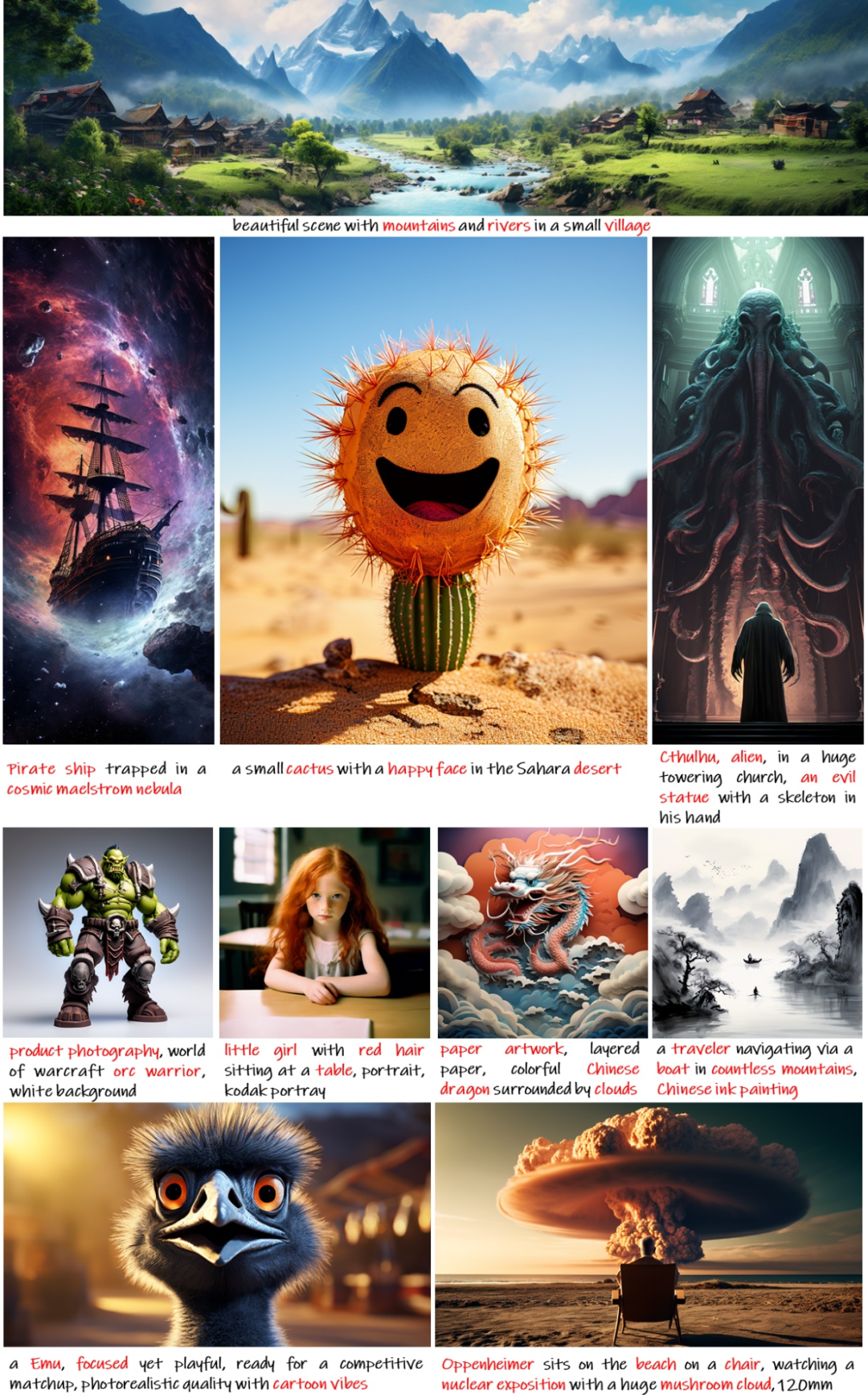

现在,来自华为诺亚方舟实验室等研究机构的研究者联合提出了开创性的文本到图像(T2I)模型 PixArt-α, 只需要 Stable Diffusion v1.5 训练时间的 10.8%(约 675 vs 约 6250 A100 GPU 天),省下近 30 万美元(26000 美元 vs 320000 美元)。与更大的 SOTA 模型 RAPHAEL 相比,PixArt-α 的训练成本仅为 1%,且支持直接生成高达 1024×1024 分辨率的高分辨率图像。

PixArt-α 模型不仅大幅降低了训练成本,还显著减少了二氧化碳排放,同时提供了接近商业应用标准的高质量图像生成。PixArt-α 的出现,为 AIGC 社区和初创公司提供了新的视角,以加速他们构建自己的高质量且低成本的生成模型。

- 论文地址:https://arxiv.org/abs/2310.00426

- 主页:https://pixart-alpha.github.io/

- 项目地址: https://github.com/PixArt-alpha/PixArt-alpha

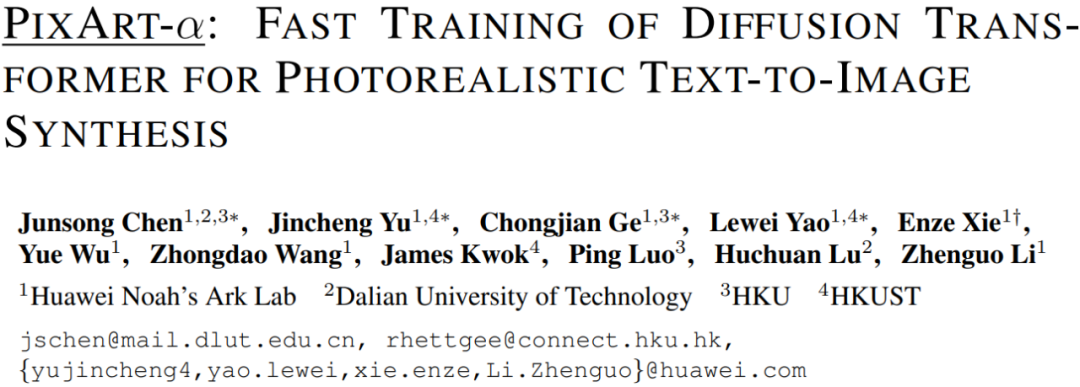

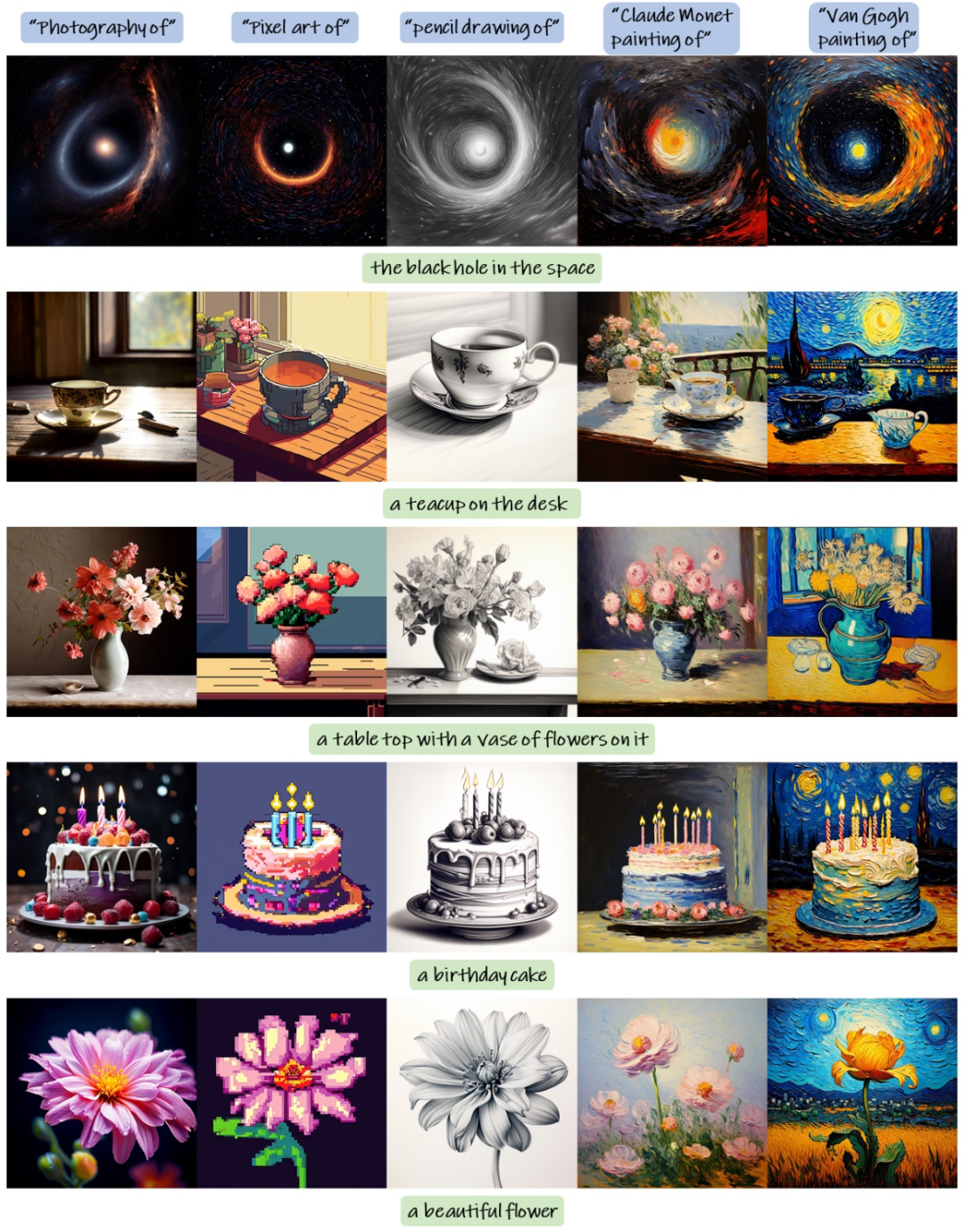

总的来说,PixArt-α 是一种基于 Transformer 的 T2I 扩散模型,其图像生成质量可以与最先进的图像生成器(例如,Imagen [1],SDXL [2],甚至 Midjourney [3])相媲美,达到接近商业应用的标准。此外,它支持高达 1024×1024 分辨率的高分辨率图像的直接生成,训练成本低,如下图 1 所示。

图表 1.PixArt-α 产生的样本展示出了其卓越的质量,其特点是高精确度和准确性的图像生成。

为了实现这个目标,该研究提出了三个核心设计:

- 训练策略分解:该研究设计了三个独特的训练步骤,分别优化像素间依赖关系,文本图像对齐和图像美学质量;

- 高效的 T2I Transformer 结构:该研究将跨注意力模块整合到 Diffusion Transformer(DiT)[6] 中,以注入文本信息并简化计算复杂的类条件分支;

- 高信息密度数据:该研究强调文本图像对中概念密度的重要性,并利用大视觉语言模型自动标记密集的伪文本标签以协助文本图像对齐学习。

大量的实验表明,PixArt-α 在图像质量、艺术性和语义控制方面表现出色。研究团队希望 PixArt-α 能为 AIGC 社区和初创公司提供新的思路,以加速他们从头开始构建自己的高质量且低成本的生成模型。

图表 2.T2I 方法之间的二氧化碳排放和训练成本比较。PixArt-α 实现了极低的训练成本,仅为 26,000 美元。相比于 RAPHAEL,PixArt-α 的二氧化碳排放和训练成本分别仅为 1.1% 和 0.85%。

从现象看本质:从训练流程和数据的角度重新审视文生图任务

从现有训练流程出发:文本到图像(T2I)生成任务可以分解为三个方面:建模像素间关系、文本与图像的精确对齐以及高审美质量生成。然而,现有方法将这三个问题混合在一起,并直接使用大量数据从零开始训练,导致训练效率低下。

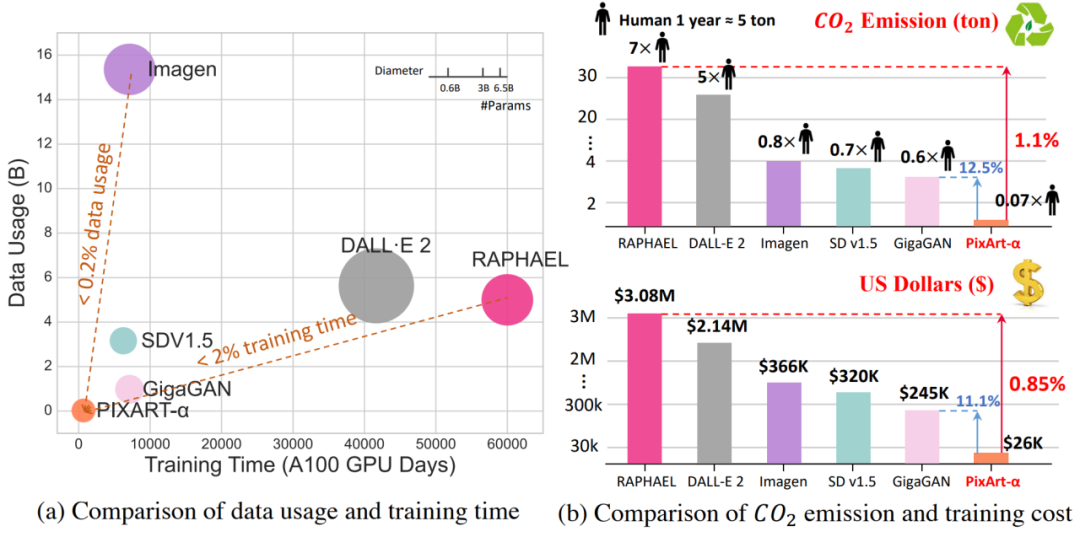

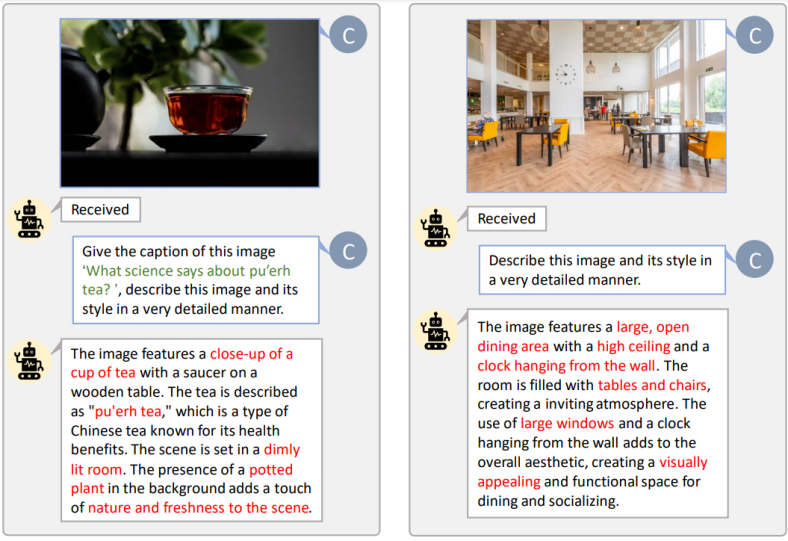

从训练数据出发:如图 3 所示,现有的文本 - 图像对常常存在文本 - 图像不对齐、描述不足、包含大量不常见词汇以及包含低质量数据等问题。这些问题给训练带来了困难,导致需要进行数百万次迭代才能实现文本和图像之间的稳定对齐。为了解决这个挑战,该研究引入了一个创新的自动标注流程来生成精确的图像标题。

图表 3.LAION [6] 原生标题 v.s. LLaVA 精细标题的对比。LLaVA 提供了信息密度更高的文本,帮助模型在每次迭代中掌握更多概念,提高了文本 - 图像对齐的效率。

解耦训练策略:不同数据获取、强化不同能力

1. 像素间依赖学习

当前 class-condition 的方法 [7] 在生成语义连贯且像素逻辑合理的图像上展现出了卓越的性能。训练一个符合自然图像分布的 class-condition 图像生成模型,不仅训练相对简单,成本也较低。该研究还发现,适当的初始化可以极大地提升图像生成模型的训练效率。因此,PixArt 模型采用了一个 ImageNet 预训练模型作为基础,来增强模型的性能。此外,该研究也提出了重参数化来兼容预训练权重,以确保最佳的算法效果。

2. 文本图像对齐

从预训练的 class-condition 图像生成模型过渡到基于文本的图像生成模型的主要挑战在于如何实现文本概念与图像之间的精确对齐。这个对齐过程既耗时,也具有挑战性。为了有效地促进这个过程,该研究构建了一个高概念密度的由精确的文本 - 图像对组成的数据集。通过使用精确且信息丰富的数据,帮助模型在单次训练迭代中有效学习更多的概念,同时相较于之前的数据集,遇到的模糊性大大减少。这种策略性的方法赋予了 PixArt-α 高效地将文本描述与图像对齐的能力。

3. 图像美学质量

在第三阶段,该研究对模型进行了微调,利用了高质量的美学数据并提高了模型的分辨率,使得模型具有生成高质量图像的能力。值得注意的是,研究团队观察到模型在该阶段的收敛速度显著加快,这主要归功于前两阶段学习到的的强大的先验知识。

删繁就简:高效 T2I Transformer 架构

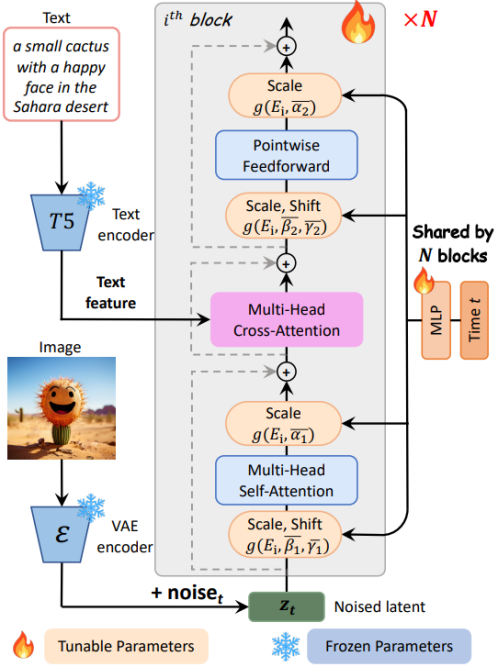

PixArt-α 采用了 Diffusion Transformer (DiT) 作为基础架构,如图 4 所示,并创新地提出了以下几个专门的设计方案来处理 T2I 任务:

图表 4.PixArt-α 模型架构。

Cross-Attention layer 该研究在 DiT 模块中加入了一个多头交叉注意力层。它位于自注意力层和前馈层之间,使得模型能够灵活地与从语言模型中提取的文本特征进行交互。为了利用预训练权重,该研究将交叉注意力层的输出投影层权重初始化为零,有效地作为恒等映射来保留输入供后续层使用。

AdaLN-single 该研究发现在 DiT 的自适应标准化层(adaLN)中,线性投影(MLP)占据了大量(27%)的参数。研究团队提出了 adaLN-single 模块来降低模型的参数量,它只在噪声进入模型第一层之前,仅使用时间特征嵌入作为输入进行独立控制(如图 4 右侧所示), 并在所有层中共享。研究团队为每一层设置了层特定的可学习特征嵌入,它可适应性地调整不同层中的尺度和位移参数。

重参数化 该研究提出了重参数化技巧来保持与预训练权重的兼容性。

实验表明,通过整合全局 MLP 和层次嵌入来处理时间步信息,以及采用跨注意力层处理文本信息,可以在有效减小模型大小的同时,保持模型的生成能力。

数据构建:全新自动化图文对标注工具

该研究发现 LAION 数据集中存在大量简单的商品样图,并选择使用专为多样性目标分割设计的 SAM 数据集 [8],其图像中包含了丰富多样的对象,即较高的信息 / 概念密度,更加贴合前文高信息密度数据可以帮助图文对齐的论述。标注流程如图 5 所示。

图表 5.为 LAION(左图)和 SAM(右图)进行自定义提示的自动标注功能。图中绿色高亮的词汇代表 LAION 中的原始标题,而红色标注的则是 LLaVA 标注的详细信息。

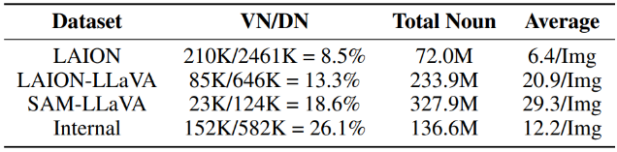

研究团队对 LAION 和 SAM 两个数据集进行了名词统计,如图 6 所示。LAION 的名词统计显示,虽然其总的名词种类多达 2451K 种,但有效名词的比例仅为 8%,这意味着其中 91% 以上的名词是不常见的,这可能会导致模型训练的不稳定。相比之下,LAION-LLaVA 的统计结果显示,有效名词的比例有所提升,总名词数量和每张图像的平均名词数量显著增加。这表明,LLaVA 生成的标签能够尽量涵盖每张图片中更多的物体和概念。同样的,在实际使用的 SAM 数据以及内部数据中,各项指标都有较 LAION-LLaVA 有更大的提升,这体现了更高的概念密度数据在训练中的重要性。

图表 6.不同数据集的名词概念统计。VN:有效的不同名词种类(出现次数超过10次);DN:总的不同名词种类;Average:每张图片的平均名词数量。

量化指标验证:指标下的能力

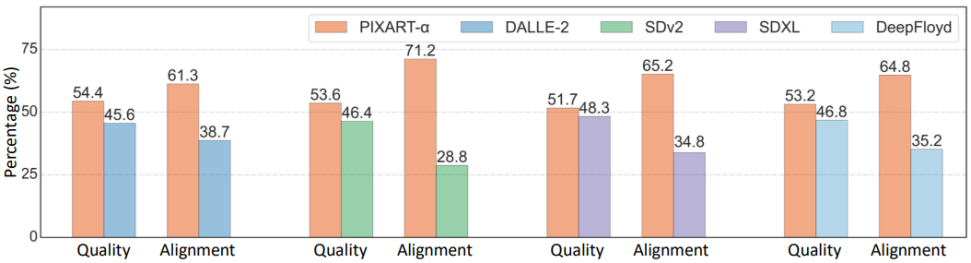

该研究最终在 User study、T2ICompBench [9] 以及 MSCOCO Zero-shot FID 三项指标上验证了 PixArt-α 的能力。更多评价结果与讨论请参考原论文。

图表 7.根据对 Ernie-vilg 2.0 [10] 的 300 个固定提示的用户体验研究,比例值表示了偏好对应模型的用户百分比。PixArt-α 在质量和对齐度方面都表现出超越其他模型的优秀性能。

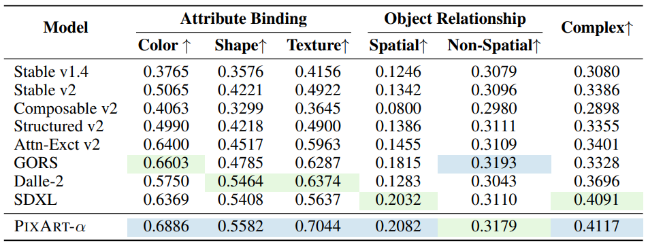

如下图表 8 所示,在 T2I-CompBench 上进行的对齐评估中,PixArt-α 在属性绑定、对象关系和复杂组合方面展示出卓越的性能,这表明 PixArt-α 具有优越的组合生成能力。其中,用蓝色高亮表示最好的值,用绿色表示次优的值。基线数据来源于 T2ICompBench。

图表 8

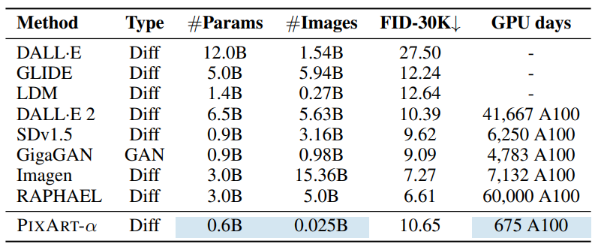

该研究全面比较了 PixArt-α 和最近的 T2I 模型,考虑了几个关键因素:模型大小、训练图像总量、COCO FID-30K 分数(Zero-shot)以及计算成本(GPU 天数),结果如下图表 9 所示。该研究提出的高效方法 PixArt-α 显著减少了资源消耗,包括训练数据使用和训练时间。基线数据来源于 GigaGAN [11]。

图表 9

可视化验证:No cheery-pick battle

用于可视化的图像文本均取自其他方法中,本文中的图片全部随机生成,无需 cheery-pick。

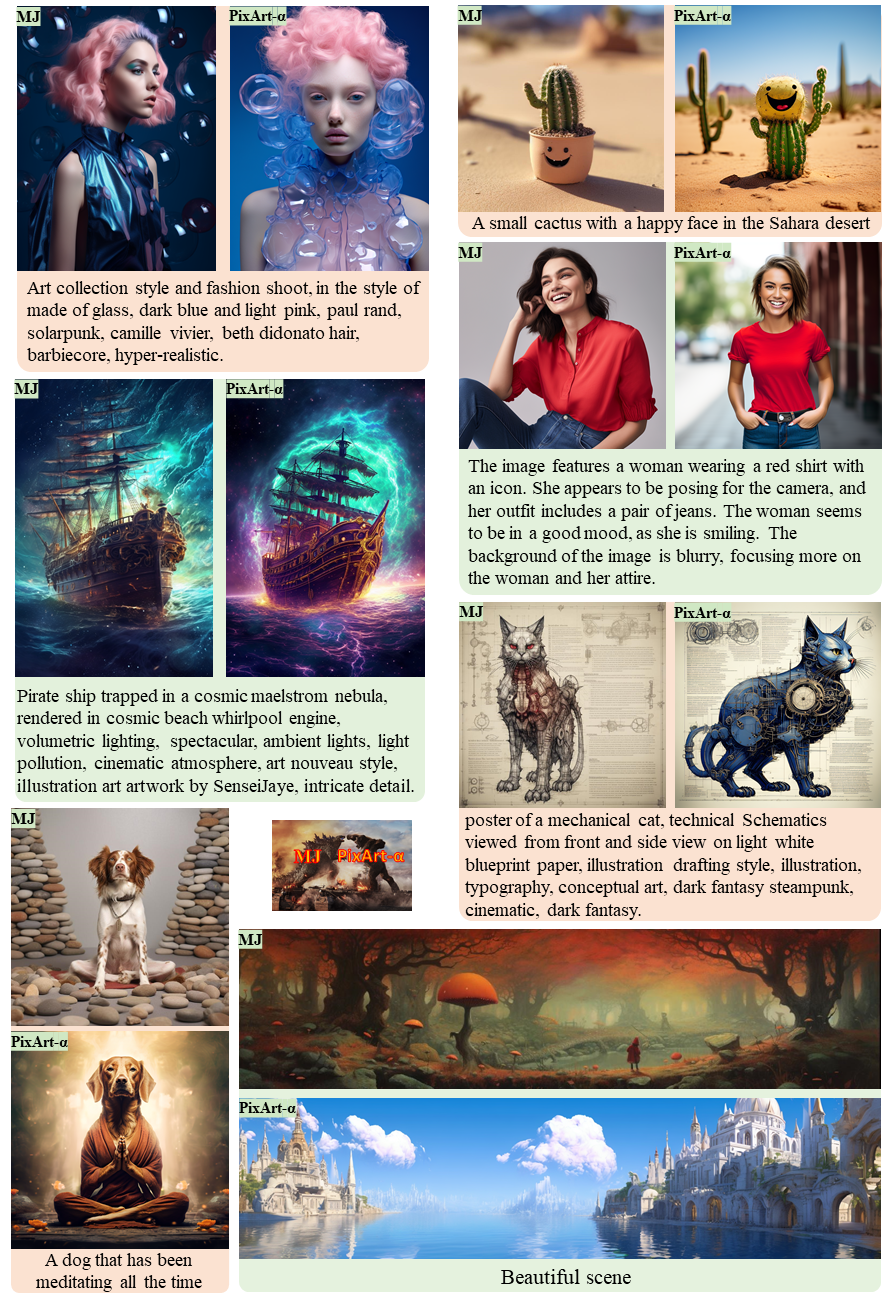

1. 与 Midjourney 对比

图表 10 与 Midjourney 的比较:此次比较使用的提示是从网上随机抽样的。为了确保公平的比较,研究团队选择了两种模型生成的第一个结果进行对比。

图表 10

2. 与更多文生图方法的对比

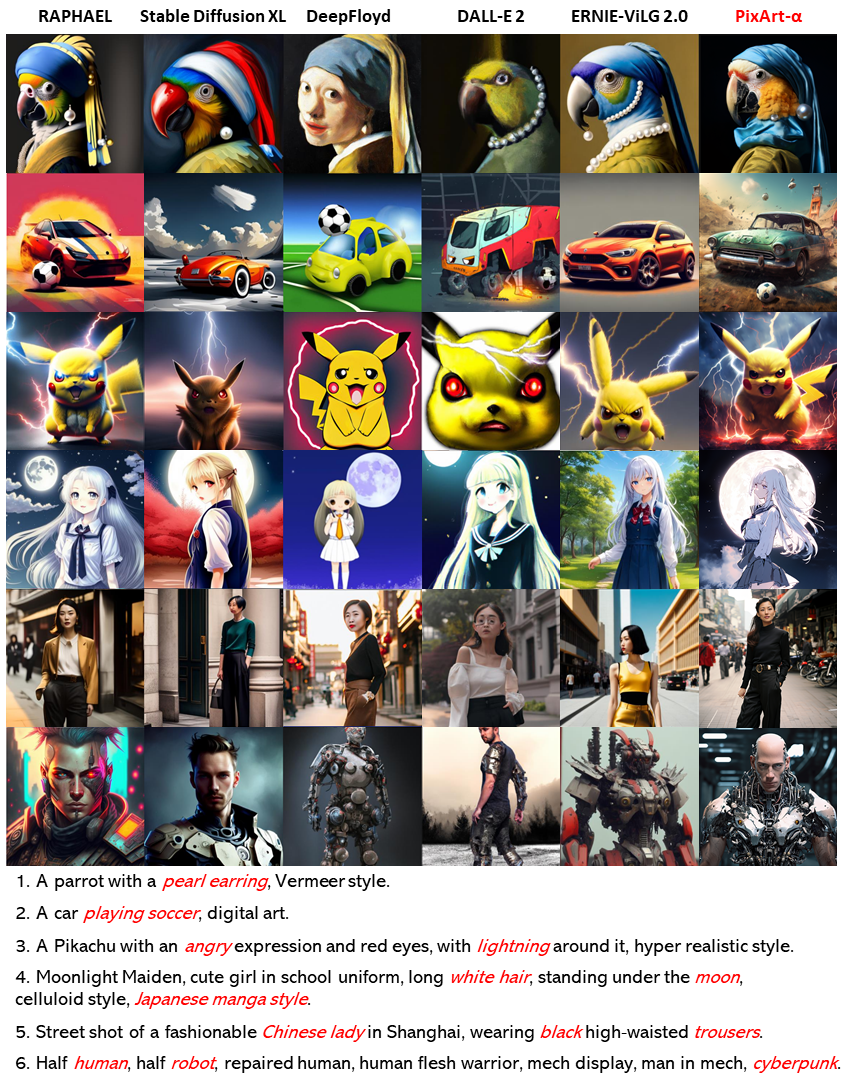

图表 11 PixArt-α 与近期代表性的方法对比,如 Stable Diffusion XL [2]、DeepFloyd [12]、DALL-E 2 [13]、ERNIE-ViLG 2.0 [10] 以及 RAPHAEL [5]。所有方法都使用了与 RAPHAEL 中相同的提示词,其中人类艺术家希望在生成图像中保留的词语被用红色高亮。各行的具体提示在图示下方提供。

图表 11

3. 文本直接控制风格

图表 12 提示词混合:PixArt-α 能够直接通过文本提示操控图像风格。利用风格控制物体,PixArt-α 生成了五个输出样本。例如,位于图示左角的第一个例子的第二个图片,使用的提示是 “Pixel Art of the black hole in the space”。

图表 12

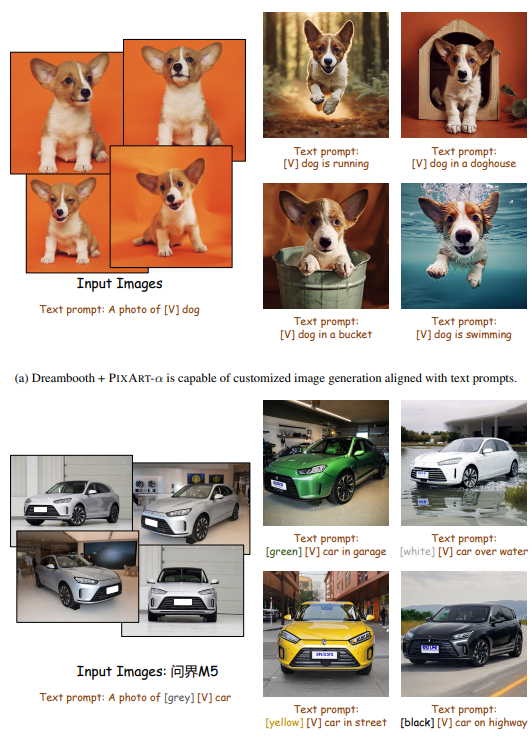

方法可拓展性:ControlNet & Dreambooth

如下图表 13 所示,PixArt-α 能够与 Dreambooth [14] 结合使用。只需给定几张图片和文本提示,PixArt-α 就能生成高保真度的图像,这些图像能展示与环境的自然互动(a)和精确的物体颜色修改(b)。这证明了 PixArt-α 能生成具有卓越质量的图像,并且在定制扩展方面具有强大的能力。

图表 13

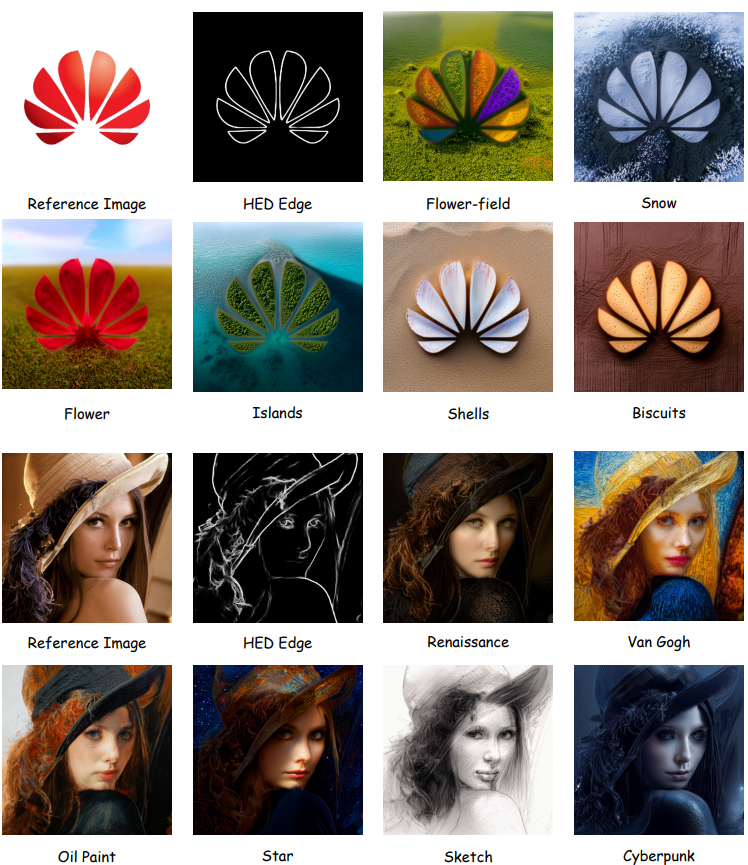

图表 14:PixArt-α+ControlNet [15] 定制样本。该研究使用输入图片生成相应的 HED 边缘图像,并将它们作为 PixArt-α ControlNet 的控制信号。

图表 14

总结

总的来说,该研究提出了 PixArt-α,这是一种基于 Transformer 的文本到图像(T2I)扩散模型,它在显著降低训练成本和二氧化碳排放的同时,实现了超强的图像生成质量。PixArt-α 的三大核心设计,包括训练策略的分解、高效的 T2I Transformer 架构和高信息量的数据,都为 PixArt-α 的成功做出了贡献。通过大量的实验,该研究证明了 PixArt-α 在图像生成质量上达到了接近商业应用的标准。有了以上的设计,PixArt-α 为 AIGC 社区和初创公司提供了新的视角,使他们能够构建自己的高质量且低成本的 T2I 模型。研究团队希望这项工作能激发这个领域的进一步创新和进步。