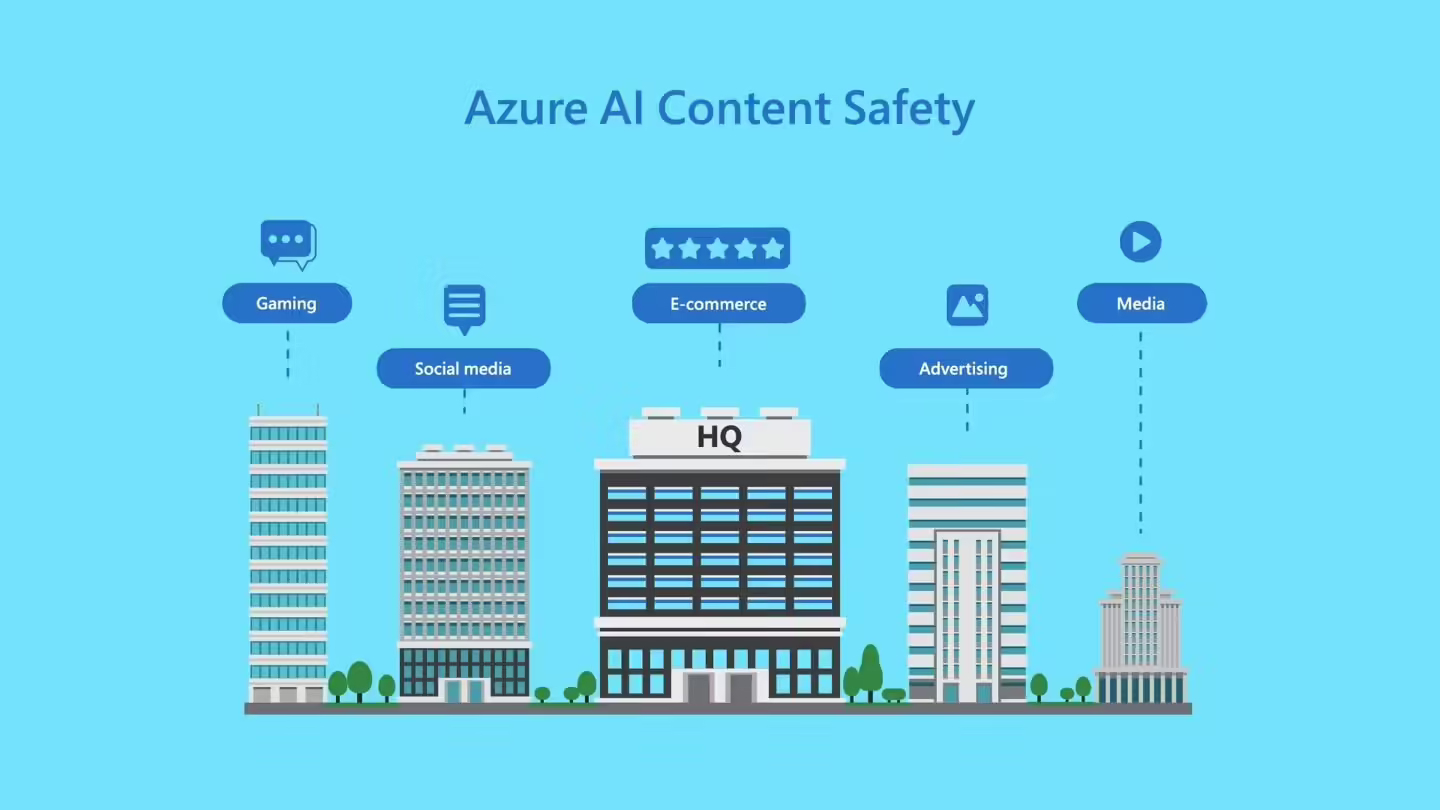

10 月 18 日消息,微软为了营造健康和谐的社区环境,减少图片或文本中关于偏见、仇恨、暴力等相关的负面内容,于今年 5 月测试推出了 AI 内容审核工具 Azure AI Content Safety,该工具经过多月测试之后于今天正式发布。

IT之家注:Azure AI Content Safety 提供了一系列经过训练的 AI 模型,能够检测图片或文本中与偏见、仇恨、暴力等相关的负面内容,并可以理解并检测包含八种语言的图片或文本,为被标记的内容严重性进行打分,指示人工审核员哪些内容需要采取行动。

该内容审核工具最初整合到 Azure OpenAI 服务中,微软现在以独立系统方式正式推出。

微软在官方博文中写道:“这意味着客户可以将其用于来自开源模型和其他公司模型的人工智能生成内容,以及调用部分用户生成的内容,进一步扩展实用性”。

微软表示,与其他同类型产品相比,该款产品在公正性和理解上下文方面有显著改进,但该款产品仍需要依赖人工审核人员标记数据和内容。这意味着最终其公正性还是取决于人类。而在处理数据和内容时,人工审核人员可能带着自己的偏见,因此依然无法做到完全中立审慎。