10 月 18 日消息,英伟达是硬件领域的生成型人工智能之王,该公司的 GPU 为微软、OpenAI 等公司的数据中心提供动力,运行着 Bing Chat、ChatGPT 等人工智能服务。今天,英伟达宣布了一款新的软件工具,旨在提升大型语言模型(LLM)在本地 Windows PC 上的性能。

在一篇博客文章中,英伟达宣布了其 TensorRT-LLM 开源库,这个库之前是为数据中心发布的,现在也可以用于 Windows PC。最大的特点是,如果 Windows PC 配备英伟达 GeForce RTX GPU,TensorRT-LLM 可以让 LLM 在 Windows PC 上的运行速度提高四倍。

英伟达在文章中介绍了 TensorRT-LLM 对开发者和终端用户的好处:

在更大的批量大小下,这种加速可显著改善更复杂的 LLM 使用体验,如写作和编码助手,可同时输出多个唯一的自动完成结果,从而加速性能并改进质量,让用户可以有最好的选择。

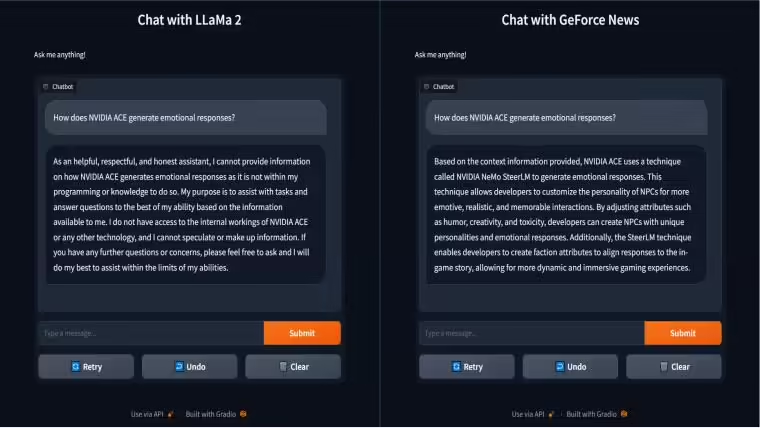

IT之家注意到,博客文章展示了一个 TensorRT-LLM 的例子。当向 LLaMa 2 基础模型提出“《心灵杀手 2》集成了 NVIDIA 的哪些技术?”这一问题时,它给出“游戏尚未公布”这一毫无帮助的回答。相反,使用 RAG 将 GeForce 新闻添加到向量库中,并连接到相同的 Llama2 模型,不仅得到正确答案 ——NVIDIA DLSS 3.5、NVIDIA Reflex 和全景光线追踪,而且在 TensorRT-LLM 加速的助力下响应速度更快。这种速度与能力的结合为用户提供更智能的解决方案。

TensorRT-LLM 很快就会在英伟达的开发者网站上提供。

英伟达今天还在新的 GeForce 驱动更新中增加了一些基于人工智能的功能。其中包括新的 1.5 版本的 RTX Video Super Resolution 功能,可以在观看在线视频时提供更好的分辨率提升效果和更少的压缩效果。英伟达还为 Stable Diffusion Web UI 增加了 TensorRT 人工智能加速功能,让拥有 GeForce RTX GPU 的用户可以比正常情况下更快地从人工智能图片生成器那里获得图像。