1.内存淘汰的意义与挑战

在这一节中,我们将讨论为什么Redis需要内存淘汰策略以及面临的挑战。我们会引入内存淘汰的概念,解释为什么在Redis中需要找到合适的数据淘汰方式。

内存淘汰的意义

在现代应用中,数据量不断增长,需要高速的数据存储和访问。然而,内存资源有限,如何优雅地管理数据成为一个挑战。这时,内存淘汰策略的出现变得至关重要。

为什么Redis需要内存淘汰策略

Redis是一种基于内存的数据库,将数据存储在内存中以实现高速读写。然而,随着数据不断写入,内存会变得紧张。为了保持高性能,Redis需要一种机制来决定哪些数据可以留在内存中,哪些需要被淘汰。

内存淘汰带来的挑战与问题

在制定内存淘汰策略时,需要权衡多个因素,如数据的访问频率、数据的重要性等。不恰当的策略可能导致常用数据被移除,影响性能,或者重要数据无法被保留。因此,Redis需要一套智能的内存淘汰机制来解决这些挑战。

2. 常见的内存淘汰策略与特点

在这一节,我们将介绍几种常见的Redis内存淘汰策略,包括LRU、LFU、随机等。我们会分析每种策略的特点,以及它们在不同场景下的适用性。

常见的内存淘汰策略

在处理内存资源有限的情况下,Redis采用了多种内存淘汰策略来决定哪些数据会被移除。其中,最常见的策略包括LRU(Least Recently Used,最近最少使用)、LFU(Least Frequently Used,最不经常使用)以及随机淘汰。

LRU、LFU、随机等策略的特点与区别

- LRU: 按照数据最近被访问的时间来淘汰,最久未使用的数据首先被移除。

- LFU: 根据数据被访问的频率来淘汰,使用频率最低的数据会被优先移除。

- 随机淘汰: 随机选择数据进行淘汰,没有明确的规则,可能导致数据存储不稳定。

这些策略各有特点,适用于不同的业务场景。

如何根据业务场景选择合适的淘汰策略

- 对于访问频率分布均匀的场景,LRU是一个不错的选择,保留了热数据,提高了命中率。

- 如果某些数据的访问频率明显高于其他数据,LFU可以更准确地保留这些热门数据。

- 随机淘汰适用于不需要严格控制的场景,但可能会导致性能不稳定。

代码示例:

根据业务需求和数据特点,选择适合的内存淘汰策略,能够更好地平衡数据存储和性能需求。

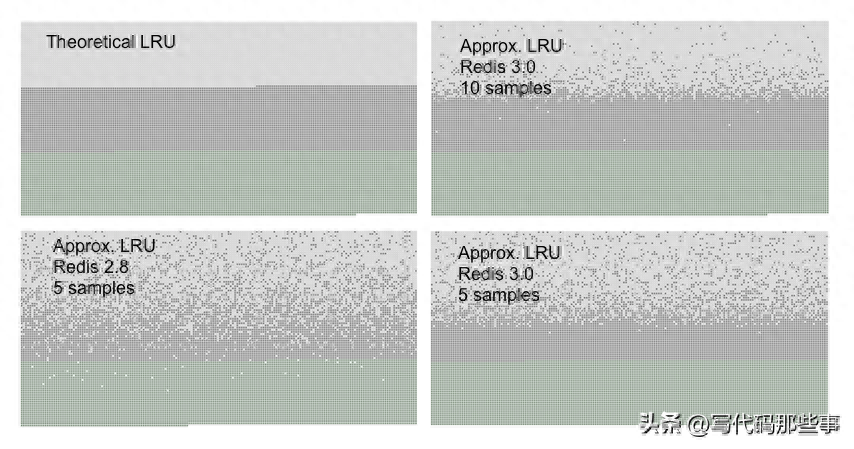

针对上述的随机LRU算法,Redis官方给出了一张测试准确性的数据图:

- 最上层浅灰色表示被淘汰的key,图一是标准的LRU算法淘汰的示意图

- 中间深灰色层表示未被淘汰的旧key

- 最下层浅绿色表示最近被访问的key

3. LRU算法:最近最少使用策略

这一节将深入探讨LRU(Least Recently Used)算法,它是一种基于时间的内存淘汰策略。我们会通过代码示例演示LRU算法的实现,以及如何在Redis中配置和应用LRU策略。

LRU算法的原理与特点

LRU(Least Recently Used,最近最少使用)算法是一种常见的内存淘汰策略,它根据数据的访问时间来决定哪些数据会被淘汰。LRU算法的核心思想是:最久未被访问的数据,被认为是最不常用的数据,应该被优先淘汰。

如何在Redis中配置和使用LRU策略

在Redis中,可以通过修改maxmemory-policy配置项来启用LRU策略。默认情况下,Redis使用的就是LRU策略。你可以根据需要修改该配置项来使用其他内存淘汰策略。

LRU算法的代码实现与注释示例

以下是一个简单的LRU算法的Python实现示例,帮助你更好地理解其工作原理。

在上述代码中,我们使用了OrderedDict来实现LRU算法,保证了数据的访问时间顺序。通过注释,你可以清晰地看到LRU算法的实现细节。

4. LFU算法:最不经常使用策略

在本节中,我们将深入研究LFU(Least Frequently Used)算法,它是一种基于使用频率的内存淘汰策略。我们将通过案例演示LFU算法的应用,以及如何在Redis中应用LFU策略。

LFU算法的原理与特点

LFU(Least Frequently Used,最不经常使用)算法是一种基于数据访问频率的内存淘汰策略。它认为,被访问频率最低的数据应该被优先淘汰。LFU算法的核心思想是:使用频率越低的数据,被认为是最不常用的数据,应该被优先淘汰。

如何在Redis中配置和使用LFU策略

在Redis中,你可以通过修改maxmemory-policy配置项来启用LFU策略。这将使Redis根据数据的使用频率来决定淘汰顺序。

LFU算法的案例与代码实现示例

以下是一个使用LFU算法的Python代码示例,帮助你更好地理解其工作原理。

在上述代码中,我们使用堆和字典来实现LFU算法,保证了按照数据访问频率进行淘汰。通过这个例子,你可以更好地理解LFU算法的实现方式。

5. 常见策略应用场景与最佳实践

在最后一节中,我们将讨论如何根据业务场景选择策略。我们会探讨如何利用Redis提供的API,编写自己的淘汰策略函数,并分享一些最佳实践。

淘汰策略

The exact behavior Redis follows when the maxmemory limit is reached is configured using the maxmemory-policy configuration directive.

当内存达到最大限制时,Redis的行为将遵守MaxMemory-Policy配置指令

有以下可用的策略:

- noeviction: 达到内存限制时不会保存新值。当数据库使用复制时,这适用于主数据库

- allkeys-lru: 保留最近使用的密钥;删除最近使用的(LRU)键

- allkeys-lfu: 保留经常使用的键;删除最少使用的(LFU)键

- volatile-lru: 删除最少使用的钥匙,将到期字段设置为true

- volatile-lfu: 将其删除最少使用的键,将到期字段设置为true

- allkeys-random: 随机删除键,为添加的新数据腾出空间

- volatile-random: 随机删除将键设置为true的键

- volatile-ttl: 将设置为true的到期字段和最短的剩余时间(TTL)值删除键

The policies volatile-lru, volatile-lfu, volatile-random, and volatile-ttl behave like noeviction if there are no keys to evict matchig the prerequisites.

根据应用程序的访问模式选择正确的驱逐策略很重要,但是您可以在运行应用程序时在运行时重新配置该策略,并使用REDIS信息输出来监视您的设置,并监视使用REDIS信息输出的缓存数量和命中次数

通常,根据经验法则:

当您期望在请求的受欢迎程度中发行幂律时,请使用allkeys-lru策略。也就是说,您希望将一部分元素访问的频率远远超过其余部分。如果您不确定,这是一个很好的选择。

如果您具有连续扫描所有密钥的环状访问,或者当您期望发行版均匀时,请使用Allkeys-mandom。

如果您想能够通过在创建缓存对象时使用不同的TTL值,请使用volatile-ttl向Redis提供有关到期的好候选者的提示。

当您要使用一个实例进行缓存和具有一组持久键时,volatile-lru和volatile-random策略主要是有用的。但是,通常是一个更好的主意来解决两个REDIS实例以解决此类问题。

还值得注意的是,将有效期的值设置为关键成本内存,因此使用诸如allkeys-lru之类的策略是更有效的,因为不需要在内存压力下驱逐键的到期配置。

如何自定义淘汰策略函数

在某些场景下,通用的内存淘汰策略可能无法满足业务需求。幸运的是,Redis允许你自定义淘汰策略函数,从而更好地适应特定需求。

利用Redis提供的API实现自定义淘汰

通过利用Redis提供的Sorted Set(有序集合)数据结构,你可以实现自己的淘汰策略。以评分机制为例,你可以在每个数据项上设置一个分数,根据分数来决定淘汰顺序。

实际项目中的最佳实践与经验分享

- 业务需求为主: 在自定义淘汰策略时,始终以业务需求为主导。深入了解数据的访问模式、重要性以及访问频率,有助于制定更合理的策略。

- 评估性能开销: 自定义淘汰策略可能会引入一定的计算开销。在设计策略时,需要评估性能开销,确保不会影响整体系统性能。

- 定期优化策略: 随着业务的演变,自定义淘汰策略可能需要进行优化和调整。定期审查和优化策略,保证其与业务需求保持一致。

- 数据冷热分离: 一些业务场景中,数据的热度是变化的。可以考虑将热数据和冷数据分开存储,采用不同的淘汰策略,从而更好地平衡性能和存储消耗。

通过自定义淘汰策略,你可以更好地满足复杂业务需求,优化数据管理,并在实际项目中获得更好的性能和效果。

总结:

通过本教程,你已经全面了解了Redis内存淘汰策略的重要性和应用。从LRU到LFU,从常见策略到自定义策略,你掌握了在数据存储和性能之间寻找平衡的关键技巧。

Redis内存淘汰策略在数据管理和性能优化中具有重要意义,帮助你充分利用内存资源,提高应用的性能和可靠性。愿你在实际项目中能够灵活应用这些知识,为你的Redis应用注入新的活力和效率。