讲真,机器狗的花活见得多了——

但今天还是有被惊艳到。

来自CMU的最新成果,直接让狗子学会了:

两倍身长的跳高、跳远、倒立撒欢儿甚至倒立下楼梯

话不多说,直接放图感受一波:

△ 这是跳远

△ 这是跳高

△ 倒立撒欢儿

△ 倒立下楼梯

不得不说,尤其跳高那段中的“挣扎”显得狗子特别灵魂。

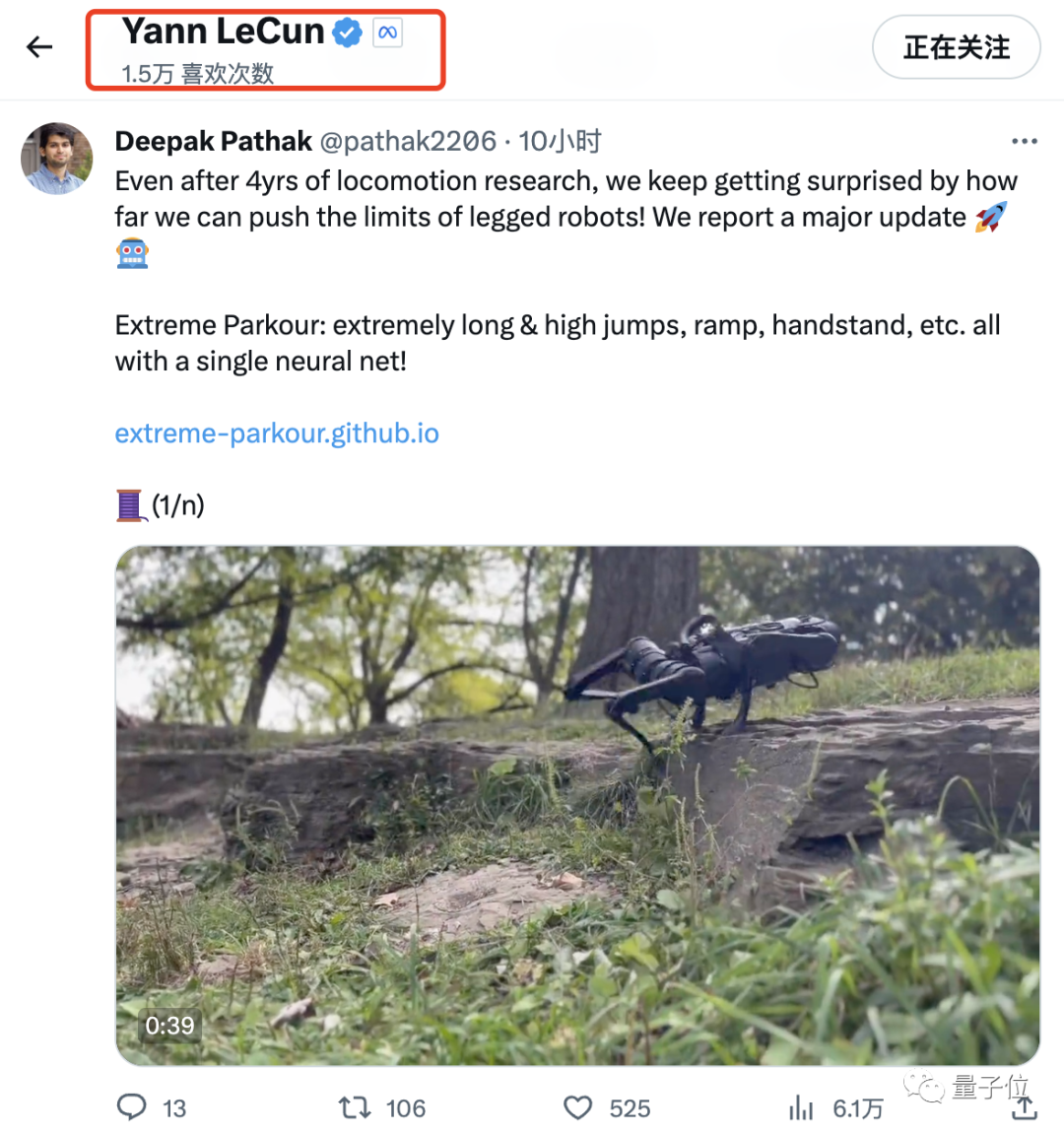

除了这些s操作,CMU也公布了几段跑酷视频,完全自主的那种。

上坎儿、过缝隙、跨斜坡,那叫一个溜。

中间即使有“失误”,也丝毫不影响它立即前进。

笑鼠,甚至还给安排了一段压力测试,结果当然是“通过”~

最厉害的是,据CMU介绍,以上这些极限操作,全部靠单个神经网络完成。

LeCun大佬听了,都得反手一个赞。

如此灵魂,如何炼成?

在推文中,作者对这只狗子的技术进行了挨个解析。

首先,比起基于视觉的端到端行走,2倍身长跳高跳远这种极限操作可谓完全不属同一个level。

毕竟,任何一个失误都可能是“致命的”。

对此,CMU采用sim2real来实现精准的足部控制和挑战,最大限度地发挥机械优势。

其中,模拟器用的是Gym。

其次,倒立。用两条腿行走显然比用四条腿要困难得多。

但CMU的机器狗使用相同的基本方法同时实现了这两种任务,甚至还可以一边倒立一边下楼梯。

第三,对于跑酷操作来说(本研究重点),机器狗必须通过精确的“眼部肌肉”协调来自己决定前进方向,而非听从人类指挥。

比如连续过两个斜坡时,它需要以一个非常特定的角度跳上坡道,然后立即改变方向。

为了学会这些正确的方向,CMU使用MTS(Mixed Teacher Student)系统来教会机器狗。

其中,仅当预测方向接近真实值时才会被系统采纳。

具体而言,该系统分为两个阶段:

第一阶段,先利用RL学习一种移动策略,该过程可以访问一些特权信息,除了环境参数和扫描点(scandots)以外,CMU还为机器狗适当提供了一些标志点(waypoints),目的是引导大体方向。

然后,使用正则化在线自适应(Regularized Online Adaptation ,ROA)来训练评估器,以便从观察历史中恢复环境信息。

第二阶段,从扫描点(scandots)中提取策略,系统将根据该策略和深度信息自主决定如何前进,从而敏捷地输出电机命令。

整个过程就像“老师教,学生举一反三学习”。

除了这个系统之外,由于跑酷需要用上各种不同动作穿越障碍,因此为每一个障碍设计特定奖励函数也是一件头疼的事儿。

在此,作者选择为所有任务制定了一个统一且简单的内积奖励函数。

它可以自动产生不同的奖励,并完全适应不同的地形形状。

没有它,狗子的表现就是这样的:

最后,CMU还提出了一种全新的双重蒸馏(dual distillation)方法,用于从深度图像中提取敏捷的运动指令和快速波动的前进方向。

同样,没有它,狗子的表现也跟个“醉汉”似的:

经过如上一番操作,这只狗子终于学会了全新的自主跑酷,并穿插高难度动作。

是不是很心动?别急:

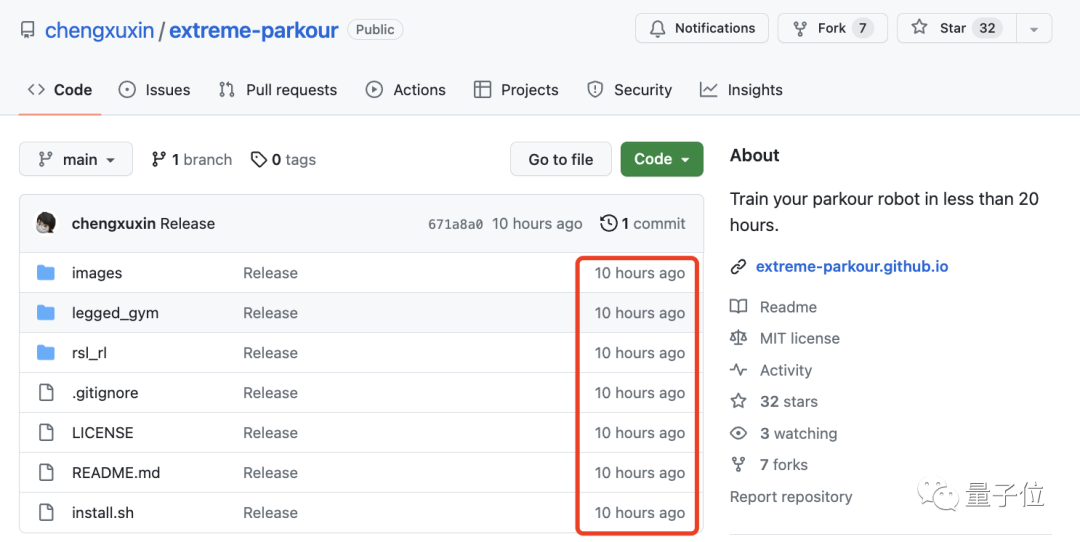

以上这些成果,CMU已全部开源(瞧这日期,还是热乎的呢)。

同时,论文也上线了。大家可以在结尾获取。

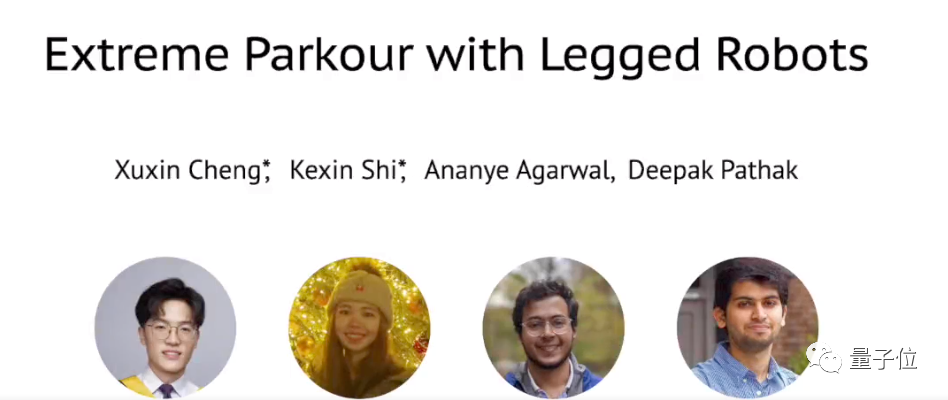

作者介绍

本研究全部由CMU完成,一共四位作者。

其中两位共同一作,且都是华人:

一位叫Xuxin Cheng,这项工作是他在CMU读研时完成的,他现在是加州大学圣地亚哥分校(UCSD)的博士生,导师为王小龙;

另一位叫石可心,CMU机器人研究所的访问学者。她本科毕业于西安交大。

项目主页(包含论文、代码等链接):https://extreme-parkour.github.io/