起猛了!

就在昨天,美国知名播客主播Lex Fridman与小扎开启了1个小时的元宇宙「面对面」聊天,震惊了全世界。

Lex Fridman聊着聊着,直言「我差点忘记,眼前的你不是真人」。

图片

图片

他们戴上Meta的头显,相隔数百公里,却能如此逼真还原Aavtar的面部表情和动作。

而这背后,是19年Meta提出的一个轻松创建虚拟人化身的技术Codec Avatars,只需要一部手机,就能捕捉人类细微的表情差异。

有网友表示,别说人家聊的身临其境,就连自己看的太投入,9分钟的时候,恍然间觉得他们就是真人在对话!

甚至让前谷歌科学家David Ha改变了对「元宇宙」怀疑的态度。

大约13个月的时间,小扎对于元宇宙的「真爱」似乎开始要有回报了。

从2021年到现在,Meta元宇宙实验室投入数百亿美元都赔了本,但是也终让人们看到了「头号玩家」里的世界离我们更近一步。

接下来,一起看看小扎和Lex虚拟化身对谈的精彩瞬间吧。

访谈实录

一出场,Fridman和小扎的访谈就在元宇宙中开始了。

虽然一个人在加州,一个人在德州奥斯丁,通过Codec Avatar和3D立体声技术,两个人就像直接面对面坐在一起一样,开始了这场可能会载入史册的会面和聊天。

Fridman调整了一下光源的位置,两个人都明显感到了光线的变化。

而两个人周围的其他的地方,都是漆黑一片。

看着对方清晰的脸和生动的表情,真的觉得这一切就发生在了一个关了灯的房间里。

而Fridman最直观的感受是,这一切实在是太真实了,真实得让人有点接受不了。

在这样的一个环境之下,长达一个小时的访谈开始了。

访谈涉及了小扎对于元宇宙的畅想,以及什么是「真实」的讨论,而最令大家关注的,应该还是小扎对于AI和元宇宙结合前景的看法,以及他对Meta AI未来的计划。

三年全身模拟就来

在小扎看来,未来 AI 技术将会在元宇宙中扮演非常重要的角色。

未来肯定会有非常强大的超级人工智能,但是依然会有很多AI工具能让人们非常方便的完成各种各样的任务。

他以Fridman的播客节目举例,播客主播需要尽可能的保持和自己的社区观众的互动。但是主播不可能 24 小时不休息地来做这个事。

如果能够在元宇宙中建立一个AI来帮助主播来维持自己粉丝社区的活力,满足粉丝们提出的各种要求,将会让主播能完成以前可能完全没有办法完成的事情。

而且Meta希望这样的AI不仅仅是出现在元宇宙中,而是在现在已经有的各种平台上,来帮主播、

网红们维护自己的粉丝、用户社区。

Meta未来会尽快发布这个功能,赋能更多的内容创作者。

进一步地,Meta AI会更多地出现在元宇宙的各个地方,和用户进行交流,为用户提供帮助。

不同的AI角色在元宇宙中会以不同的性格展现出来,为用户提供非常丰富多样的体验。

而现在这些不同角色的AI已经处于最后的准备阶段了。Meta希望能让这些AI更加可预测,保障安全性。

除了让普通用户在元宇宙中的体验更好,AI可以在元宇宙中为企业,或者代表企业向客户提供各种各样严肃专业的服务。

在元宇宙的游戏中,AI能让NPC表现得更加吸引人。他们一个正在开发的类似剧本杀的史努比游戏,AI作为游戏的主持人表现非常好,非常搞笑,很有意思。

Llama 3在路上

Fridman继续问了小扎关于Meta AI目前的一些情况,关于Llama 2和未来的Llama 3,小扎也知无不言,不断爆料。

在上一次和Fridman的播客中,小扎和他讨论了关于是否开源Llama 2,小扎很高兴Meta最终这么做了。

在小扎看来,现在开源一个Llama 2这样的基础模型的价值,远远大于风险。

小扎说在开源之前,Meta花了很多时间,进行了非常严格的评估和红队模拟,最终才开源了它。Llama 2的下载和使用量比小扎预期的还要多。

Llama 3呢,肯定会有的。不过在开源Llama 2后,现在Meta的优先事项是将其集成到各种消费者产品中。

因为Llama 2本身并不是一个消费者产品。它更像是一个基础设施,人们可以用它来构建东西。所以,现在的重点是继续微调,并且,就是让Llama 2及以及各个版本能够服务好消费者产品。

希望有一天数以亿计的人会喜欢使用这些产品。

但是,Meta也在致力于开发未来的基础模型。现在没有太多能透露的,不过肯定也会像Llama 2一样,经历严格的红队测试才会公布。

小扎也希望,当Llama 3成型时,Meta会继续开源。但是,这个事Meta还没有最终确定下来,因为现在离Meta发布下一代基础模型还比较遥远。

不过开源模型能够让人们更好地体验模型能做什么事情,比如小扎本人就很沉迷于和各种各样的AI虚拟角色聊天,非常上头。

人类未来生活

对于未来人类的生活,小扎说,元宇宙会无处不在!

最简单的例子就是电话,未来人类会像现在打电话一样,体验到自己和虚拟世界的真实互动。

比如两个人可以随时随地体验他们两现在的交流方式,除了两个没有真的坐在一间屋子里,其他方面这样的交流会和面对面的交流没有任何区别。

因为从哲学的角度来看,真实世界的本质就是我们能够感知到的东西和实际存在的东西的结合。

数字世界如果能够越来越好的还原这个方面,数字世界就能变得越来越丰富和强大。

最后,Fridman问小扎,你该不会是坐在沙滩上和我聊的吧。

小扎说,没有,我坐在会议室里。

Fridman说,可惜了,我就坐在沙滩上,而且我裤子都没穿,幸好你们没看到我真实的样子。

Codec Avatars:一部手机,化身就来

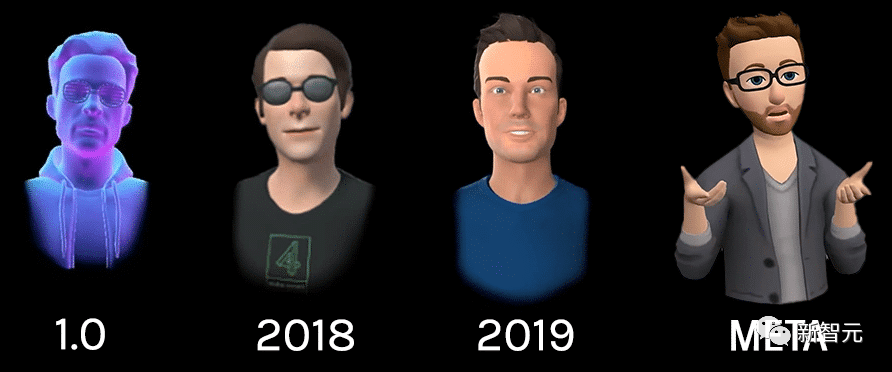

其实,我们看到博客视频中,如此惊艳的技术,其实Meta早在19年就研发出来了。

它就是——Codec Avatars。

若想在元宇宙中实现真正的交互,虚拟化身可是打开元宇宙这道门的任督二脉。

Codec Avatars这一项目旨在实现一个能够捕获和表示用于XR的逼真头像的系统。

最初这个项目是以高质量的头像演示开始,后来逐渐实现构建全身的虚拟化身。

在Connect 2021大会上,研究人员Yaser Sheikh曾展示了该团队最新的成果——全身视频编解码器(Full-body Codec Avatars)。

与此同时,Codec Avatars支持更复杂的眼部运动、面部表情、手部和身体姿势。

此外,Meta还展示了虚拟化身在对不同的光照条件和环境下实现头发和皮肤的真实渲染。

Meta开始制作Codec Avatars的契机要追溯到9年前。

2014年,卡内基梅隆大学机器人研究所旗下的一家3D捕捉实验室Panoptic Studio的负责人Yaser Sheikh遇到了Oculus首席科学家Michael Abrash,两人聊得非常投机。

左:Michael Abrash;右:Yaser Sheikh

2015年,Yaser Sheikh加入了Meta,从那以后便一直领导着Codec Avatars研究团队。

「要想打造一个逼真的化身,基础在于测量」,Codec Avatars研究科学家托马斯·西蒙说。

「化身要以假乱真靠的是精确的数据,这需要良好的测量。因此,构建真实化身的关键是找到一种方法来测量人类表情中的物理细节,比如一个人眯起眼睛或皱起鼻子的方式。」

在匹兹堡实验室的Codec Avatars团队,使用了两个主要的模块来测量人类的表情:编码器和解码器。

而现在,人们只需要一部手机,就能精确捕捉到面部表情的信息。

直接在元宇宙中还原真身。

网友惊呼:恐怖谷

看过这期博客的网友们,纷纷被视频中的效果惊艳。

英伟达高级科学家Jim Fan表示,

本期 @lexfridman 将作为第一个由虚拟化身的视频会议制作的播客载入史册。

在未来3-5年内,我们将彻底跨越Avatar和模拟的「恐怖谷」。

在我的职业生涯中,我一直在研究化身智能体。我们的终极愿景是实现场景:人类和人工智能的全身实时化身,共享同一个虚拟空间,以逼真的方式与物体互动,接收丰富的多模态反馈,忘记世界只是一个模拟。

虽然化身现在需要用特殊设备进行扫描,但扎克暗示,智能手机自拍视频很快就能实现。

鉴于3D生成模型的最新进展,我认为几个月内就能实现。细粒度手指追踪和全身追踪将是下一个目标。

从3个像素的头像怎么一下就进化到这个了?一定是我起猛了!

去年Meta在广告和市场营销上花了26亿美元,这个播客的效果比这些钱效果好多了,Lex赶快让小扎给你打钱!

虽然眼球追踪还有些小错误,但是表情的精准呈现让人忘了这其实只是虚拟化身。未来已来!

怪不得马斯克找不到小扎,原来小扎躲到这里了!

最后,访谈原视频放在这里了。