假期出游,肯定少不了拍照留念。不过,大部分在景区拍摄的照片或多或少都有些遗憾,背景里不是多了些什么,就是少了些什么。

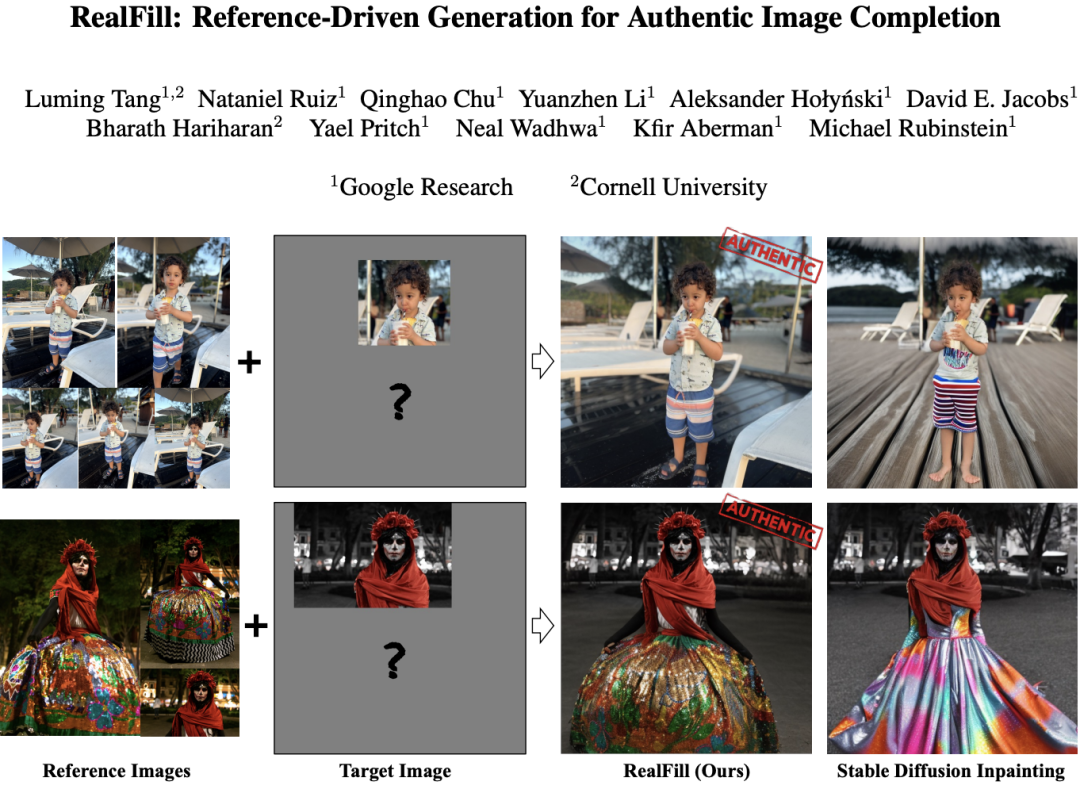

获得一张「完美」的图像,是 CV 研究人员长期以来努力的目标之一。日前,Google Research 和康奈尔大学的研究人员合作,提出了一种「真实的图像补全」(Authentic Image Completion)技术——用于图像补全的生成模型 RealFill。

RealFill 模型的优势是可以使用少量的场景参考图像进行个性化设置,而这些参考图像无须与目标图像对齐,甚至可以在视角、光线条件、相机光圈或图像风格等方面有极大的差异。一旦完成个性化设置,RealFill 就能够以忠实于原始场景的方式,用视觉上引人入胜的内容来补全目标图像。

- 论文链接:https://arxiv.org/abs/2309.16668

- 项目页面:https://realfill.github.io/

补画(inpainting)和扩画(outpainting)模型是能够在图像的未知区域生成高质量、合理的图像内容的技术,但这些模型生成的内容必然是不真实的,因为这些模型在真实场景的上下文信息方面存在不足。相比之下,RealFill 能够生成「应该」出现在那里的内容,从而使图像补全的结果更为真实。

作者在论文中指出,他们定义了一个新的图像补全问题——「真实图像补全」(Authentic Image Completion)。不同于传统的生成型图像修复(替代缺失区域的内容可能与原始场景不一致),真实图像补全的目标是使补全的内容尽可能忠实于原始场景,用「应该出现在那里」的内容来补全目标图像,而不是用「可能在那里」的内容。

作者表示,RealFill 是首个通过在过程中添加更多的条件(即添加参考图像)来扩展生成型图像修复模型表达力的方法。

在一个涵盖了一系列多样化且具有挑战性的场景的新的图像补全基准测试中,RealFill 的表现大大超过了现有的方法。

方法

RealFill 的目标是在尽可能保持真实性的前提下,使用少量的参考图像来补全给定目标图像的缺失部分。具体说,给定最多 5 张参考图像,和一张大致捕捉到相同场景(但布局或外观可能不同)的目标图像。

对于给定的场景,研究人员首先通过在参考图像和目标图像上微调一个预训练的 inpainting 扩散模型,创建一个个性化的生成模型。这个微调过程被设计成让微调后的模型不仅保持良好的图像先验,还能学习输入图像中的场景内容、光照和风格。然后,使用这个微调过的模型,通过标准的扩散采样过程来填充目标图像中的缺失区域。

值得注意的是,为了实际的应用价值,该模型特别关注更具挑战性、无约束的情况,即目标图像和参考图像可能有非常不同的视点、环境条件、相机光圈、图像风格,甚至包括移动的对象。

实验结果

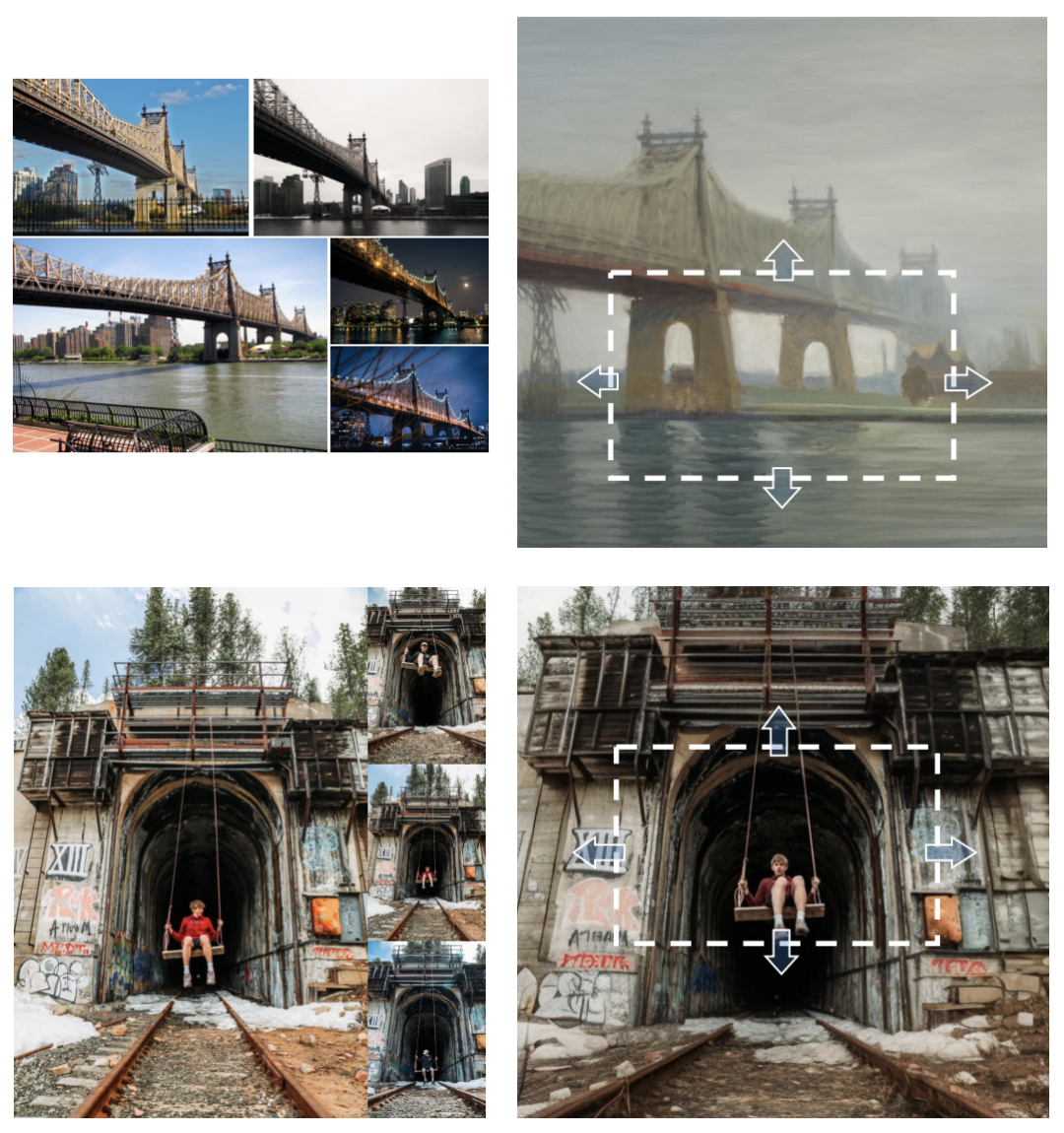

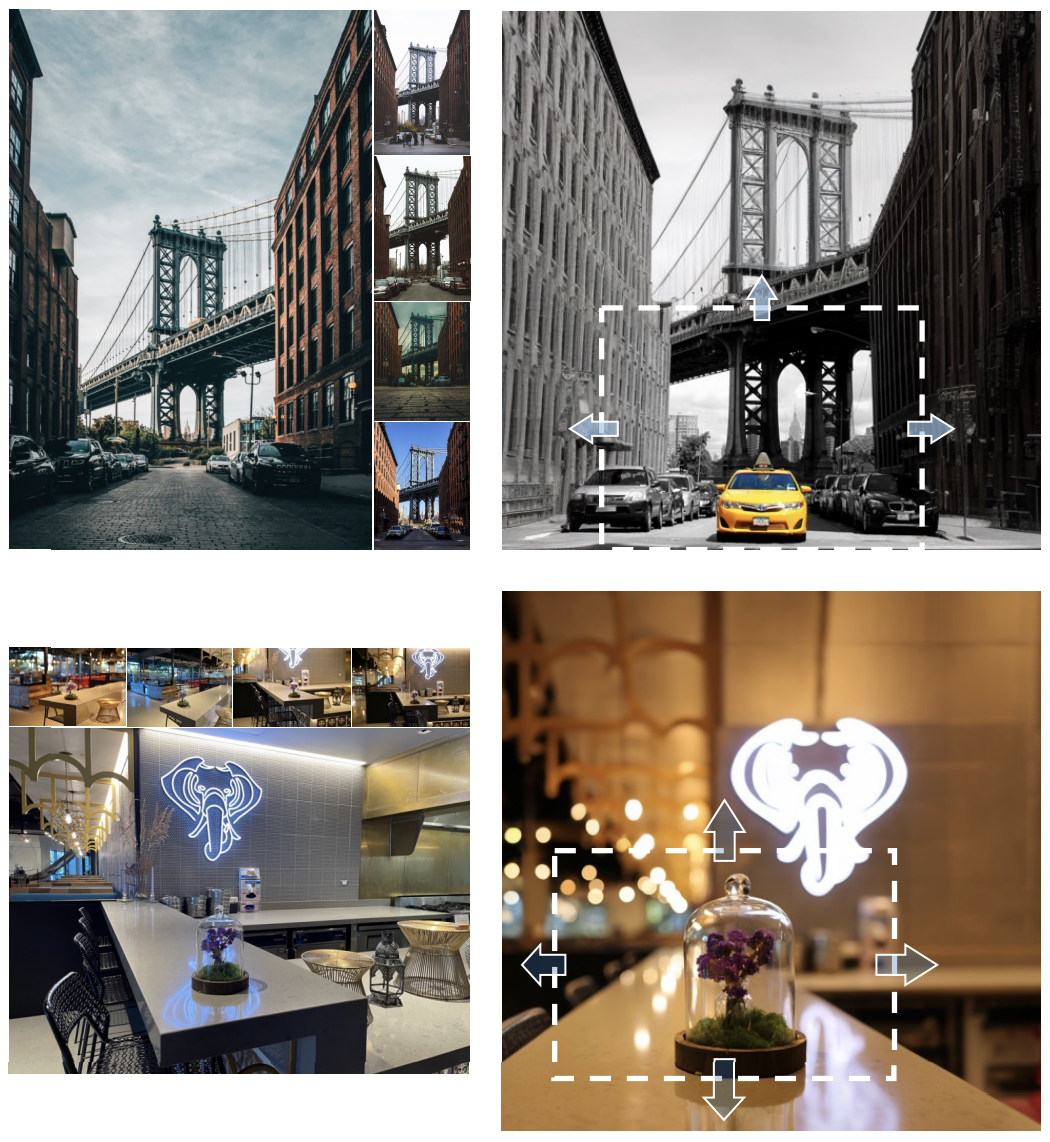

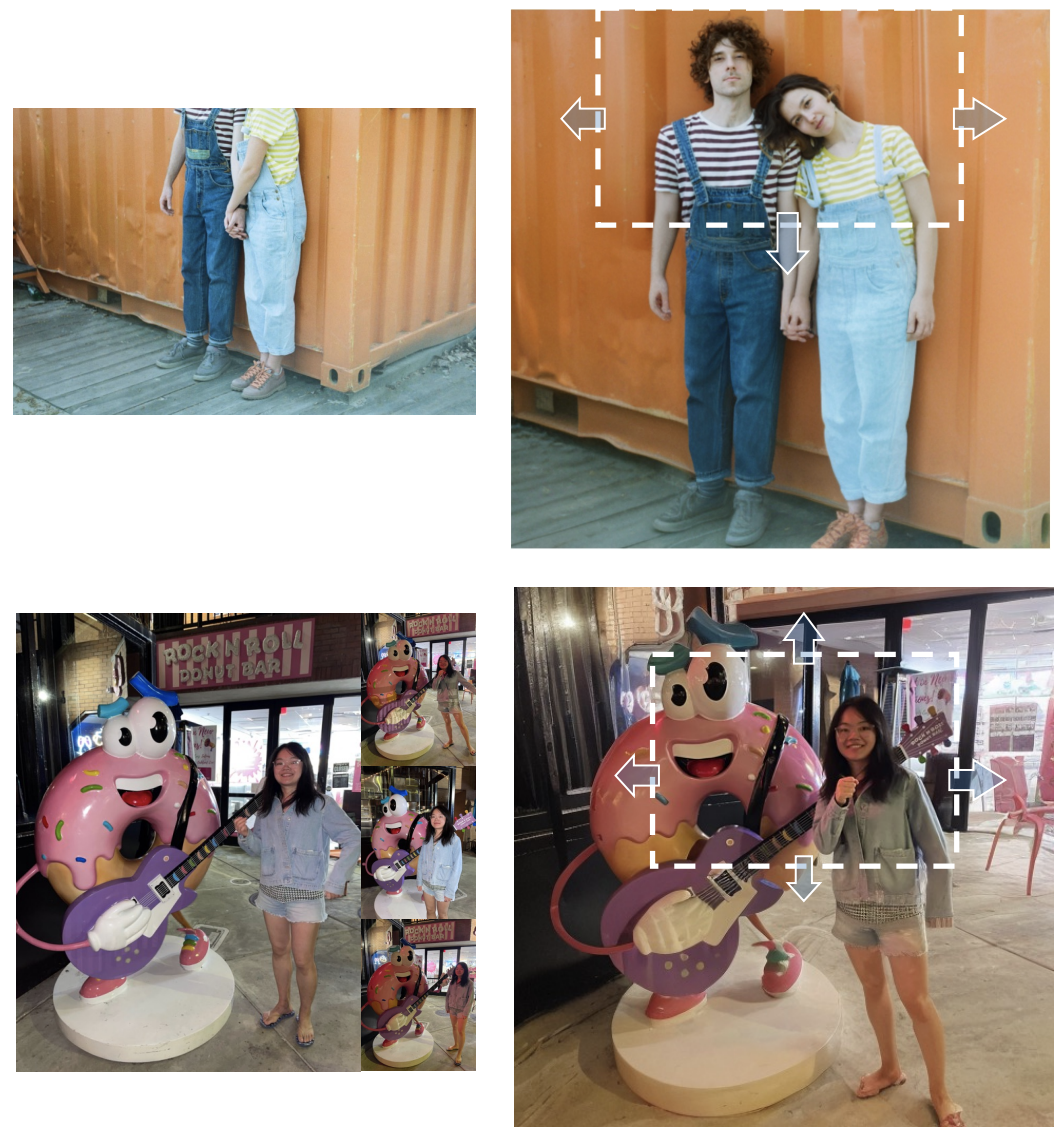

根据左侧的参考图像,RealFill 能够对右侧的目标图像进行扩展(uncrop)或修复(inpaint),生成的结果不仅视觉上吸引人,而且与参考图像保持一致,即使参考图像和目标图像在视点、光圈、光照、图像风格和物体运动等方面存在较大差异。

RealFill 模型的输出效果。给定左侧的参考图像,RealFill 能够扩画出对应的右侧目标图像。白色框内的区域被提供给网络作为已知的像素,而白色框外的区域都是生成的。结果显示,即使参考图像和目标图像之间存在包括视点、光圈、光照、图像风格和物体运动等巨大差异,RealFill 也能生成高质量且忠实于参考图像的图像。来源:论文

对照实验

研究人员比较了 RealFill 模型和其他的基准方法。相比之下,RealFill 生成的结果质量高,在场景保真度和与参考图像的一致性方面,RealFill的表现更好。

Paint-by-Example 无法实现高度的场景保真,因为它依赖于 CLIP 嵌入,而 CLIP 嵌入只能捕获高级语义信息。

Stable Diffusion Inpainting 虽然可以产生看似合理的结果,但由于 prompt 的表达能力有限,所以最终生成结果与参考图像并不一致。

RealFill 与其他两种基线方法的比较。覆盖了一层透明白色掩码的区域是目标图像未修改的部分。来源:realfill.github.io

局限

研究人员也讨论了 RealFill 模型的一些潜在的问题和限制,包括处理速度、对视点变化的处理能力,以及对基础模型具有挑战性的情况的处理能力。具体说:

RealFill 需要对输入图像进行基于梯度的微调过程,这使得它的运行速度相对较慢。

当参考图像和目标图像之间的视点变化非常大时,RealFill 往往无法恢复 3D 场景,特别是当只有一张参考图像的时候。

由于 RealFill 主要依赖于从基础的预训练模型继承的图像先验,因此它无法处理那些对基础模型来说具有挑战性的情况,例如 stable diffusion 模型无法处理好文本。

最后,作者对合作者表示了感谢:

我们要感谢 Rundi Wu、Qianqian Wang、Viraj Shah、Ethan Weber、Zhengqi Li、Kyle Genova、Boyang Deng、Maya Goldenberg、Noah Snavely、Ben Poole、Ben Mildenhall、Alex Rav-Acha、Pratul Srinivasan、Dor Verbin 和 Jon Barron 的宝贵讨论和反馈,同时也感谢 Zeya Peng、Rundi Wu、Shan Nan 对评估数据集的贡献。我们特别感谢 Jason Baldridge、Kihyuk Sohn、Kathy Meier-Hellstern 和 Nicole Brichtova 对项目的反馈和支持。

了解更多可阅读原论文并访问项目主页。