对于NFS来说,其写模式包含同步写,异步写和直接写等模式。模式的差异在于打开文件时指定的参数。限于篇幅,本文很难一一介绍所有模式,这里主要介绍一个核心流程。

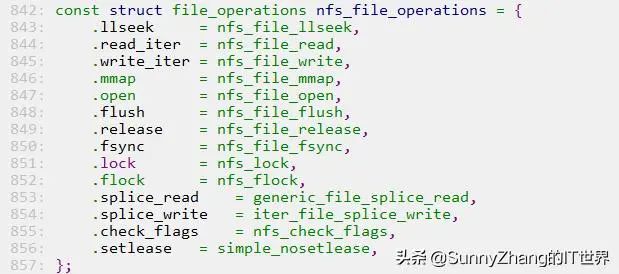

NFS作为Linux下的文件系统,为了实现与VFS的对接,NFS也要实现一套函数指针接口。以文件相关的操作为例,其实现的函数指针如下所示。对于写数据来说,VFS会调用NFS的nfs_file_write函数。

图片

图片

在该函数中,如果有SYNC标记则会触发同步写的流程,否则写入缓存后就会返回给调用者。本节我们主要关注触发同步写的流程,也就是数据是如何从NFS文件系统发送到服务端的。

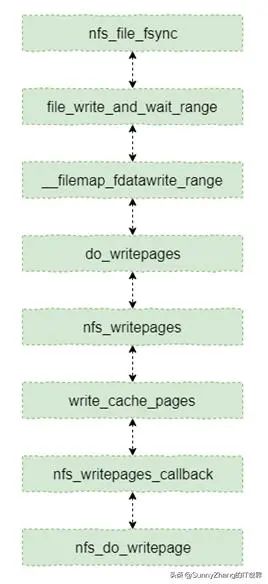

直接写和同步写都会触发将数据发送到服务端的流程,本节以同步写为例介绍数据是如何发送到服务端的。如果触发同步刷写,那么会调用nfs_file_fsync函数,该函数是将缓存数据传输到服务端的入口。该函数到后端访问接口nfs_do_writepage的主线流程如下图所示。

图片

图片

nfs_file_fsync主线流程

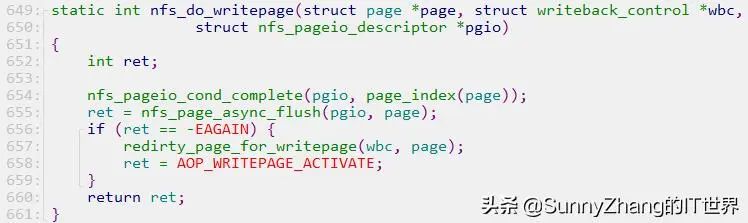

这里nfs_do_writepage用于将一个缓存页发送到服务端,具体实现如下代码所示。其中主要是功能由nfs_page_async_flush函数完成。这里比较重要的参数是pgio,在该参数中有页数据传输相关的函数指针,关于该参数类型的详细定义请参考内核源代码。

图片

图片

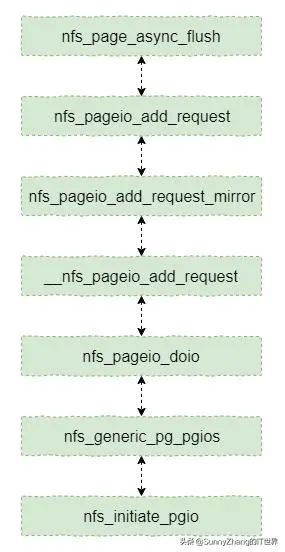

然后我们再从nfs_page_async_flush函数开始计数看一下主线流程,具体下图所示。函数nfs_generic_pg_pgios就是在pgio初始化的函数指针,其在nfs_pageio_doio中被调用。该主线流程最终调用到nfs_initiate_pgio函数,该函数完成PRC消息和参数的封装,然后调用RPC服务的API函数完成请求。

nfs_page_async_flush主线流程

nfs_page_async_flush主线流程

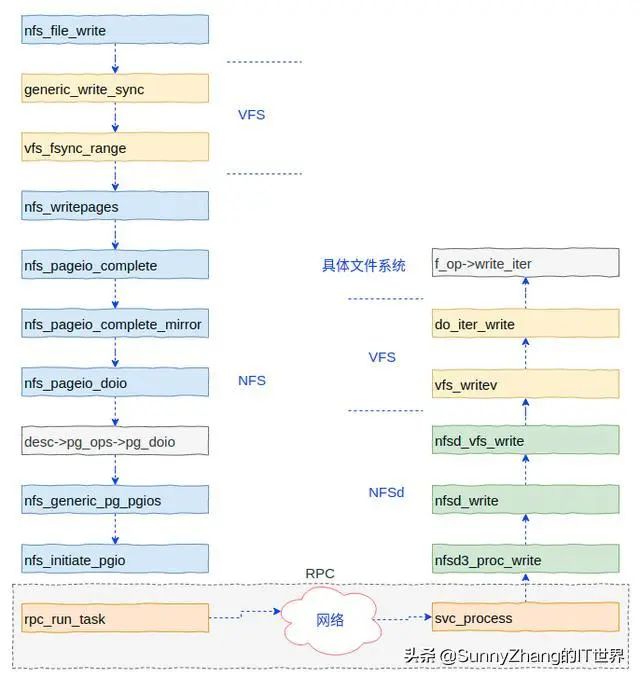

当nfs_initiate_pgio调用rpc_run_task函数后,整个流程就进入RPC服务内部了。也就是进入RPC服务状态机的流程了。关于RPC状态机的处理流程的介绍请参考本号相关内容。

最后,我们将整个写流程的简图展示一下,这里包括客户端的函数调用流程和服务端的处理流程。其中客户端的流程中省略了部分函数调用。

网络文件系统访问示意图

网络文件系统访问示意图

服务端向RPC注册了各种回调函数,当接收到客户端的请求时会调用具体的回调函数进行处理。本例将调用nfsd3_proc_write函数。该函数最后调用VFS层的写数据函数,而VFS写数据函数则调用具体文件系统(例如Ext4)的函数完成最终的写数据操作。