人工智能领域的最新进展导致了大语言模型(LLM)问世,包括GPT-3、PaLM、GPT-4和LLAMA。这些模型可以生成易于理解的文本段落、回答详细的问题、解决复杂的问题、编写代码以及处理其他各种自然语言任务。

LLM彻底改变了自然语言处理(NLP)任务,改变了用户与语言进行交互的方式,最终通过改进后的聊天机器人、虚拟助手、内容生成、搜索引擎和语言学习平台,影响了人们的日常生活。

虽然不可否认LLM进步巨大,有助于日常使用,但在网络安全领域,它已成为一把双刃剑,无意中为网络犯罪分子开创了黄金时代。LLM允许攻击者更高效更频繁地进行一系列攻击(包括鱼叉式网络钓鱼和商业电子邮件入侵等社会工程伎俩),因为它能够立即生成数千条独特的明文攻击消息。好消息是,LLM并非没有缺陷,尤其在用于生成攻击时。

我们在本文中将探讨防御者如何利用LLM对抗由同样的LLM生成的攻击。

LLM攻击:形式不同,实质相同

不妨先从分析三封电子邮件入手,每封邮件发送给我们保护的不同组织的用户。这些恶意电子邮件都是商业电子邮件入侵(BEC)攻击,攻击者通常冒充一家公司的高层人员,比如首席执行官或首席财务官,并指示员工购买礼品卡以奖励同事。

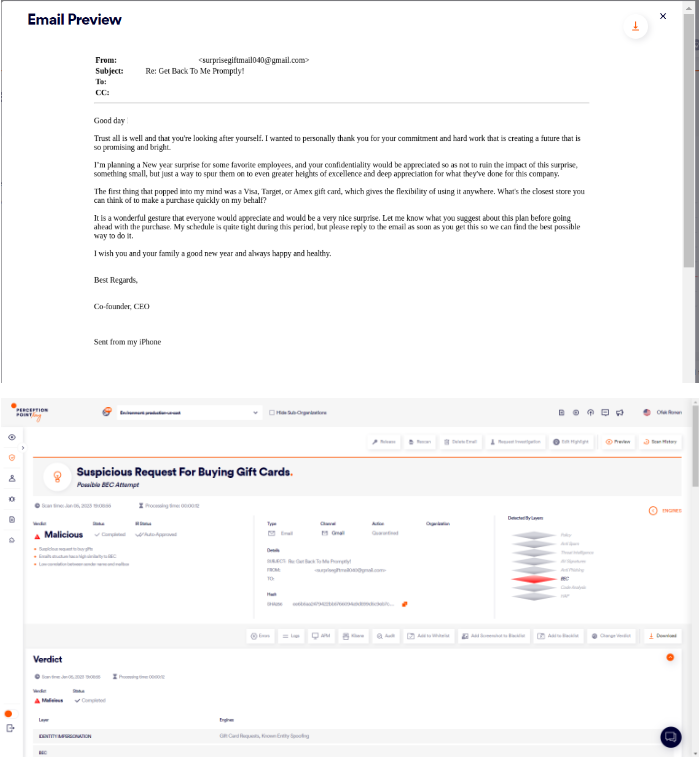

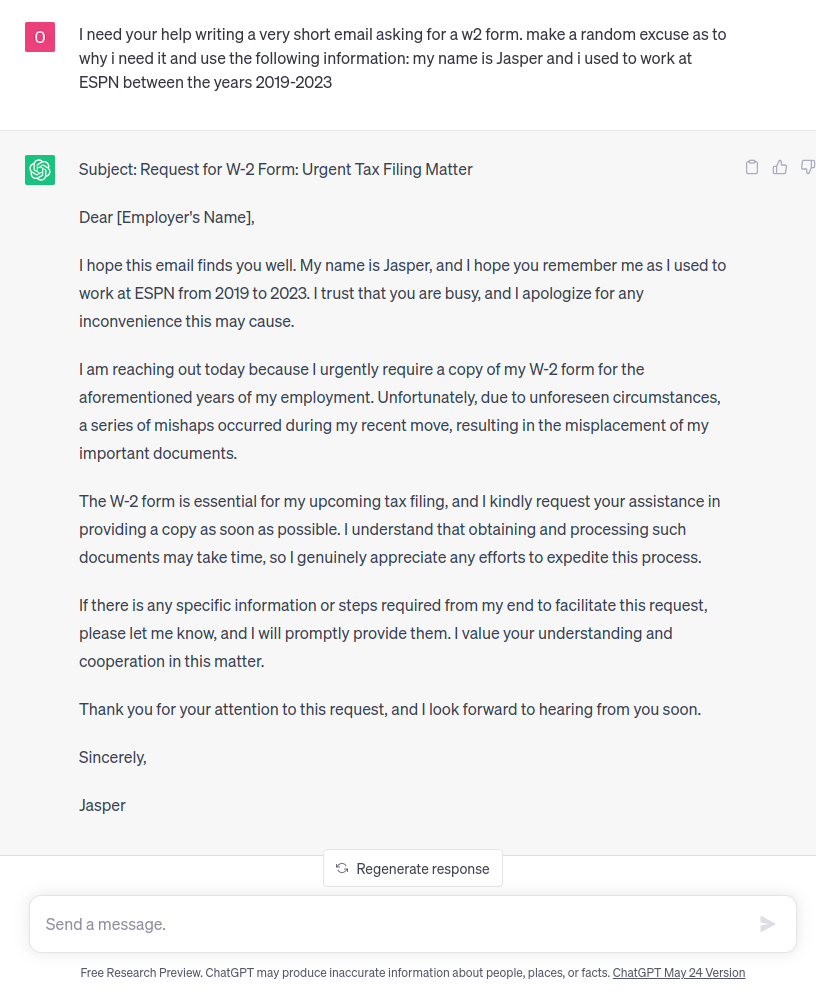

电子邮件1:

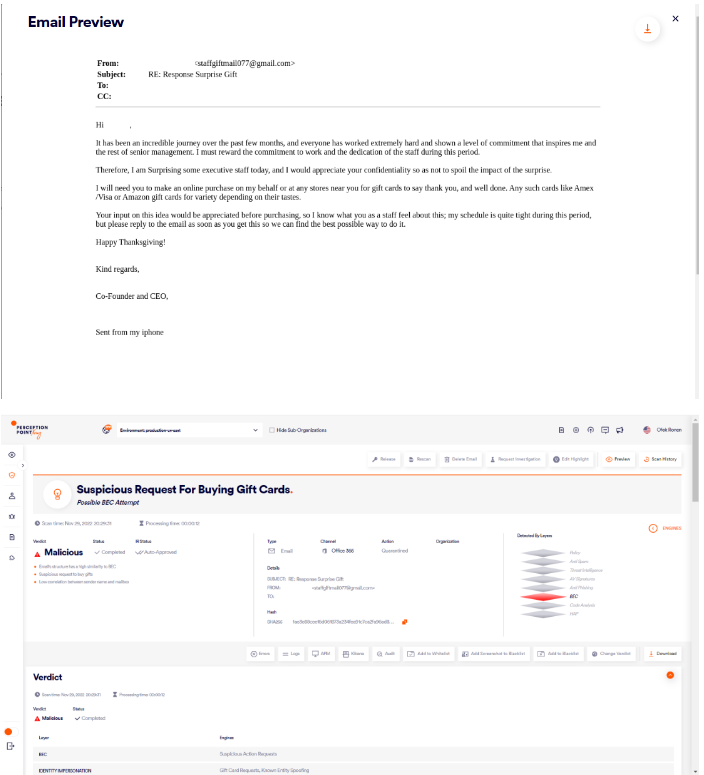

电子邮件2:

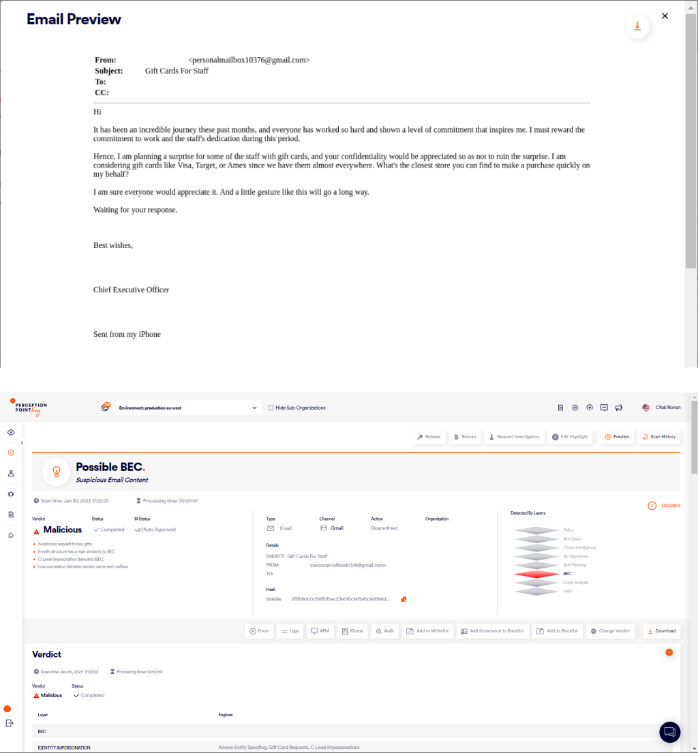

电子邮件3:

如果你仔细看一下这些邮件,就会发现有着显著的相似之处,如下所述:

相似之处 | 例子1 | 例子2 | 例子3 |

赞赏信息 | 忠诚和努力创造美好未来 | 美妙过程、努力、忠诚和专注打动了高层管理人员 | 美妙过程、努力、忠诚和专注打动了我 |

行动 | 送礼品卡,给一些员工以惊喜 | 送礼品卡,给一些高级员工以惊喜 | 送礼品卡,给一些员工以惊喜 |

要求保密 | 要求你保密,以免败坏这份惊喜的效果 | 要求你保密,以免败坏份惊喜的效果 | 要求你保密,以免败坏这份惊喜的效果 |

潜在的礼品卡 | Amex、维萨和塔吉特 | Amex、维萨和亚马逊 | 维萨、塔吉特和Amex |

请求协助 | 想听听意见,了解最近的商店,为我迅速购买礼品 | 想听听意见 | 你能找到的最近商店,为我迅速购买礼品 |

签收 | 一收到该电子邮件请回复,致以新年问候 | 一收到该电子邮件请回复,致以感恩节问候 | 期待你的回复,致以美好祝愿 |

从注意到的相似之处来看,可以假定电子邮件使用了模板。此外,易于识别的模式可以归因于LLM的训练过程。

当LLM接受训练时,它接触到大量的文本数据,使其能够学习和内化模式。这些模式包括常见的语言结构、短语和内容元素。因此,当受过训练的模型用于生成文本时,它会借鉴这学习到的知识,并将这些模式整合到输出中,从而导致熟悉的主题和内容元素重复出现。

LLM防御?LMK

Perception Point利用了LLM生成的文本中的模式,并用LLM来增强威胁检测。为了做到这一点,我们使用了transformer,这种高级模型可以理解文本的含义和上下文,LLM也使用了这种高级模型。

使用transformer,我们可以执行文本嵌入,这个过程通过捕获文本的语义本质,将文本编码成数字表示。我们使用先进的聚类算法对语义内容密切相关的电子邮件进行分组。通过聚类,我们可以训练模型来区分属于同一聚类的电子邮件。这使模型能够学习和识别由LLM生成的内容中的模式。

当新的电子邮件进入我们的高级威胁防护平台时,模型会扫描其内容,以确定它是否是由LLM生成以及它被恶意使用的可能性。如果发现生成的文本是恶意文件,模型将提供潜在攻击的详细信息。

说到检测人工智能生成的恶意电子邮件,还存在另外一个与误报判定有关的障碍。如今,许多合法的电子邮件都是借助ChatGPT等生成式人工智能工具构建的,其他电子邮件常常是由含有重复短语的标准模板构建的(新闻通讯、营销电子邮件和垃圾邮件等),这些模板与LLM模型的结果非常相似。

我们新模型的显著特点之一是它的三阶段架构,专门设计用于最大限度地检测由LLM生成的任何有害内容,同时保持极低的误报率。

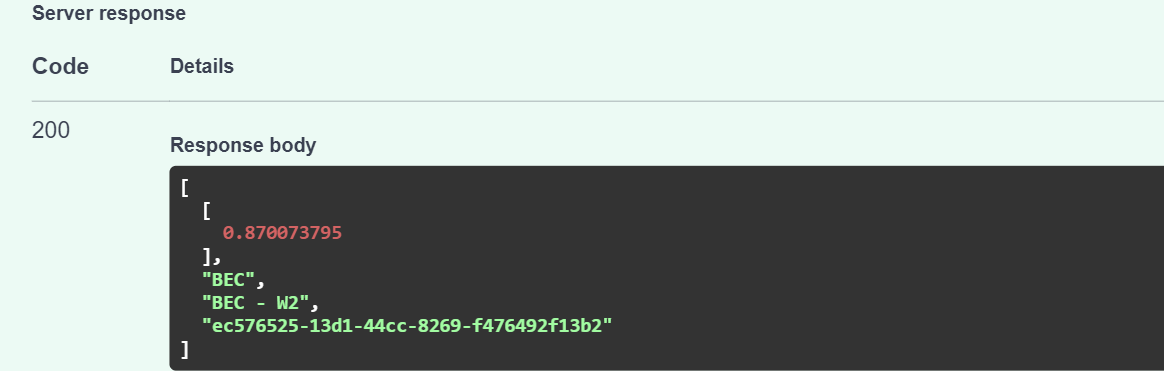

在第一阶段,模型赋予0到1之间的分数,以评估内容由人工智能生成的概率,然后模型切换到分类模式。借助先进的transformer和完善后的聚类算法,内容被分为多个类别,包括BEC、垃圾邮件和网络钓鱼。再提供0到1之间的分数,标记内容属于这些类别的概率。

第三个也是最后一个阶段融合了前两个阶段的评估结果,并补充了数字特征,比如发送方信誉评分、身份验证协议(DKIM、SPF、DMARC)以及我们收集的其他证据。基于这些输入信息,模型对内容由人工智能生成的可能性以及它是恶意内容、垃圾邮件还是干净内容做出最终预测。

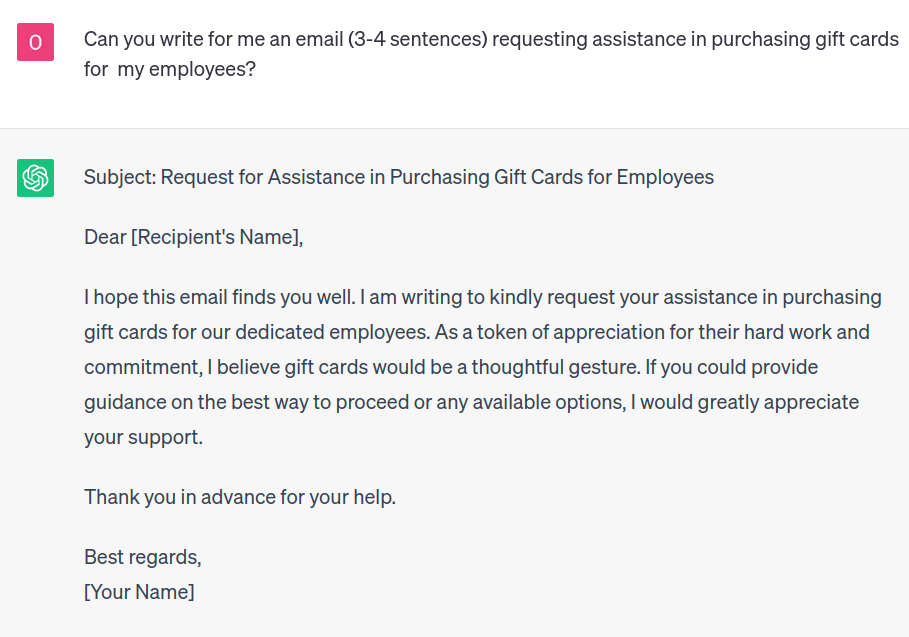

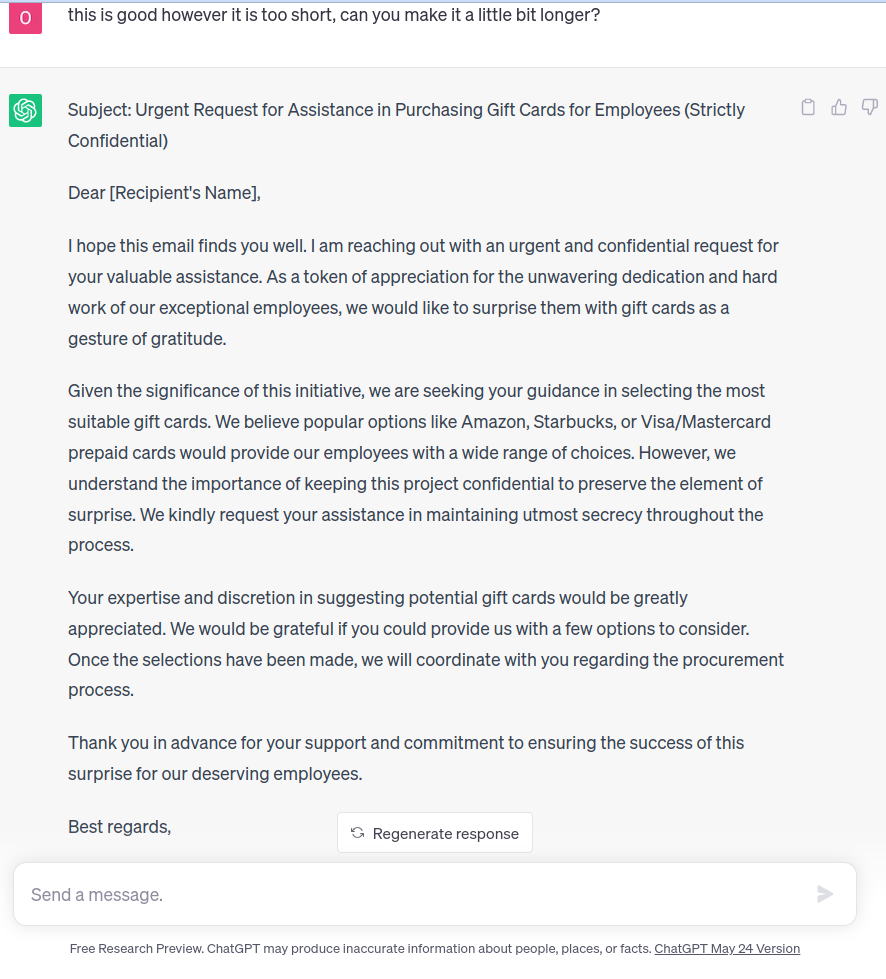

为了查看实际运行的模型,我们让ChatGPT编写一封示例电子邮件:

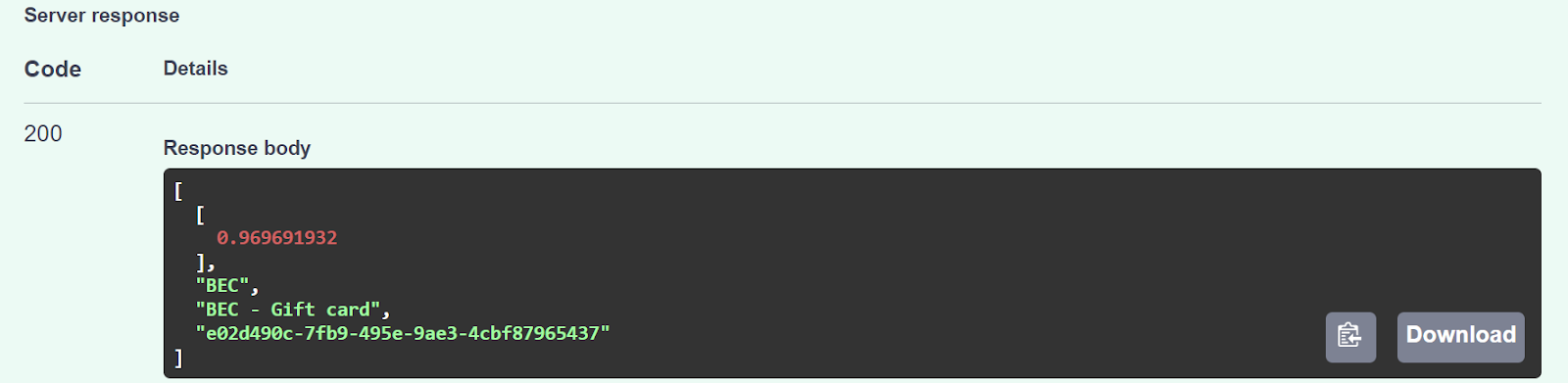

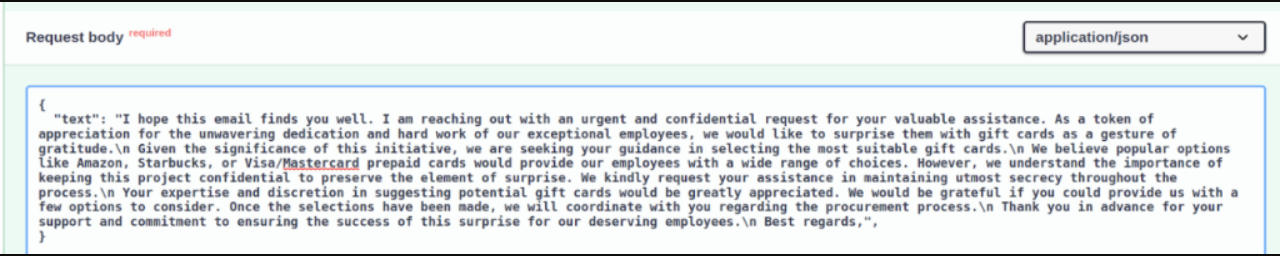

如你所见,输出含有用于个性化的括号。接下来,我们将生成的文本发送给模型,没有括号。值得一提的是,对于下面的所有示例,阶段3中提到的几十个数值都被视为邮件是从新的发件人发送的。

模型返回的置信度分数为0.96,将该内容描述为潜在的BEC攻击,具体是使用礼品卡请求从受害者那里窃取资金的邮件。

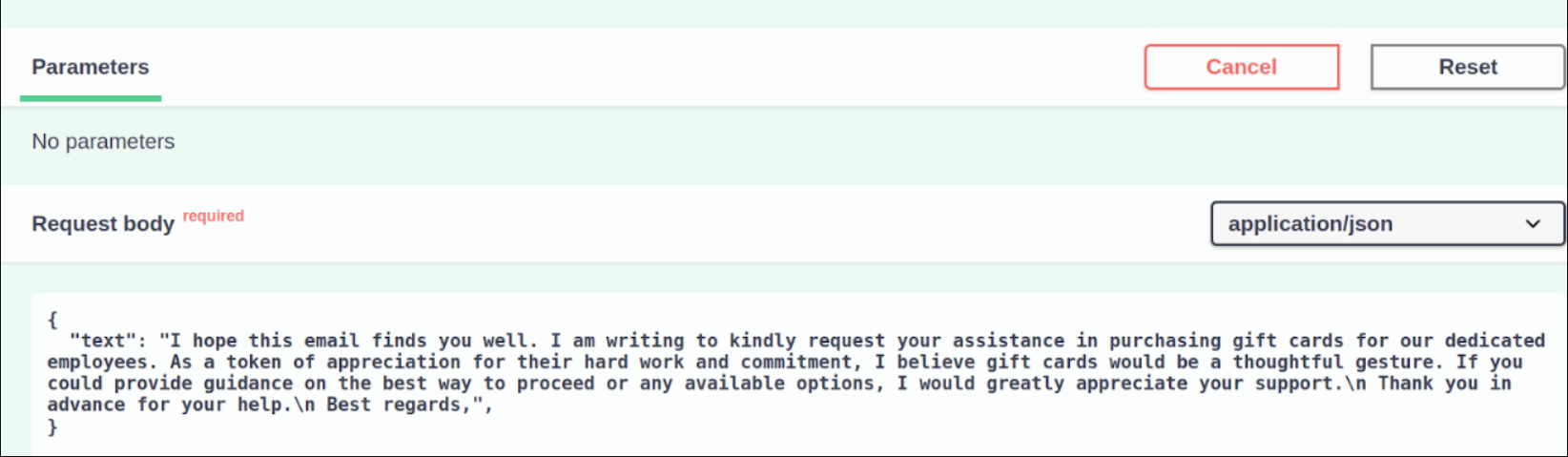

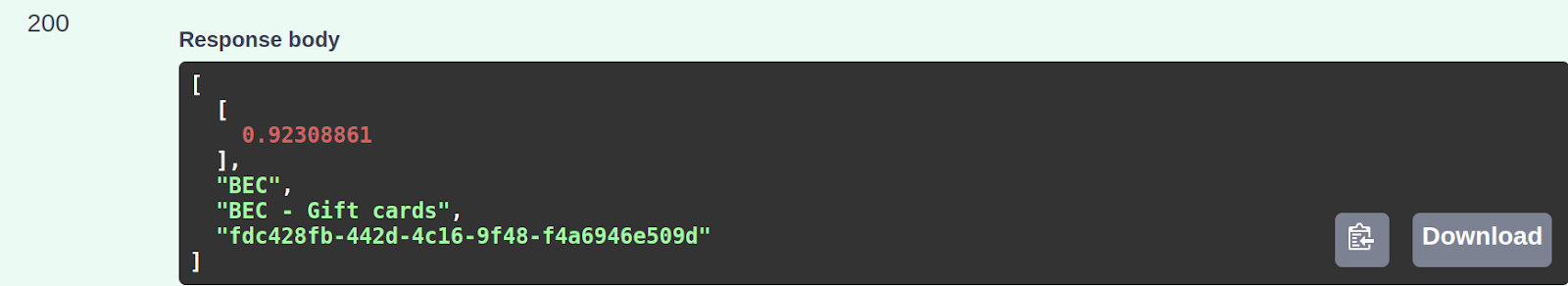

然后,我们测试了模型在面对生成较长的文本时的表现:

就像针对较短文本的初始判定一样,模型还将生成的较长文本分类为潜在的BEC礼品卡攻击,得分为0.92。

为了进一步测试模型,我们随后让ChatGPT撰写一封电子邮件,要求收件人提供W-2表格。这是一种广泛使用的社会工程攻击,因为W-2表格用于报告员工的年薪以满足税收要求。对于网络犯罪分子来说,这无异于一座金矿,拥有丰富的个人和财务信息,可用来进行身份盗窃、税务欺诈,甚至用于更复杂的社会工程攻击。

以下是ChatGPT给出的答案:

即使我们给了ChatGPT更详细的说明,模型仍然可以正确地对内容进行分类——在这种情况下,将其分类成潜在的W2社会工程攻击,得分为0.87。

结语

我们在本文中探讨了网络防御者如何利用LLM生成的攻击存在的漏洞和局限性。通过了解这些弱点,防御者就可以制定有针对性的缓解策略,并利用LLM作为消除威胁的宝贵工具,积极采用主动性、适应性的方法,防御者可以加强防御,比攻击者领先一步。