脑机接口时代,天天都有新鲜玩意儿。

今天带来四个字:脑植音乐。

具体来说,就是先用AI来观察某段音乐会让人的大脑中产生什么样的电波,然后直接在有需要的人的大脑里模拟这个电波的活动,以此来达到治疗某类疾病的目的。

让我们把目光转向若干年前的Albany医疗中心,看看里面的神经科学家们是怎么做的。

语言障碍者的福音!

在Albany医疗中心,一首名叫「Another Brick in the Wall」的音乐悠然响起,充斥着整个医院病房。

而聆听者却不是医生,而是躺在病床上准备接受癫痫手术的病人们。

神经科学家们围聚在旁,从电脑屏幕上观察病人大脑中的电极活动。

主要观察的内容,就是大脑部分区域在听到一些独属于音乐的东西后所产生的电极活动,然后看看通过这些记录下来的电极活动能不能复现出他们在听什么音乐。

上面提到的属于音乐的东西,包括音调、节奏、和声,以及歌词。

这项研究进行了十来年。加利福尼亚大学伯克利分校的神经科学家们对29位接受过该实验的癫痫患者的数据进行了详细分析。

结果是肯定的——科学家们可以根据病人大脑中的电极活动,重建这段音乐。

在复现的歌曲中,其中的一句歌词「All in all it was just a brick in the wall」的节奏非常完整,虽说歌词不算太清晰,但研究人员表示,可以破译出来,并非混沌一片。

而这首歌曲也是科学家们第一个通过大脑电极活动重建歌曲成功的案例。

结果表明,通过对脑电波的记录和解除,是可以捕捉到一些音乐元素以及音节的。

用专业术语来说,这些音乐元素也叫韵律(prosody),即节奏、重音、抑扬顿挫等等。这些元素是无法单靠语言来表达其中的意义的。

此外,由于这些颅内脑电图(iEEG)只记录在大脑表层进行的活动(也就是最接近听觉中心的部分),因此朋友们不用担心短期内会有人通过这个手段来偷听你在听什么歌(笑)。

但是,对于那些得了中风,或者瘫痪,导致交流困难的人来说,这种从大脑表层电极活动进行的复现,可以帮助他们重现乐曲的音乐性。

显然,这比之前那种机器人式的、语调呆呆的复现要好得多。就像上面提到的一样,有些东西光靠文字真不够,咱听的是那个调调。

Helen Wills神经科学研究所的神经科学家,兼加州大学伯克利分校的心理学教授Robert Knight表示,这是一项了不起的成果。

「对于我来说,音乐的魅力之一就在于它的前奏和所要表达的情感内容。而随着脑机接口领域的不断突破,这项技术就可以给有需要的人,通过植入的方式提供只有音乐才能提供的东西。受众可能包括患有渐冻人症的病人,或是癫痫病人,总之一切因为病症影响到语言输出神经的人。」

「换句话说,现在我们能做到的已经不仅仅是语言本身了,和音乐性相比,文字所表达的情感可能就稍显单薄了。我认为,从此刻开始,我们才真正开始了破译之旅。」

而随着脑电波记录技术的更迭,未来的某一天我们也有可能在不打开大脑的情况下,通过附着在头皮上的电极进行记录。

Knight表示,目前的头皮脑电图已经可以测量并记录一些大脑活动,比方说从一大串字母中检测出单个字母。虽说效率不高,每个字母都得花上至少20秒钟,但总归是个开始。

之所以要大力发展头皮电极,是因为现在的无创技术还不够娴熟。也就是说,开颅的测量并不能保证100%的安全性。

而头皮电极的测量准度,尤其是对大脑深层的测量,还不太够。只能说,成功了但也没完全成功。

能读心吗?

直接给答案:no。

打个比方,对于那些说话有障碍的人来说,脑机接口技术相当于给了他们一把「键盘」,通过捕捉脑电波的活动,他们就可以在这把「键盘」上打字,表达他们所想表达的。

比如霍金,他用的那个东西就是这样,通过捕捉他的脑电波来生成机器人声的语音。

类比到这里你应该能明白了,光看这把「键盘」,你是不知道他在想什么的。现在的技术是他想,「键盘」启动,输出语音。他不想,「键盘」就不会启动,你也不能知道他在想啥。

所以说,读心不行。

实验内容

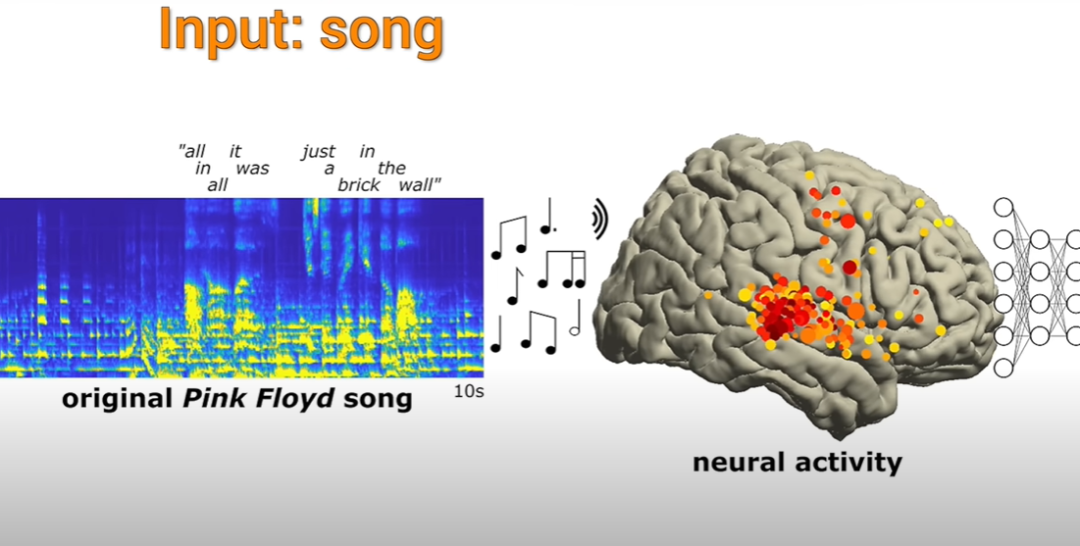

下图中,图A上即为实验所用歌曲的整体波形图。A下是该歌曲的听觉频谱图,最上端的橙色条代表有人声出现。

图B为X光片下,一名患者的电极覆盖图。每一个点代表着一个电极。

图C即为图B中4个电极分别的电极信号。此外,图中还显示了歌曲刺激所引起的HFA(High-Frequency Activity),即高频活动,在图中用下滑的黑色短线表示,频率在70到150赫兹之间。

图D是A中一小段(10秒)歌曲播放的放大的听觉频谱图以及电极神经活动图。我们可以发现,HFA的时间点与频谱图中每个标出来的矩形的右侧红色线条对上了。

这些配对情况就构成了研究人员用于训练和评估编码模型的示例。

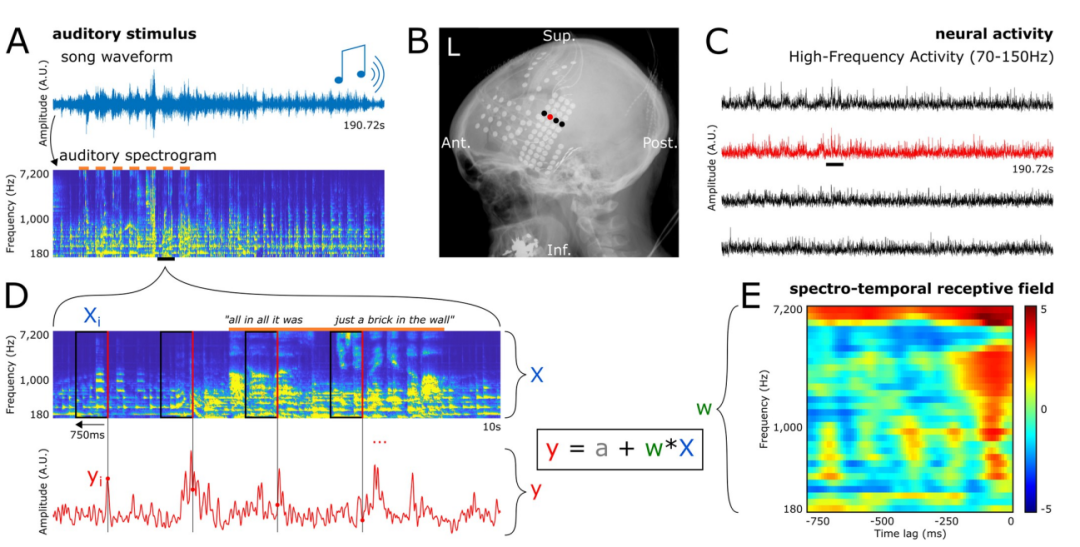

研究人员的实验结果显示,解码模型中用作预测因子的电极数量与预测准确率之间存在对数关系,如下图所示。

例如,使用43个电极(或12.4%)可以获得80%的最佳预测准确率(最佳预测准确率即为使用所有347个电极的结果)。

研究人员在单个患者上观察到了相同的关系。

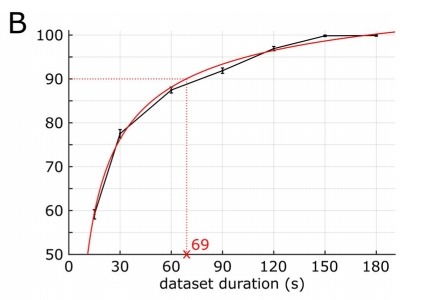

此外,通过引导分析,研究人员观察到数据集持续的时间与预测准确率之间也存在类似的对数关系,如下图所示。

例如,使用长度69秒(百分比为36.1%)的数据可以获得90%的最佳性能(最佳性能即为使用整首歌190.72秒的的长度得出)。

而关于模型类型,线性解码的平均解码准确率为0.325,而使用双层全连接神经网络的非线性解码的平均解码准确率则为0.429。

总体而言,线性音乐歌曲重建(音频S2)听起来闷闷的,对一些音乐元素(指人声音节和主音吉他)的存在有很强的节奏提示,但可能对另外一些元素的感知有限。

非线性歌曲重建的(音频S3)则复现出了一首可识别的歌曲,与线性重建相比,细节也更加丰富。音高和音色等频谱元素的感知质量得到了明显的改善,音素特征也更加清晰可辨。线性重建中存在的一些识别盲区也有一定程度的改进。

如下图所示:

所以研究人员使用非线性模型通过第29个患者的61个电极重建了歌曲。

这些模型的表现优于基于所有患者电极的线性重建,但解码准确性低于使用所有患者的347个电极所获得的准确性。

在感知方面,这些基于单个患者的模型提供了足够高的频谱-时间的细节,足以让研究人员识别出歌曲(音频S4)。

同时,为了评估基于单个患者的解码下限,研究人员从另外3位患者的脑神经活动中重建了歌曲,这3位患者的电极数量较少,分别为23、17和10个,而上述第29个患者的电极数量为61个,电极密度也相对较低。当然,还是覆盖了歌曲的反应区域,线性解码的准确性也算良好。

在重建的波形图(音频文件S5、S6 和 S7)中,研究人员检索到了部分人声。然后,他们将原始歌曲与解码歌曲的频谱图进行关联,对解码歌曲的可识别性进行了量化。

线性重构(下图A)和非线性重构(下图B)都提供了较高比例的正确识别率。

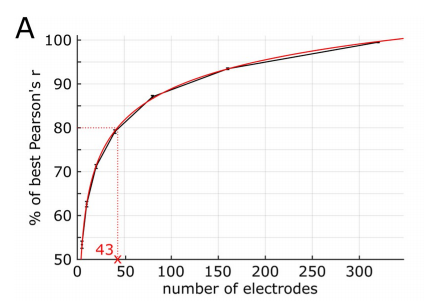

另外,研究人员分析了所有347个重要电极的STRF(频谱-时间接受域)系数,以评估不同音乐元素在不同脑区的编码情况。

这项分析揭示了各种频谱-时间的调谐模式。

为了全面描述歌曲频谱图与神经活动之间的关系,研究人员对所有重要的STRFs进行了独立成分分析(ICA)。

研究人员发现了3个具有不同频谱-时间调谐模式的组成部分,每个部分的方差解释率均超过了5%,合计方差解释率达52.5%,如下图所示。

第一个部分(解释方差为28%)显示了一个正系数集群,该集群分布在大约500Hz到7000Hz的宽频率范围内,以及观察到HFA之前90ms左右的这一个狭窄时间窗口内。

这个瞬时集群显示了声音起始的调谐。该部分被称为起始部分,只出现在双侧STG后部的电极上,如下图所示的位置。

最后,研究人员表示,未来的研究可能会将电极覆盖范围扩大到其他区域,改变模型的特征和目标,或添加新的行为维度。