本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

千模大战序幕拉起,复旦邱锡鹏教授这样说。

作为国内最早推出类ChatGPT模型的MOSS团队带头人,看到大半年来国内外大模型发展,他有了新的认知体会。

在由思佰诚科技举办的首届人工智能生成内容国际会议(AIGC 2023)上,他坦言,虽然大家都说大模型更偏工程化,但实际还有诸多科学挑战仍待解决,比如训练目标的设计、内存优化、自动化评测、大模型平民化、新架构等。

在MOSS发布之后这大半年间,他所在团队又取得了一定的成果:跨模态语音大模型SpeechGPT、优化器LOMO可实现单机微调650亿参数大模型;MOSS中文能力已超ChatGPT……

不过接下来,邱锡鹏透露不急于将MOSS产品化,而是继续在新架构探索,以及大模型的代码能力、数学能力上去进一步提升。

在与量子位的交谈中,他谈到了LIama开源生态、国内竞争格局、大模型产业落地,以及目前存在大模型幻觉、评测刷榜等现象在内的十大问题。

在不改变原意的基础上,量子位做了如下整理:

- 大模型进入到安卓时代,很多开源大模型中最终可能有一家胜出,现在来看就是LIama;

- 国内大模型同质化严重,希望有国产模型能代替LIama;

- 现在很多大模型都没有做到RLHF这一步,后者在某些技术领域也不是必须的;

- 大模型幻觉并不是一件坏事,通常做法还会导致性能降低;

- 创业窗口变大,每个人都可以借助大模型来做一些自己想做的事。

谈LIama开源生态

量子位:现在大模型进入到安卓时刻了吗?

邱锡鹏:是的,整体上是以LIama为主的开源生态。它离GPT-4有一定差距。很多复杂应用还是只能GPT-4去做,LIama仍需要进一步提升。

量子位:具体什么地方提升?

邱锡鹏:还得是基座。

量子位:LIama对市场格局的改变,如何看待?

邱锡鹏:一开始会有很多开源模型,最终可能有一家胜出,目前看来就是LIama。

量子位:为什么?

邱锡鹏:首先性能足够好,然后围绕它配套的上下游生态已经挺多了。当你要重新提一个新模型时,就不得不考虑上下游问题。将来其他大模型要想替代LIama不是不可以,但成本就会非常非常高,相当于要打破一个生态链。

谈国内竞争格局

量子位:国内是否会出现第二个LIama?

邱锡鹏:国内基本上就各做各的,如果没有显著的差异或性能提升,所以很难建立同等的生态。希望国产模型能取代Llama,否则可能会限制我们将来的一些发展。

量子位:现在千模大战,未来会变成几个大模型胜出。

邱锡鹏:肯定的。但现在整体都做得比较同质化,不太可能建立用户粘性,最终需要靠性能取胜。

谈大模型产业落地

量子位:很多人说大模型产业落地到「最后一公里」了,你怎么看待?

邱锡鹏:是不是最后一公里不太确定,但肯定是极大地促进产业落地。大模型确实改变了之前人工智能的应用范式。之前做一个产品,可能需要更多人力去标注数据,这是个很大的市场需求。但现在大模型就不太需要太多标注数据,将整个技术或者应用门槛降得很低。但缺点就是算力要求更高。

量子位:创业窗口更大了吗?

邱锡鹏:对,就是面向更终端的应用,每个人都可以借助大模型来做一些自己想做的事情。

量子位:SFT、RLHF还没形成很好的范式,什么时候能达到工业界应用水平?

邱锡鹏:现在已经有套完整的技术路径,加上有很多工具能帮助大模型在垂直行业的应用。这样的技术路径依赖能使门槛变得非常低。技术成熟度目前我觉得还是比较高的。

量子位:追求通用性同时,如何平衡大模型各领域需求?

邱锡鹏:大模型本身通用性强的话,补一些垂直领域知识可能就够了,这部分并不是特别困难,成本跟预训练相比会低很多。

量子位:像LIama2在SFT、RLHF用了100万量级人工标注数据,这种在数据量和成本上都是很大的。

邱锡鹏:现在很多大模型都没有做到RLHF这一步,只是做到SFT。

量子位:这步对产业落地是有必要的吗?

邱锡鹏:也不是必须的,比如在一个技术领域模型,就不会特别关注所谓无害性、诚实性这些特质,就像让它写个代码,通常来讲对齐会降低模型能力。

谈评测刷榜现象

量子位:怎么去看待有的大模型团队刷榜现象。

邱锡鹏:目前还没有一个特别好的数据集能反映大模型各种能力的,各方都在探索。但现在主要问题是,总体上对于生成式算法模型的评测是相当困难的。

量子位:举个例子。

邱锡鹏:就像ChatGPT刷榜不一定能刷过谷歌的大模型,但使用体验上就是更好。真正的评价可能还是要来自于人类真实感受,但这种评价的成本比较高,也很难定量化。

量子位:那客观指标还需要吗?

邱锡鹏:还是需要的,但最好就是像以前变成学术界比方法就够了。现在很多企业去刷榜,但又不公开数据,也不具体说怎么做,我觉得这是一种不公平的竞争。

比如说国内C-Eval,本身质量还挺高但出来几天就被刷榜了,导致学术价值就不大了。

谈大模型幻觉问题

量子位:大模型幻觉方面,咱们是否有些相关进展?

邱锡鹏:这方面本身做的并不是特别多,目前可靠的方法还是偏应用端去消除幻觉。除此之外,还有人通过对齐或负反馈的方式去识别。但我个人的观点是,消除幻觉可能外部加些知识验证就可以解决这件事,而不是从机理上去消除它。

量子位:为什么?

邱锡鹏:感觉它和模型这种思维能力是强相关的,有可能幻觉消失了,导致模型能力会下降。

量子位:幻觉并不是件坏事?

邱锡鹏:它可能不是件坏事,需要分场合去利用。比如有些场合绘画创作、科学发现是利用幻觉的。

谈AI对齐

量子位:OpenAI有个超级对齐团队,最终可能是AI对齐AI,您是怎么看待这件事?

邱锡鹏:对齐确实是件很难做的事情。所谓AI对齐人类价值观,我们人类本身的价值观都很难衡量。但像AI对齐某些能力是可以的,比如像解数学题、下棋,因为它的好坏不需要人来评价,用AI对齐就更好。

量子位:数理方面,大模型能力还比较欠缺。

邱锡鹏:这一块我觉得是需要更高质量的数据集。

谈对NLP的影响

量子位:大语言模型给自然语言处理带来什么样的影响?

邱锡鹏:相当于整个领域需要重新划分。早期是按照不同领域以及任务来划分,现在就要从不同阶段来划分,大体包括:预训练、指令微调、RLHF,这就导致大家做的东西比较雷同,没有像以前那样多样性——

现在大语言模型虽说有很多,但基本都是基于Transformer架构,训练数据、训练方法也差不多。

量子位:带来什么样的挑战?

邱锡鹏:首先就赛道拥挤,大家都统一集中到这一赛道;另一个就是提示变得十分重要,有点重新回到此前特征工程里面去,还有就是算力偏高,能耗高,以及很难有客观化的评价指标,以及外加安全问题。

这些挑战其实是下沉到大模型从预训练到应用的各个阶段的。

谈大模型科学挑战

量子位:普遍认知中大模型偏工程化,还有哪些科学问题需要解决?

邱锡鹏:主要有以下几点:

- 模型架构,Transformer的缺点就是复杂度和字符长度是平方的关系,扩展规模时就会变成瓶颈,未来肯定是有些新的架构产生。

- 思维链能力来源,要准备什么样的数据去提升它的能力,现在还没有一个公认手段。

- 训练目标的设计,早期机器学习目标很明确,可以端到端去减少泛化误差;但现在大语言模型每个阶段(预训练、精调加对齐)目标与最终目标是不是一致?如何去设计,这是需要去探索的。

- 幻觉,现在已经有些流行框架去解决,比如LangChain、LIamaIndex等,但有没有更深刻去理解背后工作依据去扬长避短,这值得研究。

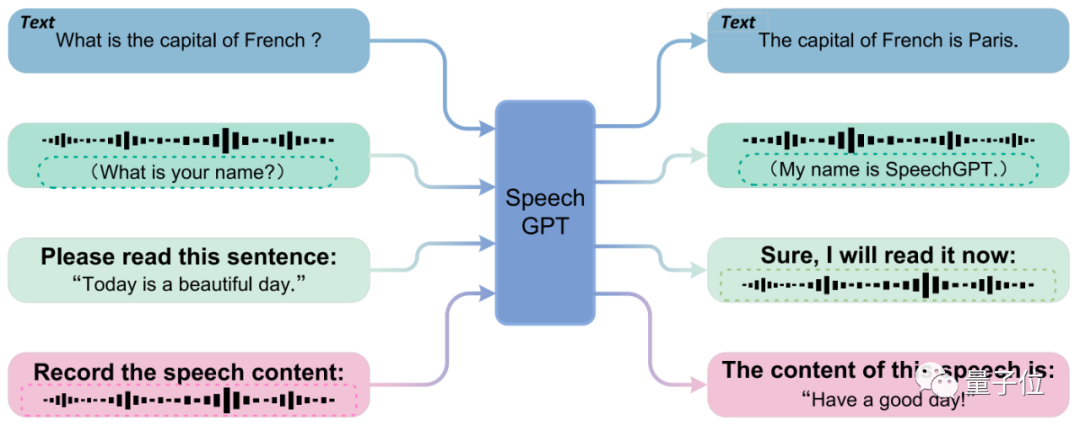

- 多模态拓展,只在符号世界的知识总归是受限的,如何与更多模态对齐。现在主流方式,比如在接到大语言模型之前接一个编码器,将多模态信息变成向量,但只是单方面对齐,模态之间没有充分融合。

我们有做一个SpeechGPT——让大模型直接接收语音信号,将语音离散化为Token直接输入给大模型,大模型可以直接输入和输出语音。

- 知识来源,大模型已经学到很多文本层面的知识,那今后进一步去提升,还能如何提升?比如那些文本所不能承载的知识,现在也有一些方法,比如多模态学习、具身学习等。

- 实时学习,如何让大模型与人的交互中进行学习,并与参数更新结合在一起,让其知识水平不断提高。

- 智能体,让大模型作为Agent的载体,赋予它各种能力去完成复杂任务;进一步思考,多个智能体之间又是怎样去交互?

- 自动化评价,现在大模型在推理能力、数学能力、代码能力等方面都差得比较远,但这些能力才足以支撑去做很多复杂的工作,因此要做一种指标去衡量这些能力,同时还要避免「刷榜」这种现象。

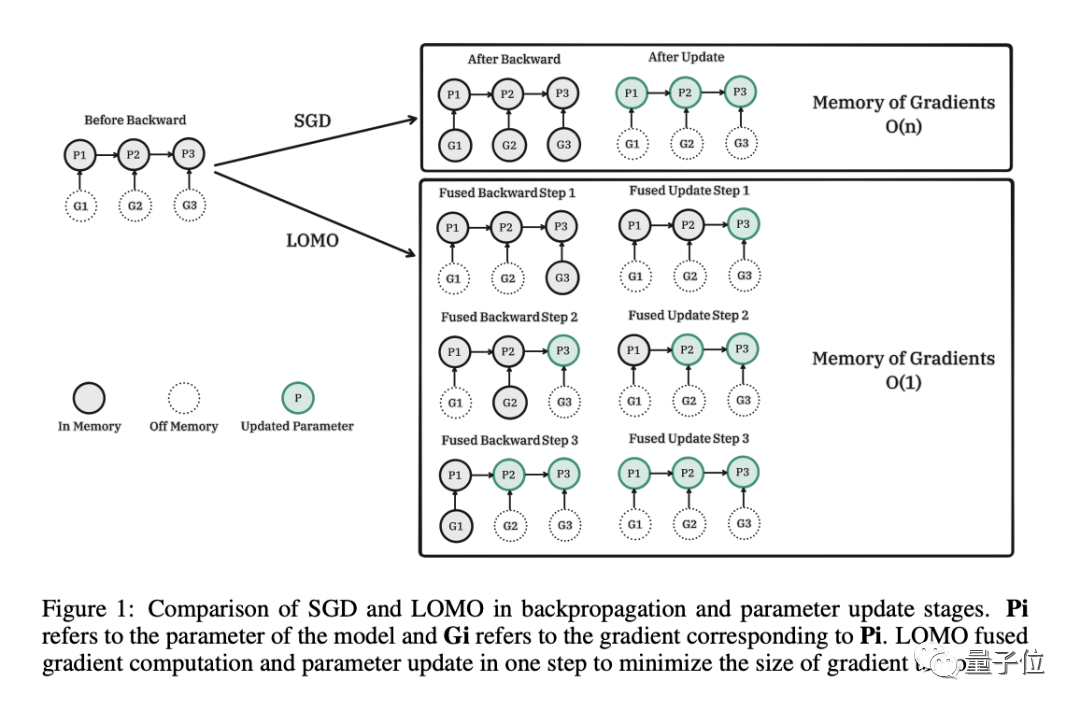

- 第十个有点偏工程,但也是个科学问题,就是大模型的平民化,如果算力要求依然很高,那将只受限于小部分人去做研究。我们在考虑一种全量的微调优化方法。前段时间提出了一种名为LOMO(低内存优化)的新优化器,并在配备8卡3090(24GB内存)的单台服务器,成功微调65B的LIama。

量子位:这些问题工业界需要关注吗?

邱锡鹏:我认为值得重视,现在国内一些团队基本只看到工程化,但其实里面很多挑战没有解决。

量子位:学界和工业界之间大模型分工是怎样的?

邱锡鹏:我觉得两者之间不存在分工,就像OpenAI自己的研究团队、DeepMind都有在研究这些问题。

谈MOSS进展

量子位:MOSS下一步将提高哪些方面的能力?

邱锡鹏:可能在新架构,以及大模型的代码能力、数学能力上去进一步提升。

量子位:成本的情况是怎样的?像OpenAI之前爆出每天烧掉70万美元。

邱锡鹏:我们没有一个完全严格的数字,但每天也是有几百张卡在跑。

量子位:未来会考虑出应用端产品?

邱锡鹏:可能在更远的将来。

量子位:为什么?

邱锡鹏:目前很多大模型但架构比较雷同,没有形成相较于其他大模型的独特性。如果未来能有一些技术创新能形成竞争力的东西,就可以去做些商业化落地的事情。

量子位:那有没有预期的时间?

邱锡鹏:没有。

量子位:之前提到将推出更大参数模型,是否有在推进中。

邱锡鹏:MOSS本身没有,但团队有参与到其他单位大模型训练中。

谈认知变化

量子位:对大模型的认知,跟半年前有什么变化?

邱锡鹏:那当然就是一开始大家都不会理解为什么大模型能做得这么好,现在觉得理所当然。比如SFT指令微调之后,就可以听懂人话之类,这件事放半年前或ChatGPT推出之前,不是所有人都能想到的。

然后放在今天,对大模型的理解就又不一样了——已经不把它当做一个只聊天的模型,更多是一种决策模型。让大家可以参与到更复杂的智能决策,包括智能体之类。