19世纪以前,当人们聚集在一起时,总是会用即时的最原始的歌声和乐器,讲述生活的故事,传递情感和思想。那时的音乐,是流动的,也是瞬间的。

1857年之后,录音的出现,让人们拥有了随时随地欣赏优秀的音乐作品的条件,在这种形式下,音乐开始变成设定好的故事,听众成了被动的接受者。

斗转星移。

时间来到2023,人工智能正在改变音乐的形态——通过便捷的操作,普通大众可以轻松生产出音乐作品。从“play guitar”到“play AI”,音乐创作正变得触手可及。

资深分析师Mark Mulligan观察音乐产业数十载,不久前,他在博客中写道:“音乐产业来到了一个临界点,AI将会改变音乐的未来,如今瓶中的精灵已经飞向了广阔的天空。”

合成的“歌唱历史”

作为歌迷的你可能不会想到,今年最火的音乐中,有一首竟然是孙燕姿演唱的“发如雪”。或者准确的说,是AI孙燕姿。

突然走红的另类“发如雪”,掀起了一阵网络创作热潮,带动AI歌手概念出圈,也让更多人感受到人工智能在音乐领域的巨大潜力。

不过,说到AI歌手,很多人第一反应应该是当红虚拟歌姬——初音未来、洛天依。在歌迷感慨于这些无论是声音和容貌都接近完美的AI歌手时,绝大多数人可能并不知道,单纯用计算机合成音乐这件事,早在上世纪五十年代就已经出现了。根据不完全统计,歌声合成的历史沿革已经跨越了70年。

1951年 | 程序员Christopher Strachey使用艾伦·图灵的大型计算机制作了历史上第一首电脑合成的音乐。 |

1961年 | 计算机音乐大师Max Mathews与科学家John Kelly等人使用IBM 704计算机完成了第一首由电脑模拟人声演唱的歌曲《Daisy Bell》。 |

1982年 | 为了统一标准,并建立起一种连接电子乐器和计算机的规则,国际乐器制造者协会的十几家厂商制定了通用合成器接口方案,更名为“音乐设备数字接口(MIDI)”。 |

2004年 | 日本雅马哈株式会社(YAMAHA)授权ZERO-G发售了VOCALOID首个声库。 |

2007年 | VOCALOID 2发布,日本CRYPTON FUTURE MEDIA公司依托该技术发布了初音未来。初音未来首次开启了声库+虚拟形象的软件销售模式,其意外爆火也激活了以UGC为核心的VOCALOID创作文化。 |

2009年 | 名古屋工业大学开发的Sinsy(Singing Voice Synthesis System)语音合成系统发布,使用了隐马尔科夫模型(HMM),可调教性别参数、颤音强度及变调等参数。 |

2012年 | 上海禾念公布洛天依等角色,并宣布第一款中文歌声库将以洛天依开发。 |

2013年 | CeVIO Creative Studio发布,基于HTS引擎(语音)/Sinsy引擎(歌唱)制作,输入音符、文字后既能唱歌,还能模拟人声说话。 |

2018年 | 华侃如发售Synthesizer V editor,结合人工神经网络和采样拼接合成的混合算法,使用底层语音模型(LLSM)技术实现了高还原度下对声色的灵活修改。 |

2019年 | 时域科技推出了ACE虚拟歌姬,最开始是一款音游。 |

2020年 | • Synthesizer V Studio发布,12月Synthesizer V AI发布,使用基于深度神经网络的歌声合成技术,生成的歌声宛如人类歌手。 • X Studio发布,由小冰公司开发,软件为音乐创作者提供具有不同音色和唱腔的虚拟歌手,它们能迅速读懂乐谱并演唱出来。 |

2021年 | • ACE开始支持AI歌声合成,并完成数百万美元Pre-A轮融资。 • CeVIO AI发行,继承了前身CeVIO Creative Studio结合歌声合成与语音合成的特征,并采用了深度神经网络等AI技术。 • 浙江大学发布了关于diffsinger的论文。diffsinger因其开源免费和高音质的特点迅速吸引了一批忠实用户。 |

2022年 | • VoiSona首个正式版发布,VoiSona是CeVIO AI的“姊妹版”,由同一家公司开发,分开运营。 • ACE发布电脑端ACE Studio预览视频,并开启内测申请。 • ACE官宣为“洛天依ACE AI”声库提供技术支持,同年为言和、乐正绫提供AI声库。 |

2023年 | • 小冰与网易云音乐合作发布了新编辑器“网易云音乐·X Studio”,提供了13名虚拟歌手。 • ACE Studio在直播问答中称新的歌声合成模型和代码重构正在稳步推进中,商业化时机根据工作进度而定。 |

在歌声合成漫长而隐秘的“进化”中,AI歌手的出现可谓划时代的产品,而要透析这段成长历史,有两个关键的信息点是必须了解的:

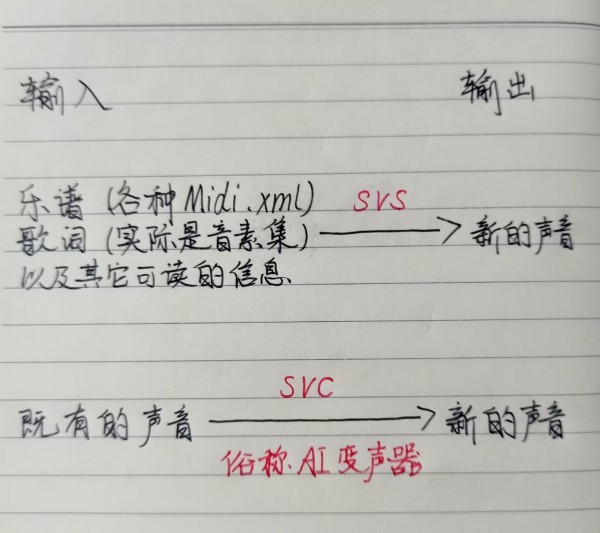

第一,AI歌手涉及的技术主要有两大类:歌声合成(Singing Voice Synthesis,SVS)和歌声转换(Singing Voice Conversion,SVC),而主要的发展是在歌声合成即SVS上。第二,总的来说,歌声合成可以分为拼接合成和AI合成两大方向,从发展过程看,是由前者逐渐向后者演进。

被公众熟知的明星虚拟歌姬——初音未来和洛天依,在技术上使用的正是拼接合成的方式,并在最初采用的是VOCALOID引擎(软件)。这类拼接合成引擎依靠手动调校,可调节的参数和调节的精准度,会直接影响创作效果——完全手动调校对于新手来说入门难,制作需要花费更多精力。

UP主你ADC我辅助表示,由于拼接合成是通过对不同发音的录入、编排和拼接来合成歌声,具备音域宽、编辑自由度高的优点,但连贯度会有所欠缺,“毕竟本质上就是一段段的音频素材”。

从拼接合成到AI合成的转变过程,可以说是一种技术的革新。与传统的拼接合成不同,AI合成是使用人工智能技术深度学习人声样本的唱法、发音、声线、风格等,推测出本人怎么唱进而模仿。

2009年,名古屋工业大学开发的Sinsy就使用了隐马尔科夫模型,而后CeVIO在Sinsy基础上开发出输入音符、文字就能唱歌说话的功能——这是最早使用非拼接方式的歌声合成引擎。到了SynthesizerV发布时,技术上已经开始介入人工神经网络(模仿人类大脑活动的机器深度学习模式),也就是说其在拼接合成的基础上结合了人工智能技术,融合了两者的优势。

微软小冰X studio也是早期AI引擎之一,免费使用但目前落后于其他引擎。相比之下,ACE作为完全的后起之秀,性能效果与Synthesizer V同属第一梯队,去年5月,洛天依也宣布与ACE合作推出了ACE引擎声库,早期ACE还提供了音乐创作社区。

AI合成引擎通过人工智能计算自动合成的声音,往往不需要大改就能使用(也可以直接在计算结果的基础上修改参数)——这一方面降低了制作成本;另一方面生成的声音非常自然、流畅、拟真,操作门槛低。

不过UP主@HarryKamski介绍说,AI合成的缺点是音域会受限,而且因为合成方式非显性,会有“自己的想法”,很多时候不能完全遵照调校师的想法。

“AI孙燕姿”背后的歌声转换

就在SVS歌声合成在商业领域大行其道的同时,各种音乐社区内,隐匿生长的开源幼苗也在茁壮成长。并因几个月前突然在网络爆火的“AI孙燕姿”,将SVC(歌声转换)猛地推向了主流的道路。

“AI孙燕姿”与商用广泛的SVS技术路线不同,采用的是歌声转换即SVC技术。两者的技术原理和用户生态都是不同的,谈及两者的区别时,UP主电浆果茶画了一张图。

UP主电浆果茶解释说,不管用SVS AI还是SVC生成音频,首先都需要采集声音做一个AI模型,采集的声音质量越高,模型输出的音质也就越高。有了模型之后,SVS只需要输入文本和音符就能生成一个新的音频,没有其他干扰的话,这个音频的音质是不会变的。SVC模型生成内容则需要先输入一个既有音频,如果你往一个很好的模型输入一个糟糕的音频,那么输出来的音频也是糟糕的。

也就是说,“AI孙燕姿”这类AI歌手,本质可以理解为AI加持的歌声变声器,它是将源音频的音色、声线替换为目标歌手的,保留原来的歌词、唱法、音调等,因此最后的呈现效果,很大程度上取决于源音频的演唱水平。

相较SVS技术,SVC出现的时间并不久。早期日本发布过一款语音合成软件Voiceroid,可以将输入的文本转换成语音朗读,当时主要应用于一些游戏解说、美食教程、伴读等。但对于实时需求来说,输入文字并不方便,于是后来就出现了AI变声器,比如,“塞壬VOICE”——这些当时本质上还是商业的闭源软件。可以说,直到以VITS(语音合成模型)为基础的这类开源、免费软件出现,SVC才真正在社区中兴起。

至于大火的“AI孙燕姿”诞生经历,这里要提到一个人,国内歌声合成爱好者Rcell,他基于VITS、SoftVC等项目开发了AI语音转换软件so-vits-svc,“AI孙燕姿”等AI歌手正是基于此制作的。由于so-vits-svc开源免费,可以在本地训练,也因此被大家广泛的使用——so-vits-svc之外,SVC软件还有RVC、DiffSVC等。

除了“AI孙燕姿”的发如雪,SVC技术的兴起给个人的音乐兴趣带来了更多的可能性。

今年3月,UP主你ADC我辅助在B站上传了一首已故歌手本兮“演唱”的《反方向的钟》,勾起无数90后的回忆杀,网友们纷纷在视频下感慨追忆,留言7000多条。

UP主你ADC我辅助表示,“现在很多网友用SVC来训练各种人物的声库,比如动漫角色、主播、明星,甚至身边的亲朋好友,只要你想,任何人的声音都可以被训练,并不限于明星。由于SVC声库训练起来不算复杂,在二创中非常受欢迎。”

也正是如此,“AI孙燕姿”爆火后,“AI王菲”、“AI周杰伦”、“AI陈奕迅”纷纷上线,有人追求歌曲的适配,有人纪念去世歌手,也有人剑走偏锋,让郭德纲唱起了热血日漫OP。

每一次有新的人工智能技术出来,都会引起一番AI取代人的问题的讨论。有人认为,AI歌手的本质其实更像钢琴吉他一样,是一种乐器,无论是将其打造成虚拟偶像,还是生产力工具,它都不能脱离于人而存在。当然那些演唱能力很差的歌手,或许该有一些危机感。

AI歌手的商业版图

不管AI歌手的本质是什么,任何一种新产品能否生存的核心都不仅是技术,更在于能否建立完善的商业模式。

商业模式上,SVS打造的歌手主要是和IP产业、偶像产业结合,比如广告代言、卖周边、直播、开演唱会、发行歌曲等。但虚拟偶像产业主要靠粉丝经济,圈子小众,想吃肉的多,可想而知这门生意并不好做。

最火的初音未来和洛天依都属于最早吃到螃蟹的,一个是第一个在世界范围爆火;另一个则是第一个打开中国市场的,因此吸引了大量粉丝。不过,与表面的火爆背后,AI歌手的成功其实凤毛麟角,即使在二次元文化最盛行的日本,真正大获成功的大概也只有以初音未来为代表的那几个。

除了偶像化的商业模式,另一个营收方向是声库销售。UP主你ADC我辅助表示,官方发布的SVS声库绝大多数都是经过配音员本人授权的,像SV AI、CeVIO AI等软件的AI声库,多采用买断制,以一个价格购买后就能终身使用其AI合成服务。

此外,电浆果茶表示,现在相关公司也在尝试拓宽市场边界,比如跟生产力工具结合。上个月,日本AI社宣布将与Unity合作推出A.I.VOICE语音合成声库,和基于A.I.VOICE技术的Unity扩展编辑器,让用户可以在Unity上直接合成语音内容,无需在多个软件切换。

相比之下,SVC的商业路径更窄,虽然也有商业化软件,但在已经有很多开源免费SVC的情况下,如何突出商业SVC的优势,是一个主要问题。同时由于制作门槛低,SVC频道更加混乱,充斥大量低质量作品,也引起了一些圈内用户的不满。另一方面由于音频的采集未经过版权方同意,SVC的AI歌手对原歌手以及词曲者都可能构成侵权。

“灰色地带”的阴影

版权争议是AI歌手面临的一个主要现实问题。

对于歌手本人和唱片公司来说,面对不间断输出的海量自制歌曲,进行授权或起诉索赔并不可行,最优的解决方案或许是将重点放在输入侧——让AI工具从预先授权的数据集中学习。这样唱片公司和出版商也有机会从中拓展营收,音乐版权也可能迎来一个新的商业模式。

这样的新商业模式并非空中楼阁。

根据近期报道,谷歌和环球音乐正在就授权AI使用艺人的声音和音乐来创作歌曲进行谈判。知情人士称,双方的讨论是围绕AI技术在音乐版权方面达成合作伙伴关系,希望开发一种工具,让广大粉丝可以合法地创作AI歌曲,向版权方付费,歌手们可以自由选择是否加入。目前磋商还处于早期阶段,暂时不会推出产品。此外据透露,华纳音乐也在与谷歌谈判中。

版权之外,声音合成还存在其他法律隐患。

声音具有强烈的人身属性,更是歌手赖以生存的根本。“声音保护”也被写入《民法典》,根据《民法典》第1023条相关规定:“对姓名等的许可使用,参照适用肖像许可使用的有关规定。对自然人声音的保护,参照适用肖像权保护的有关规定。”那么未经本人允许,通过SVC技术伪造声音,无疑是对其人身权益的损害。

UP主痕继痕迹表示,“技术也可能会被用于不好的用途,比如某流量演员自身台词功底很弱,通过换声把配音转变成自己的,或者以后某歌手的歌都不是自己唱的,而是别人唱完变声成自己的。”此外还可能伪造虚假的录音、言论,进行诈骗或者造谣诽谤他人——今年已有多起使用AI合成语音电诈的案例曝光。

法律和商业模式都是AI歌手发展过程中要过的关,但这并不影响其成为人工智能技术的一次重大应用。AI歌手正在不断拓展音乐创作的边界,为音乐文化注入无限的可能性。