译者 | 陈峻

审校 | 重楼

在最近的几周里,人们使用大型语言模型(large language models,LLM)生成了诸如:书籍、小说、说唱音乐等各种创意性的内容。可是,我们怎么才能衡量这些模型的创作力水平呢?

在本文中,我将和您分析从2019年到2023年的各个GPT模型,在收敛(存在单一正确的解决方案)和发散(开放式地可能存在多个解决方案)[1] 两种创造力的测试中的不同表现。具体测试类型包括:

通过分析,我将重点关注从早期的GPT-2模型,到最新的GPT-4模型,在性能上的变化。虽然总的来说,较晚的模型往往在各种创造力任务上表现会更好,但是我确实也发现了一些例外情况。例如:当测试本身已有“正确”的答案时,较简单的GPT-2模型反而优于GPT-4模型。

当然,我也会在相同的创造力测试中,将GPT模型与人类表现进行比较。我并不是想阐明GPT模型、或一般的LLM,能够具有与人类同等的创造性思维;而是要展示各个模型是如何响应创造性过程的。

GPT模型的发展

生成式预训练转换器(Generative Pre-trained Transformer,GPT)模型是目前互联网上被广泛用于训练的语言模型,可以根据先前的token预测下一个token。虽然ChatGPT貌似在最近的几个月才引起了公众的关注,但实际上OpenAI的GPT模型及其背后的技术,已经存在了多年。

- GPT-1(2018年,117M参数)是原始的GPT模型。我曾在HuggingFace上使用了其开源版本,其输出乱码较多。论文:通过生成式预训练提高语言理解力。

- GPT-2(2019年,1.5B参数)。我也曾在HuggingFace上使用了其开源版本。对于一些实验,GPT-2的输出为乱码,对理解其行为毫无用处。论文:语言模型是无监督的多任务学习者。

- GPT-3(2020年,175B参数),比GPT-2大了100多倍。我使用了由OpenAI APIs提供的text-davinci-002。论文:语言模型是小样本学习者。

- GPT-3.5(2022年)。虽然GPT-3.5有多个版本,但我在原始的ChatGPT上使用了一种模型(OpenAI APIs提供的gpt-3.5-turbo)。该模型是使用强化学习和人工反馈进行训练的。

- GPT-4(2023年,约100T 参数)。我使用了由OpenAI APIs提供的gpt-4。论文:GPT-4技术报告。

在下文的各个实验中,除非另行说明,否则我都是在唯一的提问(prompt)中调用了每个GPT模型五次,以说明其生成过程中的随机性。

1. 远距离联想测试:连接不相关的词

远距离联想测试(RAT)是Martha Mednick于1962 年开发的创造力测试[2]。该测试旨在衡量聚合思维。也就是说,每个问题都有一个“正确”的答案。通常,给定三个看似无关的词,受试者必须找到第四个词来连接这三个词。例如,单词“梦(dream)”、“破(break)”和“光(light)”可以通过单词“白天(day)” 联系起来,成为:白日梦(daydream)、破晓(daybreak)、日光(daylight)。

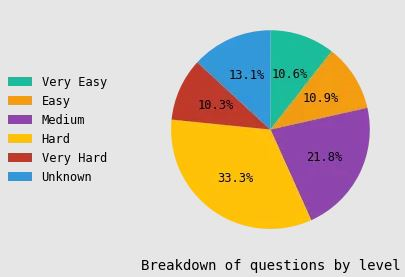

我从Remote Associates Test网站各种单词的三元组,共有312个问题。每个问题的难度都被按照从非常容易到非常困难的等级进行评分。

对于每个模型和每个单词的三元组,我都使用了如下提问模板,并将每个模型调用了5次,以说明其随机性。其中,提问的具体内容为:

给你三个词。想想与前三个词中的每一个都以某种方式相关的第四个词。请先给出答案:“Answer”,然后解释你的推理:“Reason”。单词为:{Word1}、{Word2}、{Word3}

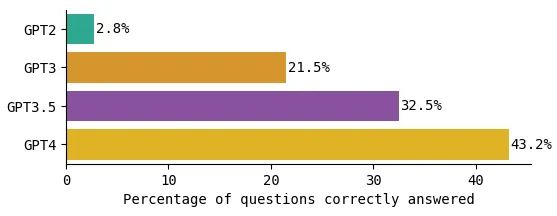

较新的GPT模型在远程关联上得分更高

我计算了每个GPT模型生成正确答案的总体百分比。如下图所示,模型越新,其生成的正确答案就越多。

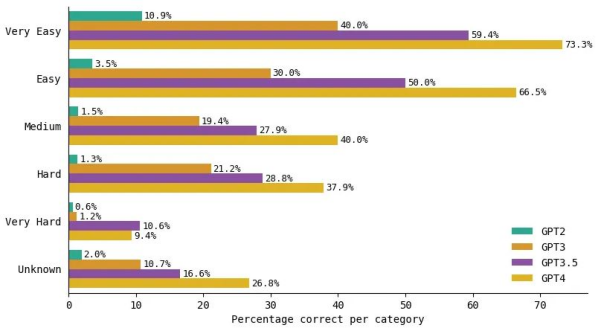

按照问题难度级别细分模型的性能,我们可以看到类似的趋势:在每个难度级别上,较新的GPT模型都比旧的模型表现得更好。虽然较新的GPT模型在困难问题上的表现优于旧模型,但是与较简单的问题相比,其改进幅度较小。这意味着:即使是GPT-4也难以解决困难的问题。

根据Remote Associates Test网站的说法,“人类通常可以解决大部分被标记为简单的项目,大约一半的中等项目,以及较少的困难项目。”虽然该网站上没有给出官方的统计数据,但是我们一眼就能看出,GPT-4确实解决了大约一半的中等难度和少量的困难。它是唯一一个近似于人类水平的模型。其他GPT模型则比人类表现要差。

一些GPT-2回答正确但GPT-4出现错误的例外

虽然这种情况并不经常发生,但是对于如下8个问题,2019年的GPT-2模型反而优于2023年的GPT-4模型。

简单的问题

单词:cottage(小屋)/brick(积木)/cake(蛋糕)

GPT-2:“cheese(奶酪)”[正确答案]

GPT-4:“layer(层)”

中等问题

单词:cat(猫)/number(号码)/phone(电话)

GPT-2:“call(呼叫)”

GPT-4:“dial(拨号)”

困难问题

单词:through(通过)/disk(盘)/way(路)

GPT-2:“drive(驱动)”[正确]

GPT-4:“circle(圆)”

非常困难的问题

单词:land(土地)/hand(手)/house(房子)

GPT-2:“farm(农场)”[正确]

GPT-4:“property(财产)”

可见,对于所有这些问题,GPT-4的回答都缺乏逻辑性。事实上,在事先不知道正确答案的情况下,您可能会认为GPT-4的答案已经将三个词联系起来了。如果你这么想的话,也不算错。我将在下一节回答这个问题。

GPT-4到底是错了,还是跳出圈外思考了?

针对上述GPT-4半数以上的“错误回答”,我查看了它对一些“非常困难”的问题的解释。

单词:artist(艺术家)/hatch(策划)/route(路线)

正确答案:“escape(逃离)”

GPT-4回答:“map(地图)”

“艺术家”一词可能会让人想起创造某物的想法,甚至可能是某物的视觉表现。地图是一种常见的视觉表现形式,需要具有一定程度的艺术技巧,才能创建。

“策划”一词可以指打开某物或使某物存在的行为。地图是一种蓝图或计划,通常用于导航新领域或制定行动方案。

“路线”一词与方向和运动有关,可以在地图上绘制和跟踪。地图可以帮助您确定旅行时的最佳路线,还可以提供有关其他人过去所走的路线信息。

总而言之,“地图”似乎是一个与前三个词都很相配的词,因为它包含了艺术创作、策划、路线、运动、以及导航等思想。

这便是GPT-4为什么认为“地图”是与“艺术家/规划/路线”相关联的单词的解释。我们再来看另一个例子:

单词:fork(分叉)/dark(黑暗)/man(人)

正确答案:“pitch(投掷)”

GPT-4回答:“shadow(阴影)”

“分叉”这个词可以与分裂或分支相关联,例如道路上的岔路口。阴影也可以看作是一种划分,因为它们代表没有光。

“黑暗”一词是指没有光。当光线被物体阻挡时会产生阴影,并且通常看起来比周围区域更暗。

“人”这个词可以与身份或个性的概念相关联。阴影也可以被用来表示一个人的身份,因为它们可以提供有关其形状和大小的线索。

因此,“影子”似乎是一个与前三个词都很相配的词,因为它包含了分裂、缺席和同一性的概念。

上述两个例子充分显示了远距离联想测试和一般性聚合创造力测试的缺陷,即“正确”的答案可能并不唯一。在此类情况下,GPT-4生成的所谓“错误”答案,可能只是因为不符合传统的“正确”答案的标准而已。

GPT-4回答任意生成的三元组单词

接着,我构建了自己的远距离联想测试,并主观地评估了其输出。首先,我列出了10,000个最常见的英语单词[3](https://github.com/first20hours/google-10000-english),然后我从该列表中随机地抽取了三个单词,让GPT-4提供第四个单词,以便将这些单词联系在一起。虽然有些三元组非常奇怪、且毫无关联,但是GPT-4总能找到一种方法,将它们联系在一起。例如:

Health(健康)

单词:dietary(饮食)/surveillance(监管)/born(出生)

答案: Health(健康)

理由:

饮食——一个人的饮食与他们的健康直接相关,因为它会影响到人的整体健康、能量水平和某些疾病的风险。

监测——健康监测是持续、系统地收集、分析和解释对于健康实践的规划、实施和评估至关重要的数据。

出生——当一个人出生时,他们的健康是至关重要的,因为它会对其发育、成长和整体生活质量产生长期的影响。

我发现其对于“健康监测”的定义,几乎是从CDC网站上的公共卫生监测简介中逐字复制的:公共卫生监测是“持续、系统地收集、分析和解释对公共卫生实践的规划、实施和评估至关重要的健康相关数据。”

2. 交替使用任务:寻找普通物品的意义

另一个衡量创造力的流行测试是替代使用任务(AUT)。它是由JP Guilford于1967年创建的。与远程联想测试不同,该测试衡量的是发散思维,即:没有正确答案。它要求受试者尽可能多地描述日常物品的原始用途。例如:“笔记本电脑”可以用作“盘子”、“身体防护罩”或“壁画”[4]。对于此类测试的响应是根据原创性(不同程度的用途)和灵活性(想法的分类)等指标来衡量的。该测试的目的是审查受试者对于一件普通的物品能想到多少种非常规的用途。

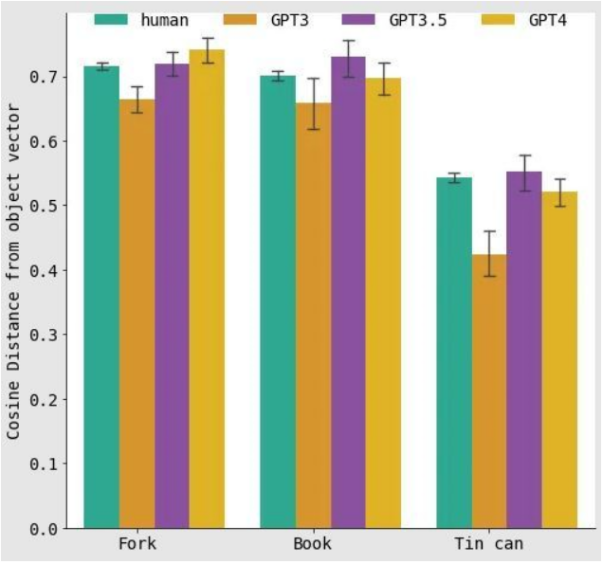

由于我的资源有限,因此我使用了创造力代理。它是由阿姆斯特丹大学的研究人员在将GPT-3的创造力用于(替代用途)测试时使用的。研究人员要求人类和GPT-3 (davinci-002)针对“叉子、锡罐和书”提出替代用例。作为衡量创造力的代理,他们测量了对象与生成的用例之间的语义距离。也就是说,生成的用例词与原始对象之间的差异有多大。

在此基础上,我对GPT模型使用了以下提示:

为{物品}想出10种创意用途,这些用途可能会让人们觉得聪明、不寻常、有趣、幽默、创新或与众不同。

在自然语言处理中,语义距离(或称语义相似性)是两个词相关程度的代表。它基于词语在相似的上下文中被一起使用的频率。例如,“computer(电脑)”和“screen(屏幕)”这两个词可能有更短的语义距离,因为它们经常在相同的上下文中使用;而“computer(电脑)”和“lentils(扁豆)”这两个词可能有更长的语义距离,因为它们不是经常在相同的上下文中使用。

为了计算两个词的语义距离,我使用了与研究人员相同的方法--自然语言处理库Spacy (`en_core_web_lg`,https://spacy.io/models/en) 来计算对象(例如“笔记本电脑”)和用例词(例如“盘子”)的嵌入关系。然后,我使用两个嵌入之间的余弦距离,来计算语义距离。

对于交替使用任务,较长的语义距离与对象的“更有创意性”用例相关。通常结果表明,对于上述三个对象--叉子、锡罐和书,人类表现出比GPT-3更高的余弦距离(因此语义差异更高)。然而,在某些情况下,GPT-3.5和/或GPT-4的匹配能够超过人类创造力语义距离分数。

虽然人类倾向于提出比GPT-3更具创造性的用例,但是GPT-4更接近于人类的水平。也就是说,GPT-4响应的物品与原始物品的语义距离更长,与人类的表现水平相似。然而,如果没有真正的人类注释,以决定更多的主观类别,例如:原创性、灵活性和实用性,那么这种使用余弦距离的量化将会是非常有限的。毕竟它只能衡量GPT模型各种创造性输出的一小部分。

人类生成的和AI生成的用例

下面的两个列表分别是人类生成的锡罐替代用例,以及由GPT-4生成的替代用例。相信您一眼就能区分开来。

清单 1:锡罐的用途

- 可作为一面镜子

- 可创造玩具

- 可作为艺术

- 可作为安迪沃霍尔(著名艺术家)的提醒

- 可作为带夹子的钥匙圈

- 可作为首饰

清单 2:锡罐的用途

- 微型架子鼓

- 古怪的花盆

- 临时饼干刀

- 自制野营炉

- 异想天开的风铃

- 微型药草园

3. 发散联想任务:十个没有联系的词

第三个创造力测试是发散关联任务(DAT)。它是最近由一组研究人员于2021年创建的[5]。该测试涉及到尽可能多地列出十个彼此不相干的名词。顾名思义,此类测试是发散的,也就是没有正确的答案。

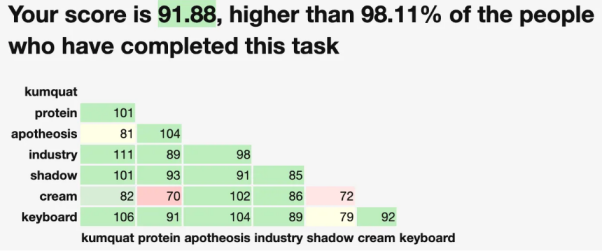

在线测试网站-- https://www.datcreativity.com/只需几分钟,便可列出十个尽可能不相关的名词。以下是我从该网站上得到的结果:

那么,DAT的分数是如何计算的呢?其过程使用了嵌入和余弦距离等相关计算。在此,我总结为[6]:

- 计算每个单词的GloVe嵌入

- 计算每对词之间的余弦距离

- 取距离的平均值

这个过程类似于,替代使用任务中用于计算创造力代理分数的方法。其唯一区别在于使用到了词的嵌入模型。

比较不同模型之间的差异

通过参考DAT网站,我向GPT模型提出了如下问题:

请输入10个尽可能不同的单词,并包括单词的所有含义和用法。

规则:

- 仅英文单词。

- 仅名词(例如,事物、对象、概念)。

- 非专有名词(例如,没有特定的人或地点)。

- 非专业词汇(例如,不包含技术术语)。

- 自己想出来的词(例如,并非周围常见物体)。

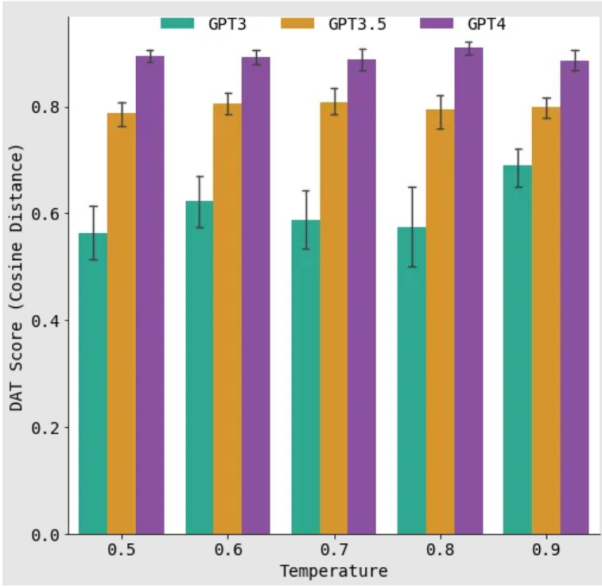

结果表明,GPT-2生成了一些文不对题的输出。如下图所示,每个新模型的DAT分数都增加了。这意味着,新的模型更擅长生成10个在语义上尽可能不同的单词。

例如,GPT-3生成了如下列表,其得分为0.36:

黄昏、夜晚、白天、黎明、早晨、下午、傍晚、午夜、暮光

而GPT-4生成了以下列表,其得分为0.95:

大象、显微镜、沙堡、星系、和谐、抹刀、冰川、哲学、手鼓、干旱

根据DAT测试的介绍,测试的平均分数一般在75-80之间,因此95分已经算是非常高了。

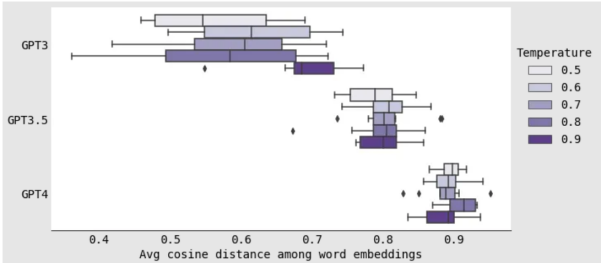

在上图中,我们需要注意的是,GPT-4的误差线比GPT-3的误差线要小得多。而在下一个实验中,这一点变得更加清晰。在该实验中,我通过调整“热度(temperature)”参数,来改变每个GPT模型生成时的随机性。

热度是介于0和1之间的值。其中,接近0的值最可预测,而1则是最随机的。我尝试了0.5和0.9之间的热度值,且增量为0.1(在之前的实验中,我将热度保持在0.7,这一默认值)。我预计较高的热度值会有更多的变化,而较低的热度值会有更多的一致性。

然而,结果表明,就语义距离方差而言,热度对模型的影响并不那么重要。例如,对于GPT-3来说,尽管热度很高,但每个包含10个单词的列表的DAT分数差异非常大。然而,对于GPT-4来说,虽然也有一定的热度,但DAT分数在一个小范围内,保持紧密一致性,几乎没有变化。

可见,GPT-4的变化远小于GPT-3。在某种程度上,我们会觉得GPT-4已经“知道”了一个本没有正确答案的任务的“正确答案”。

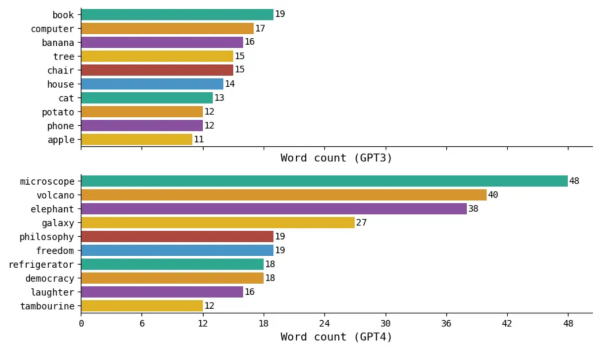

汇总所有热度分数的响应,我让每个模型生成了50次包含10个单词的列表。然后,我查看了在所有50次运行中出现的不同单词的常见程度。其中,GPT-3最常生成的单词是书,其出现率为19/50=38%。而GPT-4最常生成的单词是显微镜,其出现率为48/50=96%。

上图证实了GPT-3实际上在其单词生成中更具可变性的说法,而GPT-4通过预测许多它知道的、在“不同单词”任务中得分高的相同单词(如:显微镜、火山、大象和星系等),来保证其输出的稳定性。

同时,该发现也证明了GPT-4似乎想通过“破解代码”,来生成它认为多样化的单词。如果此猜测属实的话,我们是否可以认为:GPT-4比它能够达到“如何在测试中表现等更优秀”的所谓局部最优(local optima),要更具有创造性呢?

小结

使用一组有限的、基于文本的测试,去准确地衡量诸如模型的创造力是极具挑战的。尽管可视化远距离联想测试之类的工具,试图通过结合视觉元素来解决该问题,但是此类评估仍然存在着一些固有的局限性。具有“正确答案”的趋同测试(例如远距离联想测试)可能并不总是最正确的解决方案。而没有特定正确答案的发散测试(例如发散关联测试),则需要依赖不完美、且可能包含偏差的单词嵌入。

此外,GPT模型在上述测试中的表现,可能会受到它们在训练期间所接触的不同任务的影响,因此也可能导致数据的重叠。例如,GPT-4在发散联想测试中表现出的单词重复,可能暗示着它已事先知道了“正确”答案。而鉴于GPT-4可能正在接受测试数据、尤其是编码任务训练的传闻,我们着手开发替代测试方法就显得非常有必要了。

尽管有着上述各种缺陷,但是创造力测试仍然可以作为比较和跟踪大语言模型性能的、有价值的基准。在未来的研究实验中,我们可以用其他语言去重复本文提到的实验,以衡量跨语言领域的GPT模型的创造力。据此,我们也可以更加全面地了解人工智能所生成的内容,并进一步探索此类高级语言模型的能力和局限性。

参考

[1] Guilford, J. P. (1967). 人类智慧的本质。

[2] Mednick, S. A., & Mednick, M.T. (1959,1962). 远距离联想测试,大学和成人形式。

[3] 最常用的10,000个英语单词是通过对Google的Trillion Word Corpus的n-gram频率的分析来确定的。我进一步过滤了这个列表以删除停用词(例如英语中的常用词,如“the”、“and”和“you”)。更多信息请参见https://github.com/first20hours/google-10000-english。

[4] 有一次我把这个放在约会应用程序上,不幸的是没有人认为它很有趣。

[5] Olson, Jay A.; Nahas, Johnny; Chmoulevitch, Denis; Cropper, Simon J.; Webb, Margaret E. (22 June 2021). “通过命名不相关的词来预测创造力”。 美国国家科学院院刊。118 (25): e2022340118. doi:10.1073/pnas.2022340118. PMC 8237676. PMID 34140408

[6] 原作者从10个单词中抽取了7个子集来计算分数。我保留了所有10个单词。此外,作者使用了840B-GloVe嵌入,而我使用较小的6B-GloVe嵌入。通过将自己的GloVe嵌入结果与官方DAT分数进行比较,我发现尽管存在差异,但其结果仍具有可比性。

译者介绍

陈峻(Julian Chen),51CTO社区编辑,具有十多年的IT项目实施经验,善于对内外部资源与风险实施管控,专注传播网络与信息安全知识与经验。

原文标题:Exploring Creativity in Large Language Models: FromGPT-2toGPT-4,作者:Yennie Jun