自从Stable Diffusion和Midjourney爆火之后,人们见识到了人工智能技术在图片生成领域的强大实力。

而Stable Diffusion的开源,又进一步促进了定制化生成模型社区的建立,使得图片生成得到了长足的发展。

然而,在更复杂、表达内容更丰富的视频生成领域,却缺乏一个有能力生成高质量视频内容的模型,对于下游不同类型的视频例如电影和短视频的创作也更是「天方夜谭」。

为了打破这一窘境,微软亚洲研究院(MSRA)联合多所高校在视频生成领域提出了一系列工作,涵盖基础生成模型和实现下游视频生成任务的应用模型。

其中,有两篇工作已经被ACM Multimedia 2023接收。

基础模型

首先,北大和MSRA组成的联合团队针对将图片生成模型拓展至视频生成这一问题展开了细致的研究,提出了视频生成基础模型 VideoFactory。

作者列表:汪文靖,杨欢,拓子曦,何汇国,朱俊臣,傅建龙,刘家瑛

论文地址:https://arxiv.org/abs/2305.10874

1. 背景和动机

相较于图像生成,视频生成更为困难,其既包含空间域的单帧画面建模,也包含时间域的跨帧运动建模。

然而,相较于大规模高质量图像数据,现有视频数据集的质量和规模均存在严重缺陷。

受限于数据集,从零构建高质量视频生成模型十分困难,因此大部分工作采用了将预训练的图像生成模型拓展至视频生成的方案,更加便利高效。

在此背景下,如何将时序信息有效融入预训练的图像生成模型成为了研究的重点。

现有工作通常将独立的一维卷积和注意力模块分散地添加到视频生成模型中,这会导致时空信息的交互不足。

同时,当前可用的视频数据集质量也不令人满意,从而导致现有工作的生成质量受限。

其中具有代表性的WebVid-10M数据集分辨率不足(360P),且画面含明显水印。

2. 方法和贡献

2.1 基于交换式时空交叉注意力机制的模型设计

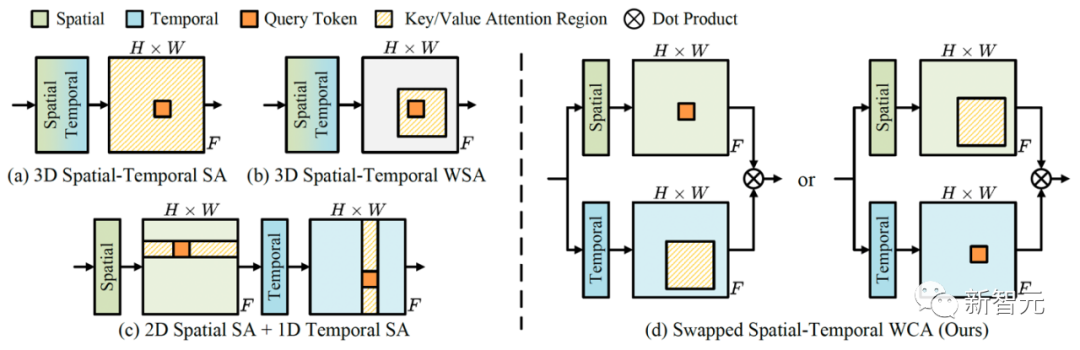

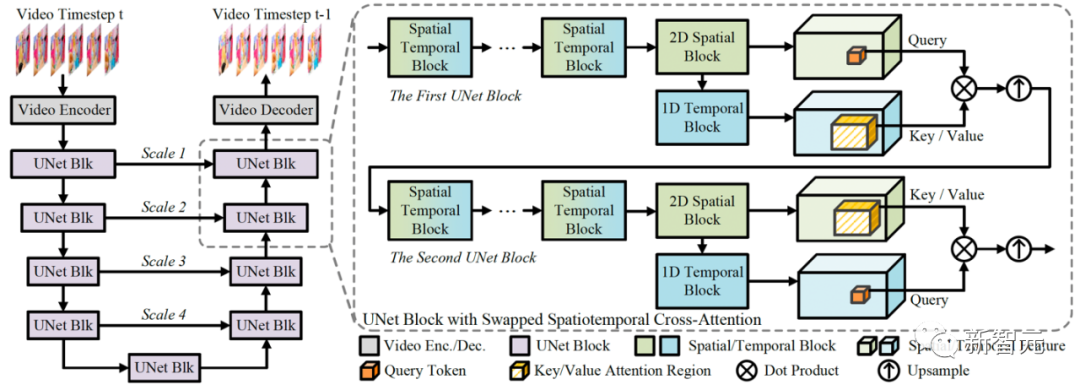

传统的时空交互模块设计如图(a)-(c)所示,这些架构独立地处理每个帧上的空域操作,而时域操作考虑每个空间位置的多个帧,这种方式忽略了时空信息的重要交互。

区别于(a)-(c)中的自注意力机制(self-attention),文章作者提出在空域和时域模块之间引入交叉注意力机制:时域和空域特征会交替(swapped)地作为注意力机制中的Query和Key,以此充分将两者的信息进行融合和交互。为减少计算开销,进一步采用了3D窗口化的计算模式(3DW-MCA)。

这种设计鼓励了更多的时空信息交互,强化了时空域特征,完整的网络结构如下图所示。

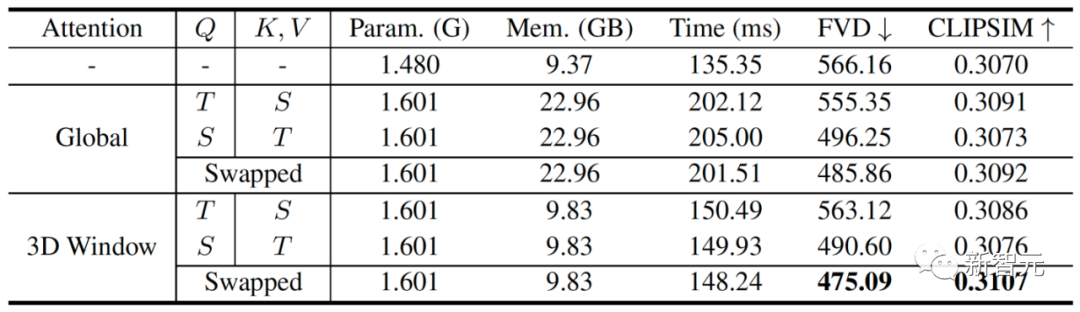

实验结果表明,交替交叉注意力机制极大地提升了网络对时空信息的建模能力,同时3D窗口的注意力优化将计算开销(包括运行时间和显存消耗)显著降低,并进一步提升了网络的生成性能。

2.2 首个超大规模的高质量视频生成数据集

丰富的文本-视频数据对是训练开放域文本到视频生成模型的先决条件。

然而,现有的文本视频数据集在规模或质量上总是受到限制,影响了高质量视频生成模型的构建。

文章作者详细分析了现有数据集的规模和质量,并提出了业内首个同时满足:高画质、大规模、强标注的文本视频对数据集HD-VG-130M。

该工作首先根据HD-VILA-100M[2]的视频标签进行采样,从YouTube上收集原始高清视频。

由于原始视频具有复杂的场景转换,不利于生成模型学习时间相关性,因此使用PySceneDetect检测并分割这些原始视频中的场景,最终得到130M个单场景视频片段。

进一步,文章作者提取每个视频片段的中心帧作为关键帧,使用BLIP-2为关键帧加上描述文本作为每个视频片段的文本描述。

HD-VG-130M中的所有视频片段都是单一场景,这确保了关键帧的描述在大多数情况下具有足够的代表性,可以描述整个片段的内容。

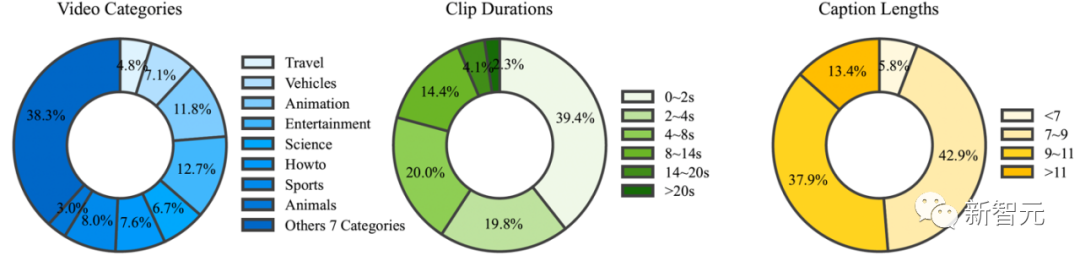

该工作从视频类型、视频时长和描述文本长度三个方面对数据集进行了全面分析,确保了该数据集中的视频具有丰富的多样性,且时长与文本长度都利于视频生成模型的训练。

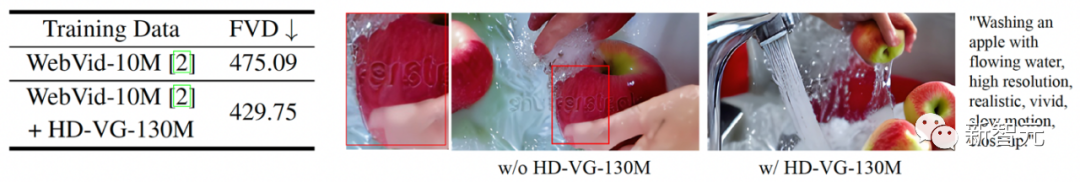

通过使用提出的大规模高质量数据集HD-VG-130M进行训练,网络在数值指标上得到了显著的提升,同时在生成视觉效果得到了显著的优化,例如生成的样本不再带有水印。

3. 实验结果

该工作以LDM作为预训练的图像生成网络,使用了公开的WebVid-10M和HD-VG-130M进行联合训练。

推理时,联合4x的预训练的超分辨率网络,最终生成1376 x 768的高清视频。

3.1 数值指标

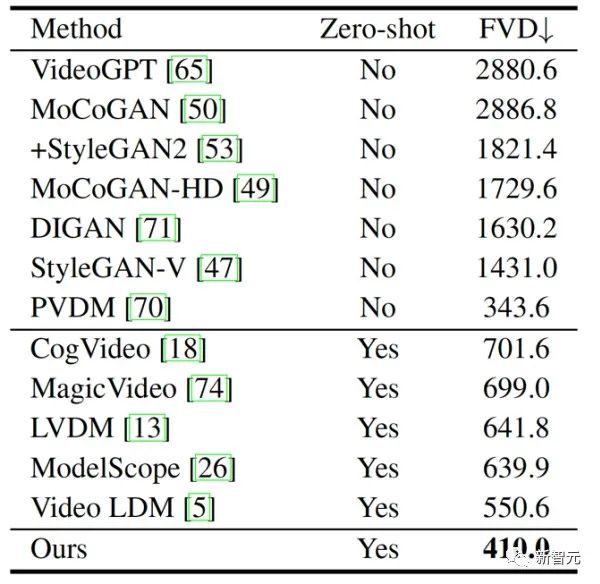

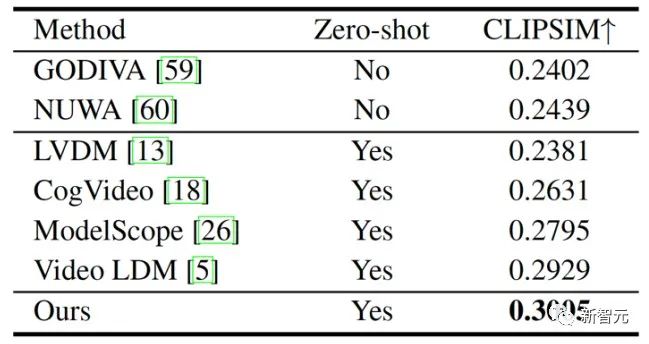

该工作在多个数据集上进行了与Zero-Shot和非Zero-Shot方法相比较的丰富实验。

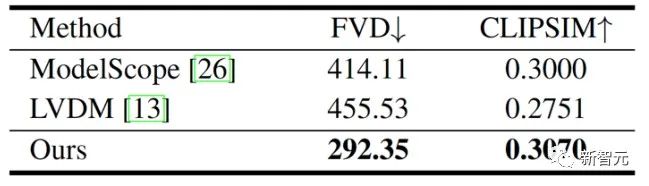

在UCF-101的实验中,VideoFactory在Zero-Shot的设定下,显著超越了其它同类型的模型,提升了FVD指标。

在MSR-VTT的实验中,该方法证明了其生成的样本与输入的文本具有极高的匹配程度。

在WebVid-10M中,文章作者选取了5K的独立测试集进行性能评估,该方法在生成指标上显著领先于现有的其它方法。

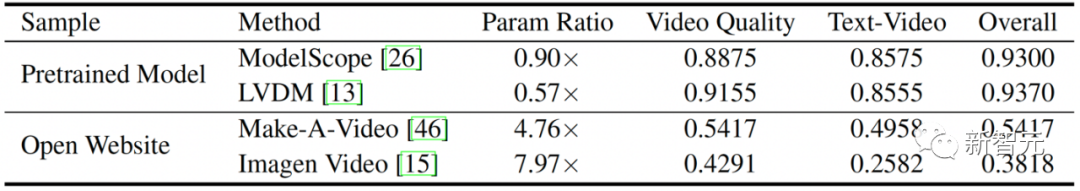

最后,该方法进行了人工评测,测评指标包含:视频画面质量、文本和视频内容的匹配程度、综合视频效果三个维度。

在与开源方法的对比中,VideoFactory以压倒性(综合偏好度93%)的优势获得了测评人员的认可。

同时VideoFactory也尝试了与当前的超大型闭源模型进行了性能的对比,该工作以超小的模型规模(仅12%~21%的参数量),在与这些模型公布的优秀样本对比中,取得了可匹敌的性能。

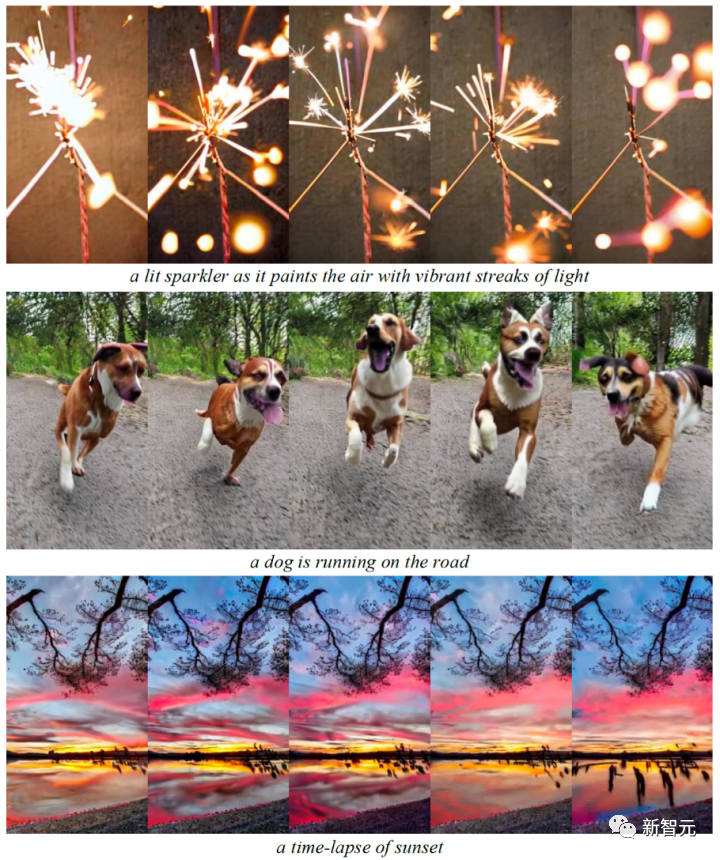

3.2 视觉效果

该工作也展示了与Imagen Video[3]、Make-A-Video[4]和Video LDM[5]的视觉效果对比。

值得注意的是,对比的方法均为当前未开源的超大模型,对比的样本均为各方法对应主页的优秀展示样本。

Make-A-Video只生成1:1的视频,这限制了用户体验。

与Imagen Video和Video LDM相比,该工作的模型生成的熊猫和金毛犬具有更生动的细节。

同时该工作也展示了与现有的其它开源模型的生成样本对比,可以明显看出,在画面构图、时序连贯性等方面,该工作有显著的效果领先。

更多生成样本展示了该工作高质量的泛化性和稳定性。

虽然目前该工作暂未公开项目主页,但小编发现作者搭建了一个数据集GitHub项目https://github.com/daooshee/HD-VG-130M),其中数据集可以通过邮件作者的方式申请。

应用模型

基于基础模型,团队实现了两个下游视频的生成任务,用以完全释放基础模型的性能,并直接能够与用户交互,实现良好的体验。

1. 电影生成模型MovieFactory

电子科技大学和MSRA等机构的研究人员提出了全自动化的电影生成模型。

用户只需要给出一句简单的电影主题,模型就可以帮用户生成电影级画质(3072 x 1280)、电影风格(多场景)和带有音乐的高质量电影。

目前,该论文已被ACM Multimedia 2023 Brave New Idea(BNI)接收。

作者列表:朱俊臣,杨欢,何汇国,汪文靖,拓子曦,郑文皇,高联丽,宋井宽,傅建龙

论文地址:https://arxiv.org/abs/2306.07257

1.1 方法设计

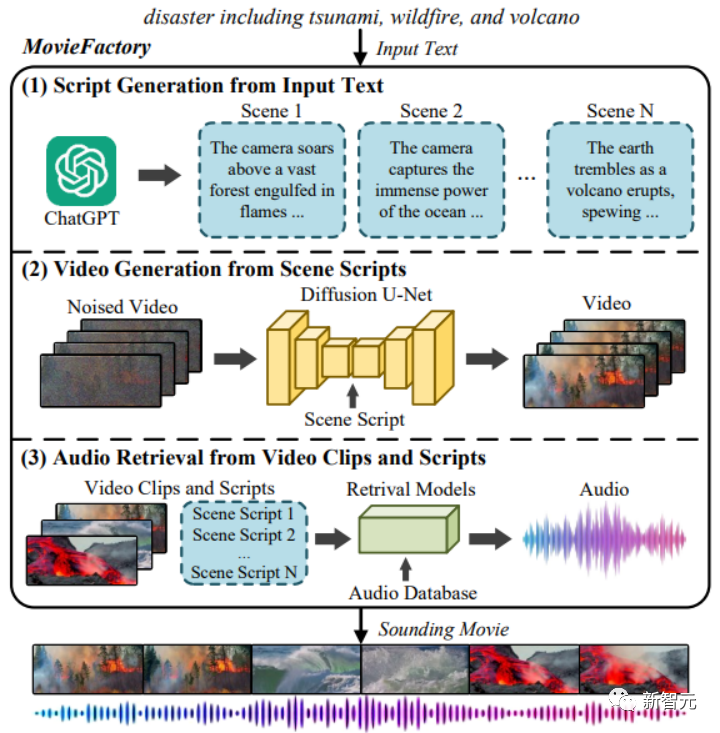

作者结合了现有的语言和图像生成大模型,构建出了可生成多幕场景的视频生成器,并采用了检索模型助力音频部分的生成。

由于要生成高质量的多幕场景,视觉生成模型需要多个引导文本。

为了让用户输入的简单且高度概括化的文本变成电影所需要的详细「剧本」,该工作采用了ChatGPT对文本进行扩充丰富。

作者设计了一套提示词(prompts)用以实现该功能。这些提示词引导ChatGPT形成一系列剧本,并且使得这些剧本能符合编剧的准则,同时能为用户指定的主题引入创新和独特的元素。此外,剧本也能有效地发挥视频生成模型的能力。

有了剧本之后,视频生成模型即可完成各幕的生成了。

考虑到电影与普通视频域之间存在的差异,例如:超宽屏画面和画面风格。而高质量的电影的相关数据却十分稀少,因此需要将预训练的基础模型快速迁移至电影生成上。

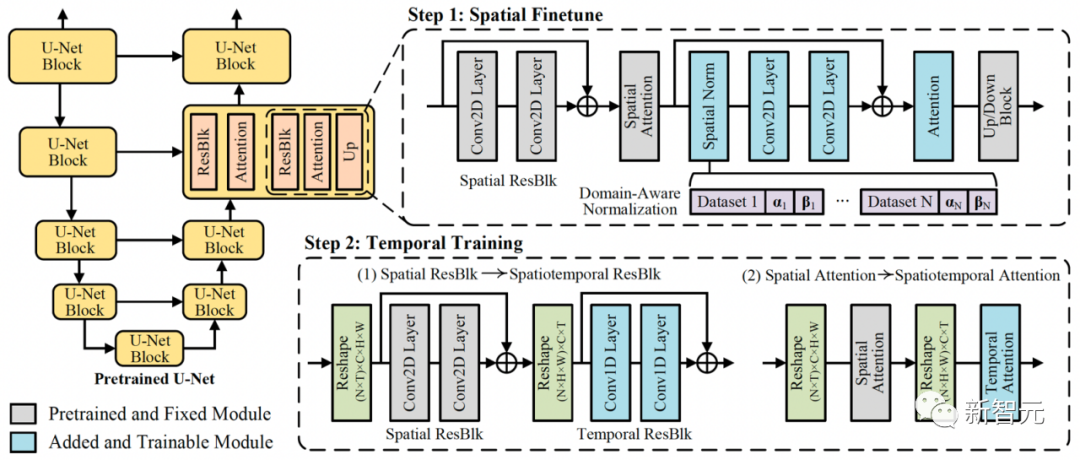

模型大体上与前文介绍的基础模型VideoFactory保持一致,并设计了新的模块用于实现快速的视频域迁移。

从图像生成模型拓展至视频生成模型时,不同于之前的工作会训练所有网络参数,该工作固定了预训练的所有参数,并添加了新的层对视频的空间信息进行拟合。

这种设计有两个优点:

1)可以完全保留预训练中的全部知识,从而生成训练数据集中不包括的内容和场景,这对于电影奇幻场景的生成尤为重要;

2)可以在新的模块中拟合多个视频域分布,这使得对于任何视频域数据的训练都不会产生数据域偏离的问题,并保持了网络生成高质量画面的能力。

基于这种设计,MovieFactory能够快速地从预训练视频迁移到电影画面的生成。

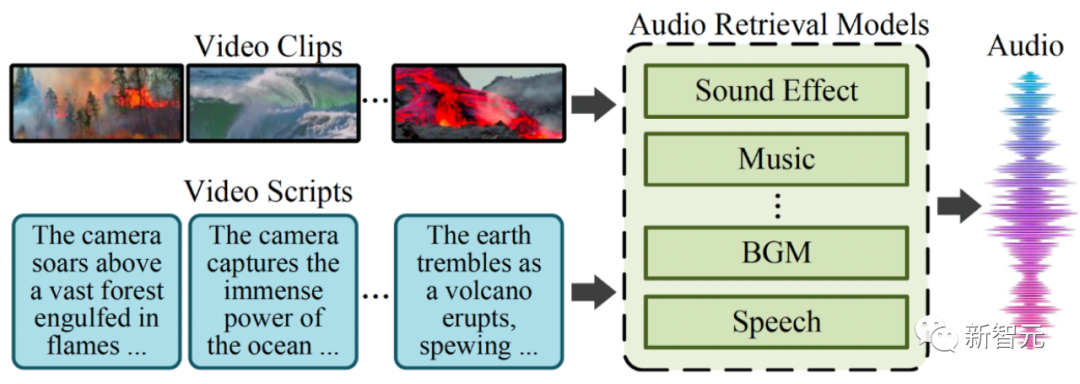

有了丰富的画面,电影还需要音乐和声效。对此,作者提出了采用检索模型依据画面和电影脚本为视频匹配合适的音频。

该工作同时采用了文本到音频和视频到音频的检索模型,以保证音效的丰富性和合理性。

同时对于背景音乐的选取,作者利用ChatGPT总结了故事情节和基调,然后将推荐的基调类别与音乐信息检索技术相结合,以识别合适的音乐曲目。

1.2 视频生成

作者选择Stable Diffusion 2.0作为基础图像生成模型,采用WebVid-10M和基础模型中提出的HD-VG-130M联合训练基础生成模型,并使用了少量的电影数据集进行画面的拟合。最后采用了4x视频超分辨率模型获得3072×1280的高清超宽屏电影视频。

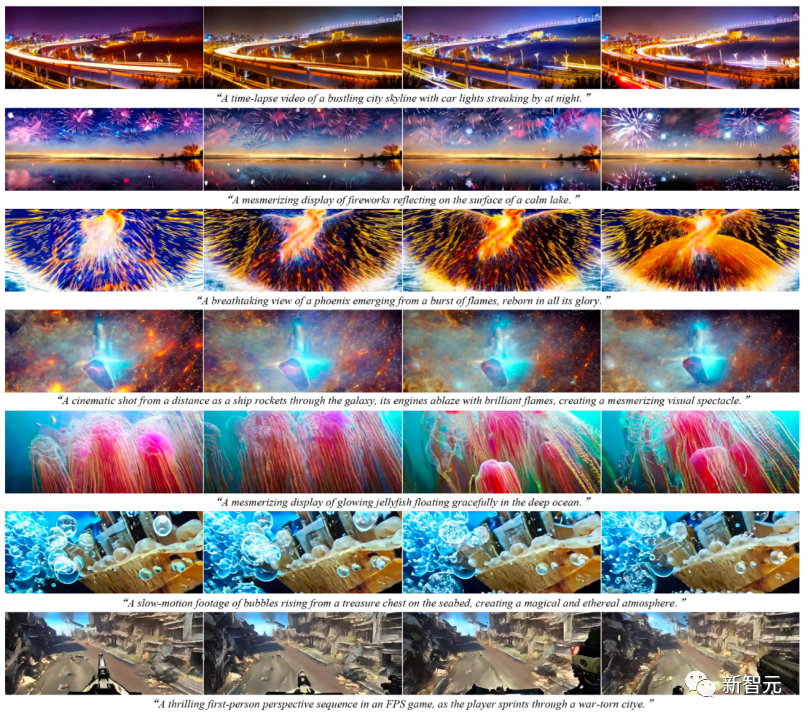

视频部分的生成结果展现了模型能够生成具有清晰画面(没有任何水印)和平滑物体运动的高质量视频。生成的视频涵盖真实与科幻的场景,并展示出了丰富的细节。

用户仅需给出简短的电影主题,例如一个宇航员的太空冒险(An Astronaut Space Adventure),该模型会自动生成电影的脚本,并由此生成多幕的带有音频的高质量电影。

2. 短视频生成模型MobileVidFactory

另一篇来自电子科技大学、MSRA,以及罗切斯特大学等机构的工作,提出了全自动化的移动设备短视频生成模型。

只需与用户进行简单的自然语言交互,模型即可生成竖屏、带有定制化内容和带有音乐的短视频。

目前,该论文已被ACM Multimedia 2023 Demo接收。

作者列表:朱俊臣,杨欢,汪文靖,何汇国,拓子曦,喻永生,郑文皇,高联丽,宋井宽,傅建龙,罗杰波

链接:https://arxiv.org/abs/2307.16371

值得注意的是,作为共同作者的罗杰波教授也是之前的视频生成工作latent-shift[1]的作者。

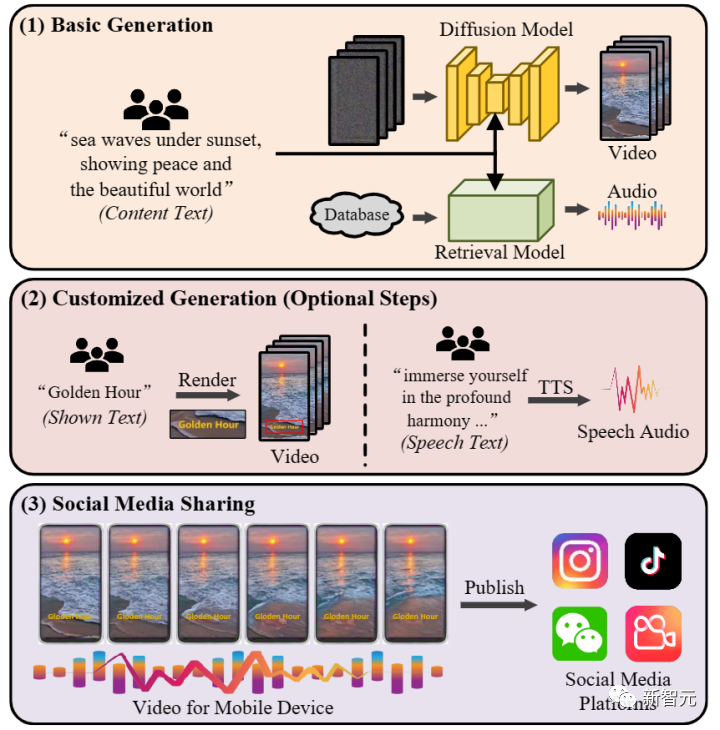

2.1 方法设计

该工作直击当前最火热的短视频,借助高效的视频生成模型和音频检索模型,结合基于文本的语音合成技术,构建出符合当前短视频风格的生成框架。

该框架分为两部分,分别是基础生成部分和可选择的定制化生成部分。

在基础生成中,该工作与MovieFactory一致,独立地生成视觉和听觉内容。不同的是,该工作添加了可选择的视频插帧模型来提升整个模型输出视频的连贯性。

在定制化生成中,作者为用户设计了两个可选的自定义功能。

首先,模型支持在视频中添加自定义的文本贴图,以辅助作者概括视频内容和表达创作想法。特别的,文本覆盖还促进了听力障碍者的无障碍性,并迎合了不同的受众。

除此之外,为了增加个人风格,增强短视频的故事性和提升整体真实感和互动性,模型允许用户在视频中添加配音。

依据用户提供的文本,模型使用预训练好的TTS(Text-To- Speech)将文本转换为配音。在这个过程中,用户可以选择自己喜欢的语音,并且很好地支持各种语言,如英语和汉语。

2.2 短视频生成

该工作在生成画面的质量上符合短视频的构图和美感。

在最终的短视频生成上,达到了丰富的创作表达,和实现了短视频的趣味性。