我们知道音乐和图像是两种可以唤起情感和讲述故事的强大媒介。

但如果我们将它们结合起来呢?这就是音乐生成图像的用武之地。借助 Hugging Face 等机器学习模型,我们现在可以根据音频输入生成令人惊叹的视觉效果。

Hugging Face

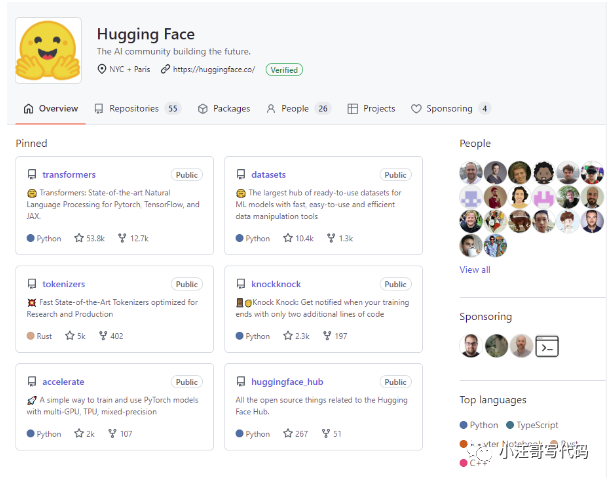

首先我们来了解一下Hugging Face,Hugging Face是一家非常活跃的人工智能创业公司, 是一个为开发人员和研究人员提供最先进的自然语言处理 (NLP) 模型的平台。包括Google AI、Facebook AI、微软在内,有超过5000多家机构都在Hugging Face的社区发布内容。

当初,Hugging Face是一个致力于开发聊天机器人的公司,成立于2016年,旨在利用聊天机器人来娱乐年轻人。虽然这个创意听起来很有趣,但实际上并没有取得太大的成功。然而,无心插柳柳成荫,Hugging Face后来在自然语言处理(NLP)领域取得了重大突破。

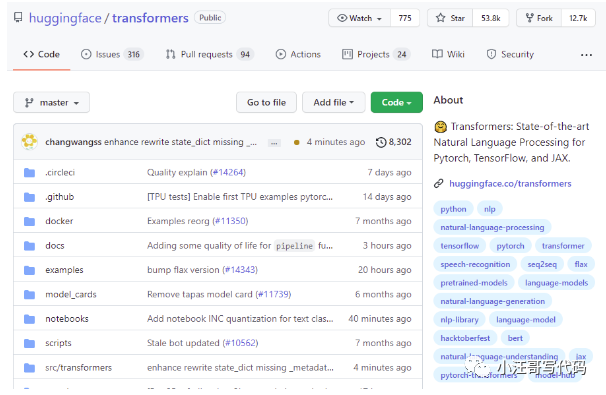

Hugging Face 致力于让最先进的NLP技术变得更易用。融合大家的贡献并整合到一起,发布了名为"Transformers"的库。这个库中包含了数千种预训练的NLP模型,比如Bert、GPT、GPT-2、XLM等,支持超过100种语言的文本分类、信息提取、问答、摘要、翻译和文本生成等任务。目前,Transformers库在GitHub上已经获得了超过5.38万个星标。

如今,Hugging Face的官方网站已经成为一个大型的人工智能社区。他们提供了各种产品和服务,包括一个特殊的社区模式,让各个机构可以在上面发布自己的模型、数据集和展示AI应用的空间。另外,他们还有discord社区、社区论坛和博客等。由于他们在NLP领域的专业能力,他们还提供了基于NLP的各种服务,比如专家支持、推断API和AutoNLP等,来解决企业在NLP方面的问题。

这次的音乐生成图像的模型也来自Hugging Face。

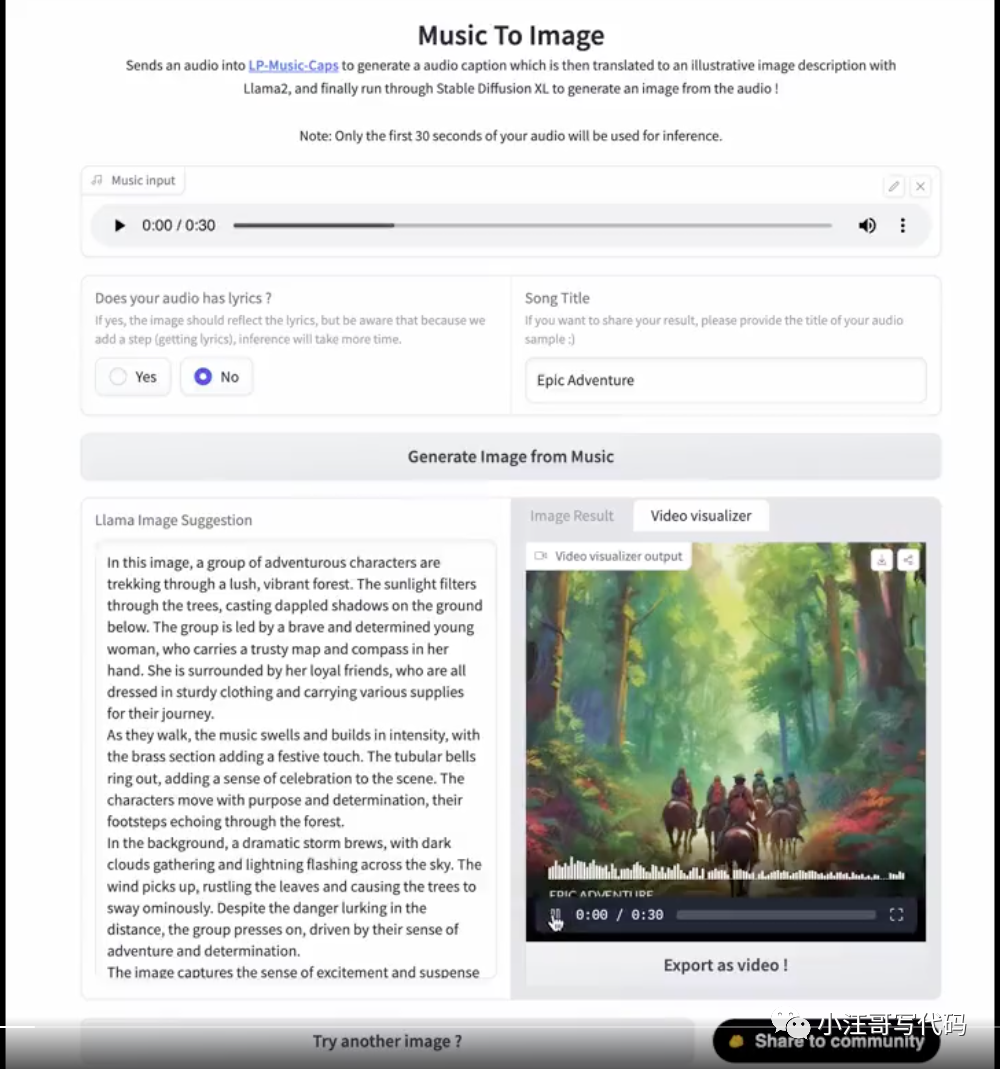

Music-To-Image

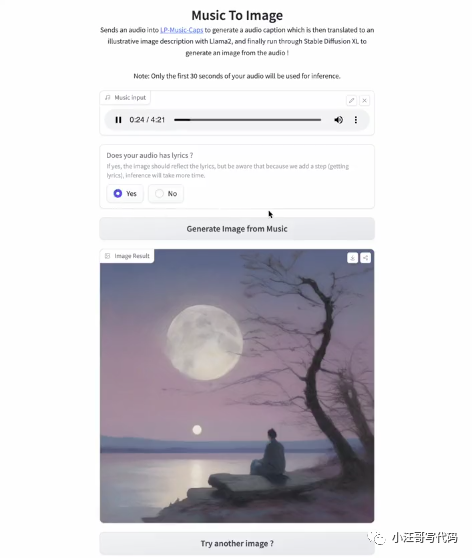

音乐生成图像的概念很简单:我们将音频文件提供给机器学习模型,然后该模型生成与声音相对应的图像序列。生成的图像可用于创建音乐视频、可视化甚至艺术品。

通过使用深度学习技术,能够从音乐中提取特征,并将这些特征转换为图像。

工作原理:

- 音频字幕生成:首先,音频被发送到 “LP-Music-Caps” 模型,该模型生成音频的字幕。这些字幕可以描述音频的内容、情感和主题。

- 图像描述生成:然后,这些字幕通过 “Llama2” 被翻译成插图图像描述。这个描述可以是对音频内容的视觉解释,为下一步的图像生成提供指导。

- 图像生成:最后,这个图像描述通过 “Stable Diffusion XL” 生成与音频相应的图像。这个图像可以是音频的抽象或具体的视觉表示。

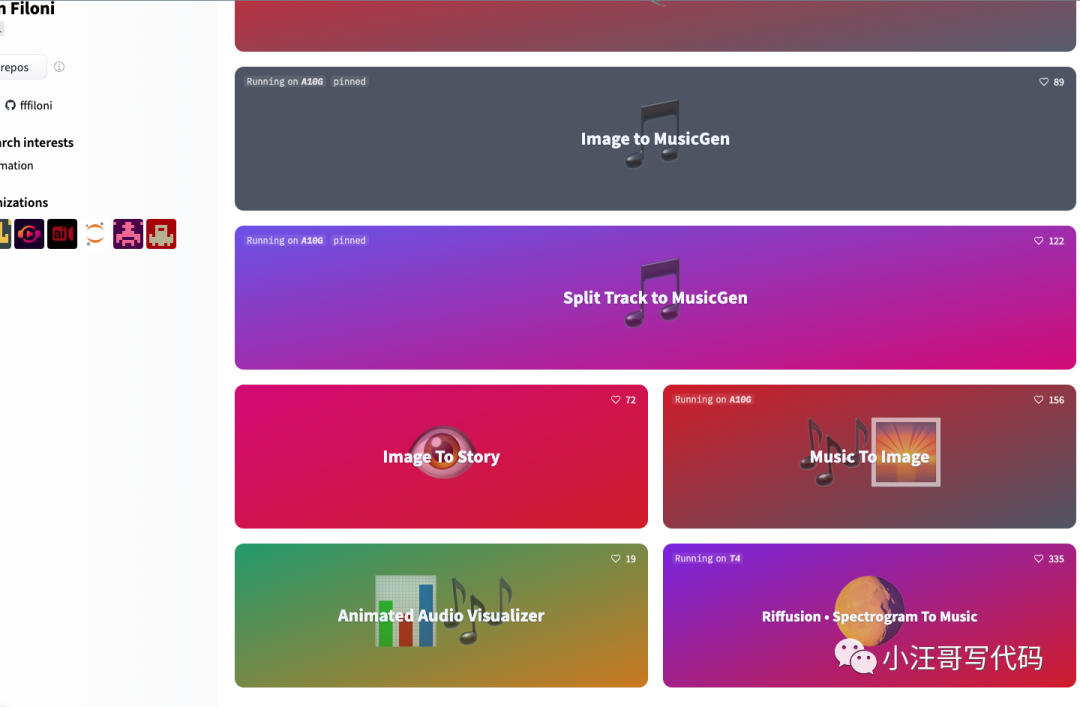

这个模型的作者还是很厉害的,除了music to image,还有其他的模型:

体验地址:https://huggingface.co/spaces/fffiloni/Music-To-Image

最后

想象一下音乐视频,其中每一帧都是根据音频输入即时生成的。或者是根据正在播放的音乐实时生成视觉效果的现场表演。可能性是无止境。

但音乐生成图像的潜力并不止于此。借助 Hugging Face 的 NLP 模型,我们可以根据歌曲的歌词生成图像。这开辟了一个全新的创作可能性世界,视觉效果可以直接反映歌曲的含义和情感。

当然,音乐生成的图像仍然存在一些限制。视觉效果的质量很大程度上取决于音频输入的质量和所使用的机器学习模型。尽管这项技术已经取得了长足的进步,但在生成真正逼真的高保真图像之前,我觉得还有很长的路要走。

尽管存在这些限制,音乐生成图像的未来还是可以的。随着机器学习模型的不断改进,我们预计会看到这项技术更具创造性和创新性的用途。

也许有一天我们能够根据单个音频文件生成完整的电影或电视节目。