GPU Utils 发布了一份关于英伟达GPU——主要是H100的研究报告,试图梳理有关GPU供应和需求的相关问题。在这篇主要针对美国市场的报告中,我们看到了目前阻碍大模型和人工智能发展的关键瓶颈GPU短缺是如何形成和发展的。

总的来说,GPU瓶颈的出现原因是多方面的,环环相扣的复杂工艺制造流程,半导体周期,对稀缺资源的抢占与恐慌乃至未曾预料到的人工智能的突然爆发,都让GPU算力变得无比紧张。

乐观地看,2024年这一瓶颈或许会有所缓解。

数十万张缺口,一百五十亿需求

每个想要在人工智能爆发中分一杯羹的人都需要GPU。准确地说,是英伟达的A100和H100,它们在训练和推理大模型中扮演关键角色。如果要想要从头训练大模型,至少需要上千张A100或H100,而推理和微调大模型也至少需要储存100张。

具体到每家的数量上,报告汇总了一些数据:GPT4在1万到2.5万块A100上训练,Meta有2.1万块A100,特斯拉有7000块,Stability AI有5000块,谷歌云大概有2.5万块H100,微软Azure 有1万到4万块,甲骨文可能也有同样多的H100。值得一提的是,Azure的GPU基本都用来供应OpenAI的训练了。

而根据马斯克的说法,GPT5的训练可能会用到3万到5万张H100,因此对未来的估计上,报告指出OpenAI可能需要5万张H100,Meta至少需要2.5万张(也有人说实际上需要10万乃至更多),所有的云服务厂商,微软、谷歌云和亚马逊云以及甲骨文各需要3万张,私有云服务商,比如刚刚融资的CoreWeave等总需求是10万张,而像Claude的开发者Anthropic这样的初创公司也都至少需要1万张GPU。

另外,一些金融公司比如JP Morgan等也在部署A100或H100,因此总体上看,对H100的需求超过了43万张。

这还是不算中国市场的情况,由于制裁原因,字节跳动、百度、腾讯和阿里巴巴只能大量购买A100和H100的替代产品A800与H800,这一部分的需求没有列入其中,根据《金融时报》的说法,其总额高达50亿美金。

如果将这些数字相加,这就是目前英伟达面对的,总计规模高达200亿美元的GPU需求。

黄仁勋没有骗我,买的越多,省得越多

作为A100的更新版,H100拥有着更好的性能,尽管它的价格更昂贵,单张约为3.5万美元。

根据产量需求和成本,大部分企业都把A100和H100混用以节省成本。具体来说,在大模型训练环节往往会使用3.2Tb/s 无限带宽(IB)的H100 GPU,在模型推理环节,则往往也可以使用A100。

相比A100,H100的升级主要体现在具有更低的缓存延迟和FP8计算能力,这两者都显著提升了显卡处理模型的效率。另外,H100还具有更好的拓展性,方便实现大规模部署。

总的来说,H100的16位训练速度快了2.3倍,推理速度快了3.5倍,而它的成本——根据报告所说,仅是A100的1.5倍到2倍。

这正是黄仁勋在不同场合都反复强调的,the more you buy, the more you save. 买的越多,省得越多。

关于H100芯片的组合形式有多种,包括英伟达自己设计的DGX H100 ,但市场上大部分公司都选择购买8个GPU版本的HGX H100 服务器,它是由英伟达的合作伙伴们生产的,价格大致在36万到38万美元之间。

HGX也有两种版本,配备SXM接口或者PCIe接口,报告指出市场上70%到80%的需求都是SXM H100,因为这种接口可以实现最大的吞吐量并且不需要连接电源。

市场对H100的趋之若鹜,与竞争对手形成了鲜明的对比。

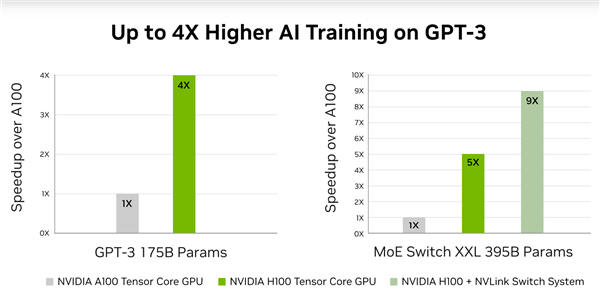

英伟达官方给出的关于训练GPT3时A100和H100的不同表现对比

英伟达官方给出的关于训练GPT3时A100和H100的不同表现对比

没有对手

根据英伟达的更新节奏,直到2024年底或2025年,H100的升级版才会到来,在此之前它将继续统领大模型市场。

竞争对手并没有坐以待毙,比如AMD刚刚推出了名为MI300系列的芯片,英特尔也有名为Gaudi2的加速计算芯片,它们至少在理论上都是英伟达的竞争对手。

然而在实际上,他们面对着比英伟达更大的问题。

报告中主要指出AMD的问题。首先重新配置AMD的设备——就算它可以完美适用大模型训练任务,也需要开发和调试的时间,这意味着在时间上会落后于竞争对手。

其次,一个模型的训练成本接近3亿美元,对芯片的需求往往会超过1万张,没有人会冒风险大规模使用除了英伟达以外的芯片。

最后,限制英伟达GPU的瓶颈——复杂的生产工艺,同样也在限制着AMD的产量——MI250同样难以获得。

至于另一个竞争对手Gaudi2,由于英特尔自己拥有工厂因此它或许在产量上有比较优势,但Gaudi2是一款几乎全新的芯片,针对它的研究和测试还非常少,事实上英特尔自己还在对其进行各种配套开发和优化,预计到今年下半年晚些时候才能调试完毕,而这时H100已经上市一年多了。

因此总结下来,目前为止H100就是是训练大模型最佳的GPU,没有之一。

GPU瓶颈到底在哪里?

目前,H100的供应已经相当短缺,有传言说微软Azure和谷歌云的容量实际上已经快用完了,亚马逊云也面对同样的情况,传言目前下单需要等数月乃至半年。

导致稀缺的原因是多方面的,最根本的是,GPU是一项极端复杂的技术,需要世界上最先进的生产工艺,而掌握这项工艺的工厂——台积电,它的产能是有限的。

目前H100都由台积电代工,使用4N工艺,也就是增强型5纳米制程(相比之下A100使用的是N7),这几乎是目前最复杂的芯片制作工艺,从开始生产到出售给客户,H100中间经历的生产、包装和测试环节一共需要6个月左右,这就意味着对H100的生产需要英伟达和台积电进行提前的布局,这在半导体行业来说是经常的事,但这一次英伟达和台积电显然都对H100需求出现了错误的判断。

这很好理解,因为ChatGPT爆发是去年底的事,那时关于今年的生产计划(至少是上半年的计划)已经规划好了,台积电总体的生产能力是有限的,还需要在不同的大客户之间分配,而产能爬坡也需要一个很长的过程——不要忘记生产H100这种GPU包含着全世界最复杂的工艺流程。

报告中特别指出生其中之一的瓶颈在于所谓CoWoS封装(Chip on wafer on Substrate 芯片、晶圆、基板封装),它目前的月产量是8000片,今年底有望提升至 11,000 片, 2024 年底则达到每月 14,500 至 16,600 片左右的水平,也就是说,想要提升一倍的产量,几乎需要一年半的时间,这当然也是由于生产工艺异常复杂导致。

这直接影响了H100的生产,更何况并不是只有一家在使用CoWoS封装工艺,英伟达的竞争对手AMD以及博通、思科和赛灵思等都同样在使用这种工艺制作芯片,又一次,台积电的产能瓶颈限制了GPU的供应。

另外,H100所使用的HBM3系列内存也是一个生产难点。报告指出英伟达主要在使用SK海力士的内存,后者是这一领域的领军者,特别是在HBM内存的研发上。HBM技术直接把内存堆栈放在GPU芯片上,实现了更高的带宽和更低的功耗。今年4月20日,SK海力士宣布在全球率先研发出12层堆叠的HBM3内存,单颗容量达到24GB。内存容量越大,意味着GPU可以装载下更大的模型,然而HBM3内存的生产过程也十分复杂,产量提升同样困难重重,实际上另外几家芯片大厂,比如三星和美光,都很难提升HBM内存的产量,据说SK海力士正在根据英伟达的要求增产,在刚刚过去的SIGGRAPH 2023 上,黄仁勋发布了GH200超级芯片的更新版, 采用了增强的HBM3E内存,这可以看作是英伟达在内存领域同供应商密切协作的一个例子。

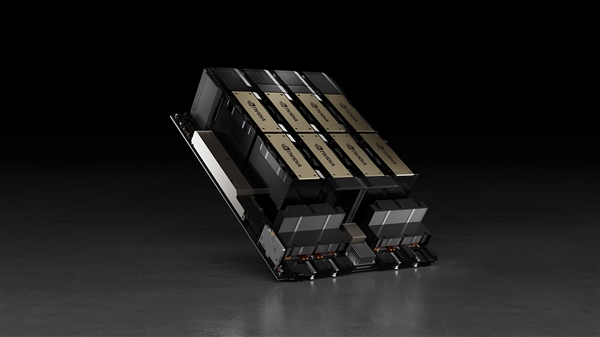

装有8个H100 的 HGX 服务器

装有8个H100 的 HGX 服务器

稀缺性螺旋、配货机制与GPU金融化

通过和台积电以及上下游供应链的积极协调,H100的产量会逐渐提升——英伟达在财报电话会上谈到了这一点,尽管没有对具体数字做任何承诺。

然而当我们理解GPU瓶颈的时候,并不能简单把它等同于产能瓶颈,这是报告中没有明确指出,但又十分显而易见的一点——这种稀缺同时还由各种市场和非市场因素造成。

当然,首要的还是英伟达本身对产品的分配。GPU本就稀缺,因此在服务客户的角度上,英伟达推行了一套和奢侈品配货制度颇为类似的机制——由英伟达来挑选自己的客户。

报告中指出,哪些客户能拿到多少GPU有赖于英伟达的规划,而英伟达更倾向于为那些没有开发竞品芯片的企业优先分配GPU——谷歌云、亚马逊云和Meta都在开发自己的芯片,因此英伟达似乎更愿意和甲骨文合作,DGX云基础架构的第一个合作对象就是甲骨文。

其次,英伟达希望了解最终的客户是谁,它更倾向于为大企业和强大的初创公司提供算力,比如说英伟达投资的AI公司 Inflection 就拥有一个巨大的H100集群,而小型云服务商CoreWeave则拥有比谷歌云更多的H100。

CoreWeave完全使用英伟达的GPU,同时也不打算自己做芯片,因此更得英伟达青睐,英伟达甚至还参与了它的B轮融资。

CoreWeave的GPU资源有多富?它使用基于H100的云服务训练GPT3大模型只用了11分钟,相比之下OpenAI用一万张A100训练了14.8天。

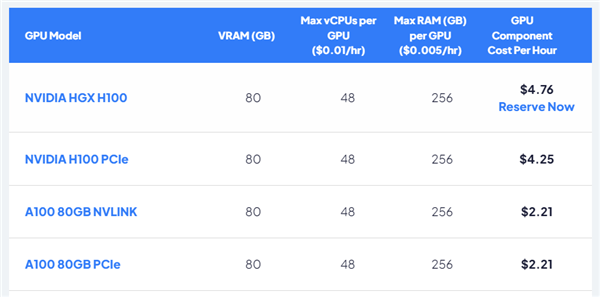

CoreWeave提供的价格列表,HGX H100 每小时价格为4.76美元。

CoreWeave提供的价格列表,HGX H100 每小时价格为4.76美元。

基于这种配货的机制,市场上的GPU流动更不平衡,GPU变得不是一个只要有钱就能买到的东西,这助长了另一种稀缺性——囤积居奇。

大模型的算法和数据的技术难度相对比较透明,相比之下,算力是一道扎实的无法逾越的护城河,有多少GPU直接决定了AI公司的能力强弱,因此GPU囤积变成了许多公司的一种下意识行为——宁可备而不用,不可用而不备,这当然加剧了GPU的稀缺。

迟迟不见提升的产量和坊间各种传闻(比如上面所谓的配货机制,它从来没得到过官方的证实——就像爱马仕从来也不承认有所谓配货机制一样)则造成了一种稀缺的预期,就像对通货膨胀的预期会真的导致通货膨胀一样,对缺货的预期进一步加剧了缺货。

这甚至某种程度上导致了GPU变成了一种战略资源,进而成为一种金融衍生品。CoreWeave 在八月初刚刚进行了一笔价值23亿美元的债务融资,抵押物正是手中的H100,如果这笔钱纯粹是基于对H100的市场均价(这里取37万美元)估出来的话,意味着CoreWeave手中有超过6000台HGX H100,也就是近5万张显卡。

在去年的GTC上,黄仁勋介绍H100

在去年的GTC上,黄仁勋介绍H100

结语

GPU的缺货严重影响了AI的发展,OpenAI 首席执行官Sam Altman说过,使用我们产品的人越少对我们反而越好。

当然你可以说Sam Altman在得了便宜卖乖(事实上也确实是),但某种程度上,这也是他的真心话,算力瓶颈在限制着所有人,这足以说明人类对AI突破的到来多么缺乏准备。

生成式AI和transformer架构都不是最新的发现,它们的理论在很早就在学界广为流传,业界也不乏大举投入其中的公司(当然,OpenAI是最坚决的那个),然而直到ChatGPT和Stable Diffusion出现之前,它们不过是人们认知中通往人工智能的某种方向而已,类似的方向还有很多,而并没有人真的确定哪条道路是正确的。

由此我们可以看出英伟达的布局是多么具有前瞻性,把原本用于让计算机显示图形的并行计算应用于神经网络,这让英伟达比其它任何人都更早地积累了一系列相关技术、算法以及硬件设备,并由此创造了CUDA生态,现在它们共同支撑起了英伟达万亿市值,成为一道短期内很难攻破的企业护城河。

正如GPU的产能短期内恐怕得不到解决一样,AI产业短期内依然要被英伟达的资源所左右,英伟达正在决定生成式AI的未来。