「作为一位 FAIR 研究科学家,我将于 2024 年加入麻省理工学院(MIT)电气工程与计算机科学系 EECS 担任教职。」

AI 领域的著名学者,ResNet 发明人何恺明,最近在个人网站上宣布即将回归学界了。

恺明甚至换上了全新的头像。

在最近科技公司竞争大模型、AIGC 新增长点的背景下,何恺明选择投身研究,做出了一个有引领性的选择。

对此人们纷纷表示欢迎,「他的学生该有福了」:

不知道未来是否会有年轻一代学会何恺明大道至简的研究风格。

也有人表示,希望他在加入 MIT 之后仍可以和 Meta 保持紧密联系,因为即使贵如 MIT 也没有业界实验室那样丰富的 GPU 算力资源。

感叹之外,人们纷纷开始预测何恺明未来的科研方向。从他个人网站上的叙述来看:「通过计算机视觉问题的视角,我的目标是开发适用于各个领域的通用方法。我目前的研究重点是构建可以学习复杂世界表示的计算机模型,并探索面向复杂世界的智能。我研究的长期目标是通过更强大的人工智能来增强人类智能。」

这可能意味着与现实世界互动的 AI,是机器人?

众人聚焦的转会

何恺明的去向在四个月前成为了 AI 领域人人关注的话题。

今年 3 月,很多人发现 MIT 的网站上出现了一条特别演讲预告。

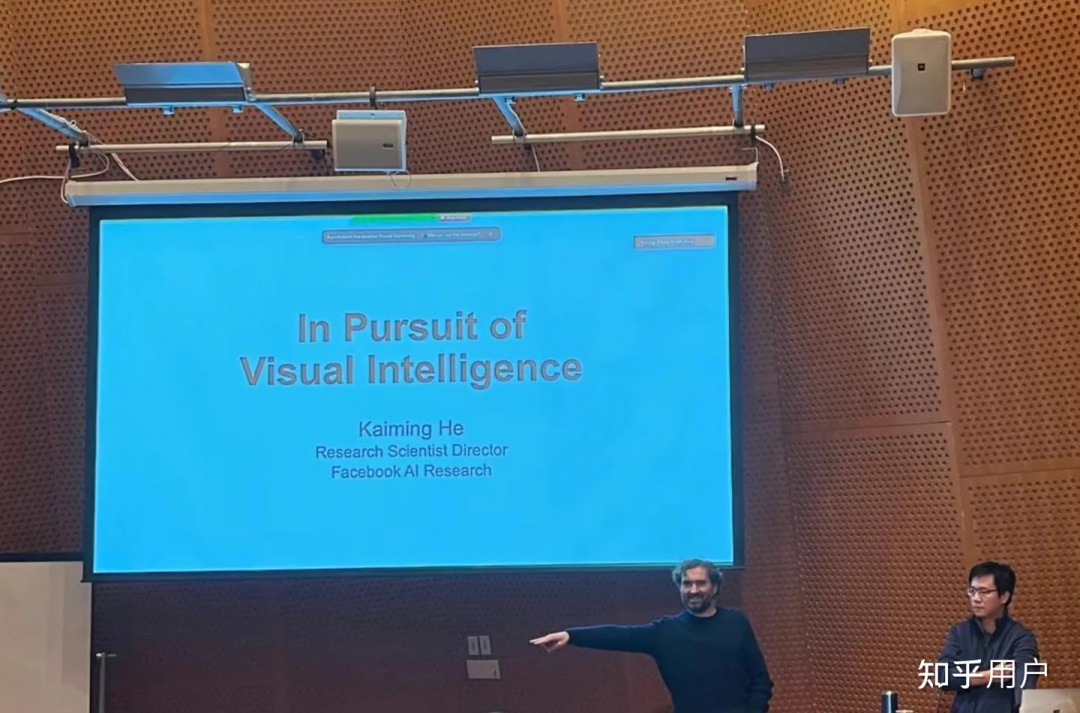

在 MIT 的 EECS,此类「特殊研讨会」通常是前来申请职位的学者进行的「面试」,其内容主要是展示求职者的研究成果。没想到作为学术明星的何恺明的一场小活动成为了大型追星现场,活动当天会议室爆满之后 MIT 不得不临时加开投屏房间,结果远程观看的房间依然爆满。

图片来自知乎

图片来自知乎

可见人们对于这位大神的认可度。

据参与活动的同学透露,在这场演讲过程中何恺明主要介绍了 ResNet、Faster R-CNN、Mask R-CNN、MoCo、MAE 等过去他完成的研究。另外还对未来进行了一定程度的展望,其中包括 AI 作为一个通用工具帮助各个科学领域开展研究,以及自监督学习的更广泛应用。

在 MIT 之行结束后,何恺明近期还曾在纽约大学、普林斯顿进行过演讲。

从高考状元到顶尖 AI 科学家

何恺明是我们耳熟能详的 AI 科学家之一,在计算机视觉领域没有人不知道他的大名。

2003 年,何恺明以标准分 900 分获得广东省高考总分第一,被清华大学物理系基础科学班录取。在清华物理系基础科学班毕业后,他进入香港中文大学多媒体实验室攻读博士学位,师从汤晓鸥。何恺明曾于 2007 年进入微软亚洲研究院视觉计算组实习,实习导师为孙剑博士。

2011 年博士毕业后,何恺明加入微软亚洲研究院工作任研究员。2016 年,何恺明加入 Facebook 人工智能实验室,任研究科学家至今。

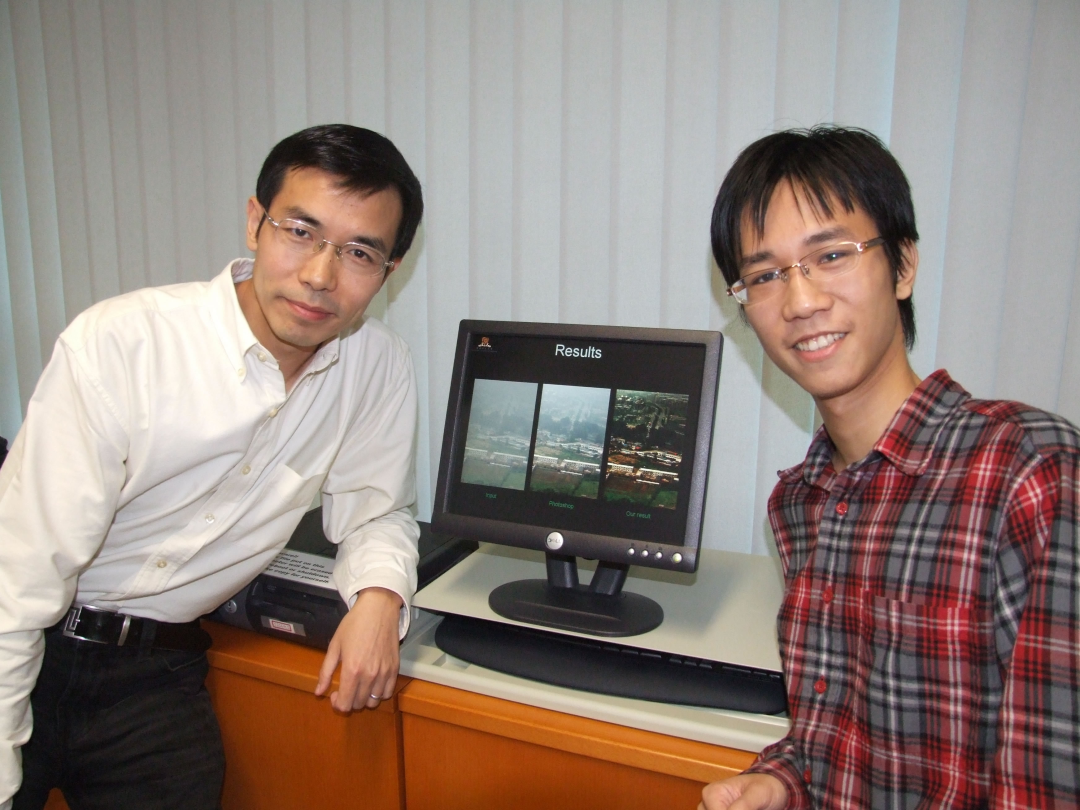

何恺明的研究曾数次得奖。2009 年,汤晓鸥教授、孙剑博士和当时博士研究生在读的何恺明共同完成的论文《基于暗原色的单一图像去雾技术》拿到了国际计算机视觉顶会 CVPR 的最佳论文奖,也是该会议创办二十五年来首次有亚洲学者获得最高奖项。

汤晓鸥与何恺明

汤晓鸥与何恺明

2016 年,何恺明凭借 ResNet 再获 CVPR 最佳论文奖,此外,他还有一篇论文进入了 CVPR2021 最佳论文的候选。何恺明还因为 Mask R-CNN 获得过 ICCV 2017 的最佳论文(Marr Prize),同时也参与了当年最佳学生论文的研究。

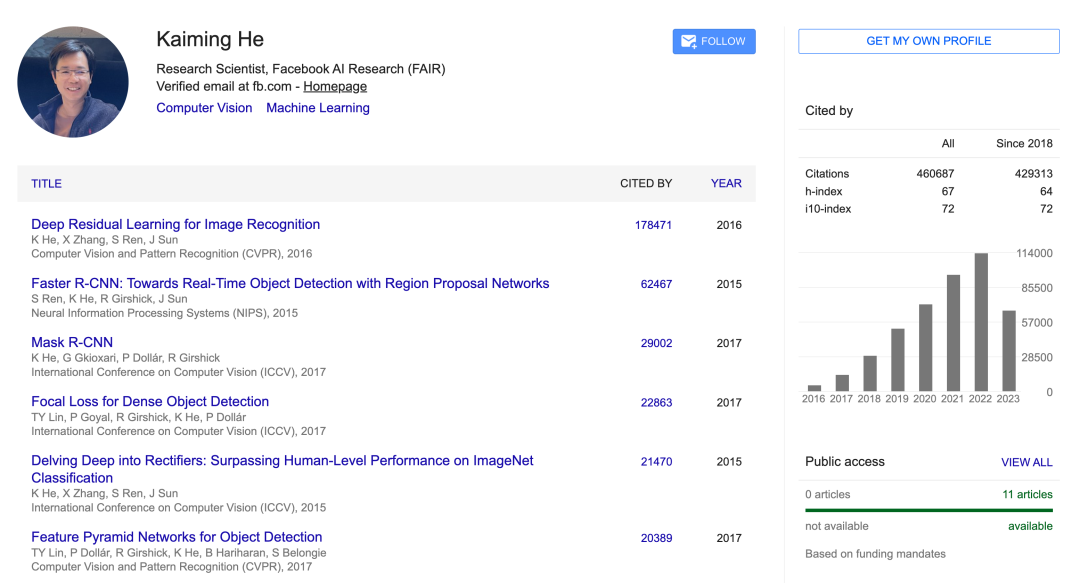

根据 Google Scholar 的统计,何恺明一共发表了 73 篇论文,H Index 数据为 67。截至 2023 年 7 月,何恺明的研究引用次数超过 46 万次,并且每年以超过 10 万次的速度增长。

这是个什么量级呢?简而言之,他加入 MIT 之后会立刻成为该校论文引用量最高的学者,不限学科,没有之一。

那些年,恺明发表过的「神作」

说起恺明大神的作品,最有名的就是 ResNet 了。这篇论文发表于七年前,迄今引用已经超过十七万。

《Deep Residual Learning for Image Recognition》在 2016 年拿下了计算机视觉顶级会议 CVPR 的最佳论文奖。该论文的四位作者何恺明、张祥雨、任少卿和孙剑如今在人工智能领域里都是响当当的名字,当时他们都是微软亚洲研究院的一员。

同样是大神级别的学者李沐曾经说过,假设你在使用卷积神经网络,有一半的可能性就是在使用 ResNet 或它的变种。

何恺明有关残差网络(ResNet)的论文解决了深度网络的梯度传递问题。这篇论文是 2019 年、2020 年和 2021 年 Google Scholar Metrics 中所有研究领域被引用次数最多的论文,并建立了现代深度学习模型的基本组成部分(例如在 Transformers、AlphaGo Zero、AlphaFold 中) )。

如今大模型都在使用的 transformer 的编码器和解码器,里面都有源自 ResNet 的残差链接。

「在 ResNet 之后就可以有效地训练超过百层的深度神经网络,把网络打得非常深,」在 2023 世界人工智能大会的演讲中,汤晓鸥对何恺明的学术贡献不吝赞美:「何恺明把神经网络做深了,谷歌把神经网络的入口拉大了,又深又大,才成为今天的大模型。」

2021 年 11 月,何恺明以一作身份发表论文《Masked Autoencoders Are Scalable Vision Learners》,提出了一种泛化性能良好的计算机视觉识别模型,同样是刚刚发表就成为了计算机视觉圈的热门话题。

一个初入 AI 领域的新人,在探索的过程中看到很多重要研究主要作者都是何恺明,经常会不由得感到惊讶。何恺明虽然长期身处业界,但科研态度一直被视为标杆 —— 他每年只产出少量一作文章,但一定会是重量级的,几乎没有例外。

我们也经常赞叹于何恺明工作的风格:即使是具有开创性的论文,其内容经常也是简明易读的,他会使用最直观的方式解释自己「简单」的想法,不使用 trick,也没有不必要的证明,有的只是美丽的直觉。

如今回归学界,期待恺明能带来更多惊艳之作。