本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

上个月刚免费开放Gen-2,视频领域的Midjourney又双叒叕更新了!

现在,Runway的Gen-2支持无提示词图生视频模式!

就是不用多说,Gen-2秒懂你的那种。

上传一张静态图,不用喂提示词,AI自动生成视频。

即使是人脸转动这种技术活,也完成的很自然。

这次更新意味着,一部大片只需要图片就够了。

手痒的网友们早就按捺不住,纷纷用Gen-2、Midjourney、Elevenlabs、MusicGen等工具,做出一波效果炸裂的大片。

这不,已经有人用Stable Duffision和Gen-2混搭,搞了部科幻短片。

还有网友用Gen-2,结合Midjourney、Elevenlabs、CapCut等工具,做出一部“Evil and good”的影片。

“赛博朋克风”高低也得来一个。

在看完Gen-2生成的这波“大秀”之后,网友们不淡定了,直接表示:

Midjourney 5.2+Gen-2太炸裂,这就是一个很深很深的兔子洞,我指定会迷失一段时间。

更有网友表示,根本停不下来。

网页版免费,体验实录

几张场景人物图片,一段电影内容就出来了,真是有手就行啊!

目前官方表示,网页端已免费可用,并专门放出了体验链接。

另外,iOS也即将上线。

多说不如一试,我们来体验一把。

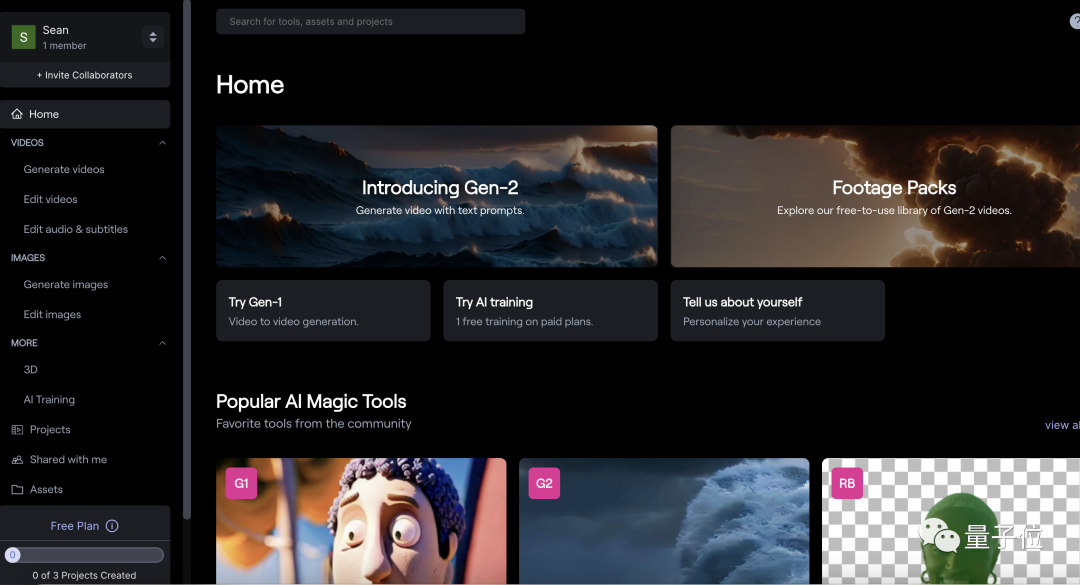

以网页端为例,首先通过网页注册登录runway的账号,进入runway的编辑界面。

点击左侧的Generate Video。

然后点击屏幕中间的Gen-2:Text to Video进入Gen-2。

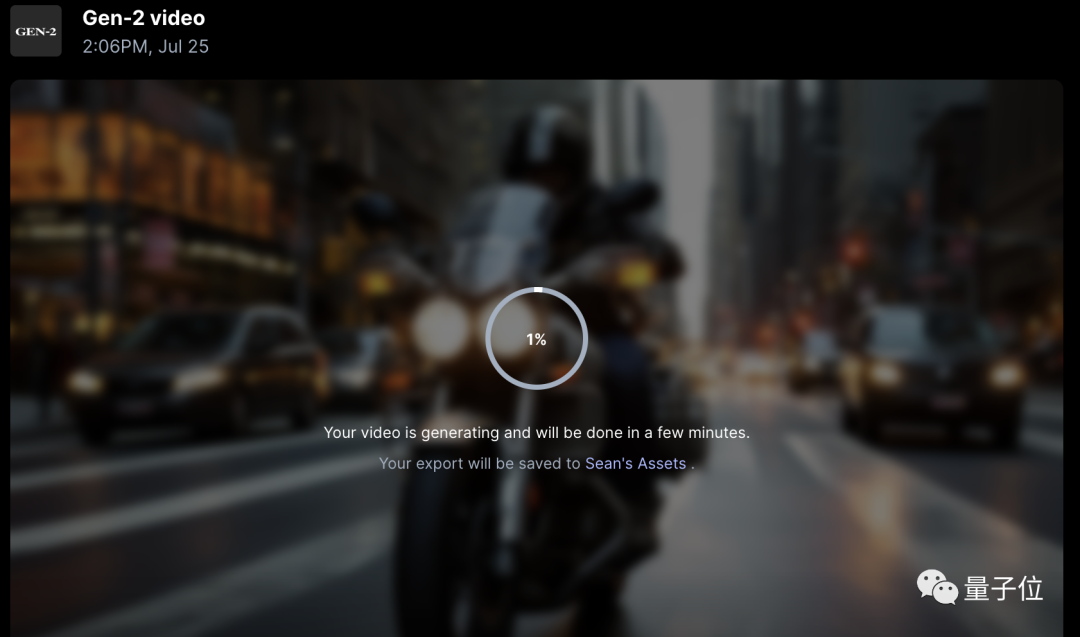

在左边的区域上传一张照片,这里用的是一张由Midjourney生成的照片。

然后不用喂任何Prompt,上传完照片之后就直接点击Generate。

大概1分钟后,一段4秒钟的视频就生成了,图中的摩托车和汽车瞬间就动起来了!

上手后发现,如果图片本身就有动态效果的元素,那么生成的视频的动态效果会更明显。

这主要是因为,现在动态效果只是根据照片里包含的内容来生成。

为了符合物理原理,如果是明显的静物图片或场景,就几乎不会有明显的动态效果。

比如测试的这个视频,就只能隐约看到帆船和海鸥在动。

网友:Gen-2延时方法已get

尽管效果很骚,但有个问题就是视频还是4秒的。

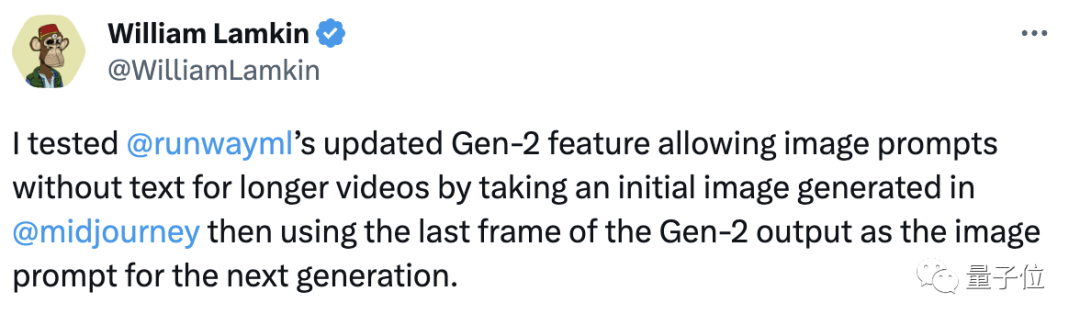

想直接就做一个Video还是短了点,不过目前已经有网友找到方法。

这位网友亲测表示,用Midjourney生成的图像作为初始图像,然后使用Gen-2输出的最后一帧作为下张图的提示,就可以让Gen-2输出更长时间视频。

下面是这位网友实操后的小视频。

可以看到,除了一些细节部分,整体上拿捏的都还不错。

免费不够玩,也能付费

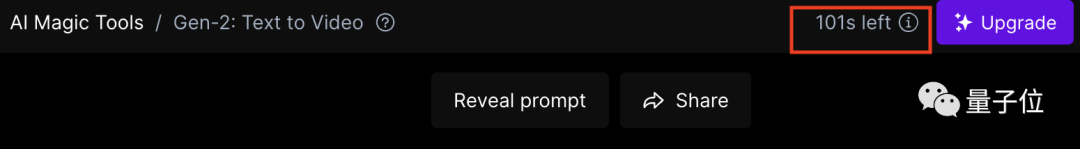

当然,免费玩的额度也是有限的。

根据官方规定,免费试用额度为105秒,每个视频为4秒,也就是大约可免费生成26个Gen2视频。

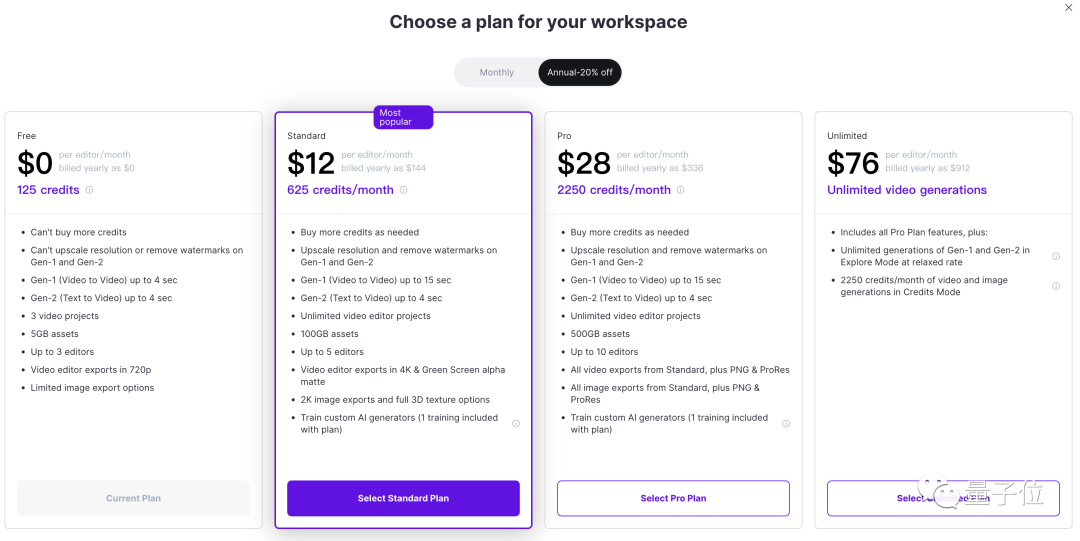

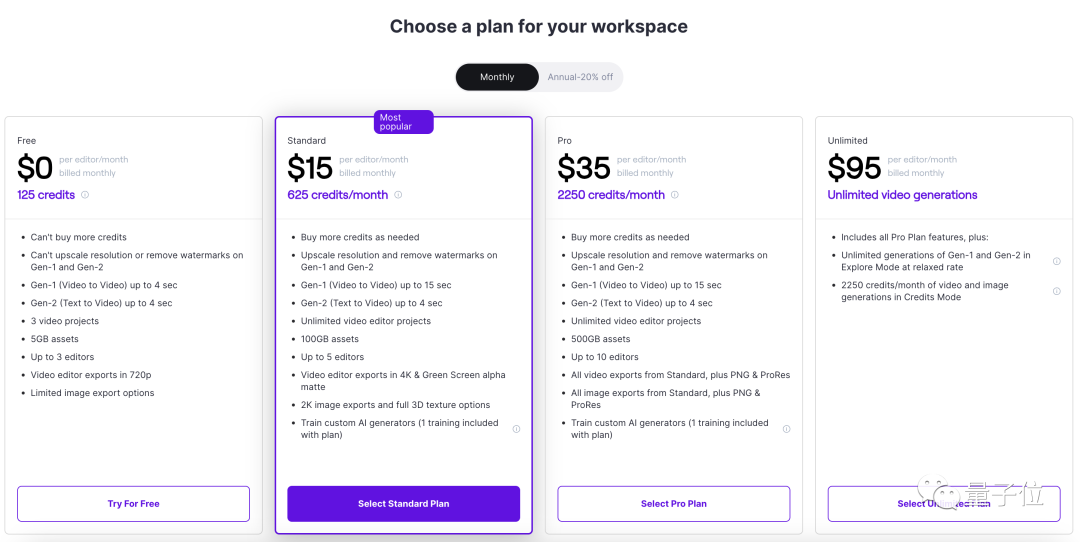

额度用完或者想体验去水印、提升分辨率等额外功能,就需要买会员,标准版为15美元一个月,Pro版35美元,无限视频制作版95美元,年付更便宜一些。

下面这个是月付模式的价格。

这个是年付模式的价格。