2023年的国际机器学习大会(International Conferenceon Machine Learning,简称ICML)在夏威夷檀香山举办。

图片

图片

ICML是由国际机器学习学会(International Machine Learning Society,IMLS)主办的年度机器学习国际顶级会议之一。

ICML创办于1980年,每年6月中下旬举行。今年的议程安排在7月23日星期日到29日星期六。

大会关注的领域涵括计算机视觉、统计和数据科学到机器人技术,目的是将人工智能 (AI) 社区聚集在一起,分享新的想法、工具和数据集,并建立联系以推动该领域的发展。

今年是ICML举办的第四十届会议,大会录用了1827篇论文。谷歌 DeepMind 的研究人员今年在ICML上发表了80多篇新论文。

谷歌在这次会议上报告的主要亮点有:

具有社会目的的机器学习、预测蛋白质结构的AlphaFold模型、具身语言模型PaLM-E、文本生成视频的Phenaki模型等。

图片

图片

除了这些,谷歌还将在会议上重点介绍模拟世界中的人工智能、强化学习的未来研究以及人工智能的前沿挑战中谷歌所做出的贡献。

下面,就来看看谷歌在这三个方面都做了哪些研究吧!

模拟世界中的人工智能

我们现在看到的能够成功进行读取、写入和创造的人工智能,如ChatGPT等,是在大量的数据集上训练的基础模型。

这些基础模型在监督和自监督学习中表现出了优越的适应性和可扩展性,但到目前为止,这些成功尚未完全转化为强化学习(RL)。

这意味着以基础模型为底层运行逻辑的人工智能将难以理解复杂的现实、处理现实中的任务。

谷歌研究人员在这项工作中,证明了大规模训练 RL 智能体会产生一种通用的上下文学习算法,该算法(AdA)可以像人类一样快速地适应开放式新颖的具体现实问题。

图片

图片

AdA是一种人工智能代理,可以像人类一样在模拟环境中适应解决新问题。

它可以承担具有挑战性的任务:以新颖的方式组合物体、导航看不见的地形以及与其他玩家合作。

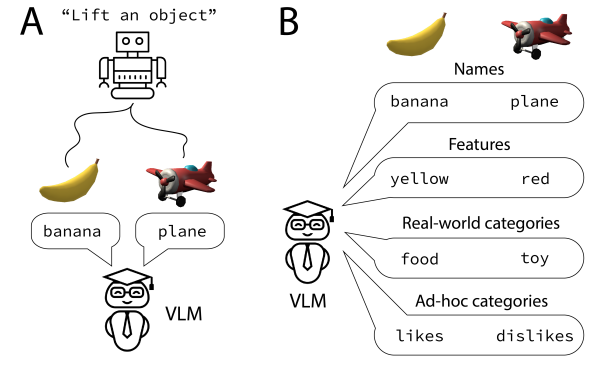

此外,谷歌的另一项研究展示了如何使用视觉语言模型(VLM)来帮助训练智能体。

通过简单的提示让VLM控制监督信号,教导智能体在 3D 渲染环境中根据新物体的名称(例如平面)或特征(例如颜色)与新物体进行交互。

图片

图片

这些研究将为日益通用和自适应的强化学习智能体奠定基础,使这些智能体在更大的开放领域中表现更好。

强化学习的未来研究

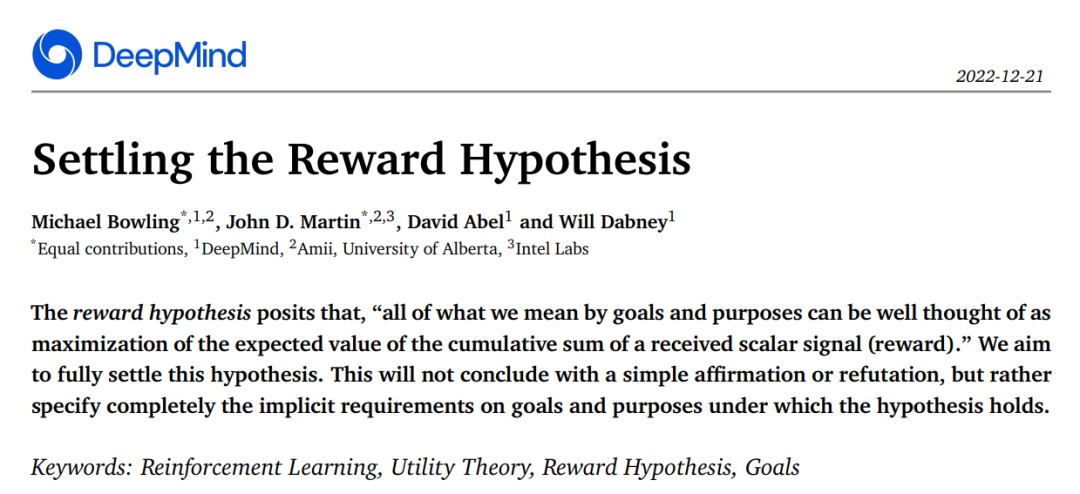

为了开发负责任且值得信赖的人工智能,必须了解这些系统的核心目标。

在强化学习中,定义系统核心目标的其中一种方法是通过奖励。

理查德·萨顿(Richard Sutton)提出的奖励假设认为,所有目标都可以被认为是最大化预期累积奖励。

谷歌研究人员解释了假说成立的确切条件,并阐明了强化学习问题的一般形式的奖励可以(或不能)捕获的目标类型。

图片

图片

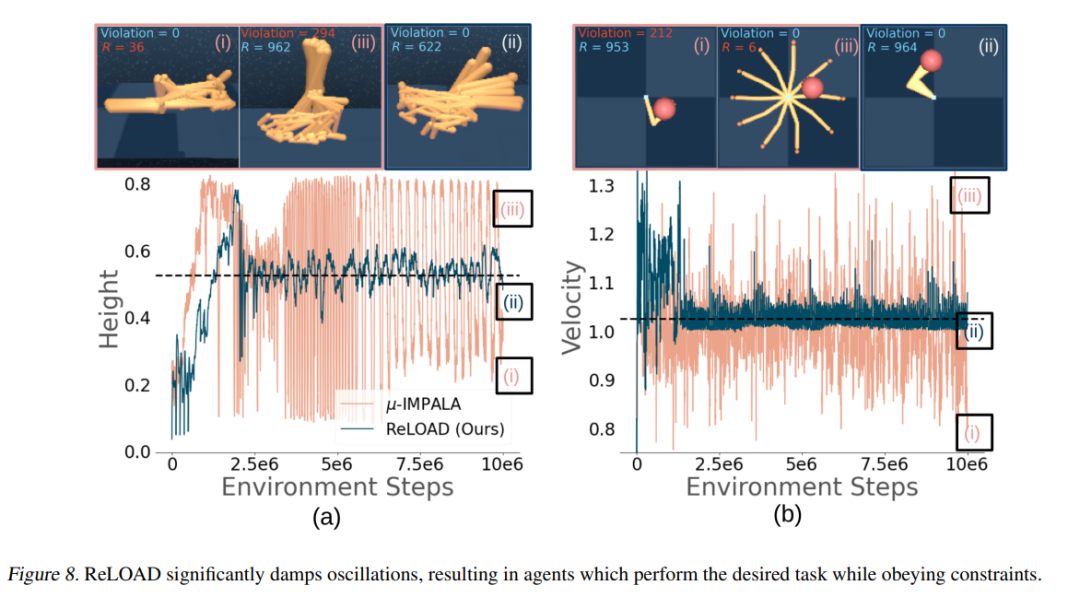

另外,谷歌还在研究中提出:在部署人工智能系统时,需要考虑模型对现实世界的适应性。

因此,谷歌了研究如何在约束条件下更好地训练强化学习算法,因为人工智能工具通常必须受到安全性和效率的限制。

图片

图片

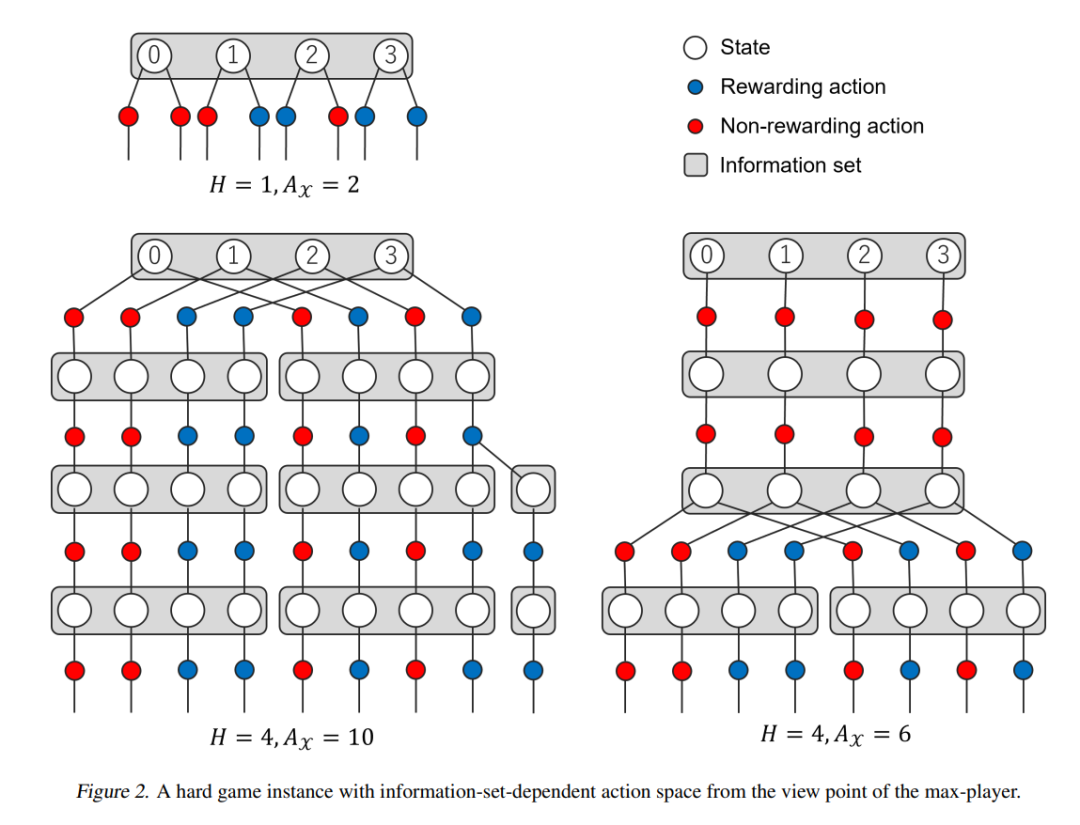

还探索了如何在不确定的情况下通过不对称的信息游戏(例如扑克)来教授模型复杂的长期策略。

图片

图片

在会议上,谷歌将会演示模型如何在不知道其他玩家的位置和可能的行动的情况下赢得双人游戏。

等会议开始,谷歌会玩出什么花样,就让我们拭目以待吧!

人工智能的前沿技术

现有的人工智能基本上都是在一系列打包好的数据集上进行训练的。像最近大火的大语言模型(LLM),它们能够学习并预测语言符号之间的联系,却很难真的理解语言所指的现实世界。

而人类却可以轻松地学习、适应和理解我们周围的世界。

开发能够以类人方式进行推理的先进人工智能系统,将有助于创建可以在日常生活中使用的人工智能并应对新的挑战。

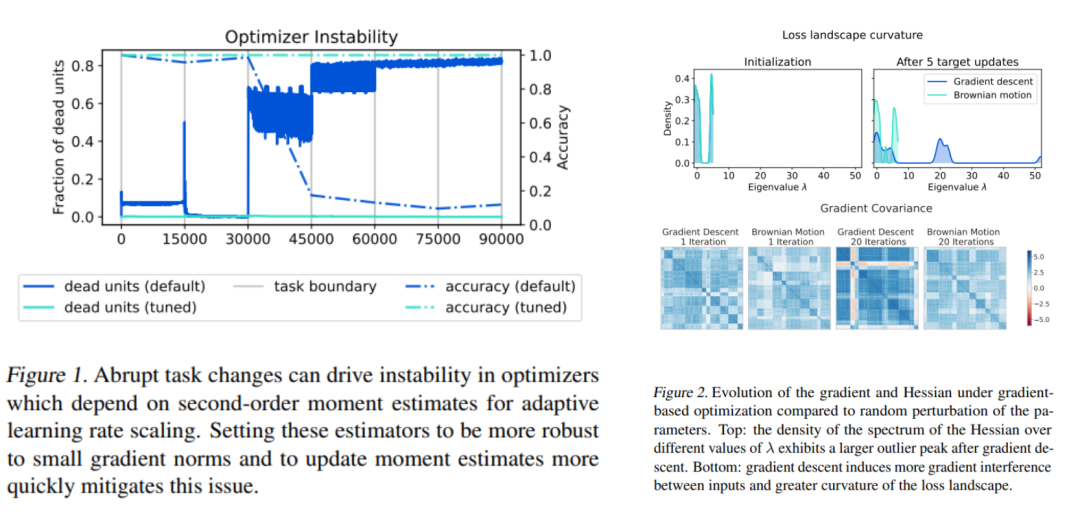

谷歌在人工智能的适应性方面,研究了人工智能根据新信息快速改变其预测和推理的神经网络的可塑性及其损失的原因。

图片

图片

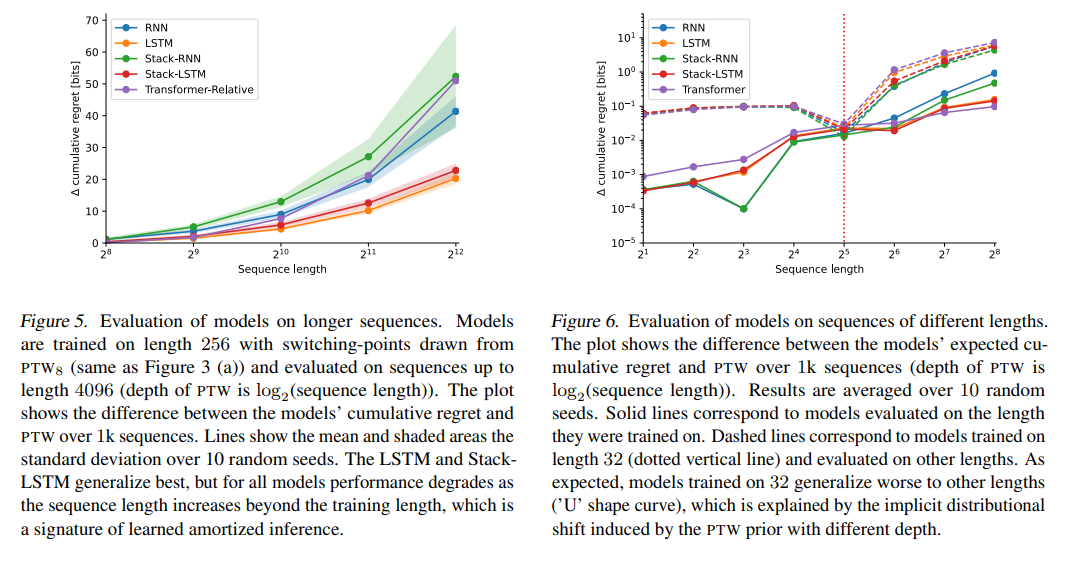

另一篇论文是研究在统计数据自发变化的数据源(例如自然语言预测中)上进行元训练的神经网络。

论文回答了当前的序列预测模型和训练机制可以在多大程度上解释大型语言模型中出现的上下文学习类型。

图片

图片

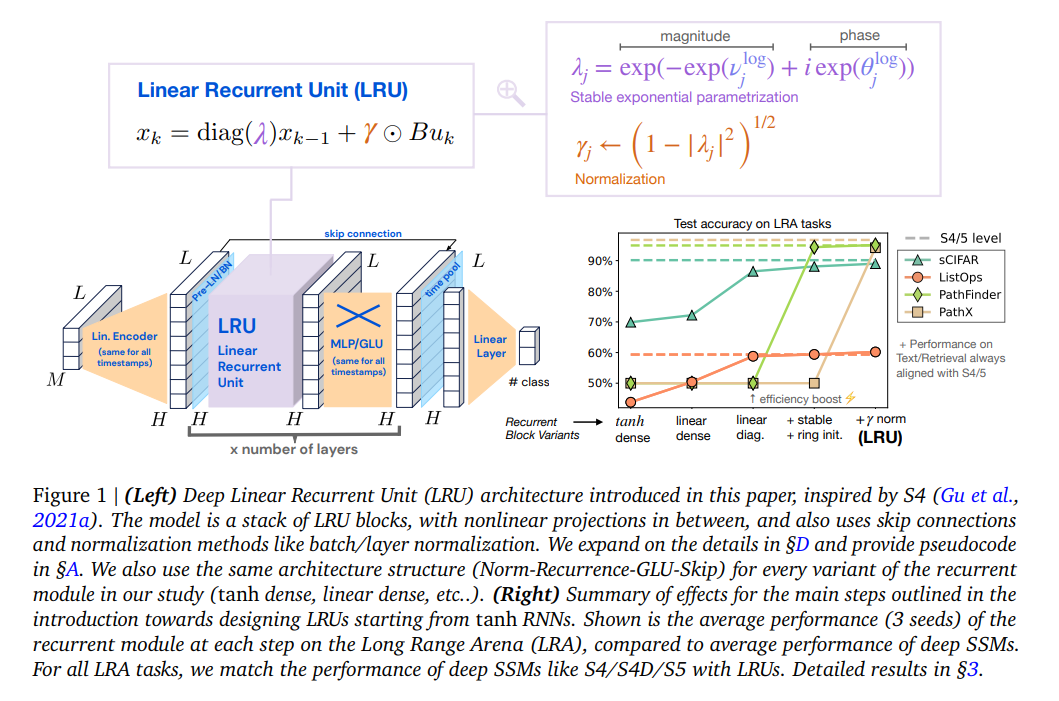

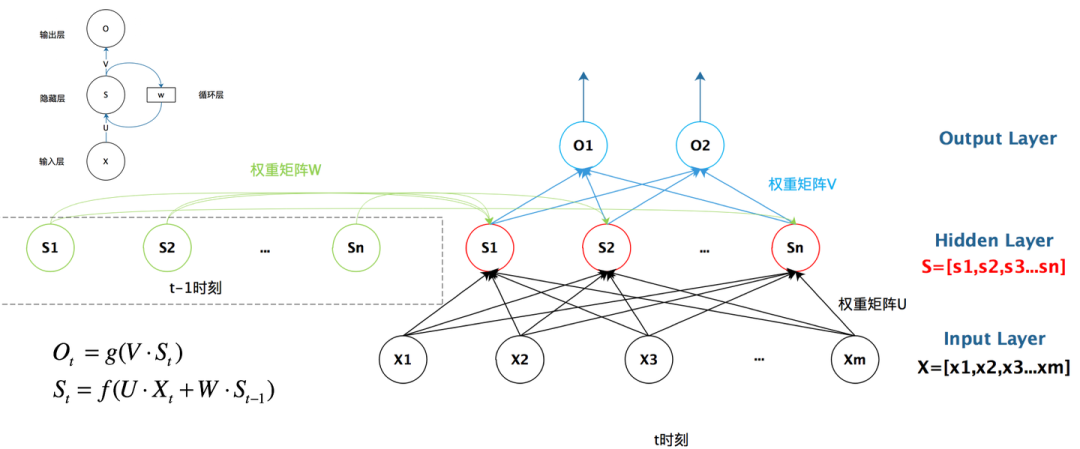

此外,谷歌DeepMind的研究人员提出了一个新的循环神经网络 (RNN) 系列,它们在长期推理任务上表现更好。

图片

图片

研究人员对标准RNN进行了改进,包括线性化和对角化递归,使用更好的参数化和初始化,并确保前向传递的正确标准化。

循环神经网络

循环神经网络

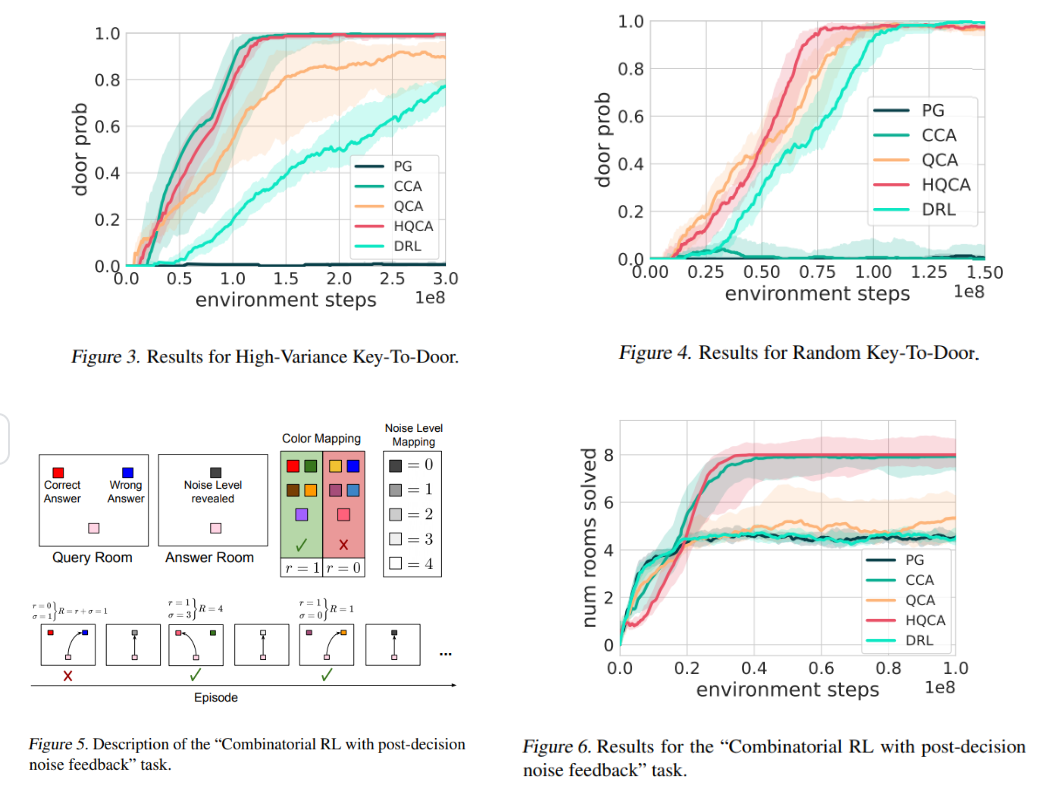

最后,在人工智能的强化学习研究中的「分位数信用分配」(quantile credit assignment),谷歌研究人员提出了一种将训练中的运气与技能分开的方法。

通过在行动、结果和外部因素之间建立更清晰的关系,人工智能可以更好地理解复杂的现实环境。

图片

图片

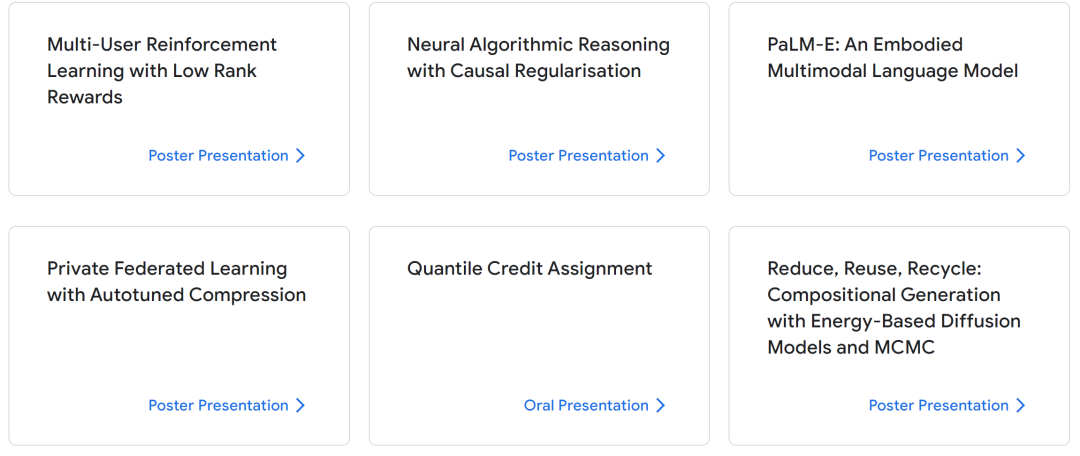

除了以上重点介绍的研究,还有很多其他的研究.....

图片

图片

图片

图片

图片

图片

80多篇论文实在太多辣!小编截不过来了.....感兴趣的就自己去看吧!

附上网址:https://deepmind.events/events/icml-2023/resources#

一路下来,这些研究真是让人眼花缭乱,让人知(tou)识(yun)大(nao)涨(zhang)!