Part 01

概述

系统的语音框架无法被外部开发者使用,但是苹果基于机器学习能力为开发者开放了具备类似能力行为的Speech框架,你可以在自己开发的APP应用程序中通过调用开放的接口能力,就可以实现类型键盘听写功能。例如,你可以使用语音识别来识别语音命令或在应用程序的其他部分中处理文本听写。你可以在许多语言中执行语音识别,但每个SFSpeech对象在一种语言上运行,并且Speech框架还依赖于苹果的服务器进行语音识别,要求设备始终连接网络。

Part 02

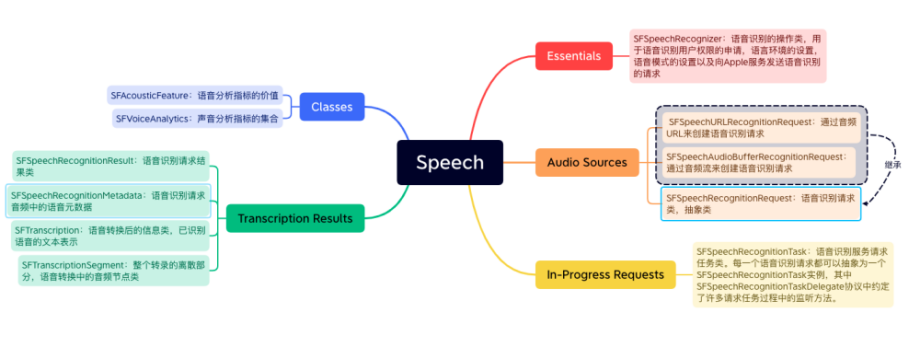

Speech框架:类结构

Part 03

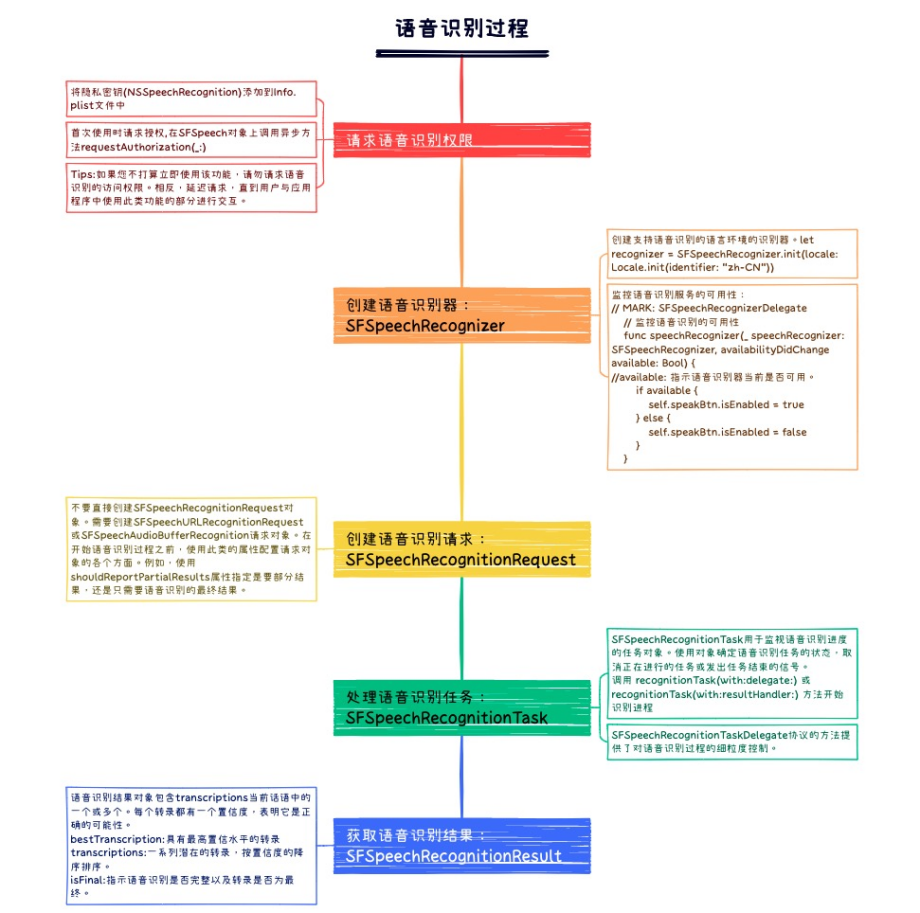

Speech框架:语音识别过程

Speech框架为快速识别语音提供了统一的接口能力,使用方便,但也存在一些需要注意的地方,具体如下:

处理由语音识别限制引起的故障:语音识别是基于网络的服务,单个设备可能在每天可以执行的识别数量方面受到限制,并且每个应用程序可能会根据其每天发出的请求数量进行全局限制。

音频持续时间1分钟的限制:语音识别对电池寿命和网络使用造成相对较高的负担。为了最大限度地减轻这种负担,该框架会停止持续时间超过1分钟的语音识别任务,此限制类似于与键盘相关的听写限制。

不要对私人或敏感信息进行语音识别:不要发送密码,健康或财务数据以及其他敏感语音进行识别。

Part 04

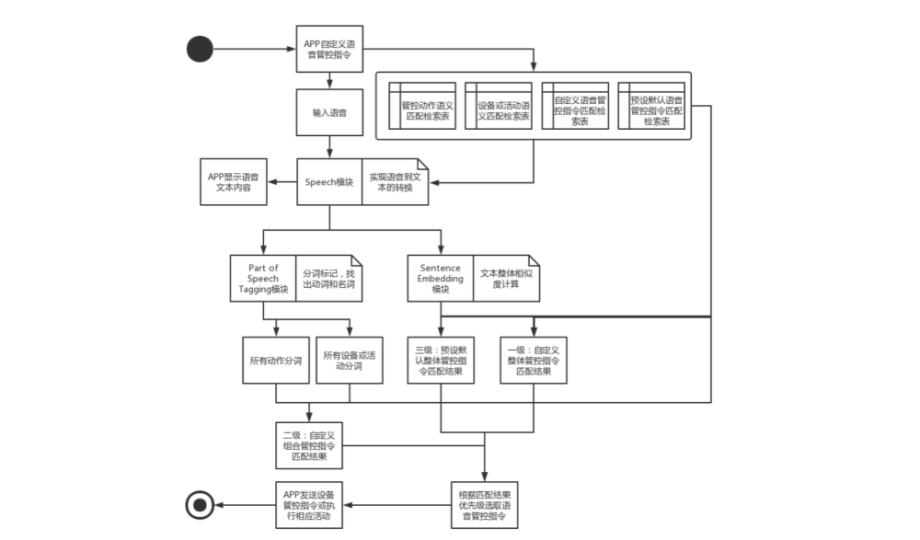

Speech框架:和家亲上的实践应用

Speech框架在和家亲上的主要应用在智能语音客服和智能管控上,通过Speech框架,快速实现语音输入到内容文本的转换显示,极大提高了交互体验效果。和家亲应用Speech框架实现设备语音管控的主要方案逻辑流程如下图所示👇

图片

图片

主要的流程步骤如下:

1️⃣APP本地构建匹配检索数据表,包括管控动作语义匹配检索表、设备或活动语义匹配检索表、自定义语音管控指令匹配检索表、默认语音管控指令匹配检索表。

2️⃣应用Speech框架能力接口,将app采集的语音输入转换成文本内容,并在APP交互页面上显示。

3️⃣将步骤2中转换好的文本内容与本地构建的自定义语音管控指令匹配检索表和默认语音管控指令匹配检索表分别进行文本整体相似度计算排序,分别找到找到一级相似管控指令及其置信度,三级相似指令及其置信度。

4️⃣将步骤2中转换好的文本内容进行分词处理,提取文本中的动词、名词、地名、产品名等。

5️⃣将步骤4中的动词、名词等分别与管控动作语义匹配检索表、设备或活动语义匹配检索表进行相似度计算匹配,找到最优的动作匹配结果和最优的活动或设备匹配结果,将动作和活动或设备组合形成二级管控指令及其置信度。

6️⃣将上述的一、二、三级管控指令按照不同权重和其对应的置信度结果进行优先级排序,并将排序结果返回显示在交互页面,等待用户确认最终指令。

7️⃣执行最终管控指令。