7 月 13 日消息,外媒 Semianalysis 近日对 OpenAI 今年 3 月发布的 GPT-4 大模型进行了揭秘,其中包括 GPT-4 模型架构、训练和推理的基础设施、参数量、训练数据集、token 数、成本、混合专家模型(Mixture of Experts)等具体的参数和信息。

▲ 图源 Semianalysis

外媒表示,GPT-4 在 120 层中总共包含了 1.8 万亿参数,而 GPT-3 只有约 1750 亿个参数。而为了保持合理的成本,OpenAI 采用混合专家模型来进行构建。

IT之家注:混合专家模型(Mixture of Experts)是一种神经网络,该系统根据数据进行分离训练多个模型,在各模型输出后,系统将这些模型整合输出为一个单独的任务。

▲ 图源 Semianalysis

据悉,GPT-4 使用了 16 个混合专家模型 (mixture of experts),每个有 1110 亿个参数,每次前向传递路由经过两个专家模型。

此外,它有 550 亿个共享注意力参数,使用了包含 13 万亿 tokens 的数据集训练,tokens 不是唯一的,根据迭代次数计算为更多的 tokens。

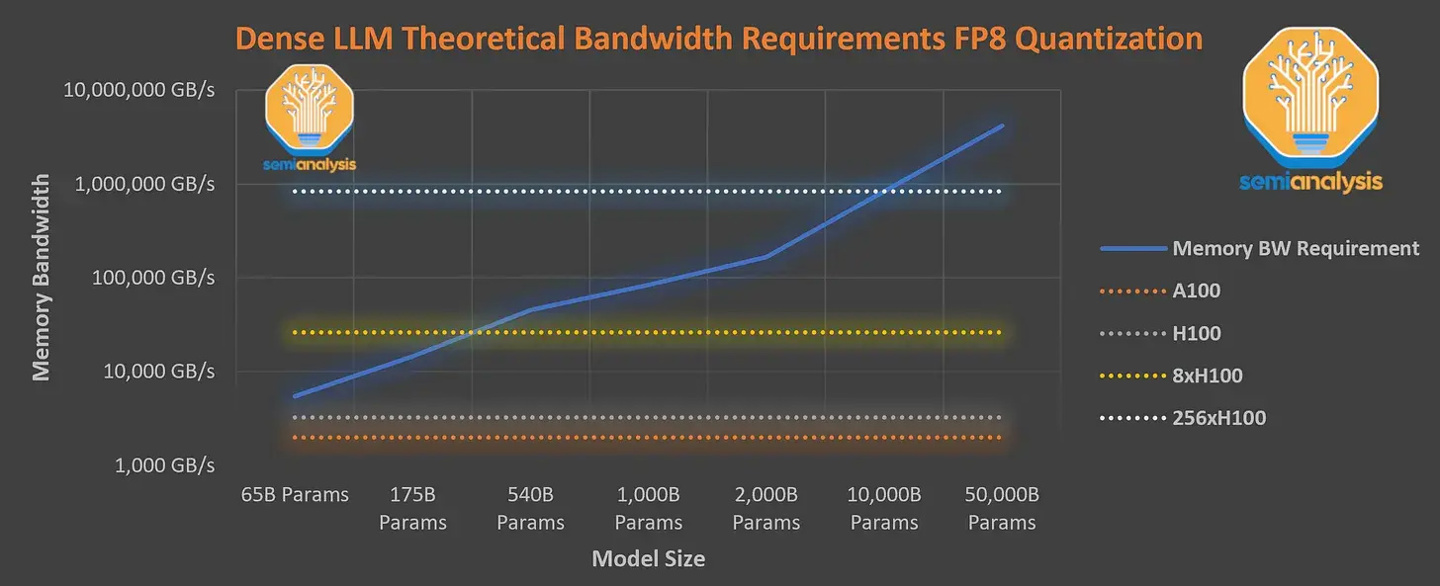

GPT-4 预训练阶段的上下文长度为 8k,32k 版本是对 8k 微调的结果,训练成本相当高,外媒表示,8x H100 也无法以每秒 33.33 个 Token 的速度提供所需的密集参数模型,因此训练该模型需要导致极高的推理成本,以 H100 物理机每小时 1 美元计算,那么一次的训练成本就高达 6300 万美元(约 4.51 亿元人民币)。

对此,OpenAI 选择使用云端的 A100 GPU 训练模型,将最终训练成本降至 2150 万美元(约 1.54 亿元人民币)左右,用稍微更长的时间,降低了训练成本。