复杂环境下透明物体的感知和抓取是机器人领域和计算机视觉领域公认的难题。近日,来自清华大学深圳国际研究生院的团队与合作者提出了一种视 - 触融合的透明物体抓取框架,该框架基于 RGB 相机和带有触觉感知能力的机械爪 TaTa, 并通过 sim2real 的方式来实现透明物体的抓取位置检测。该框架不仅可以解决玻璃碎片等不规则透明物体的抓取,还可以实现重叠、堆叠、高低不平、沙堆甚至高动态水下透明物体抓取问题。

图片

图片

透明物体由于其美观、简约等特点而在生活中广泛应用。比如厨房、商店、工厂都能见到他们的身影。虽然透明物体很常见,但对于机器人而言,透明物体的抓取却是一个非常困难的问题。其主要原因有三个:

图片

图片

1、没有自己的纹理属性。透明物体表面的信息随着所在环境的变化而变化,所产生的纹理大都是由于光线折射、反射造成的,这就给透明物体的检测带来了很大的困难。

2、透明数据集的标注相比于普通物体标注具有更大的难度。在实际场景中,人类有时也不容易区分玻璃等透明物体,更不用说对透明物体的图像进行标注。

3、透明物体表面光滑,即使抓取位置存在较小偏差也可能导致抓取任务的失败。

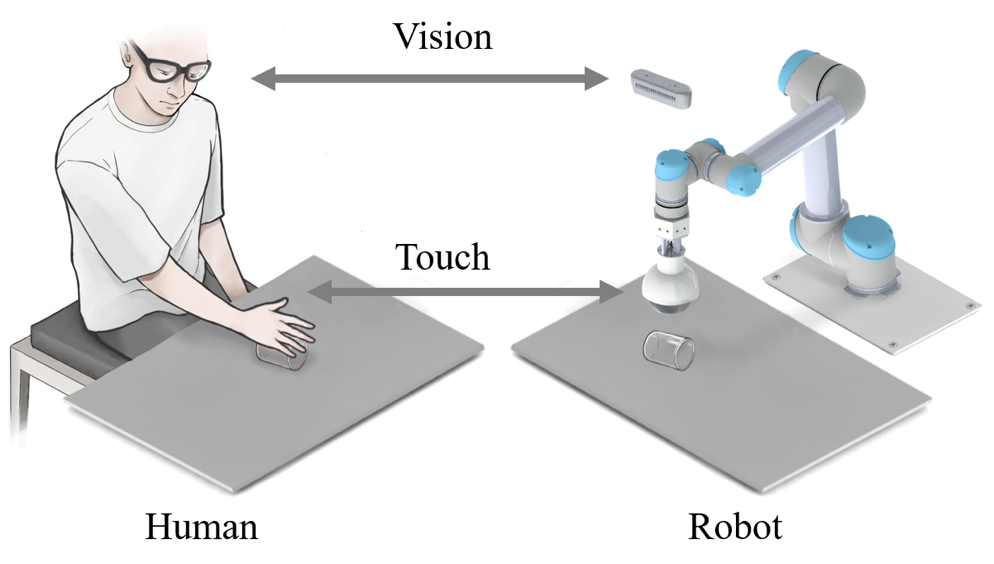

因此,如何利用尽可能少的成本来解决各种复杂场景下的透明物体抓取问题已经成为了透明物体研究领域非常重要的问题。近日,来自清华大学深圳国际研究生院的智能感知与机器人团队提出了一个基于视触融合的透明物体抓取框架,该框架模仿了人在低可见度情况下抓取物体的动作,并利用视触融合来实现透明物体的检测和抓取。该方法不仅具有极高的抓取成功率,还可以适应各种复杂场景下的透明物体抓取。

图片

图片

论文地址:https://ieeexplore.ieee.org/document/10175024

论文通讯作者、清华大学深圳国际研究生院丁文伯副教授表示:「机器人在家庭服务领域展现出了巨大的应用价值,但当前的机器人大多聚焦于某一单一领域,通用型机器人抓取模型的提出将会对机器人技术的推广和应用带来巨大的推动作用。虽然我们是以透明物体为研究对象,但该框架可以很轻松的推广到生活中常见物体的抓取任务中。」

论文通讯作者、清华大学深圳国际研究生院刘厚德研究员表示:「家庭场景中的非结构化环境对机器人的实际应用带来了极大的挑战,我们将视觉与触觉进行融合感知,进一步模拟了人类与外界交互时的感知过程,为复杂场景下机器人应用的稳定性提供了多方面的保障。除了将视觉与触觉的融合,我们提出的框架也可同样推广到听觉等更多的模态。」

研究现状

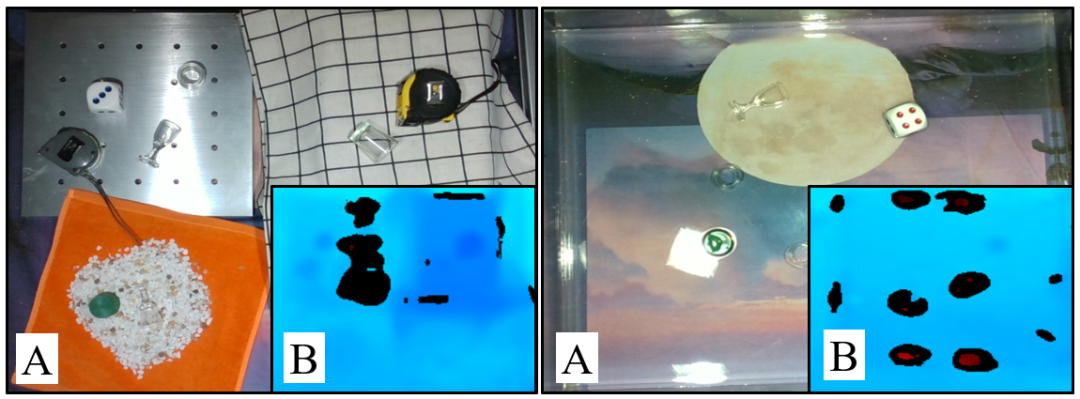

透明物体的抓取是一项具有挑战性的任务,在抓取过程中除了需要检测物体的位置外,还应考虑抓取位置和角度。目前对于透明物体的抓取,大部分的工作是在具有简单背景的平面上进行的,但在实际生活中,大部分的场景都不会像我们的实验环境那么理想。一些特殊场景,比如玻璃碎片、堆积、重叠、起伏、沙子和水下场景,都是比较有挑战性的。

- 首先,玻璃碎片是一种没有固定模型的物体,由于其随机多变的形状对抓取网络和抓取工具的通用性提出了很高的要求。

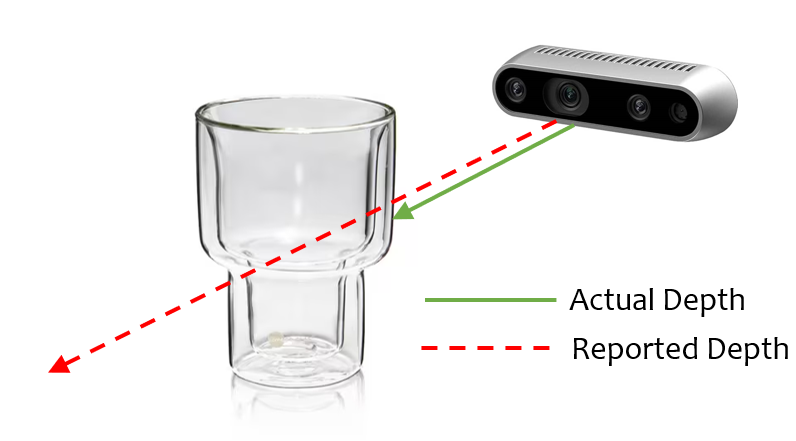

- 其次,起伏的平面的透明物体抓取也具有一定的挑战性。如下图所示,一方面,透明物体的深度信息很难准确获取,另一方面,起伏的场景有一些阴影、重叠和反射区,这给透明物体的检测带来了更多的挑战。

- 第三,由于水和透明物体的光学特性相似,水下场景中的透明物体抓取也是一个挑战。即使使用深度相机,透明物体在水中也无法准确的检测,在不同方向的光线的照射下情况会变得更糟。

图片

图片

算法设计

图片

图片

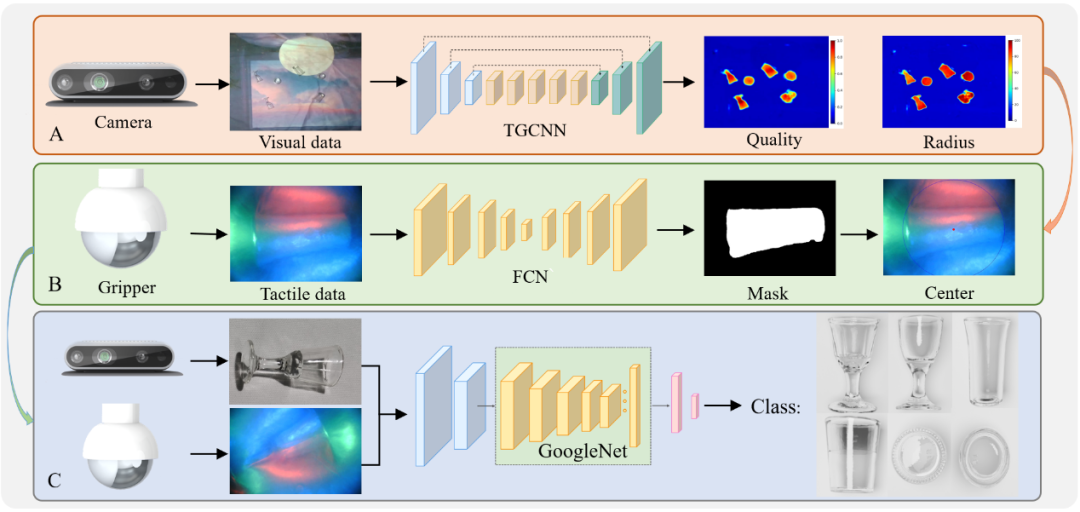

抓取算法设计如图所示,为了实现透明物体的抓取,我们分别提出了透明物体抓取位置检测算法、触觉信息提取算法和视 - 触融合分类算法。为了降低数据集的标注成本,我们采用 Blender 制作了一个多背景透明物体抓取合成数据集 SimTrans12K,其中包含 12000 幅合成图像和 160 幅真实图像。除了数据集,我们还针对透明物体的独特的光学属性提出了一种 Gaussian-Mask 标注方法。由于我们采用 Jamming gripper 作为执行器,我们为其提出了一个专门的抓取网络 TGCNN,该网络在合成数据集训练之后就可以得到不错的检测效果。

抓取框架

我们将上述算法进行了整合,以完成不同场景下的透明物体抓取,这构成了我们视触融合框架的上层抓取策略。我们将一个抓取任务分解为三个子任务,即物体分类、抓取位置检测和抓取高度检测。每个子任务都可以由视觉、触觉或视触融合来完成。

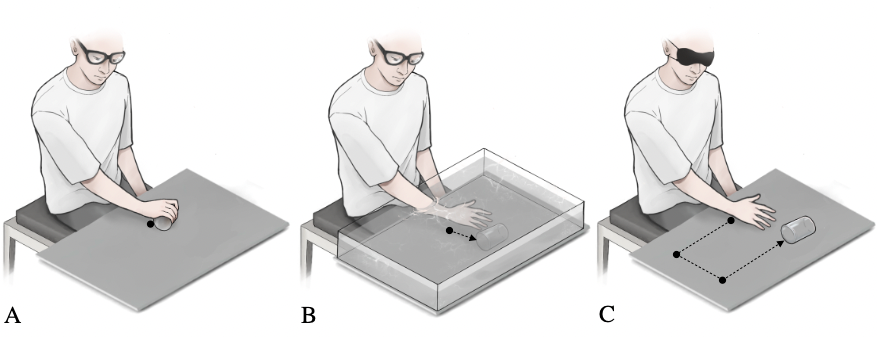

与人类抓取时的行为类似,当视觉可以直接获得物体的精确位置时,我们可以控制手直接到达物体并完成抓取,如下图(A)所示。当视觉不能准确获得物体的位置信息时,在利用视觉估计物体的位置之后,我们会用手部的触觉感知功能慢慢调整抓取位置,直到接触到物体并达到合适的抓取位置,如下图 (B) 所示。对于视觉受限情况下的物体抓取,如下图 (C) 所示,我们将利用手部丰富的触觉神经在目标可能存在的范围内进行搜索,直到与物体发生接触,这虽然效率很低,但却是解决这些特殊场景下物体抓取的有效方法。

图片

图片

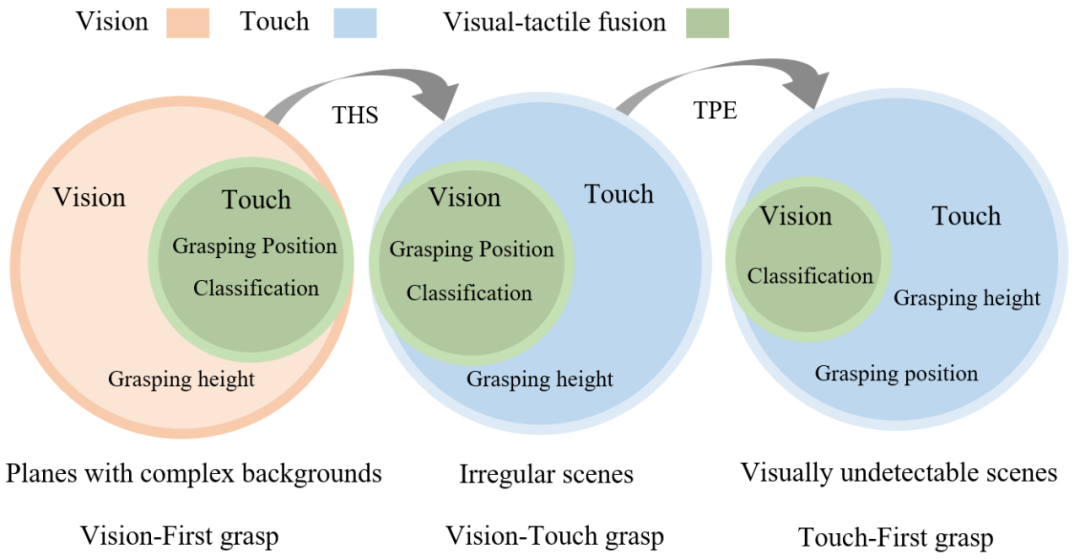

受人类抓取策略的启发,我们将透明物体的抓取任务分为三种类型:具有复杂背景的平面、不规则场景和视觉无法检测的场景,如下图所示。在第一种类型中,视觉发挥着关键性的作用,我们将这种场景下的抓取方式定义为视觉优先的抓取方法。在第二种类型中,视觉和触觉可以协同工作,我们将这种场景下的抓取方式定义为视觉 - 触觉抓取。而在最后一种类型中,视觉可能失效,触觉在任务中成为主导,我们将这种场景下的抓取方式定义触觉优先的抓取方法。

图片

图片

视觉优先的抓取方法流程如下图所示,首先利用 TGCNN 获取抓取位置和高度,之后利用触觉信息抓取位置校准,最后利用视 - 触融合算法进行分类。视 - 触觉抓取则是在之前的基础上加入了 THS module,该模块可以利用触觉来获取物体的高度。触觉优先的抓取方法又加入了 TPE modul,该模块可以利用触觉来获取透明物体的位置。

实验验证

为了验证我们提出框架及算法的有效性,我们进行了大量的验证实验。

首先,为了测试我们提出的透明物体数据集、注释方法和抓取位置检测网络的有效性,我们进行了合成数据检测实验和不同背景和亮度下的透明物体抓取位置检测实验。其次,为了验证视觉 - 触觉融合抓取框架的有效性,我们设计了透明物体分类抓取实验和透明碎片抓取实验。第三,我们设计了在不规则和视觉受限的场景中的透明物体抓取实验,以测试加入 THS 模块和 TPE 模块后框架的有效性。

总结

为了解决检测、抓取和分类透明物体的挑战性问题,该研究提出了一个基于合成数据集的视觉 - 触觉融合框架。首先,使用 Blender 模拟引擎来渲染合成数据集,而不是手动注释的数据集。

此外,使用 Gaussian-Mask 代替了传统的二进制标注法,使抓取位置的生成更加准确。为了实现对透明物体的抓取位置检测,作者提出了一种名为 TGCNN 的算法,并进行了多次对比实验,结果表明,即使只用合成数据集进行训练,该算法也能在不同的背景和照明条件下实现良好的检测。

考虑到视觉检测的局限性造成的抓取困难,该研究提出了一种与软抓手 TaTa 相结合的触觉校准方法,通过用触觉信息调整抓取位置来提高抓取成功率。与纯视觉抓取相比,该方法提高了 36.7%的抓取成功率。

为了解决复杂场景中透明物体的分类问题,该研究提出了一种基于视觉 - 触觉融合的透明物体分类方法,该方法与仅基于视觉的分类相比,准确率提高了 39.1%。

此外,为了实现在不规则和视觉无法检测的场景中的透明物体抓取,该研究提出了 THS 和 TPE 模块,它们可以弥补在没有视觉信息的情况下的透明物体抓取问题。研究者系统地设计了大量的实验,验证了所提出的框架在各种叠加、重叠、起伏、沙地、水下场景等复杂场景中的有效性。该研究认为,所提出的框架还可以应用于低能见度环境下的物体检测,如烟雾和浑浊的水下,触觉感知可以弥补视觉检测的不足,并通过视觉 - 触觉融合提高分类精度。

作者简介

视触融合透明物体抓取项目的指导老师是丁文伯,他目前在清华大学深圳国际研究生院担任副教授,领导智能感知与机器人研究小组。他的研究兴趣主要包括信号处理、机器学习、可穿戴设备、柔性人机交互与机器感知。此前他本科和博士毕业于清华大学的电子工程系,并在佐治亚理工学院担任博士后,师从王中林院士。他曾获清华大学特等奖金、第 47 届日内瓦国际发明展金奖、IEEE Scott Helt 纪念奖、中国电子学会自然科学二等奖等众多奖项,已在 Nature Communications、Science Advances、Energy and Environmental Science、Advanced Energy Materials、IEEE TRO/RAL 等领域权威期刊发表论文 70 余篇,谷歌学术引用 6000 余次,授权中国和美国专利 10 余项。担任国际信号处理权威期刊 Digital Signal Processing 的副编辑、IEEE JSTSP 机器人感知专刊的首席客座编辑,以及 IEEE 信号处理协会 Applied Signal Processing Systems Technical Committee Member。

课题组主页:http://ssr-group.net/。

从左到右: Shoujie Li,Haixin Yu,Houde Liu

论文的共同一作分别是 Shoujie Li (清华大学博士生在读),Haixin Yu (清华大学硕士生在读),通讯作者为 Wenbo Ding、Houde Liu,其他作者还包括 Linqi Ye (上海大学)、 Chongkun Xia (清华大学)、Xueqian Wang (清华大学)、 Xiao-Ping Zhang (清华大学)。其中,Shoujie Li 主要研究方向为机器人抓取、触觉感知以及深度学习,以第一作者在 Soft Robotics、TRO、RAL、ICRA、IROS 等机器人和控制权威期刊和会议发表论文多篇,授权发明专利 10 余项,获省部级竞赛奖励 10 项,相关研究成果以第一作者入选 “ICRA 2022 Outstanding Mechanisms and Design Paper Finalists”,曾获清华大学未来学者奖学金、国家奖学金等荣誉。