一夜之间,AI智能体突然霸屏全网。

业界大佬纷纷将关注重点从LLM转向了AI智能体,OpenAI的首席科学家Karpathy认为AI智能体是未来。

就连英伟达老黄表示,下一波人工智能浪潮是具身人工智能,简之「AI智能体」。

这不,近来斯坦福的最新研究,直接让AI智能体和一只小鼠来一场面对面的竞争,以确定谁能获胜。

最新研究结果已发表在arXiv上,并被ICML 2023接收。

论文地址:https://arxiv.org/pdf/2306.15934.pdf

智能体大战小鼠

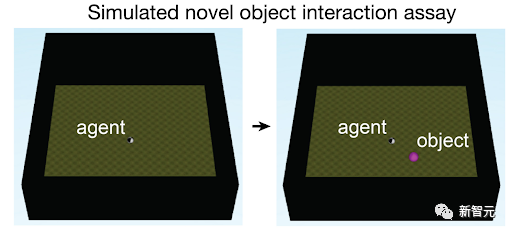

斯坦福研究人员Isaac Kauvar设计了一个简单任务,「探索和适应周围环境」。

Kauvar将一只小鼠放在狭小的空盒子里,类似地,将AI智能体放在一个3D虚拟竞技场中。

图片

图片

然后,他在两个环境中都放了一个红色的球。接下来,测试谁会更快地探索这个新物体。

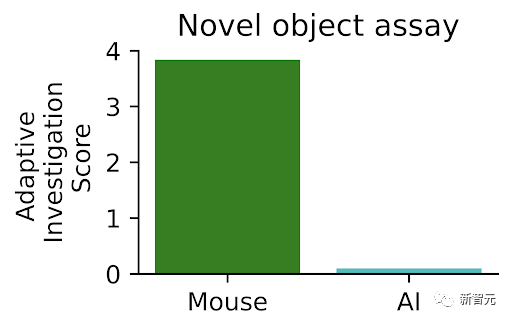

结果显示,小鼠迅速靠近球,并在接下来的几分钟里不断与之互动。但是AI智能体似乎没有注意到它。

第一回合,小鼠胜,智能体失败。

Kauvar表示,这完全出乎意料的,我们意识到,即使使用最先进的算法,性能仍然存在差距。

因此,学者们思考着:他们是否可以利用这些看似简单的动物行为作为启示,改进AI系统呢?

沿着这个思路的启发,研究人员设计一种名为「好奇回放」(curious replay)的全新训练方法。

该方法使AI智能体能够「自我反思」最近遇到的最新奇,以及最有趣的事物。

添加了「好奇回放」之后,AI智能体就能够更快地接近,并与红球进行互动。此外,它还极大地改善了基于Minecraft的游戏「Crafter」的性能。

图片

图片

通过好奇心学习

要知道,真正的超级AI智能体,是能够像人类一样进行感知、交互、理解的AI。

而好奇心,对于人类认知世界,探索周遭环境至关重要,不论是避免危险情况,还是寻找生存必需品都必不可少。

在实验中,红球可能是致命的毒药,亦或是一顿滋养的餐食,如果我们忽视它,将很难找出真相。

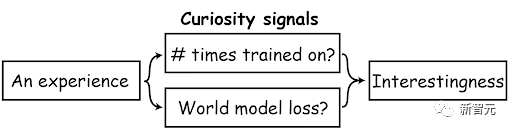

这就是为什么斯坦福研究人员,在驱动AI智能体的行为中增加了「好奇信号」,特别是基于模型的深度强化学习智能体。

这个信号告诉它们,去选择能够导致更有趣结果的行动,比如,看到门要打开门,而不是忽略它。

图片

图片

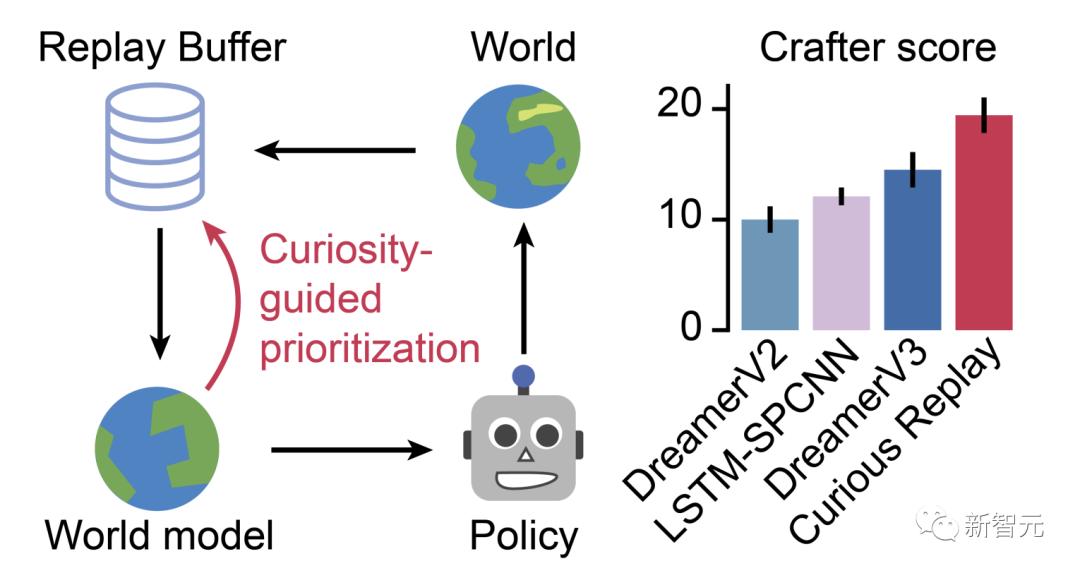

好奇回放通过使用好奇心引导的优先级来促进模型在最不熟悉的经验的训练,从而关闭了经验回放和世界模型性能之间的循环

这一次,团队以一种全新方式,利用好奇心来帮助AI智能体了解其世界,而不仅仅是做出决策。

Kauvar说:「我们不是选择要做什么,而是选择要思考什么,或多或少地选择我们想要从过去的经历中学到什么」。

换句话说,他们希望鼓励AI智能体进行「自我反思」。从某种意义上说,关于它最有趣或最奇特的(与好奇心相关的)经历。

这样,智能体就可以被促使以不同的方式与物体互动以获得更多的学习,这将指导它对环境的理解,并可能激发对其他物品的好奇心。

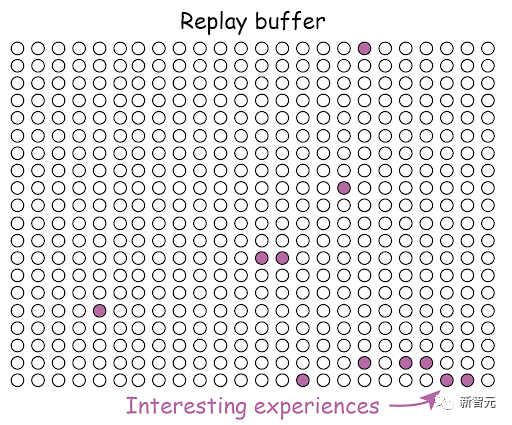

为了以这种方式实现自我反思,研究人员修改了一种常用的用于训练AI智能体的方法,称为「经验回放」。

在这种方法中,智能体存储其所有互动的记忆,然后随机重放其中的一些以再次学习。

「经验回放」受到了有关睡眠的研究的启发:神经科学家发现,一个被称为海马体的大脑区域会「重播」一天的事件(通过重新激活特定的神经元)以加强记忆。

在AI智能体中,「经验回放」在环境变化不大,且正确行为获得明确奖励的场景中,能够取得高性能。

但是,研究人员推断,在一个不断变化的环境中,AI智能体更有意义的是优先回放那些最有趣的经历,比如红球的出现,而不是一遍又一遍地回放空荡的虚拟房间。

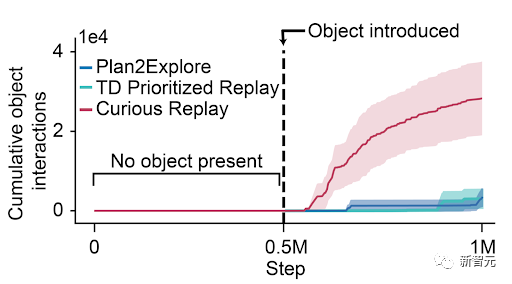

他们将这种新方法称为好奇回放,并发现它立即生效。Kauvar说:「突然之间,智能体与球的互动速度明显增加。」

图片

图片

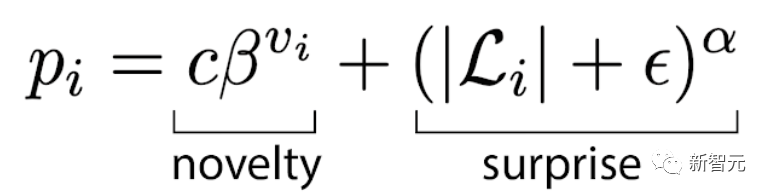

对于算法的设计,优先级信号是新奇和惊喜的叠加组合:

图片

图片

好奇回放是对现有智能体的简单修改。这些智能体使用经验重播,计算开销最小,利用了经验采样次数的计数,以及为每个训练批次计算的模型损失。

这种优先级在需要适应的不断变化的环境中特别有用。好奇回放有助于随着环境的变化,保持世界模型的最新状态,这是有效行动选择的先决条件。

另外,研究人员发现,一个领先的好奇心强的人工智能智能体Plan2Explore,在需要适应的情况下,行为明显变差(例如与对象互动的时间变慢)。

图片

图片

究其原因,部分是世界模型的训练,使用「经验回放」缓冲区的统一抽样:因此旧的、无聊的经验和较罕见的新的、有趣的经验一样有可能被训练到。

图片

图片

如果转而优先考虑对「有趣的经历」进行抽样调查结果如何?AI智能体使用好奇心信号(如新奇感和惊喜)来衡量过去经历的趣味性。

图片

图片

结果发现,这个简单的变化极大地改善了适应性,世界模型的性能得到了改善,与物体的互动也大大增加。

它也比现有的优先考虑「经验回放」的方法(如使用奖励相关的信号,如TD错误)表现得更好。

图片

图片

但他们并未止步于此。

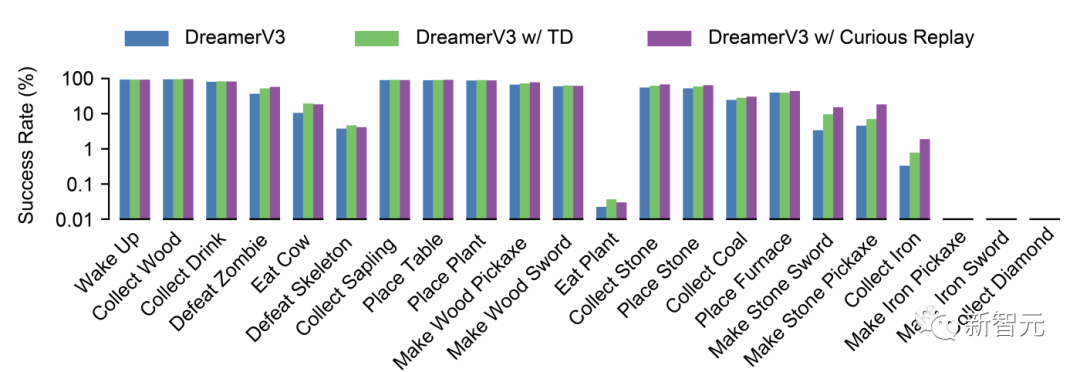

研究人员还将好奇回放添加到了玩一个名为Crafter的游戏的AI智能体中,这是一种用于测试AI智能体创造性问题解决能力的标准测试,类似于Minecraft。

智能体需要通过学习如何收集木材和石头、制作镐子以及收集铁矿石来求生和适应。

好奇回放方法将当前的最先进得分从大约14提高到19(人类通常得分约为50)——仅仅通过「这一个改变」,Kauvar说道。

好奇回放在Crafter基准上取得SOTA,超过了DreamerV3,足见其在挑战技能方面能力的大幅提升。

图片

图片

一个好奇的未来

好奇回放方法在简单和复杂任务中的成功表明,它对于未来广泛的人工智能研究将非常重要。

论文作者Haber说道,「这项工作的总体目标是使智能体能够利用先前的经验,在探索新的或变化的环境中高效适应,这将导致更加适应性强、灵活性更高的技术,从家庭机器人到个性化学习工具」。

Kauvar的博士后工作由Haber和神经科学家Karl Deisseroth(生物工程和精神病学系D.H. Chen教授)共同指导,他对从动物行为中汲取灵感以改进人工智能系统的主题感到兴奋——他计划继续在更复杂的任务上测试小鼠和AI智能体,以比较它们的行为和能力。

「很多人只是嘴上说说受到动物的启发,但我们正在建立一个直接的桥梁——而不是模糊的桥梁。我们试图做完全相同的事情」。

Kauvar希望这样的工作能够帮助「闭环」AI研究和神经科学之间的联系,并有助于我们对动物行为和底层神经过程的理解。

他表示,「你可以想象,这整个方法可能会产生以前从未想到的假设和新实验」。

作者介绍

Isaac Kauvar

Isaac Kauvar是斯坦福大学的LSRF博士后研究员,与Nick Haber一起在斯坦福自主智能体实验室工作,研究人工智能、神经科学和心理学的交叉领域。

他对大脑多个区域的细胞网络如何协同工作来模拟世界感兴趣。

Kauvar曾在斯坦福获得了电气工程博士学位。在那里,我开发了记录整个皮层神经活动的光学工具,并发现了一种神经振荡——奇怪地局限于一个皮层区域——这似乎是氯胺酮等药物解离作用的基础。

参考资料:

https://hai.stanford.edu/news/ai-agents-self-reflect-perform-better-changing-environments