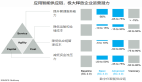

事实上,生成式AI可能很快就会在整个企业的销售、营销、采购和供应链中大力支持人类决策。想想看,IBM方面已经宣布,将暂停招聘其首席执行官认为AI可以填补的7800个当前和未来的职位。然而,尽管生成式AI存在巨大的潜力领域,但其在隐私、算法偏见甚至业务连续性方面也存在同样重大的风险。

我一直在与其他领导人讨论这些问题,特别是因为它们涉及管理供应商合规使用AI的安全和道德政策。根据这些对话,以下是领导团队考虑的一些风险领域,以及针对采购团队的一些常识性指导方针,以确保AI在道德、准确和安全的情况下运行。

风险

虽然与AI相关的风险数量可能还不完全清楚,但以下是一些已经浮出水面并亟需解决的问题:

1. 欺诈和AI鱼叉式网络钓鱼

安全研究人员认为,ChatGPT正在引发一场骗局的“浪潮”。任何针对供应商(即使是很小的供应商)的骗局都可以用来损害其客户的采购团队。这一点可以参见2021年涉及SolarWinds和其他公司的攻击,以了解受损的供应商如何影响下游的其他公司。

另一方面,供应商可能会担心AI在采购过程中选择获胜供应商的准确性或公平性——客户或黑客可能会操纵AI系统,使其偏袒某些供应商,而非其他供应商,这意味着可能会失去一份利润丰厚的合同。

2. 盗窃知识产权

除非使用得当,否则输入ChatGPT或其他生成式AI工具的数据可能会传播给使用该服务的其他用户或公司,从而暴露敏感的IP和“商业机密”。这可能会导致严重的法律后果——特别是考虑到欧盟的《通用数据保护条例》(GDPR)等法律——并可能损害公司的声誉。作为回应,三星等一些公司已经禁止或暂停员工使用生成式AI技术,同时调查潜在风险。

3. 算法偏见

许多新的AI系统为供应商提供算法推荐。不幸的是,AI是根据历史数据和过去的决策进行训练的,其中可能包括对边缘化供应商的(无意识的)偏见。如果数据中存在的偏见没有得到妥善解决,AI可能会延续甚至加剧这些偏见,导致不公平的结果和潜在的法律责任。

目前,这些偏见正在影响使用AI进行招聘决策的公正性。为此,纽约刚刚通过了一项法律,要求公司对其自动招聘工具中的算法偏见承担法律责任。

4. 供应中断

在与供应链领导者的对话中,一些人担心AI可能会检测到或先发制人地对某种特定商品进行挤兑/抢购,并在抢购之前触发一个自动购买周期,从而引发挤兑。很容易想象,随着AI与监控市场并为重复交易执行购买周期的自主系统更加融合,试图在价格飙升之前“战胜市场”触发供应短缺的风险可能会无意中造成供应中断。

对于食品、燃料和药品等类别,采购和供应管理团队可能会感到痛苦,更不用说我们所服务的客户和社区了。AI管理的库存决策也可能导致意想不到的库存水平——导致库存减少、缺货、物流成本增加、收入损失和客户信心下降。

常识性指南

考虑到这些威胁,以及AI的发展速度,立即围绕这项技术的使用制定一项常识性政策是有意义的。

在工作场所之外建立负责任的使用方式

不要假设所有员工都是“AI禁欲者”。提供关于提示(prompt)中应该和不应该包含哪些信息的指导,对于围绕负责任的使用展开全面讨论至关重要。用户应该接受培训,以有效地使用AI工具并解释其输出,并保持对AI局限性和潜在风险的认知。

与供应商间设立界限

无论您的团队成员和供应商是否知道,事实是,放入ChatGPT的任何信息都可能被竞争对手和其他第三方访问。IT团队已经在竞相建立规则,但他们往往只关注内部。

作为采购和供应链团队,我们的工作是将这些期望传达给我们的供应商合作伙伴。至少,提醒供应商始终实施数据匿名化和加密技术,以保护敏感信息。

组建专业团队

对许多人来说,创造有效的“提示”是一项关键的新技能,所以可以考虑培训团队如何创造提示,甚至聘请“提示工程师”(prompt engineer)来优化结果。

您可能还要考虑执行程序来检测和减轻AI数据和输出中的偏见。这可能涉及偏见审计、公平指标和多样化的训练数据集。

讨论自触发(self-triggering)供应中断

哪些商品类别可能容易受到“恐慌性购买”的影响?其他市场参与者是如何应对这一挑战的?

这些都是战略关注的主题,无论AI是被您的公司还是被市场上的其他买家/卖家使用,这些问题都将至关重要。作为一种预防措施,建议现在就开始与您的团队进行这些类型的对话。

防护机制的未来演变

随着技术的进步和业务实践的改变,围绕AI的风险和法律限制将继续演变。考虑一下未来可能需要对AI功能进行哪些增强,以实现更高级的功能,如预测分析、更多语言的自然语言处理、偏见审计和高级欺诈检测。

现在有很多关于AI的炒作,对许多采购和供应链领域的人来说,这并不是什么新鲜事。然而,这些模型只会变得越来越好,而且改进的速度从未如此之快。如果我们在这项技术加速之前没有进行内部讨论,形成明确的界限和具体的意图,我们可能会被AI本身产生的想法和建议所困。