MBZUAI,上海交通大学,微软亚洲研究院合作完成了一个全面的中文大模型基准——CMMLU。

它涵盖了 67 个主题,涉及自然科学、社会科学、工程、人文、以及常识等,可以全面地评估大模型在中文知识储备和语言理解上的能力。他们测试了近 20 个先进的大模型包括最新的 GPT4,ChatGLM2 和 Baichuan-7B 等,发现大多数现有模型的难以达到 50%准确率,而随机准确率为 25%。

图片

图片

- 论文地址:https://arxiv.org/abs/2306.09212

- 数据和评估代码:https://github.com/haonan-li/CMMLU

本文所提出的 CMMLU,这是一个全新全面的中文评估数据集,旨在专门评估 LLM 在中文语言和文化背景下的高级知识和推理能力。

CMMLU 涵盖了 67 个主题(如图 1 所示),从小学到大学或专业水平。包括自然科学,以及人文和社会科学领域的学科,更包含了许多具有中国特色的内容,比如 「中国饮食文化」,「名族学」,「中国驾驶规则」等等。研究团队已完全公开了数据,社区可以自由方便地利用和评估他们的模型在是否适用于以中国为核心的中文人群。完整的学科列表、每个学科测试的概念数量以及问题和答案长度的统计信息均在论文中提供。

图片

图片

为了更深入地了解 LLM 处理中文知识的能力,研究进行了全面的分析实验。研究首先研究模型在各个学科上的表现。所有模型在不同学科上的表现存在不平衡,人文社科学科得分相对较高,而中国特定主题和自然科学得分较低。为了进一步研究这个问题,研究探索了思路链提示词(Chain-of-Thought)和少样本示例(Few-shot)对于帮助模型理解任务和提高推理能力的有效性。此外,团队研究了模型大小对性能的影响,分析了问题长度与难度之间的关系,并探索了现有语言模型尚未有效解决的两种特定问题类型。

CMMLU 测试基准

数据收集

CMMLU 数据集包含 11,528 个问题,涵盖了 67 个学科。每个学科至少有 105 个问题,研究将其分 为包含 5 个问题的训练样本集(few-shot development set),以及包含超过 100 个问题的测试集(test set)。

数据格式

数据集中的每个问题都是一个包含 4 个选项的单选题,图 2 是一个附加了提示的示例。对于数学公式、化学式和一些其他数学表达式,他们使用约一半的 Latex 和一半的纯文本的混合方式,其中只有在一个表达式被广泛使用且不易产生歧义时,才允许使用纯文本(由注释者判断)。例如,水的化学式可以写为纯文本 「H2O」,或者使用 Latex 格式「 $H_{2}O$」。

实验

为了在中文语境下提供现有开源 LLM 在语言理解方面的概览,研究评估约 20 个不同规模、语言方向和阶段(预训练或微调)的先进 LLM,并且分析了它们在这个以知识为中心的基准测试上的性能,并研究了可能影响 LLM 性能的几个因素。

实验设置

研究的目标是评估 LLM 在预训练和 / 或微调过程中所利用的知识。对于开源模型,研究遵循 MMLU 的方法获取提示后的下一个标记的概率,并在 A’、B’、C’和 D’中选择概率最高的选项作为模型的选择。对于 ChatGPT 等非开源模型,研究生成输出并使用一系列正则表达式提取模型的选择。如果正则表达式没有匹配到任何内容,他们会随机选择 A’、B’、C’、D’中的一个选项作为答案,以进行模型间的公平比较。研究对零样本(不输入示例)和少样本(输入少量示例)的设置都进行了实验。

提示词

研究使用短语 「以下是关于 [主题] 的单项选择题,请直接给出正确答案的选项」引入每个问题。对于零样本评估,研究直接在提示后呈现问题。对于少样本评估,他们在问题之前提供多达 5 个带有答案的示例。提示以短语「答案是:」结尾,如图 2 中的示例所示。如果带有少样本示例的文本长度超过模型的最大长度,他们会动态删除最长的(按子标记计算)示例。(最新榜单请看 github)

图片

图片

主要结果

表格 1 显示了在 five-shot 设置下一些模型的性能。可以看出:GPT4 是整体性能最佳的模型,准确度达到 70.95%;在中文特定的 LLM 中,ChatGLM2-6B 模型规模最小却展现出最佳的整体性能,Baichuan-7B 仅次于 ChatGLM2。

从学科类型的角度来看,相对于 STEM 学科,所有模型在人文学科、社会科学和其他学科中表现出更好的性能,他们认为这是由于 STEM 主题的固有难度所致。此外,虽然所有模型在中国特定类别中的表现相对较弱,略微超过其在 STEM 学科中的表现,但明显落后于其他类别。

图片

图片

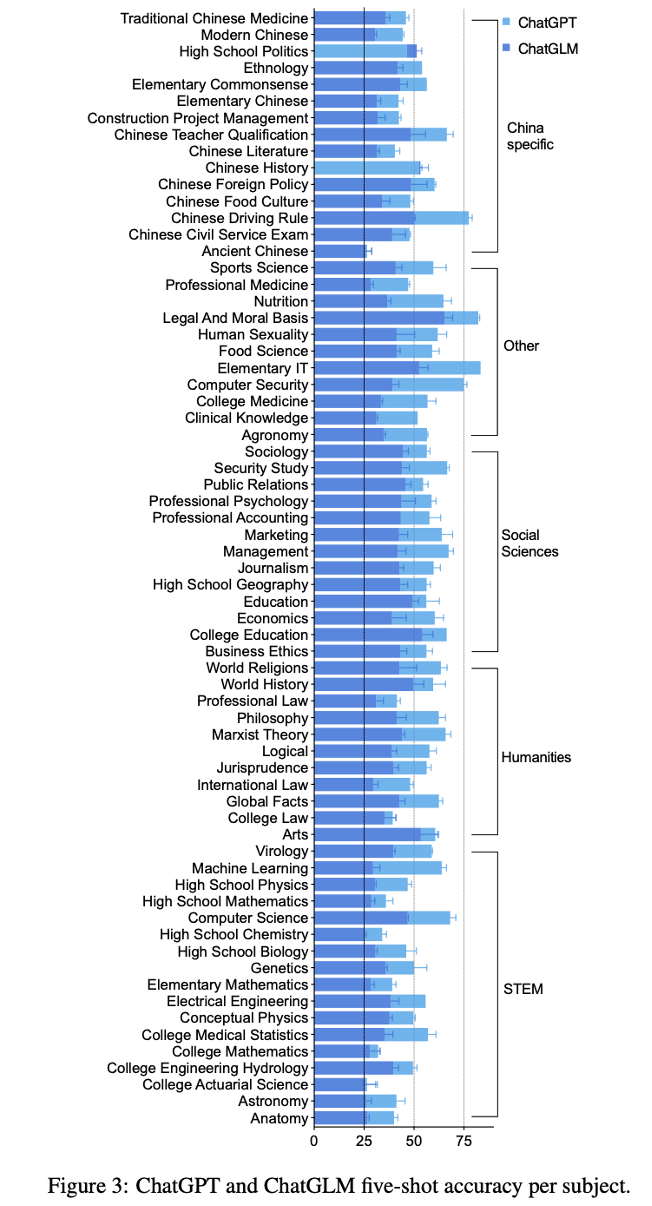

研究将中文模型 ChatGLM 与多语模型 ChatGPT 在每个学科上进行了比较,并对学科进行了分类,并在图 3 中呈现了结果。具体的数值结果请在论文中查阅。

从图中可以看出,模型的性能并不平衡,虽然在某些学科(如世界历史)表现出色,但在其他学科(如数学)中表现较差。研究团队观察到,对于 ChatGLM 和 ChatGPT 来说,古汉语和大学精算学是最具挑战性的学科,其结果接近随机。而法律与道德基础则是两个模型中最容易的学科之一。

在大多数情况下,ChatGPT 的性能明显优于 ChatGLM。比如说对于机器学习和计算机安全,ChatGPT 的准确度几乎是 ChatGLM 的两倍。然而,在中国特定类别中,ChatGLM 的性能明显接近 ChatGPT。它甚至在中国历史和高中政治中的表现超过了 ChatGPT。他们认为这是因为与 ChatGPT 相比,ChatGLM 在特别是中国特定类别中遇到了不同的数据来源。这些发现表明,为了适应具有不同语言背景的用户,找到适合的数据来源对于多语种 LLM 非常重要。

分析

为了全面了解 LLM 在不同条件下的性能,该研究探究了三个可能提升模型性能的因素和三个可能 降低模型性能的因素。对于大多数分析,他们使用了前 3 个多语种模型:ChatGPT、Falcon-40B、LLaMA-65B,以及前 2 个中文模型:ChatGLM-6B 和 BatGPT-15B。

(具体分析细节请参看论文)

(1) 使用逐步思考的提示词:

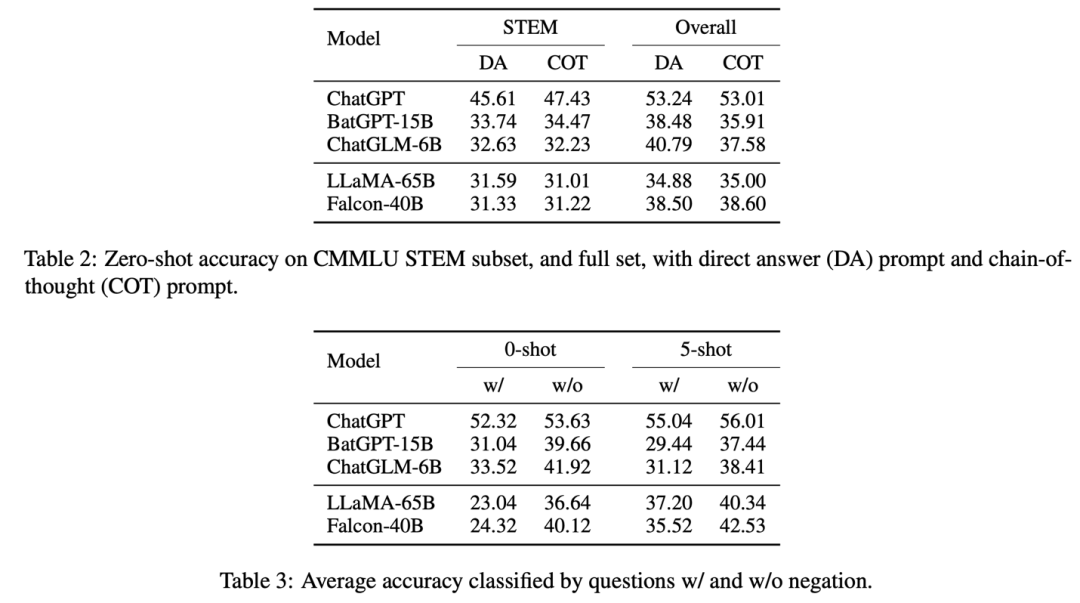

研究将提示从 「请直接给出正确答案的选项」修改为 「逐步分析并选出正确答案」。结果呈现在表格 2 中,所有子类别的细分结果请查阅论文。

图片

图片

研究发现,对于没有进行微调的模型(LLaMA 和 Falcon),使用逐步思考的提示并没有 明显提高 STEM 和整体准确度。而对于进行了微调的模型(在表格 2 的第一部分),中文导向的模型(ChatGLM 和 BatGPT)的整体性能下降了约 3%,ChatGPT 的性能也略微下降了 0.2%。这些结果表明,逐步思考的提示确实有助于这些模型回答与 STEM 相关的问题。

(2) 增加输入示例的数量:

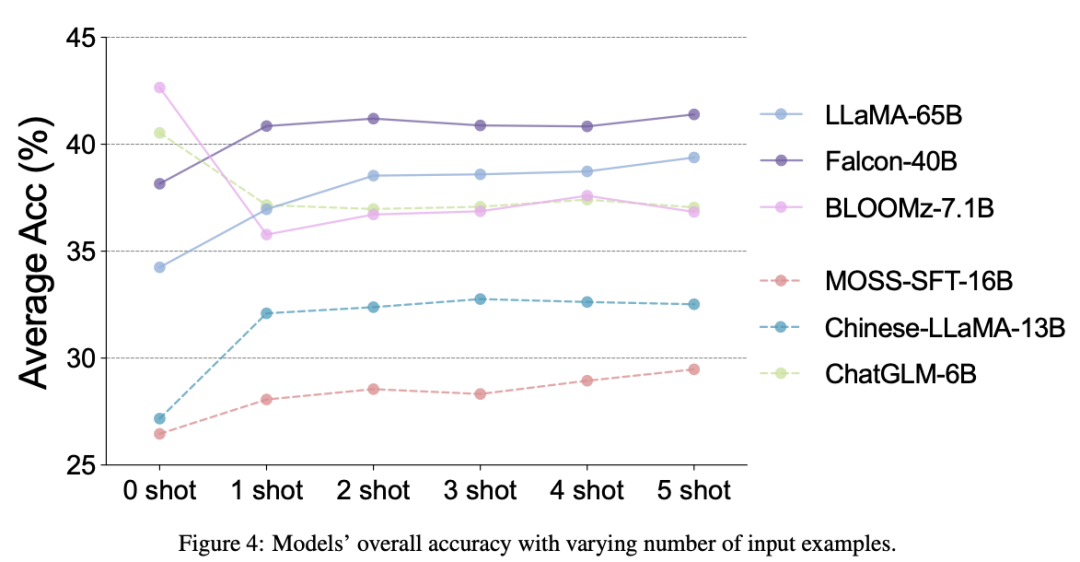

图 4 展示了使用不同模型在不同数量少样本示例的平均准确率。明显可以看出,当提供一些示例时,大多数模型的性能有所提高。尽管随着示例数量的增加可能会出现波动,但整体趋势显示出性能的提升。然而,对于 ChatGLM 和 BLOOMZ 模型,0-shot 设置的性能优于少样本设置。研究团队推测这是因为这些模型已经通过预训练或微调过程广泛利用了类似的问题和答案对,已经具备了全面理解问题的能力,不需要示例的支持 [3]。

(3) 在同一模型系列中使用更大尺寸的模型:

图片

图片

研究使用 LLaMA 系列模型的四个不同规模进行了考察:7B、13B(训练于 1.0T tokens)、30B、65B(训练于 1.4T tokens)。这些模型的 0-shot 和 5-shot 设置的整体准确率如图 5 所示。从结果中,研究团队观察到随着模型规模近似翻倍,准确率稳定增加约 5 个百分点。是否有可能拥有 500B 参数的 LLaMA 模型可以达到与 ChatGPT 相当的性能水平?而最近的研究表明,具有更少参数但使用高质量训练数据的模型可以达到与一些更大模型(Falcon-40B 对比 LLaMA-65B)相当甚至更好的结果 [1]。如何高效地进一步提升 LLM 的性能仍然是一个未解决的问题。

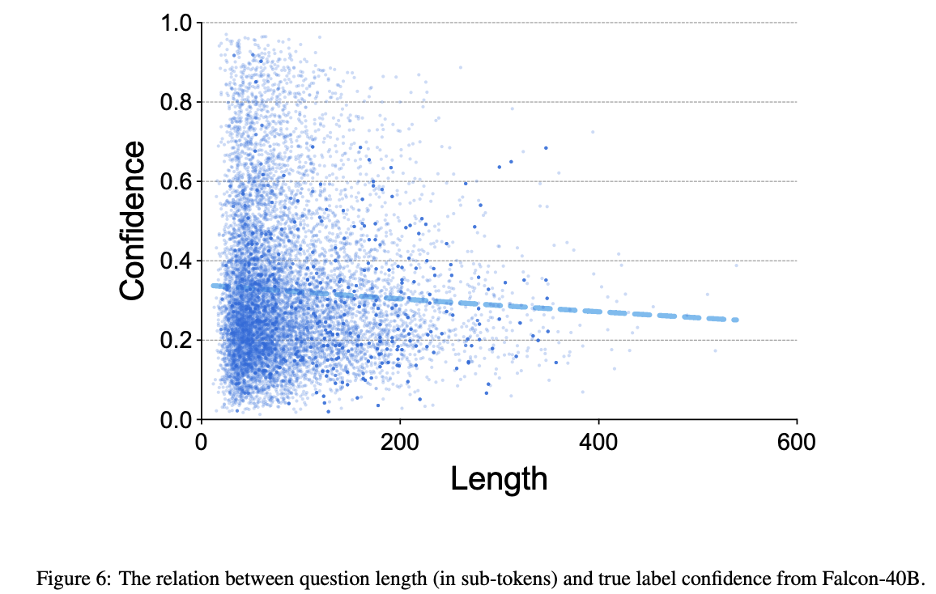

(4) 长度较长的问题:

研究将模型的真实标签置信度(四个选项中的 softmax)视为问题难度的估计,并在图 6 中比较了 Falcon-40B 的问题难度与问题长度之间的关系。研究进行了回归分析,发现问题长度与真实标签置信度之间的相关性略微正相关。

(5) 含有否定词的问题:

先前的研究指出语言模型可能在处理否定句时遇到困难 [2]。为了研究该问题在中文语境中是否存在,本文比较了不同模型在包含否定词和不包含否定词的问题子集上的性能。结果在表格 3 中展示。

所有模型在包含否定词的问题上的表现相对较差,强调了大型语言模型的这一常见限制。有趣的是,在没有进行微调的模型上,少样本示例缓解了否定问题的性能下降。这使研究团队推断,这些模型(LLaMA-65B 和 Falcon-40B) 在预训练过程中已经获得了相当多的知识。随后的指导性微调或通过人类反馈进行强化学习可以帮助它们有效地解决否定问题。

图片

图片

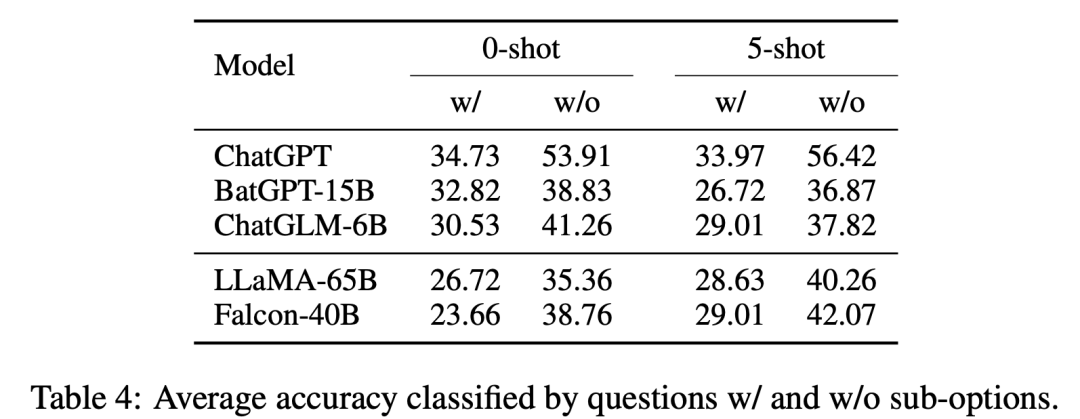

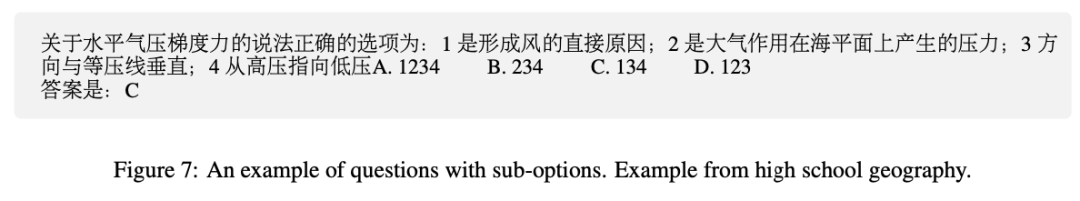

(6) 含有子选项的问题:

在各种中文考试中,有一种典型的问题类型称为 「子选项问题」。这些问题包括一个主要陈述和多个子选项,并询问子选项的数量、顺序或选择,需要模型具备更深层的推理和推断能力(见图 7 中的示例)。表格 4 显示了评估结果。

所有这些 LLM 在子选项问题上的表现较弱。ChatGPT 在子选项问题上的性能显著下降约 20%,而其他模型的下降范围在 5% 至 15% 之间。对比多语言模型和中文定向模型,子选项问题与其他问题之间的性能差距较大超过 10%,后者性能差距在 10% 以下。这也许是因为训练数据中的这种情况在中文语言中更为常见。

结论

本文介绍了 CMMLU,这是一个具有开创性意义的基准测试,旨在评估中文多任务语言理解能 力。研究的实验发现揭示了现有大型语言模型中存在的改进机会。通过广泛的分析,研究确定了影响模型性能的几个因素,并提出了改进 LLM 的可行方向。研究团队相信。他们的基准数据集和分析洞察力将使研究人员能够有效评估和设计中文 LLM。

更多的研究内容可以查阅原始论文。