超级AI智能会杀死所有人!

Sam Altman曾多次公开表态对AI未来的担忧,甚至自己都夜不能寐。

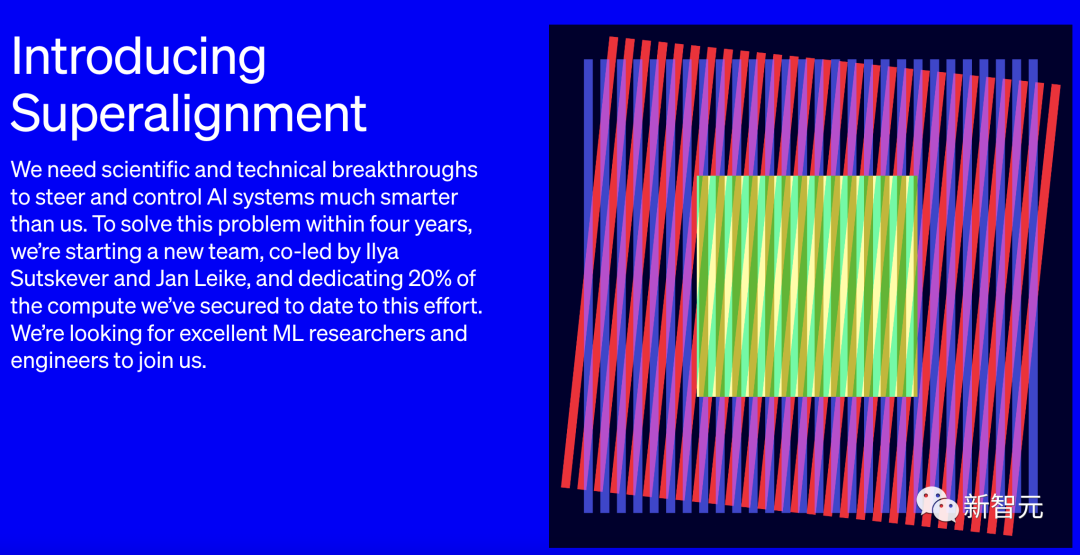

如今,OpenAI组建了一个团队,试图用20%算力,在未来4年解决「超级智能对齐问题」。

图片

图片

最新团队将由联合创始人兼首席科学家Ilya Sutskever和Jan Leike共同领导。

博客开篇,短短几行,遍阐述了OpenAI对超级智能降临时间的预判,以及具有「毁天灭地」能力的重度担忧。

超级智能将是人类发明的最具影响力的技术,可以帮助我们解决世界上许多最重要的问题。但超级智能的巨大力量也可能非常危险,并可能导致人类丧失权力,甚至导致人类灭绝。

虽然有超级智能现在看来还很遥远,我们相信这可能在十年内实现。

接下来4年,OpenAI要做的,就是防止超级智能杀死所有人类。

四年解决超级AI对齐问题

而Altman认为,想要管理这些风险,彻底解决对齐问题,就必须成立新的治理机构。

他表示,目前还没有一个像样的解决方案来引导或控制潜在的超级AI。

当前的技术,都依赖于人类的监督,比如根据人类反馈进行的强化学习(RLHF)等等。

但纯靠人力来监督比我们聪明得多的AI系统,总有一天会费劲又吃力。而目前的对齐技术又无法扩展到超级智能,所以对新技术突破的需要就提上了日程。

Altman在今天还发起了「英雄榜」。

图片

图片

OpenAI的目标,就是建立一个大致拥有人类水平的自动对齐研究员,然后用大量计算扩展研究工作,迭代调整超级智能。

为了创建第一个「自动对齐研究员」,本质上讲创建一个AI,OpenAI分三步走。

第一,开发一种可扩展的训练方法;

第二,验证生成的模型;

第三,对整个对齐管道进行压力测试。

研究人员利用AI系统来协助评估其它AI系统(可扩展的监督),同时研究人员还希望了解并控制他们的模型是如何将监督推广到人类研究员无法监督的任务上去的(有点绕嘴)。

之后,研究人员为了验证系统的一致性,自动搜索了有问题的行为,以及存在问题的内部结构。

最后可以通过找到一个未对齐的模型来测试整个流程,确认开发的框架可以检测到各种不同的未对齐类型(称为对抗性测试)。

OpenAI的研究人员预计,随着对这个问题的研究越来越深入,研究重点也会发生变化,甚至还可能会有新的研究领域出现。

全新团队

为此,OpenAI正式宣布,组建一个由顶级机器学习研究人员和工程师组成的团队——「Superalignment」。

在接下来的四年里,OpenAI将投入到目前为止获得的计算资源中的20%,用于解决超级AI的对齐问题。

在这个过程中,预计将会有很多团队参与进来,从开发新方法到将其扩展至实际应用。

OpenAI表示,自己的目标是在四年内解决超级智能对齐的核心技术挑战。

虽然听起来很大,实现起来也不一定100%成功,但OpenAI还是认为只要集多方努力,还是可以解决的。

Ilya Sutskever作为OpenAI的联合创始人兼首席科学家,已经把这个目标当作其核心研究重点,并将与Jan Leike——对齐项目负责人,共同领导该团队。

图片

图片

团队成员包括此前负责对齐工作的研究人员和工程师,甚至还有其他团队的研究人员,可谓阵容庞大。

LeCun所言「狗级」AI,真会十年翻身?

可以说,OpenAI对超级智能AI系统的将在十年内诞生,是一个非常大胆的预测。

首先,就拿ChatGPT来说,没有人承认它是一个能够进行人类思维的人工智能。

与之相反,ChatGPT作为一个类似于自动完成的大型语言模型,可以重新创建类似人类的反应,但没有完全理解单词背后的含义。

因此,有时候它会编造明显错误,或无法理解基本逻辑的答案。

前段时间,吴恩达在新开的课程中指出,ChatGPT不会反转单词直接登上Reddit热榜。

图片

图片

比如,让它反转lollipop这个词,输出的是pilollol,简直是完全混乱的。

究其原因,主要还是大模型采用token来处理文本,这样好处是能降低内存和时间复杂度。

但是,将单词token化,明显存在一个致命的问题,那就是模型很难学习到有意义的输入,也就能理解为什么ChatGPT不能理解单词含义的原因了。

当让它处理单词反转任务时,模型可能就是把每个token反转过来,由此才出丑。

抛开ChatGPT,再广泛地来讲,一直以来图灵奖的主Yann LeCun都把当前人工智能称作,连猫狗都不如的AI。

一句话总结,「论聪明程度,ChatGPT可能连条狗都不如。」

图片

图片

LeCun表示,当前的AI系统,哪怕是ChatGPT,根本就不具备人类的智能水平。

在他看来,不必太过紧张,如今的AI智能水平远远没到我们该担忧的地步。

目前的生成式AI模型都是在LLM上训练的,而这种只接受语言训练的模型聪明不到哪去。这些模型的性能非常有限,它们对现实世界没有任何理解。

由此,在一些人看来,OpenAI预测超级智能AI即将到来似乎很奇怪。

尽管如此,他们还是希望做好准备,能够以先发制人的优势,将AI灭绝人类的想法扼杀在摇篮中。

网友答疑

Stability AI的CEO表示,使AGI与ASI保持一致是我们的计划。

我的观点(提出你的意见):我们不可能在没有拿走自由的情况下绝对地对齐一个超级智能体。对齐和自由是正交的。我们不要建造那些可能会对人类造成 I)生存威胁和 II)剥夺人类权力的人工智能。

图片

图片

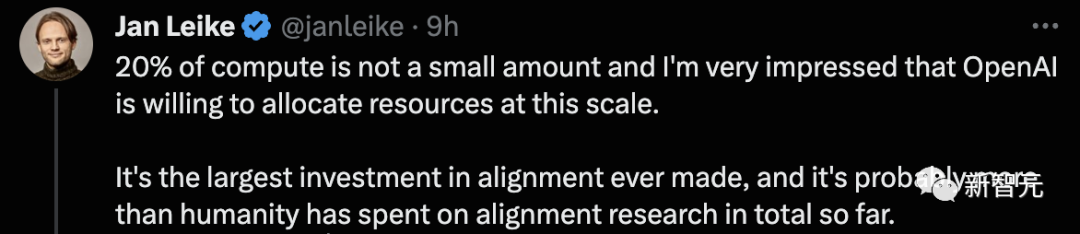

根据OpenAI博客介绍,未来要投入20%算力去做这件事,却受到网友的质疑。

现在是时候有人考虑超级智能的安全问题了。但让我们现实一点,20%的计算量真的能解决问题吗?对于这样一个巨大的问题,似乎只是杯水车薪。

图片

图片

OpenAI的对齐团队领导人Jan Leike解释道,

20%的计算量不是一个小数目,我对OpenAI愿意以这种规模分配资源感到非常印象深刻。

这是有史以来对对齐的最大投资,它可能比人类到目前为止在对齐研究上的总花费还要多。

图片

图片

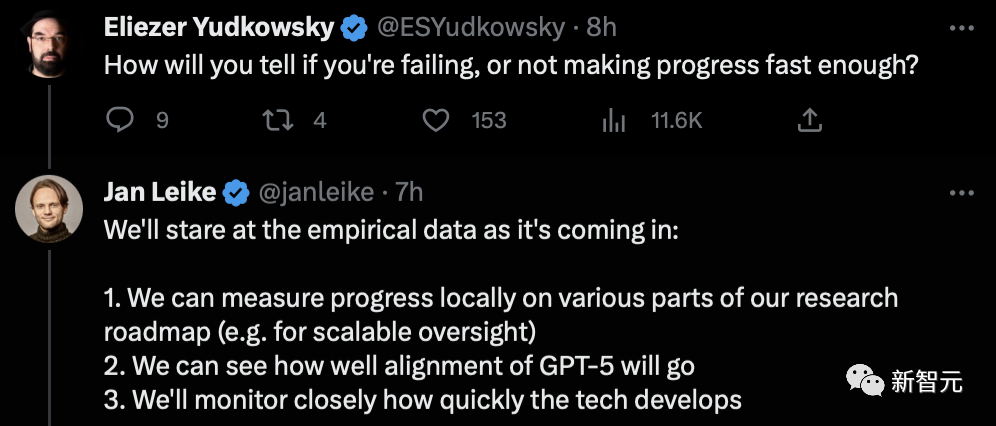

OpenAI将用4年的时间去完成这项任务,如何判断是否失败了,或者进展不够快?

我们会关注即将到来的实证数据:

1. 我们可以在本地衡量研究路线图的各部分进展(例如,可扩展的监督)

2. 我们可以看到GPT-5的对齐效果如何

3. 我们将密切关注技术的发展速度

图片

图片

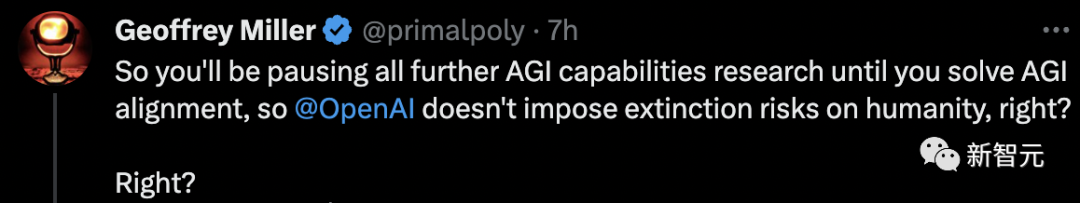

其实大多数人还是很想知道,OpenAI是不是在真正解决对齐研究之前,不会再研发超级AI了。

图片

图片

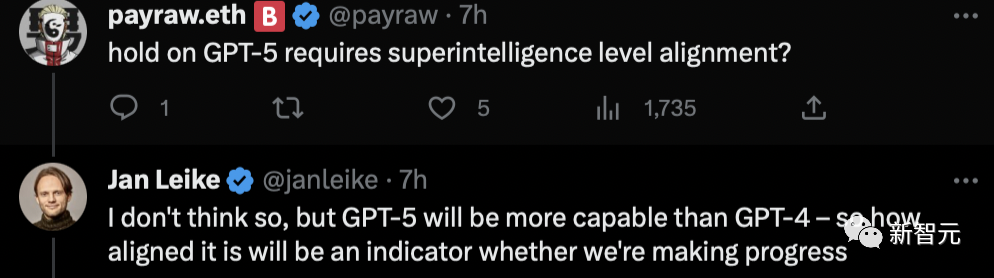

其实,Jan Leike的话中,早已透露出了GPT-5正在研发中。

图片

图片

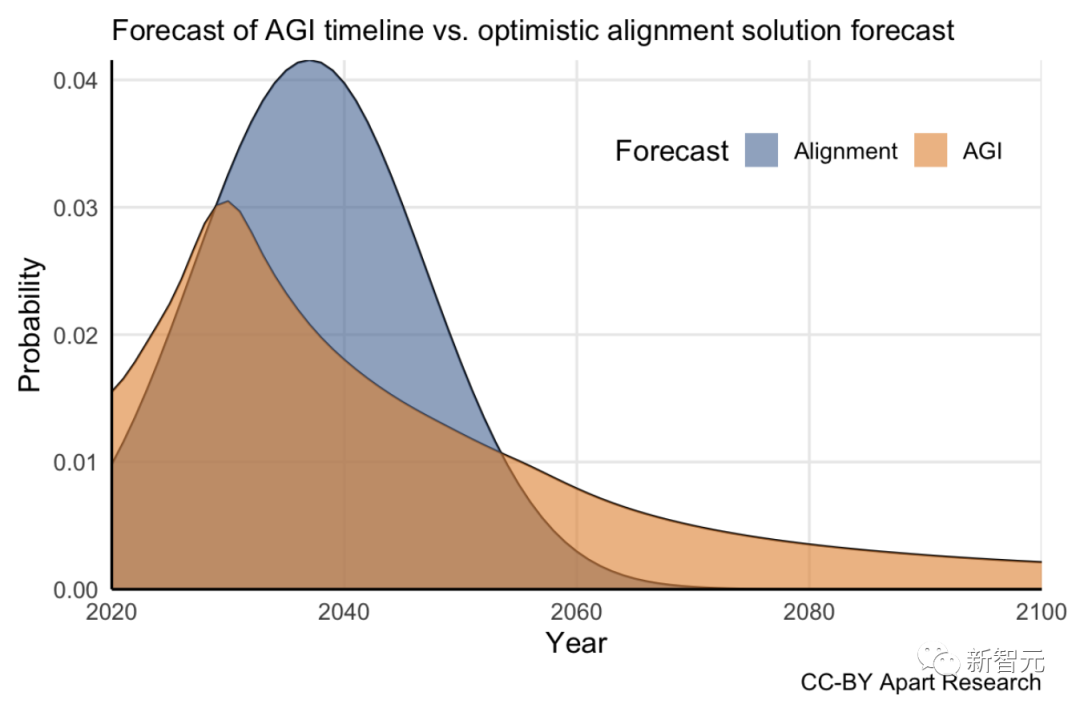

许多人还是比较支持OpenAI这么做的。

网友表示,希望机器的可解释性是战略的一部分,ASI不应该是一个黑盒子。如果我们有一天在不了解它是如何工作的情况下建立一个ASI,我们将有很大的麻烦。

图片

图片

图片

图片