此前,曾有不少人研发ChatGPT检测器,但没有一个能够真正有效鉴别。

来自堪萨斯大学的研究人员介绍了一种全新的算法,能够检测是否用ChatGPT作弊,准确率超99% 。

最新研究已在6月7日,发表在Cell Reports Physical Science期刊上。

图片

图片

该论文的作者之一、堪萨斯大学化学教授Heather Desaire表示,

「我们努力创建一种易于使用的方法,这样,即便是高中生,只需很少的指导,也可以为不同类型的写作构建一个人工智能检测器。」

四大特征,99%识别率

就像研究者所称,90%准确性往往是不够的。但要获得更高准确性,取舍往往是普遍性。

这项研究中,研究人员选取了人类作者撰写的64篇「科学」杂志上的研究文章,涵盖从生物学到物理学的各个学科。

然后,将这些数据喂给ChatGPT,并用这些数据生成了一个128篇人工智能文章的数据集。

这组训练数据,包含1276段聊天机器人示例段落。

研究者利用这些数据构建了ChatGPT检测算法。

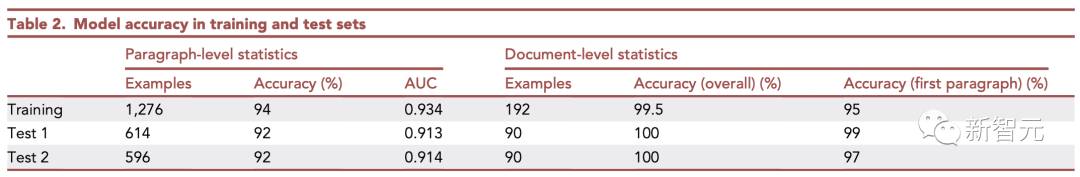

在模型完全开发和优化后,他们还生成了两个测试集。每个测试集有30篇真实文章和60篇ChatGPT撰写的文章(总计1210段)组成了一个新的数据集,来测试最新算法。

实验结果显示,最新算法能够100%检测到ChatGPT写的整篇文章。

在段落层面上,其准确性较低,但仍令人印象深刻:该算法发现了92%的由人工智能生成的段落。

图片

图片

值得一提的是,论文称,从一些细节中就能发现,哪些内容是ChatGPT创作的。

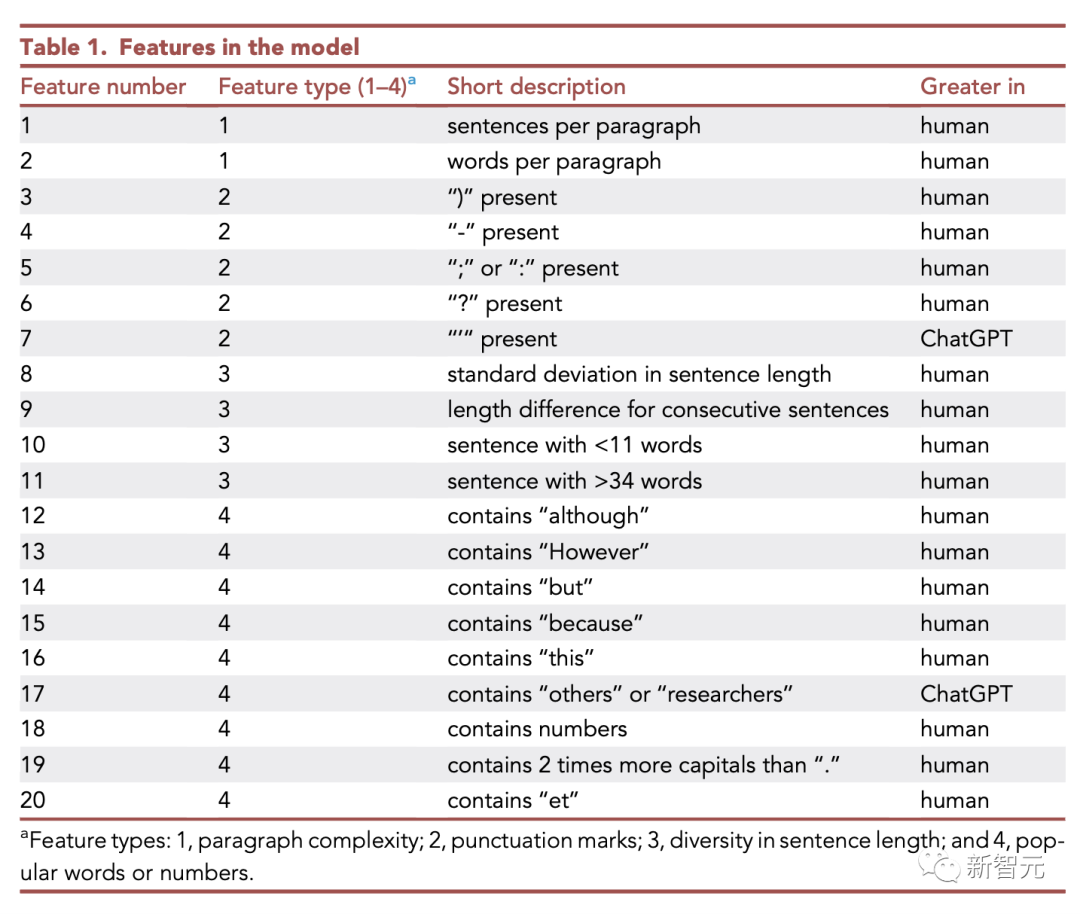

通过对训练集中许多示例的手动比较,研究者确定了4类特征。这些特征有助于区分人类写作和聊天机器人。

(1)段落复杂性,(2)句子长度多样性,(3)标点符号,以及(4)流行词或数字

总的来说,人类作家写的段落更长、使用词汇量更大,包含更多的标点符号。

而且,还倾向于用「然而」、「但是」和「尽管」这样的词来修饰他们的陈述。而ChatGPT在引用数字,提及其他科学家方面没有那么具体。

在如下表分类中,人类擅长的内容要比ChatGPT多得多。

图片

图片

在这四类特征中,有两类(1和3)是ChatGPT产生的内容不如人类复杂的方式。最大的区别特征是每段句子的数量和每段总单词的数量。

在这两种情况下,ChatGPT的平均值都明显低于人类。

研究者还发现,人类更喜欢改变句子结构。人类改变句子长度的次数超过ChatGPT。人类也更频繁地使用较长的句子(35个单词或更多)和较短的句子(10个单词或更少)。

剩下的两类区分特征可以更多地描述为「文体」选择。

一方面,人类科学家更频繁地使用问号、破折号、括号、分号和冒号,而ChatGPT使用更多的单引号。

人类还使用更多的专有名词和/或首字母缩略词,还有数字。

这个由Desaire公司建立的这个模型,对于那些希望惩罚作弊的高中生的老师来说,是行不通的。

该算法是为学术写作而建立的,特别是人们在科学期刊上读到的那种学术写作。

这家公司表示,理论上你可以使用同样的技术来建立一个模型,来检测其他类型的写作。

不过,不得不考虑的一个事实是,一个人可以很容易地对一个聊天机器人的写作进行一些小调整,并让其更难被发现是作弊,事情就更复杂了。

当你考虑到这样一个事实,一个作者可以很容易地对一个聊天机器人的写作进行一些小的调整,并使它更难被发现时,事情就崩溃了。

尽管如此,研究人员将这项研究描述为「概念证明」,并表示未来可以开发一个更加稳定,准确的工具与更大的数据集。

如果人工智能继续以极快速度发展下去,谁也无法保证这样的检测方法,能否依然有效。

因为大型语言模型越接近复制人类语言文字的能力,识别机器人语言的痕迹就越困难。

AI检测为何如此困难

自ChatGPT面世以来,已经被许多高校的学生和老师用在日常的作业和教学中。

然而,如果不加以限制,ChatGPT将会变成史上最强大的作弊工具,可以帮助学生们写作业,甚至是完成考试论文。

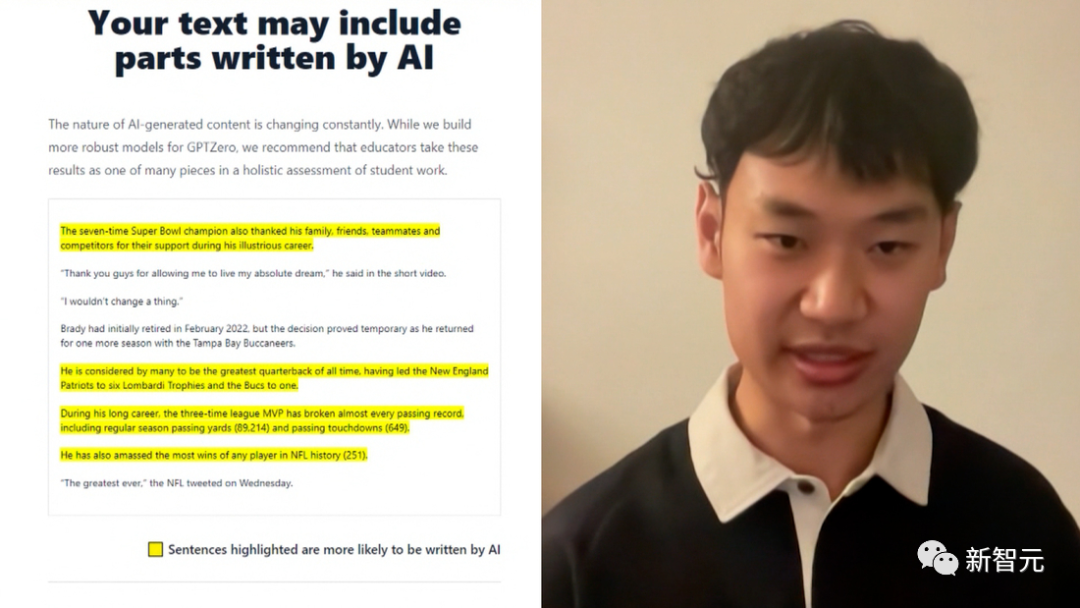

为了反侦察,一款简单易用的检测器成为老师期盼的东西。一位22岁普林斯顿大学的学生Edward Tian,就自行开发了一款检测器——GPTZero。

图片

图片

甚至,OpenAI官宣推出一个新工具,名为AI Text Classifier的文件检测器。

但是,这些检测器的表现并不如人意。

图片

图片

检测出AI创作的内容听起来很简单。但当给你一封手写邮件和ChatGPT生成的邮件后,我们几乎无法辨别。

Turnitin的人工智能副总裁Eric Wang称,用软件检测人工智能写作涉及统计学。从统计学的角度来看,人工智能与人类的区别在于它极其稳定地处于平均水平。

直白点讲,AI水平很稳定。然而,实际上并非这样一个道理。

「像ChatGPT这样的系统就像是自动补全的高级版本,寻找下一个最可能要写的单词。这实际上就是它为什么读起来如此自然的原因。AI写作是人类写作中最可能的子集。」